Практическая работа №1 Количество информации. Единицы измерения информации

Теоретическая часть

Количество информации – числовая характеристика сигнала, которая отражает степень неопределенности (неполноту знаний). Неопределенность исчезает после получения сообщения в виде сигнала. Эту меру неопределенности в теории информации называют энтропией, а способ измерения количества информации – энтропийным.

Между понятиями информация, неопределенность и возможность выбора существует тесная связь. Так, любая неопределенность предполагает возможность выбора, а любая информация, уменьшая неопределенность, уменьшает и возможность выбора. При полной информации выбора нет. Частичная информация уменьшает число вариантов выбора, сокращая тем самым неопределенность.

Например, человек бросает монету и наблюдает, какой стороной она упадет. Обе стороны монеты равноправны, поэтому одинаково вероятно, что выпадет одна или другая сторона. Такой ситуации приписывается начальная неопределенность, характеризуемая двумя возможностями. После того, как монета упадет, достигается полная ясность, и неопределенность исчезает (становится равной нулю).

Приведенный пример относится к группе событий, применительно к которым может быть поставлен вопрос типа «да–нет». К таким моделям также можно отнести: электрическую лампочку, двухпозиционный выключатель, магнитный сердечник, диод и т. п. Включенное состояние этих объектов обозначают цифрой 1(да), а выключенное – цифрой 0 (нет).

Количество информации, которое можно получить при ответе на вопрос типа «да–нет» в описываемых выше системах, называется битом (англ. bit – сокращенное от binary digit – двоичная единица). Бит – количество информации, необходимое для однозначного определения одного из двух равновероятных событий. Бит – минимальная единица количества информации, т.к. получить информацию меньшую, чем 1 бит, невозможно. При получении информации в 1 бит неопределенность уменьшается в 2 раза. Таким образом, каждое бросание монеты дает нам информацию в бит.

Группа из 8 битов информации называется байтом. Если бит – минимальная единица информации, то байт ее основная единица. Существуют более крупные единицы информации: килобайт (Кбайт, Кбт), мегабайт (Мбайт, Мбт), гигабайт (Гбайт, Гбт), терабайт (Тбайт, Тбт) и петабайт (Пбайт, Пбт):

1 Кбт = 1024 байта = 210 байта.

1 Мбт = 1024 Кбайта = 220 байта.

1 Гбт = 1024 Мбайта = 230 байта.

1 Тбт = 1024 Гбайта = 240 байта.

1 Пбт = 1024 Тбайта = 250 байта.

Эти единицы измерения количества информации чаще всего используют для указания объема памяти ЭВМ.

Пример 1. Рассмотрим систему из двух компьютеров, которые независимо друг от друга могут быть включены или выключены. Для такой системы возможны следующие состояния:

Компьютер А: 0 0 1 1

Компьютер В: 0 1 0 1

Чтобы получить полную информацию о состоянии системы, необходимо задать два вопроса типа «да–нет» – по компьютеру А и компьютеру В соответственно. В этом случае количество информации, содержащейся в данной системе, определяется уже в 2 бита, а число возможных состояний системы – 4. Если взять три компьютера, то необходимо задать уже три вопроса и получить 3 бита информации. Количество состояний такой системы равно 8 и т. д.

Связь между количеством информации и числом состояний системы устанавливается формулой Хартли:

i = log2N, (1.1)

где i – количество информации в битах; N – число возможных состояний.

Формулу Хартли можно представить иначе: N = 2i.

Пример 2. Какое количество информации несет в себе сообщение о том, что нужная вам программа находится на одной из восьми дискет?

Используем формулу Хартли: число возможных вариантов (состояний) где может находится программа – 8. i=log2 8= 3.

Количество информации в сообщении о том, что нужная вам программа находится на одной из восьми дискет, равно 3 бита.

Формула Хартли используется в ситуациях, в которых все состояния системы равновероятны. В повседневной жизни мы чаще сталкиваемся с событиями, которые имеют разную вероятность свершения. Например, когда сообщают прогноз погоды, то сведения о том, что будет дождь, более вероятны весной и осенью, а сообщение о снеге – зимой. Или – из мешка в котором лежат 10 белых шаров и 3 черных вытягивают один шар. Вероятность достать черный шар меньше, чем вероятность вытаскивания белого.

Как вычислить

количество информации в сообщении о

таком событии? Для этого необходимо

использовать следующую формулу:

![]()

где I – это количество информации;

p – вероятность события.

Вероятность события

выражается в долях единицы и вычисляется

по формуле:

![]() где

K

– величина, показывающая, сколько раз

произошло интересующее нас событие; N

– общее число возможных исходов какого-то

процесса.

где

K

– величина, показывающая, сколько раз

произошло интересующее нас событие; N

– общее число возможных исходов какого-то

процесса.

Контрольный пример. В мешке находятся 20 шаров. Из них 15 белых и 5 красных. Какое количество информации несет сообщение о том, что достали: а) белый шар; б) красный шар. Сравните ответы.

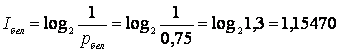

1. Найдем вероятность

того, что достали белый шар:

![]()

2. Найдем вероятность

того, что достали красный шар:

![]()

3. Найдем количество

информации в сообщении о вытаскивании

белого шара:

бит.

бит.

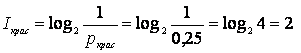

4. Найдем количество

информации в сообщении о вытаскивании

красного шара:

бит.

бит.

Количество информации в сообщении о том, что достали белый шар, равно 1, 1547 бит. Количество информации в сообщении о том, что достали красный шар, равно 2 бит.

При сравнении ответов получается следующая ситуация: вероятность вытаскивания белого шара была больше, чем вероятность красного шара, а информации при этом получилось меньше. Это не случайность, а закономерная, качественная связь между вероятностью события и количеством информации в сообщении об этом событии.

Измерение символьной и графической информации. Алфавитный подход

Вероятностный подход оценки количества информации зависит от содержания информации. При передаче, хранении, обработки информации с помощью различных технических устройств содержание информации не рассматривается и она представляется как последовательность знаков (цифр, букв, кодов цветов точек изображения). Такой подход к оценке количества информации называется алфавитным подходом.

Считая, что алфавит (набор символов знаковой системы) – это событие, то появление одного из символов в сообщении можно рассматривать как одно из состояний события. Если появление символов равновероятно, то можно рассчитать, сколько бит информации несет каждый символ.

Информационная емкость знаков определяется их количеством в алфавите. Чем больше количество символов в алфавите, тем больше количество информации несет один знак. Полное число символов алфавита принято называть мощностью алфавита.

Пример 1. Молекулы ДНК состоят из четырех различных составляющих, которые образуют генетический алфавит. Информационная емкость знака этого алфавита составляет: i = log2 4 = 2 (бита).

Чтобы определить информационный объем печатного текста или графического изображения, общее количество отдельных символов умножается на информационный объем одного символа

Количество символов вводимых в ЭВМ с помощью клавиатуры - 256. Отсюда следует, что для кодировки любого из этих символов необходимо:

i = log2 256 = 8 (бит) = 1 байт.

Пример 2. Книга содержит 100 страниц; на каждой странице по 35 строк, в каждой строке - 50 символов. Рассчитать объем информации, содержащийся в книге.

Общее количество символов в книге - 35 * 50 * 100 = 175000, информационный объем одного символа - 1 байт.

Объем всей информации в книге (в разных единицах):

175000 * 1 байт = 175 000 байт. 175000 байт / 1 024 = 170,8984 Кбайт.

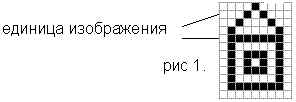

Пример 3.. Имеется следующая черно-белая картинка (рисунок 1.1). Определите информационный объем этой картинки.

Рисунок 1.1. - Картинка «Домик».

Количество цветов, используемое для изображения картинки - 2 (черный и белый). Следовательно, информационный объем одной точки: i = log2 2 = 1 (бит).

Размер картинки - 9*12 (108) точек.

Информационный объем картинки - К= 108 * 1= 108 (бит).

Задания

1. Установите знаки сравнения ( <, > , = ):