- •2.Постановка задачи линейного программирования. Основные формы задачи линейного программирования. Симплекс-таблица и критерий оптимальности. Прямой симплекс-метод и метод искусственного базиса.

- •3.Суть двойственных задач линейного программирования. Теоремы двойственности линейного программирования. Двойственный симплекс-метод.

- •5. Сравнительный анализ эффективности методов решения задач одномерной нелинейной оптимизации без ограничений. Стратегии выбора исходного интервала неопределенности и поиска глобального экстремума.

- •6. Постановка задачи многомерной безусловной оптимизации и классификация методов ее решения. Прямые методы поиска: Гаусса, конфигураций, вращающихся координат, деформируемого многогранника.

- •9. Постановка задачи многомерной безусловной оптимизации и классификация методов ее решения. Методы второго порядка: метод Ньютона и его модификации, методы переменной метрики.

5. Сравнительный анализ эффективности методов решения задач одномерной нелинейной оптимизации без ограничений. Стратегии выбора исходного интервала неопределенности и поиска глобального экстремума.

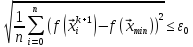

N – кол-во вычислений целевой ф-ии f(x)

– конечный интервал неопределенности

– конечный интервал неопределенности

,

где

,

где – точность

– точность

I) Алгоритмы пассивного поиска

1. Алгоритм равномерного поиска

II) Алгоритмы активного поиска

2. Алгоритм равномерного блочного поиска

;n- число точек в блоке,m- число итераций

;n- число точек в блоке,m- число итераций

3. Деление интервала пополам

4. Метод дихотомии

5. Метод золотого сечения

6. Метод чисел Фибоначчи

по эфф-ти примерно одинаков с методом золотого сечения

III) Методы основанные на аппроксимации функции

7.метод парабол

Невозможно получить выражение для

В общем случае можно говорить, что он достаточно эффективен

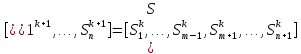

Стратегии выбораисходного интервала неопределенности и поиска глобального экстремума.

Исх.

данные:

поиска

поиска

1.

k=0;

,

если

,

если ,

то переход к шагу 2,

,

то переход к шагу 2,

иначе

h

= -h;

Если

,

то переход к шагу 2, иначе

,

то переход к шагу 2, иначе ,

,

2.

2.1.

Если

,

то

,

то

2.2.

Если

,

то переход к шагу 2.1,k=k+1,

иначе

,

то переход к шагу 2.1,k=k+1,

иначе

,

переход к шагу 3.

,

переход к шагу 3.

3.

Анализ

точек

.

Если

.

Если ,

то

,

то

иначе

останов

6. Постановка задачи многомерной безусловной оптимизации и классификация методов ее решения. Прямые методы поиска: Гаусса, конфигураций, вращающихся координат, деформируемого многогранника.

Постановка задачи

,

, ,

задана функция

,

задана функция .

Необходимо найтиmin(илиmax)

.

Необходимо найтиmin(илиmax)

исходные

данные:

Классификация методов:

1) Прямые методы поиска

Знание целевой ф-ии не нужно, необходимо только уметь вычислять ее в точках

2) Методы первого порядка (градиентные методы)

Нужно знать вид функции, уметь вычислять первую производную. Выбор направления основан на вычислении градиента

3) Методы второго порядка

Нужно знать вид функции, уметь вычислять градиент и матрицу Гесса

Особенности прямых методов:

1)нет необходимости знать вид ф-ии

2)не требуется регулярность и непрерывность

3)не требуется вычисление производной первого порядка

Метод Гаусса

На

каждом этапе осуществляем движение по

осям координат. Двигаемся по напр.

находимmin. Из новой точки

идем вдоль другой оси координат и т.д.

находимmin. Из новой точки

идем вдоль другой оси координат и т.д.

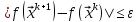

Критерии

остановки: а)

б)

1.

задаем

.

k=0–номер итерации

.

k=0–номер итерации

2.

…………………………………………………………….

3.если ,

то

,

то ;

f(

;

f( )=f(

)=f( )

)

Иначе k=k+1, перейти к шагу 2.

Недостатки метода:

1) Если линии равного уровня вытянуты (ф-ии овражного типа), то сходимость данного метода будет очень плохой.

2) Если вид такой, то алгоритм даст неправильную точку

Метод конфигураций

Метод состоит из 2-х этапов:

1) исследовательский поиск (поиск направления)

2) поиск по образцу (по определенному направлению)

1.

задаем x0, ,h, иk=0.

,h, иk=0.

2.

Введем точку zдля сравнения

новой и предыдущей точки, =

= .j=1

.j=1

2.1.

,

еслиf(

,

еслиf( )

) f(

f( ),

то

),

то и переход к шагу2.3

и переход к шагу2.3

иначе к шагу2.2

2.2.

,

еслиf(

,

еслиf( )

) f(

f( ),

то

),

то ,

иначе к шагу2.3

,

иначе к шагу2.3

2.3. j=j+1 Еслиj<n, то к шагу2.1 иначе к шагу3

3.если

=

= ,

тоh=h/2,

проверяем останов, т.е. если

,

тоh=h/2,

проверяем останов, т.е. если ,

то

,

то и останов, иначе переходим к шагу2

и останов, иначе переходим к шагу2

Иначе

если

,

то переход к шагу 4(поиск по образцу).

,

то переход к шагу 4(поиск по образцу).

4.

Направление поиска

,

,

k=k+1 переход к шагу 2.

Метод вращающихся координат

Шаг

1.

иk= 0.

иk= 0.

Шаг

2.

;

;

;

;

…………………………

;

;

Шаг

3. Если

, то

, то и остановка

и остановка

Иначе к шагу4.

Шаг

4. Используя процедуру Грамма – Шмидта

находим

k=k+1, переходим к шагу2

Процедура Грамма-Шмидта

(над

всем кроме

поставить вектора)

поставить вектора)

Пусть

–полученная С.К. на шагеk

–полученная С.К. на шагеk

– новая С.К.

– новая С.К.

Введем систему вспомогательных векторов

……………

Введем еще вспомогательные вектора

- вектор ортогональныйS1

- вектор ортогональныйS1

Аналогично

l=2..n

l=2..n

Таким образом получим новую С.К.

Если

=0 => оставляем старые

=0 => оставляем старые

Метод деформирующего многогранника.

1.

Построение исходного многогранника

k=0

Построение исходного многогранника

k=0

2.(отражение)

выч-м

i=1..n

i=1..n

– центр тяжести

– центр тяжести

; α – коэффициент отражения. Обычноα=1.

; α – коэффициент отражения. Обычноα=1.

a) Шаг 3.2

Шаг 3.2

б)

Шаг 3.1

Шаг 3.1

a)

Шаг 3.2

Шаг 3.2

3.

3.1(растяжение)

; β – коэффициент растяжения, β

; β – коэффициент растяжения, β 2

(обычно=2)

2

(обычно=2)

Если

,

то строим новый симплекс

,

то строим новый симплекс (

( ),

переход к шагу 3.3.

),

переход к шагу 3.3.

Иначе

переход к шагу 3.3

переход к шагу 3.3

3.2(сжатие)

если условие а)

если условие а)

если условие б);

если условие б); – коэффициент сжатия, обычноj=0,5

– коэффициент сжатия, обычноj=0,5

Если

,

то выполняется редукция

,

то выполняется редукция

переход к шагу 3.3

иначе

новый симплекс

(замена) и переход к шагу2

(замена) и переход к шагу2

3.3

Если

,

то

,

то

,f(

,f( )

иостановка

)

иостановка

Иначе k=k+1 переход к шагу 2.

7. Сопряженные направления и особенности их использования при решении задач многомерной безусловной оптимизации. Суть методов прямого поиска и градиентных методов, основанных на сопряженных направлениях. Их сравнительный анализ.

–система

направлений.

–система

направлений.

Эта

система будет сопряженной, если

H– некоторая положительно определенная квадратичная матрица

Теорема 1 Для матрицы Гессе существует хотябы одна система сопряженных направлений – соситема собственных векторов

Теорема 2:Если задана система сопр. направлений и целевая функция квадратична, то поиск экстремума требует n шагов, при этом порядок использования направлений значения не имеет

Пусть

известны x1,x0

и

– направление

– направление

Если

ищем минимум от

вдоль

вдоль и этотmin

-

и этотmin

-

а от точки

а от точки в направлении

в направлении тоmin

-

тоmin

- ,

.: еслиf(

,

.: еслиf( ) <f(

) <f( ),

то (

),

то ( -

- .

.

Обобщение:

если заданы направления сопр.:

и если вдоль каждого такого направления

находитьmin

из исходной т.

и если вдоль каждого такого направления

находитьmin

из исходной т.

то получим т.

то получим т.

Тогда

направление ( -

- )

сопряжено всем этим направлениям

)

сопряжено всем этим направлениям

-

-

– всегда в таких

точках как ха

xb

– всегда в таких

точках как ха

xb

вычитаем,

следовательно

вычитаем,

следовательно

Алгоритм для многих сопряженных направлений

Рассматриваем к-ую итерацию

Поиск

экстремума ведется в сопряженных

направлениях

смотрим

точку

смотрим

точку

И

на ее основе формируем точку для нового

направления

и вычисляем значение функции в этих

точках

и вычисляем значение функции в этих

точках

Вычисляем

- максимальное уменьшение функции вдоль

каждого направления.

- максимальное уменьшение функции вдоль

каждого направления.

Пусть

соответствует

соответствует .

.

Если

и/или

и/или ,

то на следующей итерации

,

то на следующей итерации у нас все направления совпадают – не

меняем на новое, а иначе

у нас все направления совпадают – не

меняем на новое, а иначе

на

к-ой итерации

убираем

убираем ,

а на к+1 итерации

,

а на к+1 итерации

,

где

,

где

=> получаем новое

=> получаем новое

- критерий остановки

- критерий остановки

На

следующем этапе в качестве точки

используется

используется или

или в зависимости от того, где значениеf

меньше

в зависимости от того, где значениеf

меньше

Исходные

данные:

Шаг

1. k

= 0,

- исходная точка.

- исходная точка.

Шаг 2. Вдоль каждого направления определяем минимум

Получаем

новое направление ( )

)

Шаг

3. Вычисляем

Если

или

или ,

,

то

=> переход к шагу 4.

=> переход к шагу 4.

Иначе

новое направление:

;

;

переход к шагу 4.

переход к шагу 4.

Шаг

4. Проверим,

если

, то

, то и остановка

и остановка

Иначе

или

или ;

k=k+1;

Переход к шагу 2.

;

k=k+1;

Переход к шагу 2.

Метод сопряженного градиента.

Задано

xo

=> первое направление

;

;

-

выбирается

так, что

-

выбирается

так, что

и

и

– сопряженные

– сопряженные

;

;

– т.к. они перпендикуляры

– т.к. они перпендикуляры

=0

=0

=>

=>

Алгоритм:

1. ,

k

= 0.

,

k

= 0.

2.

;

; ;

;

3.

Если j n,

то выполняется шаг 3.1; иначе шаг 4

n,

то выполняется шаг 3.1; иначе шаг 4

3.1

след. Сопряженное направление

след. Сопряженное направление

Если

, то

, то

и остановка

и остановка

Иначе шаг 3.2

3.2 j=j+1 и переход к шагу 3

4.

;k=k+1,

переход к шагу 2.

;k=k+1,

переход к шагу 2.

8. Постановка задачи многомерной безусловной оптимизации и классификация методов ее решения. Методы первого порядка: наискорейшего спуска, покоординатного спуска, Гаусса-Зейделя. Их сравнительный анализ.

Постановка задачи

,

, ,

задана функция

,

задана функция .

Необходимо найтиmin(илиmax)

.

Необходимо найтиmin(илиmax)

исходные

данные:

Классификация методов:

1) Прямые методы поиска

Знание целевой ф-ии не нужно, необходимо только уметь вычислять ее в точках

2) Методы первого порядка (градиентные методы)

Нужно знать вид функции, уметь вычислять первую производную. Выбор направления основан на вычислении градиента

3) Методы второго порядка

Нужно знать вид функции, уметь вычислять градиент и матрицу Гесса

Метод наискорейшего спуска.

1.

k= 0

k= 0

2. выч-м

, где

, где

3. выч-м

4.

если

=>

=> -min, иначеk=k+1

и переход к шагу2

-min, иначеk=k+1

и переход к шагу2

Метод покоординатного спуска.

1.

k = 0,

k = 0,

=

=

2.

...

3. ,

если

,

если ,

то

,

то и останов, иначе k=k+1 и переход к шагу2

и останов, иначе k=k+1 и переход к шагу2

Метод Гаусса-Зейделя

1.

2. Осуществляем циклический поиск по j=1,...,n

3.если

,

то

,

то ,

иначеk=k+1

и переход к шагу 2.

,

иначеk=k+1

и переход к шагу 2.

Сравнительный анализ

Метод наскорейшего спуска:

1) В каждой точке вычисляется градиент функции => много вычислений

2) Плохо ищет экстремум для овражной функции

3) При большой точности поиск может остановиться, не достигнув минимума.

Другие 2 метода уменьшают объем вычислений. Методы покоординатного спуска и Гаусса-Зейделя по сути одинаковы, но в Гаусса-Зейделе меньше вычислений. В покоординатном спуске - более оптимальный поиск. Все 3 метода плохо ищут экстремум овражной функции.