Информатика.Подготовка к интернет тесту / Разделы по интернет-экзамену / Раздел 1_теория__нов1

.pdf

Раздел 1. Основные понятияи методы теории информации и кодирования. Сигналы, данные, информация. Общая характеристика процессов сбора, передачи, обработки и накопления информации.

Сообщения, данные, сигнал, атрибутивные свойстваинформации, показателикачестваинформации, формыпредставления информации. Система передачи информации

Сигнал – это изменяющийся во времени физический процесс.

Формы сигналов: аналоговый, дискретный, цифровой. Аналоговые сигналы представляют собой непрерывный поток, характеризующийся изменениями частоты и амплитуды. Это означает, что форма аналогового сигнала обычно похожа на синусоиду (т.е. гармоническую волну). Дискретный сигнал – сигнал, имеющий конечное число значений. Обычно сигналы, передаваемые через дискретные каналы, имеют два или три значения. Цифровой сигнал – представляет собой последовательность резко сменяющих друг друга значений.

При кодировании звук подвергается дискретизации и квантованию. При дискретизации изменяющаяся во времени величина (сигнал) замеряется с заданной частотой (частотой дискретизации), т.е. сигнал разбивается по временной составляющей. Квантование же приводит сигнал к заданным значениям, т.е. разбивает по уровню сигнала. Сигнал, к которому применены дискретизация и квантование, называется цифровым. Качество кодирования зависит от количества измерений уровня сигнала в единицу времени. Чем большее количество измерений производится за 1 секунду (чем больше частота дискретизации), тем точнее процедура двоичного кодирования. При оцифровке сигнала уровень квантования называют также глубиной дискретизации или битностью. Глубина дискретизации измеряется в битах и обозначает количество битов, выражающих амплитуду сигнала. Чем больше глубина дискретизации, тем точнее цифровой сигнал соответствует аналоговому сигналу.

Сигналы могут порождать в физических телах изменения свойств. Это явление называется регистрацией сигналов. Сигналы, зарегистрированные на материальном носителе, называются

данными.

Чтобы получить информацию, имея данные, необходимо к ним применить методы, которые преобразуют данные в понятия, воспринимаемые человеческим сознанием. Таким образом, можно считать, что информация – это продукт взаимодействия данных и адекватных методов. Отсюда следует, что информация не является статическим объектом, она появляется и существует в момент слияния данных и методов, все остальное время она находится в форме данных. Момент слияния данных и методов называется информационным процессом.

Энтропия в теории информации представляет собой меру неопределенности состояния системы. В теории информации по концепции Шеннона под информацией понимают сведения, уменьшающие неопределенность (энтропию).

Сообщения – это сведения о каких-то событиях.

Свойства информации (показатели качества):

Дуализм информации характеризует ее двойственность. С одной стороны, информация объективна в силу объективности данных, с другой – субъективна, в силу субъективности применяемых методов.

Полнота информации характеризует степень достаточности данных для принятия решения или создания новых данных на основе имеющихся.

Достоверность информации – это свойство, характеризующее степень соответствия информации реальному объекту с необходимой точностью. Информация достоверна, если она отражает истинное положение дел.

Адекватность информации (релевантность) выражает степень соответствия создаваемого с помощью информации образа реальному объекту, процессу, явлению; способность информации соответствовать нуждам (запросам) потребителя

Объективность информации – независимость от личного мнения.

Подготовкактестированию

Актуальностьинформации– степень соответствияинформациитекущему моменту времени.

Доступность информации – это возможность получения информации при необходимости. Доступность складывается из двух составляющих: из доступности данных и доступности методов. Отсутствие хотя бы одного дает неадекватную информацию.

Информацию следует считать особым видом ресурса, при этом имеется в виду толкование «ресурса» как запаса неких знаний материальных предметов или энергетических, структурных или каких-либо других характеристик объекта. В отличие от ресурсов, связанных с материальными предметами, информационные ресурсы являются неистощимыми и предполагают существенно иные методы воспроизведения и обновления, чем материальные ресурсы. В связи с таким взглядом центральными становятся следующие свойства информации: запоминаемость, передаваемость, преобразуемость, воспроизводимость, стираемость. Фундаментальным свойством информации, означающим, что информация может менять способ и форму своего существования, является преобразуемость. В общем случае количество информации

впроцессах преобразования меняется, но возрастать не может.

Различные классификации информации (восприятие, форма представления и др.)

Информацию условно можно классифицировать по различным признакам:

По способу восприятия различают следующую информацию: визуальную (воспринимаемую посредством органов зрения), аудиальную (воспринимаемую посредством органов слуха), тактильную (воспринимаемую посредством органов осязания), обонятельную, вкусовую.

По форме представления информацию можно разделить на

1)текстовую (передаваемую в виде символов, предназначенных обозначать лексемы языка),

2)числовую (передаваемую в виде цифр и знаков, обозначающих математические действия),

3)графическую (передаваемую в виде картин, фотографий, схем, чертежей, графиков и т.п.). По области получения и применения информацию можно разделить на бытовую, научную,

производственную, техническую, управленческую и прочую.

Информационные процессы

1.Сбор данных – один из важных информационных процессов. От того, как он организован, во многом зависит своевременность и качество принимаемых решений.

2.Передача данных – это процесс обмена данными. Предполагается, что есть источник информации, канал связи, приемник информации, и между ними приняты соглашения о порядке обмена данными.

3.Хранение данных – это поддержание данных в форме, постоянно готовой к выдаче их потребителю. Одниите жеданные могут бытьвостребованы не однажды, поэтомуразрабатываются способы их хранения (обычно на материальных носителях) и методы доступа к ним по запросу потребителя.

4.Обработка данных – это процесс преобразования информации от исходной ее формы до определенного результата.

Измерение информации

Содержательный подход: Если сообщение несет 1 бит информации, то оно уменьшает неопределенность знаний в 2 раза.

Алфавитный подход: 1 бит – это информационный вес символа двоичного алфавита.

Аспекты позиций оценивания информации

Семантический аспект отражает смысловое содержание информации и соотносит ее с ранее имевшейся информацией. Смысловые связи между словами или другими элементами языка отражает тезаурус.

Прагматический аспект определяет возможность достижения поставленной цели с учетом полученной информации. Этот аспект отражает потребительские свойства информации (с точки зрения ее практической полезности).

Синтаксический аспект связан со способом представления информации вне зависимости от ее смысловых и потребительских качеств. На синтаксическом уровне рассматриваются формы представления информации для ее передачи и хранения (сообщения, данные).

Материал составил: доценткаф.информатики ИрГТУ, к.ф.-м.н. ИринаВитальевна Орлова

Меры иединицы количестваи объемаинформации

Формулы Хартли и Шеннона. Разработаны различные способы оценки количества информации. В 1928 году американский инженер Ральф Хартли рассматривал процесс получения

информации как выбор одного сообщения из конечного наперед заданного множества из N равновероятных сообщений, а количество информации I, содержащееся в выбранном сообщении, определял как двоичный логарифм N.

Формула Хартли: I = log2N.

В качестве примера использования формулы Хартли рассмотрим задачу. Допустим, нужно угадать одно число из набора чисел от единицы до ста. Поформуле Хартли можно вычислить, какое количество информации для этого требуется: I = log2100 = 6,644. Таким образом, сообщение о верно угаданном числе содержит количество информации, приблизительно равное 6,644 единицы информации.

А теперь рассмотрим другую задачу: являются ли равновероятными сообщения «первой выйдет из дверей здания женщина» и «первым выйдет из дверей здания мужчина». Однозначно ответить на этот вопрос нельзя. Все зависит от того, о каком именно здании идет речь. Если это, например, станция метро, то такая вероятность одинакова для мужчины и женщины, а если это военная казарма, то для мужчины эта вероятность значительно выше, чем для женщины.

Для подобных задач американский ученый Клод Шеннон предложил в 1948 году другую формулу определения количества информации, учитывающую возможную неодинаковую вероятность сообщений в наборе.

Формула Шеннона: I = – ( p1·log2p1 + p2·log2p2 + . . . + pN·log2pN),

где pi – вероятность того, что именно i-е сообщение выделено в наборе из N сообщений.

Легко заметить, что если вероятности p1, ..., pN равны, то каждая из них равна 1/N, иформула Шеннона превращается в формулу Хартли.

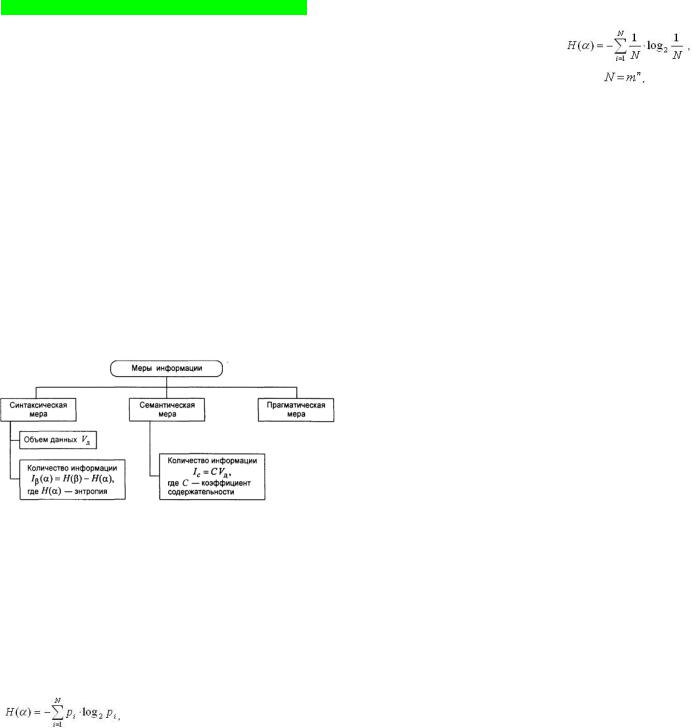

Меры информации

Синтаксическая мера информации

Синтаксическая мера количества информации оперирует с обезличенной информацией, не выражающей смыслового отношения к объекту.

Объем данных Vд в сообщении измеряется количеством символов (разрядов) в этом сообщении. В различных

системах счисления одинразрядимеет различныйвесисоответственноменяетсяединица измерения данных:

вдвоичной системе счисления единица измерения – бит (bit binary digit – двоичный разряд);

вдесятичной системе счисления единица измерения – дит (десятичный разряд).

Пример. Сообщение в двоичной системе в виде восьмиразрядного двоичного кода 10111011 имеет объем данных Vд = 8 бит. Сообщение в двоичной системе в виде шестнадцатиразрядного двоичного кода

1011101110111011 имеет объем данных Vд =16бит.

Сообщение в десятичной системе в виде шестиразрядного числа 275903 имеет объем данных

Vд = 6 дит.

Количество информации определяется по формуле:  где H(α) – энтропия, т.е. количество информации измеряется изменением (уменьшением) неопределенности состояния системы.

где H(α) – энтропия, т.е. количество информации измеряется изменением (уменьшением) неопределенности состояния системы.

Энтропия системы Н(α), имеющаяNвозможных состояний, согласноформуле Шеннона, равна:

где pi – вероятность того, что система находится в i-м состоянии.

Подготовкактестированию

Для случая, когда все состояния системы равновероятны, ее энтропия определяется соотношением

где N – число всевозможных отображаемых состояний; m – основание системы счисления (разнообразие символов, применяемых в алфавите); n – число разрядов (символов) в сообщении.

Семантическая мера информации

Для измерения смыслового содержания информации, т.е. ее количества на семантическом уровне, наибольшее признание получила тезаурусная мера, которая связывает семантические свойства информации со способностью пользователя принимать поступившее сообщение. Для этого используется понятие тезаурус пользователя.

Тезаурус – это совокупность сведений, которыми располагает пользователь или система.

Прагматическая мера информации

Эта мера определяет полезность информации (ценность) для достижения пользователем поставленной цели. Эта мера также величина относительная, обусловленная особенностями использования информации в той или иной системе. Ценность информации целесообразно измерять в тех же самых единицах (или близких к ним), в которых измеряется целевая функция.

Бит, байт и производные от них единицы

В качестве единицы информации К.Шеннон предложил принять такое количество информации, при котором неопределенность уменьшается в2 раза. Такаяединица названа бит (англ. bit – binary digit – двоичная цифра). В вычислительной технике битом называют наименьшую «порцию» памяти компьютера, необходимую для хранения одного из двух знаков «0» и «1», используемых для внутримашинного представления данных и команд.

Информационный объем сообщения – количество двоичных символов, используемое для кодирования этого сообщения. Бит – слишком мелкая единица измерения. На практике чаще применяется более крупная единица – байт, равная 8 бит. Именно 8 бит требуется для того, чтобы закодировать любой из 256 символов алфавита клавиатуры компьютера (256 = 28).

1 байт = 8 бит

Широко используются также еще более крупные производные единицы информации:

1килобайт (Кбайт) = 1024 байт = 210 байт;

1мегабайт (Мбайт) = 1024 Кбайт = 220 байт;

1гигабайт (Гбайт) = 1024 Мбайт = 230 байт.

Впоследнее время в связи с увеличением объёмов обрабатываемой информации входят в употребление такие производные единицы, как:

1терабайт (Тбайт) = 1024 Гбайт = 240 байт;

1 петабайт (Пбайт) = 1024 Тбайт = 250 байт.

Определение объема текстовой информации. Двоичное кодирование текстовой информации

Кодирование заключается в том, что каждому символу ставится в соответствие уникальный десятичный код от 0 до 255 или соответствующий ему двоичный код от 00000000 до 11111111. Таким образом, человек различает символы по их начертаниям, а компьютер – по их кодам.

Присвоение символу конкретного кода – это вопрос соглашения, которое фиксируется в кодовой таблице. При вводе в компьютер текстовой информации происходит ее двоичное кодирование Пользователь нажимает на клавиатуре клавишу с символом, а в компьютер поступает его двоичный код (последовательность из восьми электрических импульсов). Код символа хранится в оперативной памяти компьютера, где занимает 1 байт. При выводе символа на экран происходит обратный процесс – декодирование, те. преобразование кода символа в его изображение.

В качестве международного стандарта присвоения символу определенного числового кода принята кодовая таблица ASCII (256 символов)

Существует несколько кодировок кириллицы (КОИ-8, WINDOWS, MS-DOS) Unicode – 2 байта для размещения 1 кода символа (65536 символов).

Материал составил: доценткаф.информатики ИрГТУ, к.ф.-м.н. ИринаВитальевна Орлова

ВАЖНО!!! Все символы кодируются одинаковым числом бит (алфавитный подход); чаще всего используют кодировки, в которых на символ отводится 8 бит (8-битные) или 16 бит (16-битные) (если не указан вид кодировки – по умолчанию 8-ми битная );

чтобы найти информационный объем текста I, нужно умножить количество символов N на число бит на символ K: I = N * K.

В кодировке ASCII каждый символ имеет 8-битовый код, т.е. занимает 1 байт.

В кодировке Unicode на каждый символ отводится 2 байта = 16 бит.

Количество информации, которое вмещает один символ N-элементного алфавита, равно по формуле Р. Хартли i=log2N.

Мощность алфавита (N) по формуле Р. Хартли равна N=2i, где i – количество информации (бит для кодирования), N – количество вариантов (символов, цветов и т.п.).

Взаимосвязь энтропии и информации H+Y=1, где Н – энтропия,Y – информация.

Например, объем текстовой информации в сообщении на 20 страницах (на странице35строк по85 символов в каждой) в кодировке ASCII равен…

0,0065 Мбайт;60Кбайт; 0,56 Кбайт;58 Кбайт Объем текстовой информации вычисляетсятак:сначала определяется количествосимволов в тексте. В

данном примере20*35*85=59500.В кодировке ASCII каждый символ имеет 8-битовый код, т.е. занимает 1 байт. Следовательно, объем равен 59500(байт). Переведем объем в килобайты, поэтому объем в килобайтах равен 59500/1024 =58 (Кбайт).

Другой пример. Количествоинформации в слове«Информация» при условии, чтодля кодирования используется 64-значный алфавит, равно _______битам(-ов).

11/32; 11; 352; 55

Количествоинформации, котороевмещает один символ N-элементногоалфавита, равноi=log2N. Это известнаяформула Р. Хартли. В 64-значном алфавитекаждый символнесет i=log2N=log264=6(бит) информации. В слове«Информация» 10 символов. Количествоинформации вслове«Информация» при кодировании в 64-значномалфавитеравно10*6=60(бит)

Аналоговый и дискретный способы представления изображений и звука

Информация, в том числе графическая и звуковая, может быть представлена в аналоговой и дискретной форме. При аналоговом представлении физическая величина принимает бесконечное множество значений, причем ее значения изменяются непрерывно. При дискретном представлении физическая величина принимает конечное множество значений, причем величина изменяется скачкообразно. Примеры аналогового и дискретного представлений информации помещены в

Примеры аналогового и дискретного представлений информации

Тип информации |

Аналоговое представление |

Дискретное представление |

Графическая |

Полотно живописной картины, |

Изображение, напечатанное с помощью |

информация |

цвет которой меняется |

струйного принтера (состоит из отдельных |

|

непрерывно |

точек разного цвета) |

Звуковая |

Виниловая пластинка (звуковая |

Аудио-CD (звуковая дорожка содержит |

информация |

дорожка меняет свою, форму |

участки с различной отражающей |

|

непрерывно) |

способностью) |

Преобразование графической и звуковой информации из аналоговой формы в дискретную производится путем дискретизации, т.е. разбиения непрерывного графического изображения (звукового сигнала) на отдельные элементы. В процессе дискретизации производится кодирование, т е присвоение каждому элементу конкретного значения в форме кода.

Дискретизация – это преобразование непрерывных изображений и звука в набор дискретных значений в форме кода.

Двоичное кодирование графической информации.

В процессе кодирования изображения производится пространственная дискретизация. Пространственную дискретизацию изображений можно сравнить с построением изображения из мозаики. Изображение разбивается на отдельные мелкие фрагменты (точки), каждому из которых присваивается код цвета.

Качество кодированиязависит от размераточки(чем меньше размер точки,тем качествовыше) и от цветовой палитры – количества цветов (чем больше количество, тем выше качество изображения).

Подготовкактестированию

Формирование растрового изображения. Графическая информация на экране монитора представляет собой растровое изображение, которое формируется из определенного количества строк, содержащих определенное количество точек – пикселей.

Качество изображения определяется разрешающей способностью монитора, например 800*600, 1280*1024. Чем больше разрешающая способность, тем выше качество изображения.

Рассмотрим формирование на экране монитора растрового изображения с разрешением 800*600 (800 точек на 600 строк, итого 480 000 точек на экране). В простейшем случае (черно-белое изображение без градаций серого цвета) – каждая точка может иметь одно из двух состояний – “черная" или “белая”, т.е для хранения ее состояния необходим 1 бит. Таким образом, объем чернобелого изображения (количество информации) равен:

<Количествоинформации> = Разрешающая способность>*1 (бит)

Цветные изображения формируются в соответствии с двоичным кодом цвета каждой точки (хранится в видеопамяти). Цветные изображения могут иметь различную глубину цвета, которая задается количеством битов, используемых для кодирования цвета, например: 8, 16, 24 или 32 бита Качество двоичного кодирования изображения определяется разрешающей способностью и

глубиной цвета (cм. таблицу).

Количество цветов N может быть вычислено по формуле: N=2i, где i – глубина цвета.

Глубина цвета и количество отображаемых цветов

Глубина цвета (i) |

8 |

16 (High Color) |

|

24 (True Color) |

|

32 (True Color) |

||

Количество изобра- |

28=256 |

218=65 536 |

|

|

224= 16 777 216 |

|

232= 4 294 967 296 |

|

жаемых цветов (N) |

|

|

|

|||||

Например, для хранения растрового изображения размером 128*128 пикселей отвели 4 килобайта |

||||||||

памяти.Каковомаксимальновозможноечисло цветов в палитреизображения? |

|

|||||||

|

|

1) 8 |

2) 2 |

3) 1 |

4) 4 |

|

|

|

<Количество информации> = <Разрешающаяспособность>*<Глубинацвета> <Количество цветов> =N= 2i, где i – глубина цвета.

Гц=Кол-воинф/Разрешение=4*210*8/(128*128)=215/(27*27)= 215/214=2

Кол-воцветов (N)=2i=22=4.

Двоичное кодирование звуковой информации. Временная дискретизация звука

Звук представляет собой звуковую волну с непрерывно A(t) меняющейся амплитудой и частотой. Чем больше амплитуда сигнала, тем он громче, чем больше частота, тем выше тон. Для того, чтобы компьютер мог обрабатывать звук, непрерывный звуковой сигнал должен быть превращен в последовательность электрических импульсов (двоичных нулей и единиц).

В процессе кодирования непрерывного звукового сигнала производится его временная дискретизация. При этом звуковая волна разбивается на мелкие временные участки, для каждого из которых устанавливается значение амплитуды. На графике это выглядит как замена гладкой кривой на последовательность "ступенек”, каждой из которых присваивается значение уровня громкости. Чем большее количество уровней громкости будет выделено в процессе кодирования, тем более качественным будет звучание.

При двоичном кодировании непрерывного звукового сигнала он заменяется последовательностью дискретных уровней сигнала. Качество кодирования зависит от количества измерений уровня сигнала в единицу времени, т е. частотой дискретизации. Чем большее количество измерений проводится в 1 секунду (чем больше частота дискретизации), тем точнее процедура двоичного кодирования.

Качество двоичного кодирования звука определяется глубиной кодирования и частотой дискретизации.

Частота дискретизации аналогового звукового сигнала может принимать значения от 8 кГц до 48 кГц. При частоте 8 кГц качестве диекретизеванноге звукового сигнала соответствует качеству радиотрансляции, а причастоте 48 кГц - качествузвучанияаудио-CD. Следует также учитывать, что возможны как моно-, так и стереорежимы.

Информационный объемстереоаудиофайла длительностьюзвучания1 секундапри высоком качестве звука (16 бит, 48 кГц). Для этого количество битов нужно умножить на количество выборок в 1 секунду и умножитьна 2 (стерео):

16бит*48000 *2 =1 536 000бит = 192000 байт = 187,5Кбайт

Материал составил: доценткаф.информатики ИрГТУ, к.ф.-м.н. ИринаВитальевна Орлова

Кодированиеданныхв ЭВМ

Целые числа обычно хранятся в двухбайтовом (Integer – целое) или четырехбайтовом (I.ong – длинное целое) формате.

Вn байтах можно разместить, целое положительное число от 0 до 256n-1. Поскольку один из разрядов требуется для кодирования знака числа, то максимальное по модулю целое число, которое можно закодировать в двух байтах, равно 32767. а в четырех байтах – 2147483647.

Целые числа со знаком обычно занимают в памяти компьютера два или четыре байта, при этом самый левый (старший) разряд содержит информацию о знаке числа.

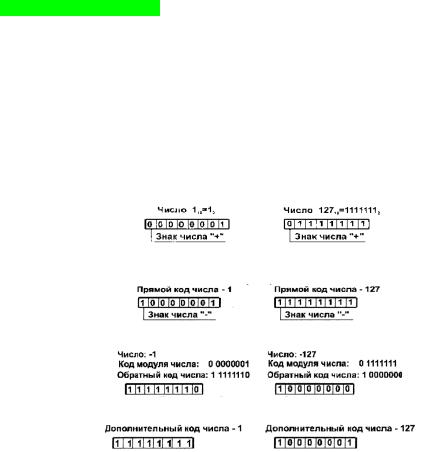

Вкомпьютерной технике применяются три формы записи (кодирования) целых чисел со знаком:

прямой код, обратный код, дополнительный код.

Последние две формы применяются особенно широко, так как позволяют упростить конструкцию арифметико-логического устройства компьютера путем замены разнообразных арифметических операций операцией сложения.

Положительные числа в прямом, обратном и дополнительном кодах изображаются одинаково – двоичными кодами с цифрой 0 в знаковом разряде. Например:

Отрицательные числа в прямом, обратном и дополнительном кодах имеют разное изображение.

1.Прямой код. В знаковый разряд помещается цифра 1, а в разряды цифровой части числа – двоичный код его абсолютной величины. Например:

2.Обратный код. Получается инвертированием всех цифр двоичного кода абсолютной величины числа, включая разряд знака: нули заменяются единицами, а единицы – нулями. Например,

3 .Дополнительный код. Получается образованием обратного кода с последующим прибавлением единицы к его младшему разряду. Например:

Обычно отрицательные десятичные числа при вводе в ЭВМ автоматически преобразуются в обратный или дополнительный двоичный код и в таком виде хранятся, перемещаются и – участвуют в операциях. При выводе таких чисел из ЭВМ происходит обратное преобразование в отрицательные десятичные числа.

Алгоритм получения дополнительного кода для отрицательного числа состоит из 3-х шагов. Шаг 1: Записать модуль числа (-105) в прямом коде в n двоичных разрядах. Число 105 в двоичной

системе счисления равно 1101001. Прямой 8-разрядный код числа 105 равен 01101001.

Шаг 2: Получить обратный код, инвертируя значения всех битов в прямом коде числа. В нашем примере получим обратный код: 10010110.

Шаг 3: Прибавить 1 к полученному обратному коду. 10010110+1=10010111. Итак, отрицательное число –105 в 8-разрядном компьютерном представлении будет равно 10010111.

Алгоритм получения числа по его дополнительному коду.

Если 16-разрядный дополнительный код равен 11100100110101102, то десятичное значение данного числа равно …

Для того чтобы найти десятичное число, необходимо:

1)из дополнительного кода вычесть 1 (11100100011010110-1=11100100011010101);

2)инвертировать полученное двоичное число (00011011100101010);

3)перевести инвертированное число в десятичную систему счисления

(000110111001010102=1412210);

4)взять полученное десятичное число с отрицательным знаком (-14122).

Представление в прямом, обратном и дополнительном коде при не указании разрядности представления числа.

Подготовкактестированию

Прямой код числа образуется кодированием знака числа нулём, если число положительно и единицей, если число отрицательно (для двоичной системы). Для общего случая (q - 1) – если число отрицательно, и 0 – если число положительно. q – основание системы счисления.

Код знака записывается перед старшей цифрой числа и отделяется от неё точкой: -101 = 1.101. Прямой, обратный и дополнительный коды положительных чисел совпадают между собой. Обратный код отрицательного числа образуется из прямого кода, заменой его цифр на их

дополнения до величины q-1. Код знака сохраняется без изменения. Пример:

+12310 = 0.123пр = 0.123об. |

+3А7С0016 = 0.3А7С00пр = 0.3А7С00об. |

-12310 = 9.123пр = 9.876об |

-3А7С0016 = F.3А7С00пр= F.C583FFоб. |

|

-1012 = 1.101пр = 1.010об. |

Принцип перевода описан ранее: замена цифр их дополнениями для двоичной системы совпадает с операцией инверсии, то есть нули заменяются единицами, единицы - нулями. Знак принимает значение, равное единице.

Дополнительный код отрицательного числа образуется из обратного увеличением на 1 его младшего разряда. При этом перенос из знакового разряда игнорируется. Пример:

+23610 = 0.236пр.= 0.236об.= 0.236доп. |

-1012= 1.101пр.= 1.010об= 1.011доп. |

-23610 = 9.236пр.= 9.763об.= 9.764доп. |

-3А7С16= F.3А7Спр= F.C583об.= F.C584доп. |

Правила перевода из прямого кода в обратный и из обратного в прямой, а также из прямого в дополнительный и из дополнительного в прямой совпадают между собой.

Действительные числа называют числами с плавающей точкой. Такие числа обычно хранятся в четырехбайтовом (Single – одинарная точность) или в восьмибайтовом (Double – двойная точность)

формате. 19705.0001=105 • 0.197050001.

Любое число N в системе счисления с основанием q можно записать в виде N = М • qp, где М – множитель, содержащий все цифры числа (мантисса), а р – целое число, называемое порядком. Такой способ записи чисел называется представлением числа с плавающей точкой.

В памяти первый байт занимает – знак числа, знак порядка, порядок. В остальных трех или семи байтах при двойной точности – мантисса.

Кодирование графической, звуковой и видеоинформации (см. выше)

Дополнения: Цветовые модели.

Если говорить о кодировании цветных графических изображений, то нужно рассмотреть принцип декомпозициипроизвольного цвета на основные составляющие. Применяютнесколько систем кодирования: HSB, RGB и CMYK.

1)Модель HSB характеризуется тремя компонентами: оттенок цвета (Hue), насыщенность цвета (Saturation) и яркость цвета (Brightness). Можно получить большое количество произвольных цветов, регулируя этикомпоненты. Эту цветовую модель лучшеприменять в тех графических редакторах,в которых изображения создают сами, а не обрабатывают уже готовые.

2)Принцип метода RGBзаключается в следующем:известно, что любой цвет можно представить в виде комбинации трех цветов: красного (Red, R), зеленого (Green, G), синего (Blue, B). Другие цвета и их оттенки получаются за счетналичияили отсутствияэтихсоставляющих. Попервымбуквамосновныхцветов система

иполучила свое название – RGB. Данная цветовая модель является аддитивной, то есть любой цвет можно получить сочетание основных цветов в различных пропорциях. При наложении одного компонента основного цвета на другой яркость суммарного излучения увеличивается. Если совместить все три компоненты, то получим ахроматический серый цвет, при увеличении яркости которого происходит приближение к белому цвету. При 256 градациях тона (каждая точка кодируется 3 байтами) минимальные значенияRGB (0,0,0) соответствуютчерномуцвету,а беломумаксимальныескоординатами(255, 255,255).

3)Принцип метода CMYK. Эта цветовая модель используется при подготовке публикаций к печати. Каждому из основных цветов ставится в соответствие дополнительный цвет (дополняющий основной до белого). Получают дополнительный цвет за счет суммирования пары остальных основных цветов. Значит, дополнительными цветами для красного является голубой (Cyan,C) = зеленый + синий = белый - красный, для зеленого - пурпурный (Magenta, M) = красный + синий = белый - зеленый, для синего - желтый (Yellow, Y) = красный + зеленый = белый - синий. Причем принцип декомпозиции произвольного цвета на составляющие можно применять как для основных, так и для дополнительных, то есть любой цвет можно представить или в виде суммы красной, зеленой, синей составляющей или же в виде суммы голубой, пурупурной, желтой составляющей. В основном такой метод принят в полиграфии. Но там еще используют черный цвет (BlacК, так как буква В уже занята синим цветом, то обозначают буквой K). Это связано с тем, что наложение друг на друга дополнительных цветов не дает чистого черного цвета.

Материал составил: доценткаф.информатики ИрГТУ, к.ф.-м.н. ИринаВитальевна Орлова