11.Нейронные сети встречного распространения

|

|

Объединение разнотипных нейроструктур способствует возникновению свойств, отсутствующих у этих структур по отдельности.

Сети встречного распространения были разработаны Р. Хехт-Нильсеном в 1986 г. [2].

Сети встречного распространения состоят из входного слоя простых нейронов, слоя нейронов Кохонена и слоя нейронов Гроссберга (входная звезда). Время обучения сети встречного распространения задачам распознавания и кластеризации более чем в сто раз меньше времени обучения этим задачам сети обратного распространения.

Нейрон слоя Кохонена с максимальным значением взвешенной суммы является победителем. На его выходе формируется уровень логической «1», на остальных – логический «0».

Нейроны слоя Гроссберга в результате выдают величины весов vij, которые связывают их с нейроном-победителем.

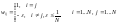

Обучение сети осуществляется с учителем, но обучение слоя Кохонена фактически проходит без учителя. В процессе обучения сети задается набор входных векторов и соответствующих им выходных. В результате обучения слоя Кохонена каждый его нейрон обучается реагировать на какой-то класс образов. При этом соответствие образа и нейрона не задается учителем, а получается случайным образом. Реакция слоя Гроссберга на случайный вектор выходов слоя Кохонена задается учителем. Особенность обучения нейронов Гроссберга состоит в том, что индивидуально настраивается тот вход каждого нейрона, который подключен к активному нейрону слоя Кохонена:

|

vij(t+1) = vij(t) + η (yj-vij(t))Ki, |

(27) |

где Ki – выход i-го нейрона Кохонена.

Таким образом, настройка весов, к которым подключены неактивные на очередной итерации обучения нейроны Кохонена, просто не производится. Вес каждого входа нейрона Гроссберга настраивается, только когда активен подключенный к этому входу нейрон Кохонена.

Сеть встречного распространения предназначена для построения отображений, т.е. производит отображение одного вектора в другой. При этом группа близких векторов на входе будет давать один и тот же вектор на выходе. Основное применение сетей встречного распространения – быстрая неточная начальная аппроксимация. Они не предназначены для точной аппроксимации.

Билет 12

Сеть поиска максимума MAXNET (сеть MAXNET циклического функционирования, сеть поиска максимума с конкуренцией посредством латерального торможения, максимизатор)

Одна из сетей, дающих результат «победитель забирает все» [4].

|

|

|

Рисунок 8. Сеть MAXNET |

На каждой итерации сильные сигналы на выходах нейронах подавляют слабые сигналы на выходах других нейронов.

Итерации сети завершаются, когда сигналы на выходах сети перестают меняться. При этом на всех выходах, кроме одного, формируется значение, близкое к нулю.

Входные сигналы – целые или действительные, выходные – действительные. Передаточные функции – линейные с насыщением. Число синапсов сети N(N-1).

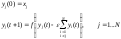

Формирование синаптических весов выполняется по формуле:

|

|

(29) |

Изменение выходных сигналов сети на очередной итерации описывается формулами:

|

|

(30) |

Используется совместно с сетью Хэмминга в составе систем распознавания образов.

Недостатки – неизвестное количество итераций, квадратичный рост числа синапсов при увеличении размерности входного сигнала.

Преимущество – простота.

.

. .

.