9 Вопрос

Преимущество по сравнению с сетью MAXNET циклического функционирования – заранее известен необходимый объем вычислений.

Сеть Кохонена (Kohonen’s Neural Network, Kohonen’s Self Organizing Feature Map – SOFM – самоорганизующаяся карта признаков Кохонена)

Предложена Кохоненом в 1984 г. [2]. Имеется множество модификаций.

Сеть предназначена для разделения N-мерных векторов входных сигналов на подгруппы. Сеть состоит из M нейронов, образующих прямоугольную решетку на плоскости. Элементы входных сигналов подаются на входы всех нейронов сети. В процессе работы алгоритма настраиваются синаптические веса нейронов.

Алгоритм использует меру соседства нейронов. Для каждого нейрона определяется зона соседства, т.е. некоторое множество нейронов, считающихся его соседями. Зона соседства в процессе обучения сужается.

Алгоритм:

Шаг 1. Инициализация. Весовым коэффициентам, количество которых MN, присваиваются произвольные малые значения. Определяются начальные зоны соседства.

Шаг 2. Предъявление сети входного сигнала.

Шаг 3. Вычисление расстояния от входного сигнала до каждого нейрона по формуле:

|

|

(23) |

где i(t) – i-й элемент входного сигнала в момент времени t;

wij(t) – вес связи от i-го элемента входного сигнала к j-му нейрону.

Шаг 4. Выбор нейрона j*, для которого расстояние dj является наименьшим.

Шаг 5. Настройка весов для нейрона j* и всех весов из его зоны соседства в соответствии с алгоритмом обучения Кохонена по формуле:

|

|

(24) |

где η – шаг обучения (0<η<1, сокращается со временем).

Шаг 6. Возврат к шагу 2.

Области применения: кластерный анализ, распознавание образов, классификация.

Сеть может быть использована, если заранее известно количество кластеров.

Сеть способна функционировать в условиях помех, т.к. число классов фиксировано, веса модифицируются медленно, и настройка весов заканчивается после обучения.

Одна из модификаций состоит в добавлении к сети Кохонена сети MAXNET, которая определяет нейрон с наименьшим расстоянием до входного сигнала.

10 Вопрос

Звезды Гроссберга

Предложены Гроссбергом [4]. Доказано, что являются моделями отдельных участков биологического мозга.

Известны входные звезды Гроссберга (Instar) и выходные звезды Гроссберга (Outstar).

Входная звезда реагирует на определенный входной вектор, которому она обучена.

В процессе обучения модификация весовых коэффициентов производится по формуле:

|

wi(t+1) = wi(t) + η (xi-wi(t)), |

(25) |

где η – коэффициент скорости обучения (в начальный момент равен 0.1, в процессе обучения сокращается до 0).

Обучение по такой формуле приближает весовой вектор к усредненному вектору обучающих образов. При этом звезда обучается реагировать на любой вектор этого определенного класса.

Используется в сетях распознавания образов.

И достоинства и недостатки сети заключены в ее простоте. Вследствие простоты использование звезды для решения сложных задач распознавания ограничено.

Как и входная звезда, выходная звезда используется как хранилище набора весовых коэффициентов. Решает обратную задачу: при наличии возбуждающего сигнала выставляет вектор весов на свои выходы.

Обучение производится итеративной настройкой на требуемой вектор весов по формуле:

|

wi(t+1) = wi(t) + η (yi-wi(t)). |

(26) |

Достоинства и недостатки аналогичны входной звезде.

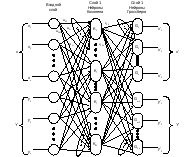

Нейронные сети встречного распространения

|

|

|

Рисунок 7. Сеть встречного распространения |

Объединение разнотипных нейроструктур способствует возникновению свойств, отсутствующих у этих структур по отдельности.

Сети встречного распространения были разработаны Р. Хехт-Нильсеном в 1986 г. [2].

Сети встречного распространения состоят из входного слоя простых нейронов, слоя нейронов Кохонена и слоя нейронов Гроссберга (входная звезда). Время обучения сети встречного распространения задачам распознавания и кластеризации более чем в сто раз меньше времени обучения этим задачам сети обратного распространения.

Нейрон слоя Кохонена с максимальным значением взвешенной суммы является победителем. На его выходе формируется уровень логической «1», на остальных – логический «0».

Нейроны слоя Гроссберга в результате выдают величины весов vij, которые связывают их с нейроном-победителем.

Обучение сети осуществляется с учителем, но обучение слоя Кохонена фактически проходит без учителя. В процессе обучения сети задается набор входных векторов и соответствующих им выходных. В результате обучения слоя Кохонена каждый его нейрон обучается реагировать на какой-то класс образов. При этом соответствие образа и нейрона не задается учителем, а получается случайным образом. Реакция слоя Гроссберга на случайный вектор выходов слоя Кохонена задается учителем. Особенность обучения нейронов Гроссберга состоит в том, что индивидуально настраивается тот вход каждого нейрона, который подключен к активному нейрону слоя Кохонена:

|

vij(t+1) = vij(t) + η (yj-vij(t))Ki, |

(27) |

где Ki – выход i-го нейрона Кохонена.

Таким образом, настройка весов, к которым подключены неактивные на очередной итерации обучения нейроны Кохонена, просто не производится. Вес каждого входа нейрона Гроссберга настраивается, только когда активен подключенный к этому входу нейрон Кохонена.

Сеть встречного распространения предназначена для построения отображений, т.е. производит отображение одного вектора в другой. При этом группа близких векторов на входе будет давать один и тот же вектор на выходе. Основное применение сетей встречного распространения – быстрая неточная начальная аппроксимация. Они не предназначены для точной аппроксимации.

,

, ,

,