Модели нейронных сетей

Модели НС делят на оптимизирующие и неоптимизирующие. И те, и другие функционируют в одном из двух режимов: обучения и решения задач. Некоторые разновидности «дообучаются» во время решения задач. Неоптимизирующие НС при решении задач преобразуют входные сигналы и выдают выходные. В оптимизирующих НС, как правило, используются обратные связи, и решение задач выполняется итеративно, т.е. сигнал проходит через сеть несколько раз, приближаясь к правильному решению. В ходе этих итераций выполняется оптимизация некоторой целевой функции, поэтому НС называются оптимизирующими.

1.6.1. Неоптимизирующие НС

6 Вопрос

Модель Маккаллока

У. Маккаллок и его ученик У.Питтс в 1943 г. сформулировали основные положения теории деятельности головного мозга [2]. Результаты их работ:

разработана модель нейрона как простейшего процессорного элемента, выполняющего вычисление переходной функции от скалярного произведения вектора входных сигналов и вектора весовых коэффициентов;

предложена конструкция сети таких элементов для выполнения логических и арифметических операций;

сделано основополагающее предположение о том, что такая сеть способна обучаться, распознавать образы, обобщать полученную информацию.

Недостатки модели Маккаллока и Питтса:

пороговый вид переходной функции (не предоставляет нейронной сети достаточную гибкость при настройке на заданную задачу, хотя значительно снижает требования к сложности структуры нейрона);

бинарность состояний нейронов и синапсов.

7 Вопрос

Модель Розенблата

Ф.Розенблат в 1958 г. ввел в модель Маккаллока и Питтса способность связей к модификации, что сделало его модель нейронной сети обучаемой. Однако пороговый вид переходной функции Розенблатом изменен не был. Эта модель была названа персептроном [2, 5]. Розенблат ставил целью моделирование человеческого зрения и распознавание образов. Его система распознавала некоторые буквы латинского алфавита.

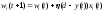

Работа персептрона сводится к классификации (обобщению) входных сигналов, принадлежащих n-мерному гиперпространству, по некоторому числу классов. С математической точки зрения это происходит путем разбиения гиперпространства гиперплоскостями [5]. Для однослойного персептрона

|

|

(20) |

Каждая полученная область является областью определенного отдельного класса. Число таких классов для персептрона не превышает 2m, где m – число его выходов. Однако не все из классов могут быть разделимы данной нейронной сетью.

Например, невозможность обучить однослойный персептрон логической функции исключающего ИЛИ (XOR) получила название проблемы исключающего ИЛИ. Ограниченная сложность решаемых персептроном задач является его основным недостатком. Основным достоинством является простота реализации.

8 Вопрос

Алгоритм обучения персептрона:

Шаг 1. Инициализация синаптических весов и смещения b некоторыми случайными малыми числами.

Шаг 2. Предъявление персептрону нового входного вектора x = (x1, …, xN) и требуемого выходного сигнала d.

Шаг 3. Вычисление выходного сигнала персептрона:

|

|

(21) |

где b – постоянное смещение.

Шаг 4. Настройка значений весов персептрона:

|

|

(22) |

где η (0< η<1) – коэффициент скорости обучения,

d – требуемый выход.

Если решение правильное, веса не модифицируются.

Шаг 5. Переход к шагу 2.

Персептрон применялся для задач автоматической классификации и был способен делить пространство признаков только линейными функциями, т.к. представлял собой однослойную нейронную сеть. Распознавание при помощи персептрона становилось невозможным при работе в пространстве признаков, обладающем свойством линейной неразделимости. Решением этой проблемы стало использование многослойного персептрона.

Персептрон стал первой действующей нейросетевой моделью, показавшей основные недостатки имеющихся решений задач ИИ и определившей основные направления дальнейших разработок в этой области.

Сеть поиска максимума с прямыми связями (Feed-Forward MAXNET, сеть поиска максимума, основанная на двоичном дереве и нейросетевых компараторах)

|

|

|

Рисунок 6. Сеть поиска максимума с прямыми связями |

Предложена в качестве дополнения к сети Хэмминга (см. п. 1.6.2) [4].Входные сигналы сравниваются попарно, и на каждый следующий слой сети передается наибольший сигнал. С выхода сети снимается сигнал, являющийся максимальным из входных.

Передаточные функции нейронов, формирующих сигналы y1, y2 – жесткие пороговые, передаточные функции остальных нейронов – линейные с насыщением.

Если вспомнить вид линейной функции с насыщением (рисунок 3, б), очевидно, что каждый из помеченных светлым нейронов первого уровня, обрабатывающих входные сигналы по формулам x1-x2 и x2-x1, формирует на выходе разность входных сигналов или 0. Т.е. если x1>x2, то на выходе первого нейрона будет сигнал, пропорциональный величине x1-x2, а на выходе второго 0. Сигнал z в этом случае будет равен:

0,5·(x1-x2) + 0,5·x1 + 0,5·x2 = x1

На рисунке 5 обозначены:

z – значение максимального сигнала

y1, y2 – индикаторы максимума.

Используется совместно с сетью Хэмминга в составе систем распознавания образов.

Недостаток – зависимость числа слоев сети от размерности входного сигнала

.

. ,

, ,

,