Содержание и структура информатики в схематическом виде

|

ТЕОРЕТИЧЕСКАЯ ИНФОРМАТИКА |

Философские основы информатики Теория информации. Методы измерения информации Математические основы информатики Информационное моделирование Теория алгоритмов Представление знаний и интеллектуально-информационные системы | |||

|

СРЕДСТВА ИНФОРМАТИЗАЦИИ |

Технические |

Хранения и обработки данных |

Персональные компьютеры. Рабочие станции. Вычислительные системы. Устройства ввода/вывода. Накопители (магнитные, оптические, смешанные) | |

|

Передачи данных |

Сети ЭВМ. Комплексы. Цифровые технические средства связи. Телекоммуникационные системы передачи аудио, видео и мультимедийной информации. | |||

|

Программные |

Системное ПО и системы программирования |

Операционные системы и среды. Сервисные оболочки. Утилиты. Системы и языки программирования. | ||

|

Реализации технологий |

Универсальных |

Текстовые и графические редакторы Системы управления базами данных Табличные процессоры Средства моделирования объектов, процессов и систем | ||

|

Профессионально-ориентированных |

Издательские системы Профессионально-ориентированные системы автоматизации расчетов Системы автоматизации проектирования, научных исследований и пр. | |||

|

ИНФОРМАЦИОННЫЕ ТЕХНОЛОГИИ |

| |||

|

СОЦИАЛЬНАЯ ИНФОРМАТИКА |

Информационные ресурсы общества Информационное общество – закономерности и проблемы Информационная культура, развитие личности Информационная безопасность | |||

Информационно-поисковые системы– это совокупность способов, предназначенных для хранения и поиска информации. К ним относятся базы данных (БД) и системы управления базами данных (СУБД), автоматизированные обучающие системы, автоматизированные рабочие места, системы автоматического проектирования, базы знаний и другие.

Все науки используют современные информационные технологии для практической реализации своих идей. Основным методом современного научного исследования является метод компьютерного моделирования (вычислительный эксперимент). Информатика занимает определенное место среди других наук, поставляя им общие идеи и основные методы исследования информационных процессов, а с информационными процессами имеет дело каждая отрасль научных знаний. Информатика формирует системный подход к изучению объектов, явлений и процессов окружающего мира.

РАЗНЫЕ ПОДХОДЫ К ОПРЕДЕЛЕНИЮ ИНФОРМАЦИИ. ОСОБЕННОСТИ ИНФОРМАЦИИ.

ИНФОРМАЦИЯ И СООБЩЕНИЯ. НЕПРЕРЫВНАЯ И ДИСКРЕТНАЯ ИНФОРМАЦИЯ.

ПОНЯТИЕ О ДИСКРЕТИЗАЦИИ.

В случаях, когда наука не может дать четкого определения конкретному объекту или явлению, приходится пользоваться понятиями. Понятия отличаются от определений тем, что разные люди при различных обстоятельствах могут вкладывать в них различное содержание. На бытовом уровне под информацией понимаются те сообщения (сведения), которые получают от природы и общества. Биологи в понятие информации вкладывают генетический код. В технике понятие информации отождествляют с различного рода сигналами. В теории информации, основы которой заложил Клод Шеннон, информация – это сообщение, которое снимает или уменьшает неопределенность. В неживой природе понятие информации связывают с отображением. В лингвистике понятие информации связано со смыслом (содержанием) сообщения. В этом случае под информацией понимают сообщения, которые являются новыми и полезными. В теории связи под информацией понимают любую последовательность сигналов, абстрагируясь от их содержания. В кибернетике информацией считают ту часть сообщений, которая берет участие в управлении. В документалистике под информацией понимают все то, что определенным образом зафиксировано в знаковой форме в виде документа.

Таким образом, в разных научных дисциплинах и в разных отраслях техники существуют разные понятия информации. Объединяет все эти подходы четыре основные особенности информации:ее можно создавать, передавать (и, соответственно, принимать), хранить и обрабатывать.Важной особенность информации является еенеисчерпаемость. Информация – это единый ресурс жизнеобеспечения, который не уменьшается, а его объем со временем возрастает. Это стало особенно заметно, начиная с середины ХХ столетия. В 70-х годах ХХ столетия объем информации удваивался каждые 5-7 лет, в 80-х – каждые 20 месяцев, а в 90-х – каждый год.

Характерные черты информации:

Информация приносит знания об окружающем мире, которых не было в рассматриваемой точке до получения информации.

Информация нематериальна, но передается с помощью материальных носителей – знаков и сигналов.

Знаки и сигналы несут информацию только для адресата, способного распознать их.

Во время передачи информации от источника до адресата информация в источнике не исчезает (не уменьшается).

Информация

является основной составляющей

цивилизации, информационных процессов.

Особую роль в жизни человека играет

научная информация.Научная

информация – это полученная в

процессе познания логическая информация,

которая адекватно (соответственно)

отображает явления и законы природы,

общества, мышления и используются в

общественно-исторической практике.Научная (как и бытовая) информация

подается с помощью сообщений.Сообщение

– это форма подачи информациив виде

языка, текста, изображения, цифровых

данных, таблиц, графиков и т.д. Способы

подачи информации – знаки и сигналы.Информация и сообщения –

неопределяемые понятия.Связь между

ними устанавливается через понятиеотображение, которое является

результатом договоренности между

отправителем (источником) и получателем

сообщения (адресатом), или описанием

(алгоритмом). Отображение![]() сообщенияPна

информациюIназываютправилом интерпретации:

сообщенияPна

информациюIназываютправилом интерпретации:![]() .Информация передается с помощью

конкретного сообщения. Правило

интерпретации

.Информация передается с помощью

конкретного сообщения. Правило

интерпретации![]() для данного сообщения часто получается

как отдельный случай некоторого общего

правила, которое применяется к целому

множествуMсообщений,

построенных по одинаковым законам.

Если формулируется сообщение на

некотором языке, то выражение «xпонимает языкМ» выражает тот факт,

что особахзнает правило интерпретации

для данного сообщения часто получается

как отдельный случай некоторого общего

правила, которое применяется к целому

множествуMсообщений,

построенных по одинаковым законам.

Если формулируется сообщение на

некотором языке, то выражение «xпонимает языкМ» выражает тот факт,

что особахзнает правило интерпретации![]() для всех (по крайней мере, для большинства)

сообщений, сформулированных на данном

языке. Иногда правило интерпретации

известно ограниченному кругу особ: к

этому относятся правила интерпретации

для специальных языков, в частности

для профессиональных и научных языков

(жаргонов). Связь между сообщениями и

информацией особенно четко просматриваются

вкриптографии (способ

тайнописи, основанный на использовании

шрифта): здесь никто посторонний не

должен иметь возможность получить

информацию с сообщением, которая

передается, иначе это означало бы, что

он имеет «ключ».

для всех (по крайней мере, для большинства)

сообщений, сформулированных на данном

языке. Иногда правило интерпретации

известно ограниченному кругу особ: к

этому относятся правила интерпретации

для специальных языков, в частности

для профессиональных и научных языков

(жаргонов). Связь между сообщениями и

информацией особенно четко просматриваются

вкриптографии (способ

тайнописи, основанный на использовании

шрифта): здесь никто посторонний не

должен иметь возможность получить

информацию с сообщением, которая

передается, иначе это означало бы, что

он имеет «ключ».

Соответствие между сообщением и информацией не является однозначной.Разные сообщения могут содержать одну и ту информацию (класс эквивалентности сообщений). Например, сообщение на разных языках о результатах матчу на кубок Европы. Одно и тоже сообщение может содержать разную информацию. Например, сообщение об авиакатастрофе несет разную информацию для руководства авиакомпании и для родственников погибших; разную информацию получают из политической статьи в газете политолог и обыкновенный гражданин.

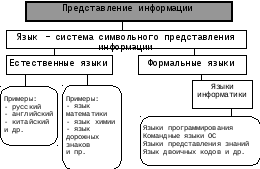

Информация может быть одной и той же, но ее представления – различными. Обработка информации начинается с представления ее в той или иной форме. Информация, выраженная с помощью букв, чисел, математических символов, естественного языка называется сообщением.Сообщение – это различные представления какой-либо информации.Сообщения состоят из знаков. Знаки обычно объединяются вслова. Система знаков, предназначенная для выражения сообщений, называетсязнаковой системой. К знаковым системам относится, например, естественный язык общения, язык программирования, язык химических формул и реакций и т.д. Основой знаковой системой являетсяалфавит.Алфавит – это минимальный упорядоченный набор знаков, с помощью которого строятся слова.

Каждой знаковой системе присущи, как правило, определенные свойства. Одним из таких свойств является полнотазнаковой системы. Если знаковая система обладает полнотой, то с ее помощью можно выразить любое сообщение. Так алфавит десятичных (арабских) цифр является полным с точки зрения выполнения арифметических действий над числами. Точно так же полным является алфавит кириллицы с точки зрения русского языка. Хотя большинство естественных языков устроено таким образом, что пропуск одной или даже нескольких букв незначительно усложняет восприятие сообщений. Это достигается благодаря другому свойству знаковой системы –избыточности. Избыточность позволяет правильно понимать сообщения в условиях воздействия помех. Одно и то же сообщение можно выразить в различных знаковых системах. Например, дату 22 мая 2000 года, которая записана с помощью кириллицы и арабских цифр, можно записать в латинском алфавите и цифрами (22may2000), с помощью знаков и цифр (22.05.00 или 22/05/00). Суть сообщения от этого не изменится. Различные представления одной и той же информации называютсяэквивалентными сообщениями.

Таким образом, для одной и той же информации могут существовать сообщения в разных знаковых системах. С другой стороны, одно и то же сообщение может нести различную смысловую нагрузку, различную информацию для разных получателей. Для любого сообщения важна его интерпретация, толкование. Чтобы понять, какую информацию несет сообщение, нужно знать способ кодирования сообщения. Чтобы сообщение можно было обработать с помощью электронной аппаратурой (в том числе, компьютера), его преобразуют в электрический сигнал.Сигналом называется смена некоторой физической величины во времени, которая обеспечивает передачу сообщения (тем самым и информации). Сигналы бывают непрерывными (аналоговыми) либо дискретными (импульсивными). Непрерывный сигнал можно описать функцией, которая плавно изменяется во времени. Сигнал называетсянепрерывнымилианалоговым, если его параметр принимает непрерывные значения.

Дискретные сигналы описываются функцией U(t), которая в определенные моменты времени изменяется скачком. Сигнал называетсядискретным, если параметр сигнала может принимать конечное число значений и существенен лишь в конечном числе моментов времени. Сообщения, которые могут быть переданы с помощью дискретных сигналов, называютдискретными сообщениями. Они передаютдискретную информацию. Дискретизация позволяет подать непрерывную информацию дискретно, в виде таблицы, которую можно поместить в память компьютера для последующей обработки. Дискретизация часто используется для анализа результатов физических, биологических и других экспериментов. Таким образом, любую непрерывную информацию можно аппроксимировать дискретной информацией с любой степенью точности, поэтомудискретная форма подачи информации является универсальной. Дискретные сигналы чрезвычайно важны в вычислительной технике. Компьютеры имеют дело только с дискретной информацией, которая подается физически (кодируется) в виде последовательности цифровых (дискретных) сигналов.

ОСНОВНЫЕ НАУЧНЫЕ НАПРАВЛЕНИЯ ИССЛЕДОВАНИЯ ИНФОРМАЦИИ:

СЕМАНТИЧЕСКИЙ, СИНТАКСИЧНЫЙ И ПРАГМАТИЧНЫЙ.

Есть три научных направления, связанных с исследованием информации: семантический (содержательный), синтаксический и прагматичный. Их впервые предложил рассматривать один из авторов так называемой статистической теории информации американский ученый У. Уивер.

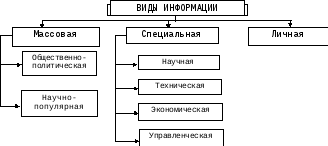

Семантическая (содержательная) информация– это информация, основана на однозначной связи знаков (сигналов) с объектами действительного мира (студент, преподаватель, ученик, компьютер, стол, тетрадь, книга и т.д.). Именно с семантической информацией постоянно имеет дело человек. Содержательную информацию условно можно классифицировать по способам восприятия, по форме подачи, по общественному назначению.По способу восприятиявыделяют визуальную, звуковую (аудио), осязательную, обонятельную и вкусовую информацию.По форме подачивыделяют текстовую, числовую, графическую, звуковую и комбинированную (мультимедийную) информацию.По общественному назначениювыделяют личную, массовую (повседневную, общественно-политическую, эстетическую) и специальную (научную, производственную, техническую, управленческую) информацию.

Содержательной (семантической) информации присущи: объективность, достоверность, полнота, актуальность, полезность, понятность.

Объективность.Информация – это отображение внешнего мира, который существует независимо от нашего сознания, мыслей и рассуждений о нем.

Достоверность.Информация достоверна, если она отражает истинное положение дел. Только на основе достоверной информации могут приниматься правильные решения.

Полнота.Информация является полной, если ее достаточно для понимания ситуации и принятия решения.

Актуальность.Информация актуальна, если она истинна, важна для данного времени.

Полезность.Степень полезности зависит от потребности конкретных людей и от задач, которые с помощью полученной информации можно решить.

Понятность.Информация понятна, если во время восприятия ее человеком не возникает дополнительных вопросов, потребности в дополнительных сообщениях.

Недостатком теории семантической информации является отсутствие формального аппарата, приспособленного для ее оценки. Наиболее распространенными являются две теории семантической информации.

Семантическая теория информации, созданная в 1953 году американскими учеными Н.Бар-Хиллелом и Р.Карнаком, исследует простые высказывания некоторого формализованного языка. Количество семантической информации простого высказывания оцениваются функцией логической вероятности. Данная семантическая теория не исследует процесса связи между субъектами и историческими условиями, что обусловливает незначительную ее практическую пригодность.

Другой подход к оценке семантической информации осуществлен российским математиком-логиком Ю.А.Шрейдером. В ее основе лежит понятие тезауруса. Тезаурус (в переводе с греческого – клад) – это множество содержательновыражающих элементов и отношений на этом множестве. Согласно с этой теорией, все построение человеческих знаний можно рассматривать в виде совокупности содержательновыражающих элементов и содержательных отношений между ними. Отметим, что с получением содержательной информации связывают и возникновение эмоций, которые можно понимать как биологическую реакцию на информацию. Знания– это накопленная в процессе практической и научной деятельности информация, которая подает в сжатой систематизированной форме все сведения об объекте, процессе или явлении.Тезаурус– это знания, представленные в виде понятий и отношений между ними, т.е. определенным образом структурированные знания. (В узком понимании «тезаурус» - это словарь для поиска слов определенного языка по их смыслу.) Эффективность передачи информации зависит от соотношения тезаурусов источника и адресата. Одно и тоже сообщение содержит разное количество информации, например, для ребенка, студента и специалиста. В связи с малым развитием тезауруса ребенок не понимает текста вузовского учебника по высшей математики и количество полученной им информации равняется нулю. Большой запас знаний у специалиста практически ничем не пополняется во время чтения этого учебника и количество полученной им информации также равняется нулю. Наиболее содержательным и полезным учебник будет для студента. Модель Шрейдера предусматривает один из возможных перспективных путей для решения проблемы оценки семантической информации: изучение, составление тезаурусов природных (обычных) языков или вывод таких искусственных семантических систем, которые приближаются к обычным и структура тезауруса которых может быть описана полностью формально.

Синтаксическая информация – это информация, которая основана на порядке и взаимосвязи следования знаков. Тут не учитывается содержание, которые несут эти знаки. Например, важная теорема в 1000 знаков, фрагмент произведения А.С.Пушкина в 1000 знаков и произвольная (не имеющая смысла) совокупность из 1000 знаков имеют тут одинаковый вес. Синтаксическая информация всегда дискретна. Она подается определенной последовательностью знаков (дискретных сигналов). Синтаксическое направление исследования информации исключает ее человеческую оценку. Французский физик Леон Брилюен в книге «Наука и теория информации» отмечает, что «исключение человеческой оценки информации – это как раз путь к ее научному обсуждению». Создан точный математический аппарат для оценки синтаксической информации. Следует отметить, что синтаксическая информация имеет практическую ценность потому, что семантическая информация (а именно она в конечном итоге интересует человека-адресата) содержится в заданной последовательности знаков или сигналов. Чем больше знаков передается за данный промежуток времени, тем больше в среднем ( по совокупности всех сообщений) передается семантической (содержательной) информации.

Прагматической информациейназывается информация, полезная для достижения конкретной цели. Ценность информации в этом случае выступает как конкретная величина: нет просто полезной информации, а есть информация, ценная для конкретного адресата в конкретный момент времени. Материал, который находится в сообщении, может быть богатым семантической информацией и при этом может быть лишен ценности для субъекта, который обучается, если этот материал не способствует достижению конкретной цели. В наше время разработаны лишь отдельные подходы для оценки прагматической информации.

Информация для человека – это знания, которые даются с помощью сообщений. Наиболее полезными для человека являются информативные сообщения.Информативное– это такое сообщение, которое пополняет знания человека, т.е. несет новую для него информацию. Для разных людей одно и то же сообщение с точки зрения его информативности может быть разным. Если сообщение не несет полезной для конкретного человека в конкретный момент времени информации, тогда оно несетшум.

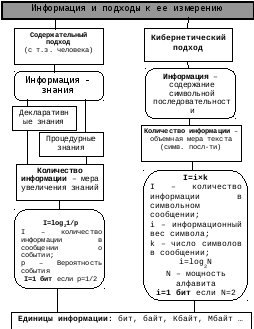

ИЗМЕРЕНИЕ ИНФОРМАЦИИ.

Существует несколько способов оценивания информации: алфавитный (объемный или технический), алгоритмический, комбинаторный, вероятностный. Наибольшую практическую ценность имеют алфавитный и вероятностный.

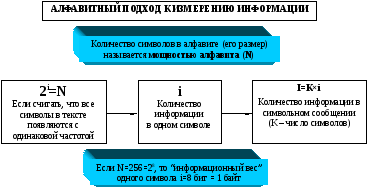

Алфавитный способ измерения информации.

Единицы измерения.

В вычислительной (компьютерной) технике широко используется алфавитный способ измерения информации. Суть этого способа состоит в том, что носителем информации считают слово, которое является последовательностью символов (букв) и каждый новый символ увеличивает количество информации в слове (безотносительно к содержанию), которое представлено в выбранном алфавите. Для измерения количества информации нужно выбрать соответствующий эталон (как выбрать метр, килограмм и т.д.). Эталоном для подсчета информации, представленной конечной последовательностью символов, логично считать слово минимальной длины – которое складывается из одного символа (буквы). Количество информации, которое содержится в слове из одного символа, принимают за единицу измерения. Если строим сообщение, используя двухзначный алфавит {0, 1}, то любой их этих символов становится эталонной единицей измерения информации. Величину, способную принимать только два значения (0 и 1), называютбитом. Сравнивая текст с эталоном, можно установитьобъем (количество) информации. Информационный объем сообщения определяется по формуле

![]() (1.1)

(1.1)

г деk– количество символов

в сообщении, аl–

количество битов в одном символе.

деk– количество символов

в сообщении, аl–

количество битов в одном символе.

Следует отметить, что этот способ применим для оценивания синтаксической информации, где содержание сообщения игнорируется. К информативности сообщения данная величина может не иметь никакого отношения, поэтому использовать при алфавитном способе оценки информации термин «количество информации» некорректно. Целесообразно говорить об (потенциальном) информационном объеме сообщения, его информационной длине, а не про количество информации.

Алфавитный (объемный) способ измерения информации, благодаря его простоте, широко используется в технике, в частности, компьютерной, поэтому его часто называют техническим. Этот способ измерения информации широко используется для оценивания внутренней и внешней памяти компьютеров, характеристики пропускной возможности компьютерных сетей. При этом используются производные от бита, значительно большие единицы измерения информации:

Байт (1 байт = 8 битов = 23битов);

Килобайт (1 Кб = 1024 байт = 210байтов);

Мегабайт (1 Мб = 1024 Кб = 220байтов);

Гигабайт (1 Гб = 1024 Мб = 230байтов);

Терабайт (1 Тб = 1024 Гб = 240байтов);

Петабайт (1 Пб = 1024 Тб = 250байтов).

Теорема 1.

Над алфавитом мощностью m можно создать ровно mn слов длиною n.

Доказательство:

Воспользуемся

методом полной математической индукции.

Пусть

![]() - элементы (буквы) алфавита

- элементы (буквы) алфавита![]() мощностью

мощностью![]() .

Из этого алфавита можно создать

.

Из этого алфавита можно создать![]() слов длиной 1. Такими словами будут

буквы этого алфавита. Для

слов длиной 1. Такими словами будут

буквы этого алфавита. Для![]() данное утверждение является правильным

данное утверждение является правильным![]() .

.

Допустим, что данное

утверждение является правильным для

![]() ,

и покажем, что тогда оно выполняется и

для

,

и покажем, что тогда оно выполняется и

для![]() .

Предположим, число длины

.

Предположим, число длины![]() равняется

равняется![]() .

Чтобы создать все возможные слова длины

.

Чтобы создать все возможные слова длины![]() ,

достаточно к каждому слову длины

,

достаточно к каждому слову длины![]() добавить в его конце последовательно

каждую из

добавить в его конце последовательно

каждую из![]() букв алфавита. Таким образом, из каждого

слова длины

букв алфавита. Таким образом, из каждого

слова длины![]() образуется

образуется![]() разных слов длины

разных слов длины![]() .

Таким образом, получаем все возможные

слова длиною

.

Таким образом, получаем все возможные

слова длиною![]() .

Поскольку слов длиной

.

Поскольку слов длиной![]() является

является![]() ,

то общее количество слов длиной

,

то общее количество слов длиной![]() будет

будет![]() .

Таким образом, предположив истинность

утверждения для

.

Таким образом, предположив истинность

утверждения для![]() ,

доказано, что оно является правильным

для

,

доказано, что оно является правильным

для![]() .

Теорема доказана.

.

Теорема доказана.

Пример 1.

Какой является мощность алфавита, с помощью которого записано сообщение, которое содержит 5120 символов, если его информационный объем составляет 2,5Кб?

Переведем информационный объем сообщения в биты:

![]() .

.

Определим количество битов, которые приходятся на один символ:

![]() .

.

Определяем мощность алфавита по теореме 1:

![]()

Пример 2.

Компьютерный

алфавит состоит из 256 символов, которые

кодируются равномерным двоичным кодом

(каждое кодированное слово равномерного

кода имеет одну и ту же длину

![]() ).

Какая длина кодированного слова?

).

Какая длина кодированного слова?

Согласно

теореме 1

![]() .

Таким образом, один символ кодируется

в компьютерном алфавите одним байтом.

.

Таким образом, один символ кодируется

в компьютерном алфавите одним байтом.

Пример 3.

Сообщение «Розуменко является студентом ПГАСА» содержит, включая и пробелы, 34 символа. Следовательно, его информационный объем в компьютерном алфавите составляет 34 байта.

Пример 4.

Книга содержит 256 страниц. На каждой странице напечатано 64х48 символов. Можно ли записать эту книгу на гибкий магнитный диск объемом 1,44 Мб?

Книга содержит 256х64х48=786432 символа. Таким образом, ее информационный объем в компьютерном алфавите составляет 786432 байта.

786432 байта = 786432 : (1024)2 = 0,75Мб.

Следовательно, книгу на данный диск записать можно.

Следует отметить, что алфавитный способ измерения информации используется для оценивания информационного объема внутренней и внешней памяти компьютера.

В разных системах передачи информации используется более точный способ измерения информации, разработанный в теории информации английским математиком Робертом Хартли и американским ученым Клодом Шенноном.

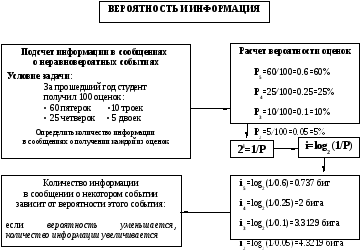

Вероятность и информация.

В практической жизни постоянно приходится иметь дело со случайными событиями, наступление которых предвидеть наперед трудно.

Вероятность– это числовая характеристика степени наступления случайного события при определенных условиях, отношение числа шансов, которые способствуют наступлению события, к общему числу шансов, которые способствуют или не способствуют наступлению события.

Если

число шансов, которые способствуют

наступлению события,

![]() ,

а число всех возможных шансов, которые

способствуют и не способствуют

наступлению события,

,

а число всех возможных шансов, которые

способствуют и не способствуют

наступлению события,![]() ,

то вероятность

,

то вероятность

![]() (1.2)

(1.2)

Например, если на

вечере присутствовали 37 студентов

строительного факультета, 43 механика

и 20 архитекторов, то вероятность

встретить первого студента строительного

факультета равняется

![]() ,

механика –

,

механика –![]() ,

архитектора –

,

архитектора –![]()

Имеет место теорема сложения вероятностей:

вероятность суммы

двух независимых событий равняется

сумме вероятностей этих событий, т.е.

![]() .

.

Теорема имеет два важных следствия.

Следствие 1.

Если

![]() рассматриваемых событий создают полную

группу несовместимых событий, то сумма

их вероятностей равняется 1, т.е.

рассматриваемых событий создают полную

группу несовместимых событий, то сумма

их вероятностей равняется 1, т.е.![]() .

.

Следствие 2. Если рассматривать два зависимых события, то вероятность их суммы равняется суме вероятностей этих событий без вероятности одновременного их наступления, т.е.

![]() .

.

Таким образом, в сумме

все вероятности дают 1. Значения

вероятности изменяется в пределах от

0 до 1:

![]() .

Вероятность достоверного события

(события, которое обязательно совершится)

равняется 1; соответственно, вероятность

события, которое никогда не наступит,

равняется 0. Например, вероятность того,

что зима наступит после осени, равняется

1, а вероятность события, что в феврале

30 дней, – 0.

.

Вероятность достоверного события

(события, которое обязательно совершится)

равняется 1; соответственно, вероятность

события, которое никогда не наступит,

равняется 0. Например, вероятность того,

что зима наступит после осени, равняется

1, а вероятность события, что в феврале

30 дней, – 0.

Какая

связь существует между вероятностью

и информацией? Информация и вероятность

соединены между собой обратной связью.

Чем меньше вероятность некоторого

события, тем больше информации содержится

в сообщении, что оно состоялось. Например,

сообщение, что после 23 августа наступит

24 августа (День независимости Украины),

не содержит никакой информации, поскольку

в этом сообщении вероятность равняется

1 (это достоверное событие); но если

сообщают, что этот день четверг, то

вероятность

![]() ,

поскольку неделя имеет 7 дней, и это

сообщение уже содержит определенное

количество информации. Реализация

менее вероятного события, т.е. большая

возможность выбора, дает больше

информации. Таким образом, чем больше

неопределенность до получения сообщения

о событии, меньше вероятность его

наступления, тем больше количество

информации при получении сообщения.

,

поскольку неделя имеет 7 дней, и это

сообщение уже содержит определенное

количество информации. Реализация

менее вероятного события, т.е. большая

возможность выбора, дает больше

информации. Таким образом, чем больше

неопределенность до получения сообщения

о событии, меньше вероятность его

наступления, тем больше количество

информации при получении сообщения.

Проблемы измерения информации изучаются специальным разделом информатики (теория информации) – информметрии. Есть много подходов для решения этой проблемы. Одним из наиболее распространенных и практично приспособленных является вероятностный подход, идеи которого заложил английский ученый Роберт Хартли (1927-1928 гг.), а обобщил и развил американский ученый Клод Шеннон (1948-1949 гг.).

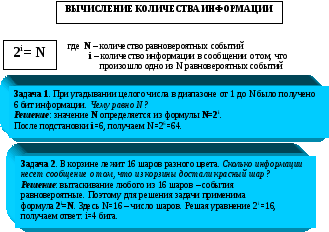

Измерение количества информации по Р.Хартли.

Меру количества информации установил в 1928 году Р.Хартли на основе предложенной им концепции выбора. Согласно этой концепции связь между отправителем и получателем информации осуществляется только при наличии определенного набора сообщений, из которых отправитель в каждый момент времени выбирает только одно. В результате последовательных выборов вниманию получателя предлагается последовательность сообщений (символов). Во время каждого выбора исключаются все другие сообщения (символы), которые могли бы быть выбраны.

Пусть

сообщение состоит из

![]() элементов, которые последовательно и

независимо выбирают из

элементов, которые последовательно и

независимо выбирают из![]() равновероятных элементов. Число

возможных сообщений в этом случае (по

теореме 1):

равновероятных элементов. Число

возможных сообщений в этом случае (по

теореме 1):

![]() (1.3)

(1.3)

Хартли установил, что

в роли меры количества информации,

которая имела бы практическую ценность,

лучше выбрать не число

![]() ,

а логарифм этого числа:

,

а логарифм этого числа:

![]() (1.4)

(1.4)

Мера количества информации, введенная Хартли, целиком согласуется с природными интуитивными требованиями к такой мере. Прежде всего, интуитивно ощущается, что количество информации в сообщении будет тем больше, чем длиннее сообщение: например, более длинная телеграмма содержит и больше сведений. Кроме этого, характеристика какого-нибудь явления будет тем лучше, чем большую разновидность сообщений о нем можно использовать. Например, оценка студента по 100-бальной системе лучше отражает его знания, чем пятибальная.

Формула

(1.3) отображает и зависимость количества

информации от длины сообщения

![]() и от разнообразия элементов в сообщении

и от разнообразия элементов в сообщении

![]() .

Следует отметить: для вывода формулы

(1.4) Хартли сделал предположение, что

элементы сообщения равновероятны и

выбор каждого элемента осуществляется

независимо от того, какие элементы были

раньше выбраны. В информметрии идеи

Хартли интерпретируются с более общей

позиции, которая вытекает из понятия

системы.

.

Следует отметить: для вывода формулы

(1.4) Хартли сделал предположение, что

элементы сообщения равновероятны и

выбор каждого элемента осуществляется

независимо от того, какие элементы были

раньше выбраны. В информметрии идеи

Хартли интерпретируются с более общей

позиции, которая вытекает из понятия

системы.

Пусть

есть система

![]() из

из![]() равновероятных (равновозможных)

состояний. Если каждое состояние системы

закодировать равномерным кодом

определенной длины

равновероятных (равновозможных)

состояний. Если каждое состояние системы

закодировать равномерным кодом

определенной длины![]() над алфавитом

над алфавитом![]() ,

то длину

,

то длину![]() нужно выбрать так, чтобы число всех

разных комбинаций было меньше чем

нужно выбрать так, чтобы число всех

разных комбинаций было меньше чем![]() .

Наибольшее число, при котором это

возможно, илимера разнообразия

множества состояний системызадается

формулой Р.Хартли:

.

Наибольшее число, при котором это

возможно, илимера разнообразия

множества состояний системызадается

формулой Р.Хартли:![]() (1.5)

(1.5)

где

![]() -

коэффициент пропорциональности

(масштабирования, зависимо от выбранной

длины измерения),

-

коэффициент пропорциональности

(масштабирования, зависимо от выбранной

длины измерения),![]() - основа системы меры,

- основа системы меры,![]() - количество информации, которую дает

появление одного из

- количество информации, которую дает

появление одного из![]() равновозможных состояний системы.

равновозможных состояний системы.

Поскольку

в информационных процессах наиболее

широко используется двоичная система

счисления, то из практических соображений

выбирают

![]() .

Формулу Хартли рассматривают в виде:

.

Формулу Хартли рассматривают в виде:

![]() (1.6)

(1.6)

где

![]() - количество равновозможных состояний

системы,

- количество равновозможных состояний

системы,![]() - количество информации в битах. Отметим,

что бит в данном случае имеет другое

толкование, чем при техническом

(алфавитном) подходе при оценивании

информации.Бит– это количество

информации, которая поступает от

системы, что имеет два разных, одинаково

возможных для реализации состояний.

- количество информации в битах. Отметим,

что бит в данном случае имеет другое

толкование, чем при техническом

(алфавитном) подходе при оценивании

информации.Бит– это количество

информации, которая поступает от

системы, что имеет два разных, одинаково

возможных для реализации состояний.

![]() .

.

Следовательно, тут бит не является наименьшей единицей измерения информации.

Пример 5.

Сколько

битов информации несет сообщение о

том, что студент

![]() живет в 90-квартирном доме?

живет в 90-квартирном доме?

![]() .

.

Поскольку

всех состояний системы -

![]() и все они равновероятны, то вероятность

случайного появления какого-нибудь из

них

и все они равновероятны, то вероятность

случайного появления какого-нибудь из

них![]() ,

отсюда

,

отсюда![]() .

Подставив это в формулу (1.6), получим:

.

Подставив это в формулу (1.6), получим:

![]() .

(1.7)

.

(1.7)

Пример 6.

Сколько

битов информации несет сообщение о

том, что вероятность появления любого

из ![]() состояний системы

состояний системы

![]() ?

?

![]()

Измерение количества информации по К.Шеннону.

Концепцию выбора Хартли развил и обобщил из вероятностных позиций американский ученый Клод Шеннон. Он создал в 1948-1949 гг. основы статистической теории информации, основным понятием которой являетсяэнтропия.Энтропияв теории информации – мера неопределенности, которая существует при принятии сообщений. Название свое мера неопределенности получила благодаря формальной схожести с термодинамической энтропией, но суть этих понятий совсем разная. Согласно с исходными «положениями» статистической теории информации, любое сообщение, которое необходимо передать, является результатом случайного выбора из совокупности возможных сообщений данного типа. Для получателя сообщения в связи со случайностью выбора существует неопределенность, которая снимается только после получения сообщения. Мера неопределенности для получателя сообщения зависит от того, насколько большим есть выбор из возможного набора сообщений.Информация по Шеннону – это сообщение, которое уменьшает неопределенность системы (явления), которая существовала до получения сообщения. Меру этой неопределенности Шеннон и назвал энтропией.

Содержание энтропиисостоит в том, что увеличение энтропии означает уменьшение упорядоченности системы. Беспорядочной система кажется тогда, когда про нее очень мало известно. Энтропия такой системы высока. С получением новых знаний о ней, с получением определенной информации, энтропия системы уменьшается. Таким образом, получение информации способствует уменьшению энтропии, причем это уменьшение пропорционально информации, которая поступает. Следовательно,за меру информации можно взять определенное количество энтропии, которая соответствует этой информации.

По Шеннону количество информации в сообщении равняется

![]() (1.8)

(1.8)

где Н0 – энтропия до получения сообщения, а Н1– энтропия после получения сообщения. Следует отметить, что Шеннон практически не делает разницы между энтропией и количеством информации. Основоположник кибернетики американский ученый Н.Винер писал, что количество информации, по сути, - некоторая неотъемлемая энтропия.

Пример 7.

Рассмотрим систему, которая содержит 128 клавиш – символов букв, цифр, математических и служебных знаков. Максимальное количество информации, которую создает эта система, во время нажатия одной клавиши, равняется максимальной энтропии при равномерной частоте нажатия любой клавиши.

![]() .

.

Допустим,

что поступило сообщение: «нажата клавиша

управления курсором». Таких клавиш

всего 4 и вероятность нажатия каждой

из этих клавиш одинакова. После сообщения

энтропия системы

![]() Тогда, согласно формулы Шеннона (1.8)

Тогда, согласно формулы Шеннона (1.8)![]()

Пример 8.

На факультете 875 студентов, среди них 247 студента-разрядника. Какое количество информации принесло сообщение «кубок по волейболу завоевала команда из 8-ми студентов-разрядников»?

Энтропия

системы до получения сообщения

![]() (по теореме 1 в алфавите мощностью 875

можно построить ровно 8758

слов длиною 8). Энтропия системы после

получения сообщения

(по теореме 1 в алфавите мощностью 875

можно построить ровно 8758

слов длиною 8). Энтропия системы после

получения сообщения

![]() .

Следовательно,

.

Следовательно,![]() .

Данное сообщение несет 14,6 бита информации.

.

Данное сообщение несет 14,6 бита информации.

Формула Шеннона (мера Шеннона).

Базируясь на вероятностном подходе к оцениванию информации, К.Шеннон в 1948 году вывел формулу, которая дает оценку информации, абстрагируясь от ее содержания:

![]() (1.9)

(1.9)

где

![]() - число состояний системы,

- число состояний системы,![]() - вероятность, или относительная частота

перехода системы в

- вероятность, или относительная частота

перехода системы в![]() -ое

состояние,

-ое

состояние,![]() - количество информации в битах, которую

дает, в среднем, появление одного из

- количество информации в битах, которую

дает, в среднем, появление одного из![]() разновероятных состояний системы.

Таким образом,

разновероятных состояний системы.

Таким образом,

![]() .

.

Формулу

Шеннона можно получить на основе

следующего мыслительного эксперимента.

Пусть есть программа-генератор, которая

на экране дисплея может демонстрировать

любую букву некоторого алфавита, который

состоит из

![]() букв.

букв.

|

ai |

a1 |

a2 |

a3 |

. . . |

an |

|

pi |

p1 |

p2 |

p3 |

. . . |

pn |

Генерирование

осуществляется соответственно заданным

законам распределения. Каждая из букв

появляется на экране согласно с

вероятностью ее появления pi.

За экраном дисплея ведется наблюдение:

пусть на экране появилосьmбукв (m– довольно

большое число, значительно больше чем![]() ).

Если интересует букваai,

то она на экране появится приблизительно

).

Если интересует букваai,

то она на экране появится приблизительно![]() раз. Каждое появление на экране буквыaiдает по формуле (1.7) количество информации,

которая равняется

раз. Каждое появление на экране буквыaiдает по формуле (1.7) количество информации,

которая равняется![]() ,

всего (за все ее появления) на экране

будет получено

,

всего (за все ее появления) на экране

будет получено![]() битов информации. Общее количество

информации, которое необходимо

просуммировать после демонстрации

всехmбукв, равняется

битов информации. Общее количество

информации, которое необходимо

просуммировать после демонстрации

всехmбукв, равняется

![]() .

.

На одну букву в среднем приходится:

![]() (1.10)

(1.10)

Из этой формулы, как

частный случай, получается формула

Хартли (1.6). Действительно, если каждое

состояние системы является равновероятным,

т.е.

![]() ,

то энтропия системы будет максимальной

и равняется:

,

то энтропия системы будет максимальной

и равняется:![]() .

.

Пример 9.

Система состоит из 40 красных, 25 зеленых, 20 желтых, 10 голубых и 5 фиолетовых лампочек. Какое количество информации дает визуальное сообщение о вспышке одной лампочки?

Определим вероятность вспышки лампочки каждого цвета:

Pк=40/100=0,40; Pз=25/100=0,25; Pж=20/100=0,20; Pг=10/100=0,10; Pф=5/100=0,05.

Вычислим количество информации по формуле Шеннона (1.8)

I=-(0.40log20.40+0.25log20.25+0.20log20.20+0.10log20.10+0.05log20.05)=

=-(0.40ln0.40+0.25ln0.25+0.20ln0.20+0.10ln0.10+0.05ln0.05)/ln2=

=2.0411.

Таким образом, данное визуальное сообщение несет 2,04 бита информации.

Измерение информации по Шеннону имеет широкое применение в технических проблемах передачи информации линиями связи, в задачах сохранения и обработки информации с помощью компьютеров.