- •Глава 5. Нейросетевые методы распознавания и аппроксимации

- •5.1 Принципы организации и классификация нейронных сетей

- •5.2 Формальный нейрон. Однослойный персептрон

- •5.3 Многослойный персептрон

- •5.3.1 Модель сети

- •5.3.2 Обучение многослойного персептрона

- •Да: перейти на шаг 11. Нет: Перейти на шаг 13.

- •Да: Окончание поиска: нет продвижения к решению. Перейти на шаг 13.

- •Алгоритмы сопряженных градиентов представляют собой подкласс квадратично сходящихся методов. Для алгоритмов сопряженных градиентов шаг 6 обобщенного градиентного алгоритма имеет вид:

- •5.3.3 Следящий алгоритм обучения мнс

- •5.4 Радиально-базисные нейронные сети

- •5.5 Нейронные сети Хопфилда

- •5.5.1 Модель сети Хопфилда

- •5.5.2 Обучение сети Хопфилда распознаванию образов

- •5.5.3 Эффект разнасыщения

- •5.6 Нейронная сеть Хэмминга

- •5.7 Машина Больцмана

- •5.8 Двунаправленная ассоциативная память

- •5.9 Нейросетевой селектор максимума

- •5.10 Карта признаков самоорганизации Кохонена

- •5.10.2 Интерпретация результатов классификации нс Кохонена

- •Блок кпск-азу может быть рекомендован для использования в системах классификации в случае, когда:

- •5.10.3 Выбор метрики и учет информативности признаков

- •Шаг 3. Произвести обучение блока кпск-азу на всей выборке X

- •5.11 Квантование обучающих векторов

- •5.11.1 Модель сети

- •5.11.2 Алгоритм обучения lvq1

- •5.11.3 Алгоритм обучения lvq2

- •5.11.4 Алгоритм обучения lvq3

- •5.11.5 Алгоритм обучения olvq1

- •5.12 Контрастирование нейронных сетей

- •Алгоритм построения и оптимизации модели объекта.

- •Алгоритм контрастирования многослойной нейронной сети.

Алгоритм построения и оптимизации модели объекта.

Шаг 0. Задать набор классификаторов: определить используемые модели, начальные параметры моделей и методы обучения.

Шаг 1. Обучить все классификаторы на основе обучающей выборки.

Шаг 2. Для всех экземпляров обучающей выборки последовательно подать на входы классификаторов значения признаков для текущего экземпляра xs, s=1,...,S, где S-количество экземпляров в обучающей выборке, и определить Kks - класс s-го экземпляра для k-го классификатора, k=1,..,G, где G – количество классификаторов.

Шаг 3. Набор результатов классификации Kвх={Kks} для всех экземпляров и классификаторов и набор фактических значений классов K={Ks} для всех экземпляров подать для обучения на входы и выход блока-интегратора, соответственно. Если в качестве блока-интегратора используется НС Кохонена, то подается только набор Kвх.

Шаг 4. Обучить интегратор моделированию зависимости между классами на выходах классификаторов и фактическим классом.

Шаг 5. Вычислить Ik - вклад k-го классификатора в формирование общего результата, k=1,2,...,G. Если в качестве блока-интегратора используется НС Кохонена, то Ik могут быть определены как информативности входов НС на основе алгоритма отбора информативных признаков.

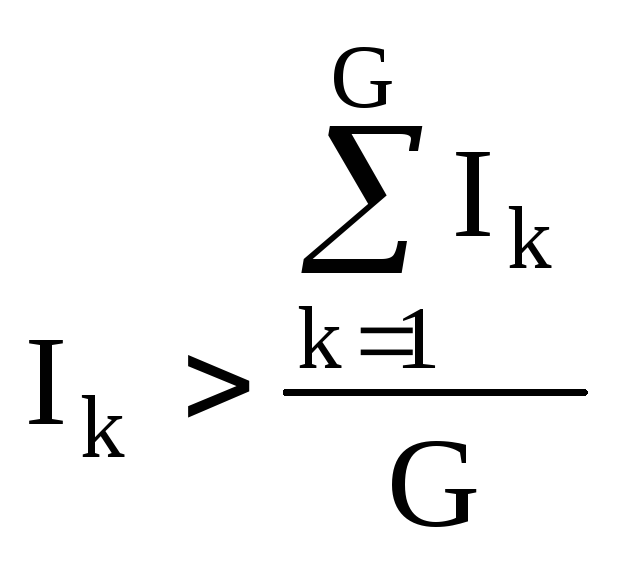

Шаг 6. Для классификаторов,

у которых

,

выполнить процедуру

оптимизации структуры (контрастировать

связи и / или оценить информативность

и осуществить отбор признаков).

,

выполнить процедуру

оптимизации структуры (контрастировать

связи и / или оценить информативность

и осуществить отбор признаков).

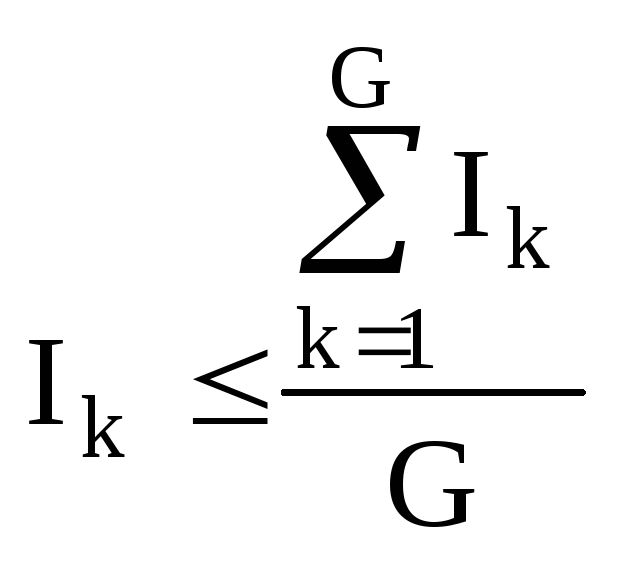

Для классификаторов,

у которых

,

если возможно,выполнить

процедуру выращивания, иначе исключить

классификатор из системы.

,

если возможно,выполнить

процедуру выращивания, иначе исключить

классификатор из системы.

Шаг 7. Если значимость классификатора в процессе P повторений шагов 1-6 меньше определенного заданного числа, то исключить классификатор из системы, иначе – перейти на шаг 1.

Выход из цикла, определяемого шагами 1-7, осуществляется, если будет выполняться хотя бы одно из условий:

1) количество

классификаторов G![]() 2;

2;

2) достигнуты пределы увеличения / сокращения структуры для всех классификаторов (дальнейшее применение алгоритмов контрастирования и выращивания нецелесообразно);

3) требуемая точность классификации достигнута;

требуемая точность классификации недостигнута в течение заданного времени.

Алгоритм контрастирования многослойной нейронной сети.

Шаг 0. Сохранить текущий набор значений весов и порогов сети.

Шаг 1. Задать или вычислить по определенному

правилу граничное значение

значимости весов![]() .

В качестве такого значения, например,

можно использовать среднее арифметическое

значение модулей весов и порогов сети.

.

В качестве такого значения, например,

можно использовать среднее арифметическое

значение модулей весов и порогов сети.

Шаг 2. Все веса |w

j (![]() ,i)|<

,i)|<

![]() , гдеw j

(

, гдеw j

(![]() ,i)– весj-го

входаi-го нейрона

,i)– весj-го

входаi-го нейрона

![]() -го

слоя НС, уменьшить на основе правилаw j

(

-го

слоя НС, уменьшить на основе правилаw j

(![]() ,i)= R-(

w j

(

,i)= R-(

w j

(![]() ,i)),

где

,i)),

где

![]() ,

i, j удовлетворяют заранее определенным

правилам и ограничениям.

,

i, j удовлетворяют заранее определенным

правилам и ограничениям.

Шаг 3. Все веса |w

j (![]() ,i)|

,i)|![]()

![]() увеличить на основе правилаw

j (

увеличить на основе правилаw

j (![]() ,i)= R+(

w j

(

,i)= R+(

w j

(![]() ,i)),

где

,i)),

где

![]() ,

i, j удовлетворяют заранее определенным

правилам и ограничениям.

,

i, j удовлетворяют заранее определенным

правилам и ограничениям.

Шаг 4. Для всех экземляров обучающей выборки xs, s=1,...,S вычислить значение суммарной ошибки сетиError.

Шаг 5. Если Error<MaxError, гдеMaxError – некоторое заданное максимальное граничное значение ошибки сети, то перейти на шаг 0, в противном случае – перейти на шаг 6.

Шаг 6. Восстановить предыдущие значения весов и порогов сети.

Шаг 7. Останов.

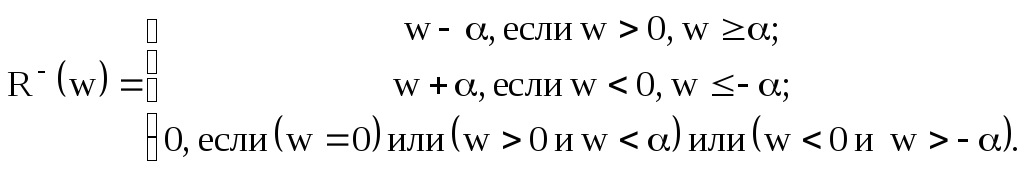

В качестве правил R(w) предлагается использовать:

или

![]()

![]()

или

![]() ,

,![]() ,

,

где

где

![]() - заранее заданные константы.

- заранее заданные константы.

При задании этих констант следует руководствоваться следующими соображениями:

слишком большие значения констант могут существенно ухудшить результат и затруднить процесс обучения;

слишком малые значения констант могут привести к существенному увеличению времени работы алгоритма контрастирования;

чем меньше значения констант, тем меньше будет дополнительная ошибка классификации, возникающая после выполнения алгоритма контрастирования.

В отличие от большинства других алгоритмов контрастирования, предполагающих удаление малоинформативных связей, данный алгоритм осуществляет последовательное увеличение больших весов и уменьшение малых, что позволяет более гибко осуществлять процесс контрастирования.

Алгоритм выращивания сети.

Шаг 0. Инициализация:

![]() =1.

=1.

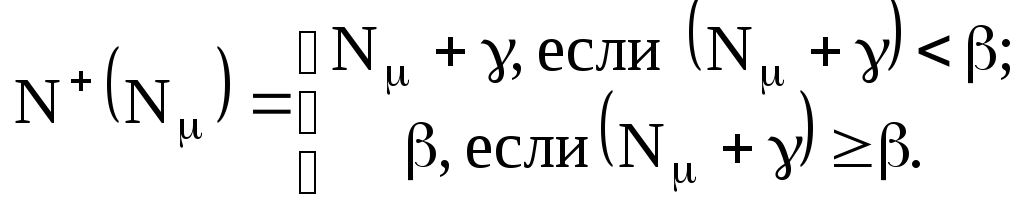

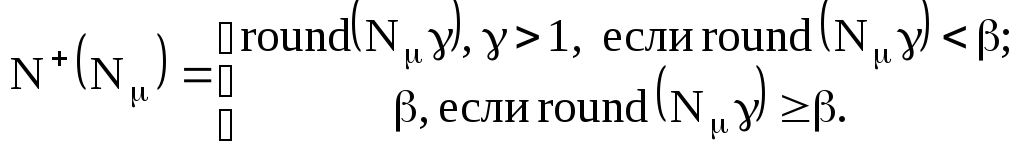

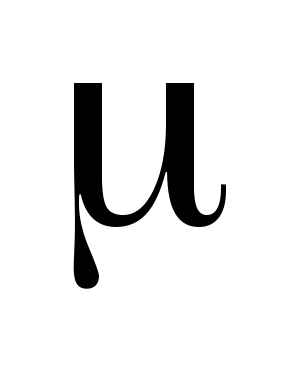

Шаг 1. Если

количество нейронов в

![]() -ом

слое сетиN

-ом

слое сетиN![]() меньше

определенной величины

меньше

определенной величины

![]() ,

то увеличить

количество нейронов в

,

то увеличить

количество нейронов в

![]() -ом

слое в соответствии с правиломN

-ом

слое в соответствии с правиломN![]() =

N+(N

=

N+(N![]() ),

где N+(N

),

где N+(N![]() )

может определяться

одним из выражений:

)

может определяться

одним из выражений:

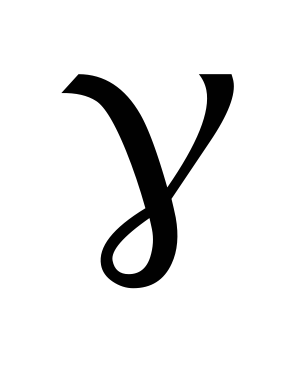

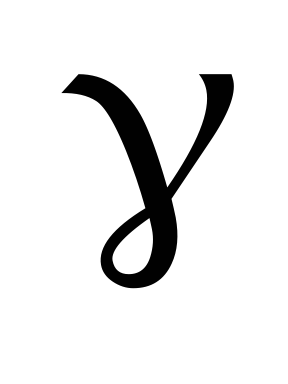

где

![]() - заранее заданные константы,и

перейти на шаг 4, в противном случае –

перейти на шаг 2.

- заранее заданные константы,и

перейти на шаг 4, в противном случае –

перейти на шаг 2.

Шаг 2. Если

![]() <M,

то положить:

<M,

то положить:

![]() =

=![]() +1и перейти на шаг 4,

в противном случае – на шаг 3.

+1и перейти на шаг 4,

в противном случае – на шаг 3.

Шаг 3. Если

![]() =M

и M<Mmax,

где Mmax

– максимально

допустимое

количество слоев НС, то

положить: M=M+1,

NM=1

и перейти на шаг 2,

в противном случае – на шаг 4.

=M

и M<Mmax,

где Mmax

– максимально

допустимое

количество слоев НС, то

положить: M=M+1,

NM=1

и перейти на шаг 2,

в противном случае – на шаг 4.

Шаг 4. Останов.

При задании констант

![]() следует

учитывать следующие соображения:

следует

учитывать следующие соображения:

при увеличении значения

сеть будет расти быстрее;

сеть будет расти быстрее;значения

должны

быть больше нуля;

должны

быть больше нуля;константа

должна быть целым числом;

должна быть целым числом;если константа

-

не является целым числом, то значениеN+(N

-

не является целым числом, то значениеN+(N )

должно округляться.

)

должно округляться.с увеличением значения

снижаются возможности роста сети.

снижаются возможности роста сети.

Построение блока принятия решений.

Основная задача блока принятия решений – обработка результата классификации для данного экземпляра и выдача соответствующих управляющих сигналов, определенных для данной ситуации.

Блок принятия решений можно строить различными способами:

1) на основе жестко заданных правил «Если (условие), то (действие)».

2) на основе нечеткой логики.

3) на основе нейросетевых моделей.

Последний вариант является более предпочтительным в тех случаях, когда нет заранее формализованных правил принятия решений, а есть только некоторое множество кортежей (пар данных), состоящих из описания ситуации и решения, которое целесообразно принять в такой ситуации.

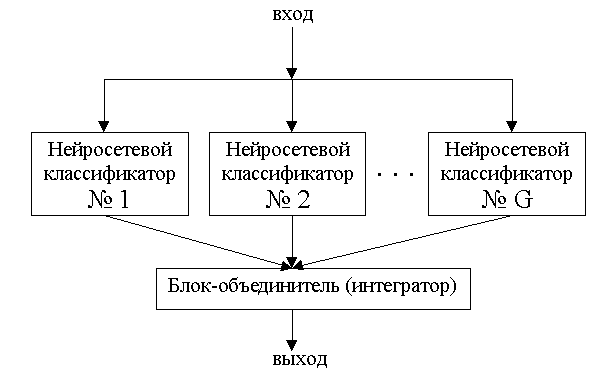

Схема интегрированной системы нейросетевой классификации показана на рис. 5.9 Она состоит из подсистемы классификации и блока интеграции.

Рис. 5.9 - Интегрированная система классификации.

На входы классификаторов подаются входные наборы данных, на выходы классификаторов – выходные наборы данных. Для каждого классификатора производится обучение, после которого по данным на входе он должен на выходе выдавать значения незначительно отличающиеся от желаемых. Выходы отдельных обученных классификаторов подаются на входы блока-объединителя. Количество возможных классификаторов определяется входной размерностью блока-объединителя.

В качестве блока-интегратора можно использовать нейросетевые, статистические, эвристические и другие модели. Рассмотрим наиболее просто реализуемые и, в тоже время, наиболее обоснованные модели.

Карта признаков самоорганизации Кохонена имеет ряд свойств, которые позволяют использовать ее как блок интеграции в методе интегрированной классификации. Использование самоорганизующейся карты Кохонена обусловлено подобием ее работы некоторым механизмам функционирования человеческого мозга. Мозг организован так, что различные сенсорные входы представляются топологически упорядоченными вычислительными картами. В частности, сенсорные входы осязательного, визуального и акустического типа отображаются на различные области коры головного мозга топологически упорядоченным способом. Таким образом, карта Кохонена представляет собой базовый конструктивный блок в инфраструктуре обработки данных возбужденной системы.

Как известно, обработка информации в человеческом мозге связана с извлечением значений из данных внешнего мира и последующим их объединением. Например, распознавание объекта часто определяется интеграцией систем зрения, осязания, слуха и обоняния. Карта Кохонена подобна биохимической отображающей модели мозга. Доказано, что объединение с использованием НС Кохонена соответствует человеческому способу распознавания. Следовательно, карты Кохонена целесообразно использовать в качестве блока-интегратора.

Карты Кохонена обладают рядом свойств, желательных для блока-интегратора:

- они способны аппроксимировать входное пространство;

- карты Кохонена осуществляют топологическое упорядочение данных;

- НС Кохонена учитывает статистические характеристики, присущие данным.

Последнее свойство особено важно для решения задачи интеграции классификаторов. НС Кохонена объединяет выходы отдельных классификаторов согласно распределениям их вероятностей.

Использование НС Кохонена в качестве блока-интегратора делает метод интегрированной классификации нечувствительным к корреляции отдельных классификаторов, что объясняется конкурирующим принципом работы НС.

Другой моделью для блока-интегратора может служить усредненная взвешенная сумма выходов классификаторов, учитывающая некоторым образом их значимость (чем выше безошибочность работы соответствующего классификатора, тем выше его значимость). Если на выходах классификаторы будут выдавать значения 0 или 1, то класс на выходе блока-интегратора K можно будет определить по формуле:

,

,

где G

- количество

классификаторов,

![]() -

значимость выходаi-го

классификатора, Ki

-

значение на выходе

i-го

классификатора,

-

значимость выходаi-го

классификатора, Ki

-

значение на выходе

i-го

классификатора,

![]() - некоторый коэффициент, позволяющий

регулировать влияние малозначимых

классификаторов на общий результат,round

– функция округления.

- некоторый коэффициент, позволяющий

регулировать влияние малозначимых

классификаторов на общий результат,round

– функция округления.

Значения

![]() могут быть найдены разными способами.

Например, в качестве

могут быть найдены разными способами.

Например, в качестве![]() можно использовать вероятности правильной

классификации:

можно использовать вероятности правильной

классификации:

![]() ,

,

где s-количество экземпляров обучающей выборки; Nправ. – количество экземпляров обучающей выборки, для которых произведена правильная классификация.

При выборе значения

коэффицента

![]() следует учитывать следующие соображения:

следует учитывать следующие соображения:

1) значения коэффициента

![]() должны быть больше нуля;

должны быть больше нуля;

2) в простейшем случае, когда

нет необходимости регулировать влияние

малозначимых классификаторов, коэффициент

![]() можно принять равным единице;

можно принять равным единице;

3) с увеличением коэффициента

![]() вклад малозначимых классификаторов

будет существенно снижаться.

вклад малозначимых классификаторов

будет существенно снижаться.