- •Глава 5. Нейросетевые методы распознавания и аппроксимации

- •5.1 Принципы организации и классификация нейронных сетей

- •5.2 Формальный нейрон. Однослойный персептрон

- •5.3 Многослойный персептрон

- •5.3.1 Модель сети

- •5.3.2 Обучение многослойного персептрона

- •Да: перейти на шаг 11. Нет: Перейти на шаг 13.

- •Да: Окончание поиска: нет продвижения к решению. Перейти на шаг 13.

- •Алгоритмы сопряженных градиентов представляют собой подкласс квадратично сходящихся методов. Для алгоритмов сопряженных градиентов шаг 6 обобщенного градиентного алгоритма имеет вид:

- •5.3.3 Следящий алгоритм обучения мнс

- •5.4 Радиально-базисные нейронные сети

- •5.5 Нейронные сети Хопфилда

- •5.5.1 Модель сети Хопфилда

- •5.5.2 Обучение сети Хопфилда распознаванию образов

- •5.5.3 Эффект разнасыщения

- •5.6 Нейронная сеть Хэмминга

- •5.7 Машина Больцмана

- •5.8 Двунаправленная ассоциативная память

- •5.9 Нейросетевой селектор максимума

- •5.10 Карта признаков самоорганизации Кохонена

- •5.10.2 Интерпретация результатов классификации нс Кохонена

- •Блок кпск-азу может быть рекомендован для использования в системах классификации в случае, когда:

- •5.10.3 Выбор метрики и учет информативности признаков

- •Шаг 3. Произвести обучение блока кпск-азу на всей выборке X

- •5.11 Квантование обучающих векторов

- •5.11.1 Модель сети

- •5.11.2 Алгоритм обучения lvq1

- •5.11.3 Алгоритм обучения lvq2

- •5.11.4 Алгоритм обучения lvq3

- •5.11.5 Алгоритм обучения olvq1

- •5.12 Контрастирование нейронных сетей

- •Алгоритм построения и оптимизации модели объекта.

- •Алгоритм контрастирования многослойной нейронной сети.

Глава 5. Нейросетевые методы распознавания и аппроксимации

5.1 Принципы организации и классификация нейронных сетей

При построениии адаптивных систем диагностики перспективным является использование искусственных нейронных сетей (НС), которые обладают такими свойствами, как обучаемость, универсальность и способность аппроксимировать любые вычислимые функции. Это позволяет использовать их для классификации, оценки значений параметров и построения математических моделей сложных процессов и объектов даже в тех случаях, когда другими способами это сделать затруднительно.

Кроме вышеперечисленных достоинств НС характеризуются высокой надежностью и устойчивостью к негативным внешним воздействиям (высокими робастными свойствами), обладают способностями самостоятельно извлекать знания из данных в процессе обучения, а также способны самостоятельно решать некоторые оптимизационные задачи.

Все модели искусственных НС представляют собой множество нейронов (или нейроподобных элементов), связанных определенным способом между собой. Основными отличиями моделей НС являются способы связи нейронов между собой, механизмы и направления распространения сигналов по сети, а также ограничения на используемые функции активации.

Одно из важнейших свойств НС - способность к самоорганизации и самоадаптации с целью улучшения качества функционирования. Это достигается обучением НС, алгоритм которого задается набором обучающих правил. Обучающие правила определяют, каким образом изменяются связи в ответ на входное воздействие. Обучение основано на увеличении силы связи (веса синапса) между одновременно активными нейронами. Таким образом, часто используемые связи усиливаются, что объясняет феномен обучения путем повторения и привыкания.

В настоящее время не существует единой стандартной классификации НС, поскольку нейроинформатика является относительно новой областью науки и терминология здесь еще не устоялась. Поэтому рассмотрим классификацию НС только по некоторым базовым характеристикам.

В зависимости от типа функции активации НС подразделяют на дискретные, вещественные (непрерывные) и дискретно-непрерывные.

В зависимости от направления распространения сигналов НС подразделяют на сети прямого распространения, сети обратного распространения и двунаправленные НС.

В зависимости от количества и структуры связей НС подразделяют на полносвязные (все нейроны связаны со всеми) и неполносвязные.

В зависимости от количества слоев нейронов НС подразделяют на однослойные и многослойные. Иногда особо выделяют двуслойные и трехслойные НС.

5.2 Формальный нейрон. Однослойный персептрон

Нервная система человека состоит из клеток, называемых нейронами, и имеет ошеломляющую сложность: около 1011нейронов участвуют в порядка 1015передающих связях, имеющих длину метр и более. Каждый нейрон обладает многими качествами, общими с другими клетками, но его уникальной способностью является прием, обработка и передача электрохимических сигналов по нервным путям, которые образуют коммуникационную систему мозга.

На рис. 5.1 показана структура биологического нейрона. Дендриты идут от тела нервной клетки к другим нейронам, где они принимают сигналы в точках соединения, называемых синапсами.

Рис. 5.1 - Структура биологического нейрона

Принятые синапсом входные сигналы подводятся к телу нейрона. Здесь они суммируются, причем одни входы стремятся возбудить нейрон, другие – воспрепятствовать его возбуждению. Когда суммарное возбуждение в теле нейрона превышает некоторый порог, нейрон возбуждается, посылая по аксону сигнал другим нейронам. У этой основной функциональной схемы много усложнений и исключений, тем не менее большинство искусственных нейронных сетей моделируют лишь эти простые свойства.

Итак, нейрон (формальный нейрон, нейроподобный элемент), представляющий собой примитивное вычислительное устройство, имеющее несколько входов и один выход является основным вычислительным элементом НС.

Однослойный персептрон является одним из самых простых вариантов НС (рис. 5.2) и содержит вего один нейрон. Являясь самостоятельной моделью НС с одной стороны, формальный нейрон (однослойный персептрон) является основным конструкционным элементов для большинства моделей НС, с другой стороны.

Рис. 5.2 - Однослойный персептрон (формальный нейрон)

На вход нейроподобного элемента (формального нейрона) поступает набор входных сигналовx1, x2, ..., xN или входной векторx. Каждый входной сигнал умножается на соответствующий вес связиw1, w2, ..., wN - аналог эффективности синапса (межнейронного контакта).

Вес связи является скалярной величиной, положительной для возбуждающих и отрицательной для тормозящих связей. Взвешенные весами связей входные сигналы поступают на блок суммации, соответствующий телу клетки, где осуществляется их алгебраическая суммация и определяется уровень возбуждения нейроподобного элемента net:

.

.

Выходной сигнал нейрона yопределяется путем пропускания уровня возбужденияnetчерез нелинейную функцию активации ψ:

y =ψ(net-θ), где- некоторое постоянное смещение (аналог порога нейрона). Обычно используются простейшие нелинейные функции: бинарная (пороговая):

![]()

или сигмоидная: ψ(x) = 1/(1+e-x).

В зависимости от типа функции активации различают дискретные персептроны, использующие пороговую функцию активации, и вещественные – использующие вещественные функции активации, например сигмоидную функцию.

Каждый нейрон обладает небольшой памятью, реализуемой весовыми коэффициентами входных синапсов (межнейронных контактов) и порогом нейрона. Поэтому нейроны можно рассматривать как запоминающие устройства. В то же время нейроны могут рассматриваться как примитивные процессоры, осуществляющие вычисление значения функции актиивации на основе разности взвешенной суммы входных сигналов и порога.

Алгоритм обучения однослойного дискретного персептронаимеет вид.

Шаг 1.Весам wi(0) (i=1, ... ,N)и порогу θ(0) присваиваются случайные значения (через wi(t) обозначен весовой коэффициентi-го входа персептрона в момент времени t, черезθ(t) обозначена величина смещения (порога) нейрона в момент времениt).

Шаг 2.Предъявляются очередной входной вектор х={х1,...,хN}тиз обучающего множества и желаемый выход y*(t)(y*(t) = 1,если х(t)относится к классу A, y*(t) = 0,если х(t) относится к классу В).

Шаг 3.Вычисляется реальное значение на выходе персептрона по формулам:

![]() ,

,

![]() .

.

Шаг 4.Корректируются веса согласно равенствам:

wi(t+1) = wi(t) + η(y*(t) - y(t))xi(t), i = 1,2,...,N,

θ(t+1) = θ(t) + η(y*(t) - y(t)),

где η- положительное корректирующее приращение.

Шаг 5.Если достигнута сходимость, то процедура обучения заканчивается; в противном случае - переход к шагу 2.

Согласно данному алгоритму сначала производится инициализация параметров персептрона случайными значениями. Затем поочередно предъявляются образы с известной классификацией, выбранные из обучающего множества, и корректируются веса в соответствии с формулами шагов 3и 4.Величина коррекции определяется положительным корректирующим приращениемηконкретное значение которого выбирается достаточно большим, чтобы быстрее производилась коррекция весов, и в то же время достаточно малым, чтобы не допустить чрезмерного возрастания значений весов.

Процедура обучения продолжается до тех пор, пока не будет достигнута сходимость, то есть пока не будут получены веса, обеспечивающие правильную классификацию для всех образов из обучающего множества.

В том случае, когда обучающие выборки разделить гиперплоскостью невозможно для обучения персептрона можно использовать алгоритмУидроу-Хоффа,минимизирущий среднеквадратическую ошибку между желаемыми и реальными выходами сети для обучающих данных. Этот алгоритм также можно применять для обучения однослойного вещественного персептрона. Алгоритм Уидроу-Хоффа можно записать в том же виде, что и вышеописанный алгоритм,предполагая что в узлах персептрона нелинейные элементы отсутствуют, а корректирующее приращение η в процессе итераций постепенно уменьшается до нуля.

Если для решения задачи распознавания образов используется дискретный персептрон, решающее правило относит входной образ к классу A, если на выход персептрона равен 1, и к классу В – в противном случае.

В случае, если для решения задач распознавания образов используется вещественный персептрон, решающее правило относит входной образ к классу А, если выход сети больше 0.5,и к классу В в противном случае.

Однослойный персептрон может использоваться какгауссовский классификатор максимального правдоподобия. В этом случае предполагается, что функции правдоподобия входных векторов имеют гауссовскую форму и каждый класс задается своей ковариационной матрицей и вектором средних. Входной вектор в этом случае причисляется к тому классу, для которго его функция правдоподобия максимальна.

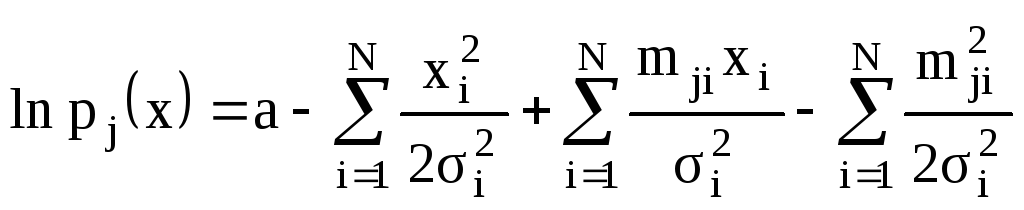

Для упрощения вычислений вместо самой функции правдоподобия используют ее логарифм (делать это позволяет тот факт, что логарифмическая функция является возрастающей). Если составляющие входного вектора не коррелируют, то эти логарифмы могут быть вычислены узлами однослойного персептрона, у которых отсутствуют нелинейные элементы. Действительно, предположив, что функции распределения входных векторов для различных классов различаются лишь средними, для логарифмов функций правдоподобия можно записать:

,

j=1,...,M,

,

j=1,...,M,

где рj(х)

—функция правдоподобия входного

вектора х={x1,х2,....,xN}тдля j-го класса (то есть плотность

вероятности вектора х при условии, что

он относится к j-му классу); М

–количествоклассов;mji -

математическое ожидание составляющей

xiдля j-го класса;

![]() -дисперсия величины xi(в нашем случае одинаковая для каждого

класса); a -некоторая постоянная.

-дисперсия величины xi(в нашем случае одинаковая для каждого

класса); a -некоторая постоянная.

Так как первые два слагаемых в данном выражении являются постоянными для всех классов, то при классификации они могут быть отброшены, а оставшиеся два слагаемых могут быть вычислены линейными узлами персептрона, если принять веса и пороги равными

и

и ,i=1,2,...,N, j=1,2,....,M,

,i=1,2,...,N, j=1,2,....,M,

где wji

-весовой коэффициент

i-говхода j-го узла;![]() -порог j-го узла.

-порог j-го узла.