- •Оглавление

- •Глава вторая структура социологического знания

- •1. Общая социологическая теория. Уровни социологического познания.

- •Общая социологическая теория и материалистическое понимание истории.

- •Исторический материализм и теория научного коммунизма.

- •Основные структурные элементы общества и их взаимодействие.

- •Общественные отношения и социальная деятельность людей.

- •2. Теоретический и эмпирический уровни социологического познания. Теоретическая и прикладная социология Эмпирические социологические исследования

- •Теоретические социологические исследования.

- •Теоретическая и прикладная социология.

- •3. Специальные социологические теории и эмпирические исследования Понятие конкретной социальной, ситуации.

- •Основные функции специальных социологических теорий.

- •Компоненты специальных социологических теорий.

- •Литература для дополнительного чтения

- •Глава третья

- •Социалистический образ жизни как объект социологического анализа.

- •Социальное значение научно-технической революции

- •Социология труда

- •Социологические исследования трудовых коллективов.

- •Функции трудового коллектива.

- •Структура трудового коллектива.

- •Виды трудовых коллективов.

- •Социология быта Понятие внепроизводственной деятельности.

- •Классификация занятий.

- •Показатели условий жизненной обстановки.

- •Методические схемы изучения быта.

- •Социологическое исследование бюджетов времени

- •2. Социальная структура и социальные отношения Понятие социальной структуры

- •Социально-классовая структура. Социальные группы и социальные слои

- •Общественное разделение труда и социально-профессиональная структура общества

- •Социально-этническая структура общества. Этносоциология

- •Социально-демографическая структура общества

- •Возрастная структура общества Социальные проблемы молодежи

- •Геронтосоциология.

- •3. Социально-территориальные, общности Понятие территориальных общностей

- •Расселение людей. Социология города и деревни

- •Социальные проблемы миграции населения

- •4. Социально-политическая организация общества и социальные институты Социально-политическая организация

- •Понятие социального института.

- •Социология права.

- •Социология политики.

- •Социология образования

- •Социология науки

- •Социология брака и семьи

- •5. Духовная жизнь общества. Средства массовой информации и пропаганды Социальные проблемы идеологической деятельности

- •Социология средств массовой информации Социальная роль средств массовой информации.

- •Эффективность средств массовой информации

- •Общественное мнение

- •Структура и функции общественного мнения.

- •Характеристики общественного мнения.

- •6. Социальное планирование. Социальные показатели Экономическое и социальное планирование

- •Показатели социального планирования

- •Социальная деятельность и социальные показатели

- •Литература для дополнительного чтения

- •Глава четвертая Организация и проведение эмпирического социологического исследования

- •1. Постановка проблемы. Цели и задачи Место и роль программы в социологическом исследовании

- •Проблемная социальная ситуация и научная проблема.

- •Научная и практическая проблемы.

- •Цели и задачи социологического исследования.

- •2. Определение объекта и предмета исследования Объект исследования и единица наблюдения.

- •Системный анализ объекта социологического исследования.

- •Метод восхождения от абстрактного к конкретному.

- •3. Интерпретация и операционализация понятий Теоретическая и эмпирическая, интерпретация понятий.

- •Граница операциональных определений.

- •I. Управление развитием общества.

- •IV. Уровень поселений и трудовых коллективов.

- •V. Уровень первичной социальной группы.

- •VI. Уровень личности.

- •VII. Уровень развития социальной группы.

- •5. Организационно-методический план исследования Стратегический план исследования.

- •6. Рабочий план исследования и подготовка исполнителей

- •Литература для дополнительного чтения

- •Статистические методы в социологическом исследовании. Измерение социальных характеристик.

- •Глава пятая Методы статистики в социологическом исследовании.

- •1. Понятие измерения в социологии. Уровни измерения Определение измерения.

- •Неоднозначность шкальных значений. Допустимые преобразования и типы шкал.

- •Адекватность математических методов.

- •2. Группировка материала статистических наблюдений

- •Ряды распределения.

- •Статистические таблицы.

- •3. Графическая интерпретация эмпирических зависимостей

- •Гистограмма.

- •Полигон распределения.

- •Кумулята.

- •Вид (форма) кривых распределений.

- •Теоретическое распределение.

- •4. Средние величины и характеристики рассеяния значений признака

- •Среднее значение признака.

- •Показатели колеблемости (вариации) значений признаков.

- •5. Нормальное распределение. Статистические гипотезы

- •Статистические гипотезы.

- •6. Статистические взаимосвязи и их анализ

- •Коэффициенты взаимозависимости для порядкового уровня измерения.

- •Коэффициенты взаимозависимости для номинального уровня измерения.

- •7. Новые подходы к анализу данных, измеренных по порядковым и номинальным шкалам

- •Литература для дополнительного чтения

- •Глава шестая Выборочный метод в социологическом исследовании

- •1. Основные понятия выборочного метода

- •Единица отбора и единица наблюдения.

- •2. Простой случайный отбор

- •Процедура простого случайного отбора.

- •Расчет характеристик простой случайной выборки.

- •3. Систематическая и серийная выборки. Систематический отбор.

- •Серийная (гнездовая) выборка.

- •4. Стратифицированный отбор Понятие стратифицированной выборки.

- •Организация стратифицированной выборки.

- •Расчет характеристик стратифицированной выборки.

- •5. Многоступенчатые и комбинированные способы, формирования выборочной совокупности

- •Многофазовый отбор.

- •Комбинированные выборки.

- •6. Неслучайные методы отбора и другие подходы к построению выборки

- •Другие сложности и, проблемы построения выборки.

- •Литература для дополнительного чтения

- •Глава седьмая Измерение в социологическом исследовании.

- •1. Виды шкал

- •2. Некоторые методы измерения

- •Построение шкал методом экспертных оценок.

- •Метод суммарных оценок.

- •Шкалограммный анализ.

- •Семантический дифференциал.

- •3. Надежность измерения социальных характеристик

- •Устойчивость измерения.

- •Обоснованность измерения.

- •Литература для дополнительного чтения

- •Раздел третий

- •Методы сбора данных в социологическом исследовании.

- •Глава восьмая

- •Анализ документов и существующих данных

- •1. Понятие документа. Классификация документов. Понятие документа.

- •Архивы эмпирических данных в машиночитаемой форме.

- •Иконографические документы.

- •Фонетические документы.

- •Другие способы классификации документов.

- •2. Методы анализа документов

- •Традиционный анализ.

- •Формализованный анализ.

- •3. Выборка документов и проблемы качества документальной информации

- •Необходимость критического отношения к документам.

- •Литература для дополнительного чтения

- •Глава девятая Наблюдение

- •1. Понятие наблюдения

- •Особенности наблюдения в социологии.

- •Планирование наблюдения.

- •2. Программа наблюдения

- •Рамки соотнесения.

- •Определение ситуации и условий деятельности наблюдаемого объекта.

- •Цели, задачи я структура деятельности изучаемой группы.

- •Определение предмета наблюдения.

- •Выбор признаков и единиц наблюдения.

- •Определение понятий и разработка категорий.

- •3. Виды наблюдения

- •Определение вида наблюдения.

- •4. Фиксация результатов. Подготовка наблюдателя Фиксация результатов.

- •Требования к наблюдателю.

- •Подготовка наблюдателей. Разработка инструкции.

- •Преимущества и недостатки метода наблюдения.

- •Литература для дополнительного чтения

- •Глава десятая Опрос как метод сбора социологических данных

- •1. Понятие опроса

- •Понятие опроса.

- •2. Критерий качества данных опроса.

- •3. Основные фазы опроса

- •4. Типы и виды вопросов

- •Содержание вопросов.

- •Формулировка вопросов.

- •Последовательность вопросов.

- •Расслоение совокупности опрашиваемых.

- •5. Разновидности опроса

- •6. Эмпирическое обоснование методики опроса

- •Эмпирическая проверка вопросника.

- •Литература для дополнительного чтения

- •Глава одиннадцатая Социометрические методы изучения структуры межличностных отношений.

- •1. Социометрический опрос

- •Процедура социометрического опроса.

- •Социометрическая карточка.

- •2. Обработка и анализ результатов социометрического опроса.

- •Виды социограмм.

- •2. Социометрические индексы

- •Литература для дополнительного чтения

- •Глава двенадцатая Эксперимент в социологическом исследовании.

- •1. Понятие, эксперимента

- •2. Экспериментальные переменные

- •Выбор зависимых и независимых переменных.

- •Условия проведения эксперимента.

- •Измерение переменных.

- •Контроль переменных.

- •Воспроизводимость эксперимента.

- •Основные требования к проведению эксперимента.

- •3. Виды экспериментов

- •Параллельный и последовательный эксперименты.

- •4. Обработка экспериментального материала

- •Репрезентативность экспериментальных данных.

- •Ошибки эксперимента.

- •Литература для дополнительного чтения

- •Обобщение результатов исследования Глава тринадцатая Анализ данных и обобщение результатов социологического исследования.

- •1. Подготовка данных к анализу на эвм

- •Редактирование.

- •Кодирование.

- •Контроль данных и исправление ошибок.

- •Построение новых переменных.

- •2. Описание и объяснение в социологическом исследовании

- •Понятие описания.

- •Группировка.

- •Понятие объяснения, в социологии.

- •3. Способы проверки гипотез

- •Глава четырнадцатая Отчет о результатах исследования. Отчет и пояснительная записка.

- •Разделы отчета.

- •Рекомендации.

- •1616 Труды по социологии, с. 32—34. О технике телефонного интервью см.: Методические проблемы сравнительного анализа социологических данных. М. 1982.

6. Статистические взаимосвязи и их анализ

Понятие о статистической зависимости. Исходя из известного положения исторического материализма о всеобщей взаимозависимости и взаимообусловленности явлений общественной жизни, социолог-марксист не может ограничиться изучением отдельно взятого явления изолированно от других процессов и событий, а должен стремиться по возможности охватить весь комплекс явлений, относящихся к тому или иному социальному процессу и изучить существующие между ними зависимости.

Различают два вида зависимостей: функциональные (примером которых могут служить законы Ньютона в классической физике) и статистические.

Закономерности массовых общественных явлений складываются под влиянием Множества причин, которые действуют одновременно и взаимосвязанно. Изучение такого рода закономерностей в статистике и называется задачей о статистической зависимости. В этой задаче полезно различать два аспекта: изучение взаимозависимости между несколькими величинами и изучение зависимости одной или большего числа величин от остальных. В основном первый аспект связан с теорией корреляции (корреляционный анализ), второй — с теорией регрессии (регрессионный анализ). Основное внимание в этом параграфе уделено изучению взаимозависимостей нескольких признаков, а основные принципы регрессионного анализа рассмотрены очень кратко.

В основе регрессионного анализа статистической зависимости ряда признаков лежит представление о форме, направлении и тесноте (плотности) взаимосвязи.

В

табл. 7 приведено эмпирическое распределение

заработной платы рабочих в зависимости

от общего стажа работы (условные

данные) для выборки в 25 человек, а на рис. 9 эти численные данные представлены в виде так называемой диаграммы рассеяния, или разброса. Вообще говоря, визуально не всегда можно определить, существует или нет значимая взаимосвязь между рассматриваемыми признаками и насколько она значима, хотя очень часто уже на диаграмме просматривается общая тенденция в изменении значений признаков и направление связи между изучаемыми признаками. Уравнение регрессии. Статистическая зависимость одного или большего числа признаков от остальных выражается с помощью уравнений регрессии. Рассмотрим две величиных иу, такие, например, как на рис. 9. Зафиксируем какое-либо значение переменнойх, тогдау принимает целый ряд значений. Обозначиму среднюю величину этих значенийу при данном фиксированномх. Уравнение, описывающее зависимость средней величиныух отx называется уравнением регрессииу пох:

![]()

Аналогичным образом можно дать геометрическую интерпретацию регрессионному уравнению22

![]()

Уравнение регрессии описывает числовое соотношение между величинами, выраженное в виде тенденции к возрастанию (или убыванию) одной переменной величины при возрастании (убывании) другой. Эта тенденция проявляется на основе некоторого числа наблюдений, когда из общей, массы выделяются, контролируются, измеряются главные, решающие факторы.

Характер связи взаимодействующих признаков отражается в ее форме. В этом отношении полезно различать линейную и нелинейную регрессии. На рис. 10, 11 приведены графики линейной и криволинейной форм линий регрессии и их диаграммы разброса для случая двух переменных величин.

Направление и плотность (теснота) линейной связи между двумя переменными измеряются с помощью коэффициента корреляции.

Меры взаимозависимости для интервального уровня измерения. Наиболее широко известной мерой связи служит коэффициент корреляций Пирсона (или, как его иногда называют, коэффициент корреляции, равный произведению моментов). Одно из важнейших предположений, на котором покоится использование коэффициента г, состоит в том, что регрессионные уравнения для изучаемых переменных имеют линейную форму23, т. е.

где у — среднее арифметическое для переменнойу; х — среднее арифметическое для переменнойх; b1 иb2 - некоторые коэффициенты.

Поскольку вычисление коэффициента корреляции и коэффициентов регрессии b1и b2проводится по схожим формулам, то, вычисляя r, получаем сразу же и приближенные регрессионные модели24.

Выборочные коэффициенты регрессии и корреляции вычисляются по формулам

Здесь s2x—дисперсия признаках; s2x— дисперсия признака у. Величина sxy, называется ковариациейх иу.

Расчет r для не с группированных данных. Для вычислительных целей эти выражения в случае не сгруппированных данных можно переписать в следующем виде:

Рассчитаем коэффициент корреляции и коэффициенты регрессии для данных табл. 7:

Тогда уравнение регрессии имеет вид

![]()

Линии регрессии y = F(x) изображены на рис. 10-. Отсюда видно, что между заработной платой и общим стажем работы существует прямая зависимость: по мере увеличения общего стажа работы на предприятии растет и заработная плата. Величина коэффициента корреляции довольно большая и свидетельствует о положительной связи между переменными величинами. Следует отметить, что вопрос о том, какую переменную в данном случае принимать в качестве зависимой величины, а какую — в качестве независимой, исследователь решает на основе качественного анализа и профессионального опыта. Коэффициент корреляции по определению является симметричным показателем связи: rxy= ryx. Область возможного изменения коэффициента корреляцииг лежит в пределах от +1 до —1.

Вычисление r для сгруппированных данных. Для сгруппированных данных примем ширину интервала по каждой переменной за единицу (если по какой-либо переменной имеются неодинаковые размеры интервала, то возьмем из них наименьший). Выберем также начало координат для каждой переменной где-нибудь возле среднего значения, оцененного на глаз.

Для условных данных, помещенных в табл. 8, за нулевую точку отсчета выберем значение у, равное 64, а поx — значение 134,5.

Тогда коэффициент корреляции определяется по следующей формуле:

![]()

Для вышеприведенного примера порядок вычислений представлен в табл. 9. Для определения Snijaxby вычислим последовательно все произведения частоты в каждой клетке таблицы на ее координаты. Так

В соответствии с формулой вычисляем

![]()

Таким образом, величина связи достаточно велика, как, впрочем, и следовало ожидать на основе визуального анализа таблицы.

Статистическая значимость r. После вычисления коэффициента корреляции возникает вопрос, насколько показателен этот коэффициент и не обусловлена ли зависимость, которую он фиксирует, случайными отклонениями. Иначе говоря, необходимо проверить гипотезу о том, что полученное значение r значимо отличается от 0.

Если гипотеза H0 (r = 0) будет отвергнута, говорят, что величина коэффициента корреляции статистически значима (т. е. эта величина не обусловлена случайностью) при уровне значимостиa.

Для случая, когда п < 50, применяется критерийt, вычисляемый по формуле

![]()

Распределение t дано в табл. В приложения.

Если п > 50, то необходимо использовать Z-критерий

![]()

В табл. А приложения приведены значения величины ZKp для соответствующихa.

Вычислим величину Z для коэффициента корреляции по табл. 7 (вычисление проделаем лишь для иллюстрации, так как число наблюденийп — 25 и нужно применять критерийt). Величинаr (см. табл. 7) равна 0,86. Тогда

![]()

Для уровня значимости a= 0,01 ZKp= 2,33 (см. табл. А приложения).

Поскольку Z > ZKp, мы должны констатировать, что коэффициент корреляции г = 0,86 значим и лишь в 1 % случаев может оказаться равным нулю. Аналогичный результат дает и проверка по критериюt для а = 0,01 (односторонняя область); tкр— 2,509, t выборочное равно 8,08.

Другой часто встречающейся задачей, является проверка равенства на значимом уровне двух коэффициентов корреляции. i = г2при заданном уровне а, т. е. различия между r1и r2обусловлены лишь колебаниями выборочной совокупности.

Критерий для проверки значимости следующий:

где значения zrjиzr находят по табл. Д приложения для r1и r2.

Значения ZКpопределяют по табл. А. приложения аналогично вышеприведенному примеру.

Частная и множественная регрессия и корреляция. Ранее нами было показано, как можно по опытным данным найти зависимость одной переменной от другой, а именно как построить уравнение регрессии видау = а +bх. Если исследователь изучает влияние нескольких переменныхх1, х2, ..., хk результатирующий признак y, то возникает необходимость в умении строить регрессионное уравнение более общего вида, т. е.

![]()

где a, b1,. b2, ..., bk — постоянные коэффициенты, коэффициенты регрессии.

В связи с уравнением (26) необходимо рассмотреть следующие вопросы: а) как по эмпирическим данным вычислить коэффициенту регрессии а, b1, b2…bк; б) какую интерпретацию можно приписать этим коэффициентам; в) оценить тесноту связи междуу и каждым изXi в отдельности (при элиминировании действия остальных); г) оценить тесноту связи междуу и всеми переменнымих1, ...,xк в совокупности.

Рассмотрим этот вопрос на примере построения двухфакторного регрессионного уравнения. Предположим, что изучается зависимость недельного бюджета свободного времени (у) от уровня образования(хi) и возраста(х2) определенной группы трудящихся по данным выборочного обследования. Будем искать эту зависимость в виде линейного уравнения следующего вида:

![]()

При расчете коэффициентов уравнения множественной регрессии полезно преобразовать исходные эмпирические данные следующим образом. Пусть в результате обследования п человек получены эмпирические значения, сведенные в следующую таблицу (в каждом столбце представлены не сгруппированные данные):

Каждое значение переменной в таблице преобразуем по формулам

![]()

![]()

![]()

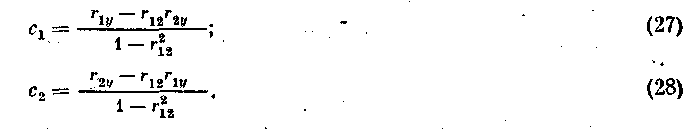

Коэффициенты с1исг находятся по следующим формулам

с1 и с2называютсястандартизированными коэффициентами регрессии. Следовательно, зная коэффициенты корреляции между изучаемыми признаками, можно подсчитать коэффициенты регрессии. Подставим конкретные значения rijиз следующей таблицы25;

Коэффициенты исходного регрессионного уравнения b0, b1и b2находятся по формулам

Подставляя сюда данные из вышеприведенной таблицы, получим b1= 3,13; b2= -0,17; b0= - 8,56.

Как же следует интерпретировать это уравнение? Например, значение b2 показывает, что в среднем недельный бюджет свободного времени при увеличении возраста на один год и при фиксированном признакеXi уменьшается на 0,17 час. Аналогично интерпретируется b1. (Исходные эмпирические данные можно изобразить на диаграмме рассеяния аналогично тому, как это сделано на рис. 10, но уже в трехмерном пространстве(у, xt, х2).

Коэффициенты х1и х2можно в то же время рассматривать и как показатели тесноты связи между переменнымиу и, например,Xi при постоянствехг.

Аналогичную интерпретацию можно применять и к стандартизированным коэффициентам регрессии сi. Однако посколькуci вычисляются исходя из нормированных переменных, они являются безразмерными и позволяют сравнивать тесноту связи между переменными, измеряемыми в различных единицах. Например, в вышеприведенном примереXi измеряется в классах, a x2 — в годах. C1 и с2позволяют сравнить, насколько z1теснее связан су, чемхг26.

Поскольку коэффициенты bi и сiизмеряют частную одностороннюю связь, возникает необходимость иметь показатель, характеризующий связь в обоих направлениях. Таким показателем являетсячастный коэффициент корреляции

![]()

Для рассматриваемого примера ry1.2= 0,558, rу2.1i = —0,140.

Для любых трех переменных x1, х2, х3 частный коэффициент корреляции между двумя из них при элиминировании третьей строится следующим образом:

![]()

Аналогично можно определить и частные коэффициенты корреляции для большего числа переменных (r12,34...). Однако ввиду громоздкости вычисления они применяются достаточно редко.

Для характеристики степени связи результатирующего признака ус совокупностью независимых переменных служитмножественный коэффициент корреляции R2y , который вычисляется по формуле (иногда он выражается в процентах)

![]()

Так, для вышеприведенного примера он равен

![]()

Множественный коэффициент корреляции показывает, что включение признаков х1 их2 в уравнение

![]()

на 32% объясняет изменчивость результатирующего фактора. Чем больше Rt, тем полнее независимые переменныех2 ...,xk описывают признаку. Обычно служит критерием включения или исключения новой переменпой в регрессионное уравнение. Если Л мало изменяется при включении новой переменной в уравнение, то такая переменная отбрасывается.

Корреляционное отношение. Наиболее общим показателем связи при любой форме зависимости между переменными является корреляционное отношениеh2. Корреляционное отношениеh2у/х определяется через отношение межгрупповой дисперсии к общей дисперсии по признакуу:

где уi — среднее значение i-roy-сечения (среднее признакау для объектов, у которыхx=xi, т. е. столбец «г»);xi—среднее значение i-го x-сечения т. е. строка «i» nyi—число наблюдений вyсечении;nXi — число наблюдений вx-сечении;у — среднее значениеу.

Величина h2у/х показывает, какая доля изменчивости значенийу обусловлена изменением значениях. В отличие от коэффициента корреляцииh2у/хне является симметричным показателем связи, т. е,h2у/х не равно h2х/y. Аналогично определяется корреляционное отношениех поу27.

Пример. По данным таблицы сопряженности (табл. 9) найдемh2у/х. Вычислим общую среднюю

Сравнение статистических показателей r и h2у/х. Приведем сравнительную характеристику коэффициента корреляции (будем сравнивать r2) и корреляционного отношенияh2у/х.

а) r2= 0, если x и у независимы (обратное утверждение неверно);

б) r2=h2у/х=1 тогда и только тогда, когда имеется строгая линейная функциональная зависимостьу отх.

в) r2=r\y/x<i тогда и только тогда, когда регрессиях и у строго линейна, но нет функциональной зависимости;

г) r2<h2у/х < 1 указывает на то, что нет функциональной зависимости и существует нелинейная кривая регрессии.