- •Оглавление

- •Аналитические технологии

- •Формализация нейронных сетей

- •Принцип обучения искусственных нейронных сетей

- •Концепция обучения нейронной сети, предложенная Хэбом

- •Сбор данных для нейронной сети

- •Прикладные возможности нейронных сетей

- •Переобучение и обобщение

- •Персептрон

- •Алгоритм обратного распространения ошибки

- •Сигмоидальный нейрон

- •Нейрон типа «адалайн»

- •Инстар и оутстар Гроссберга

- •Нейрон типа wta (Winner Takes All)

- •08.10.2011 Модель нейрона Хэбба

- •Стохастическая модель нейрона

- •Стохастические алгоритмы обучения

- •Настройка числа нейронов в скрытых слоях многослойных сетей в процессе обучения

- •Алгоритмы сокращения

- •Конструктивные алгоритмы

- •Упрощенные алгоритмы расщепления

- •Радиальная базисная сеть

- •Вероятностные нейронные сети

- •Линейные нейронные сети

- •Обучение

- •Сети с самоорганизацией на основе конкуренции

- •12.11.2011 Модели ассоциативной памяти. Сети Хопфилда

- •Когнитивные карты

- •19.11.2011 Генетические алгоритмы Естественный отбор и генетическое наследование

- •Модель эволюции в природе, реализованная программно

- •Символьная модель простого генетического алгоритма

- •Работа простого генетического алгоритма

- •26.11.2011 Шима (Schema)

- •Применение аналитических технологий

- •03.12.2011

- •Бизнес-приложения

- •Программные реализации аналитических технологий

- •Список литературы

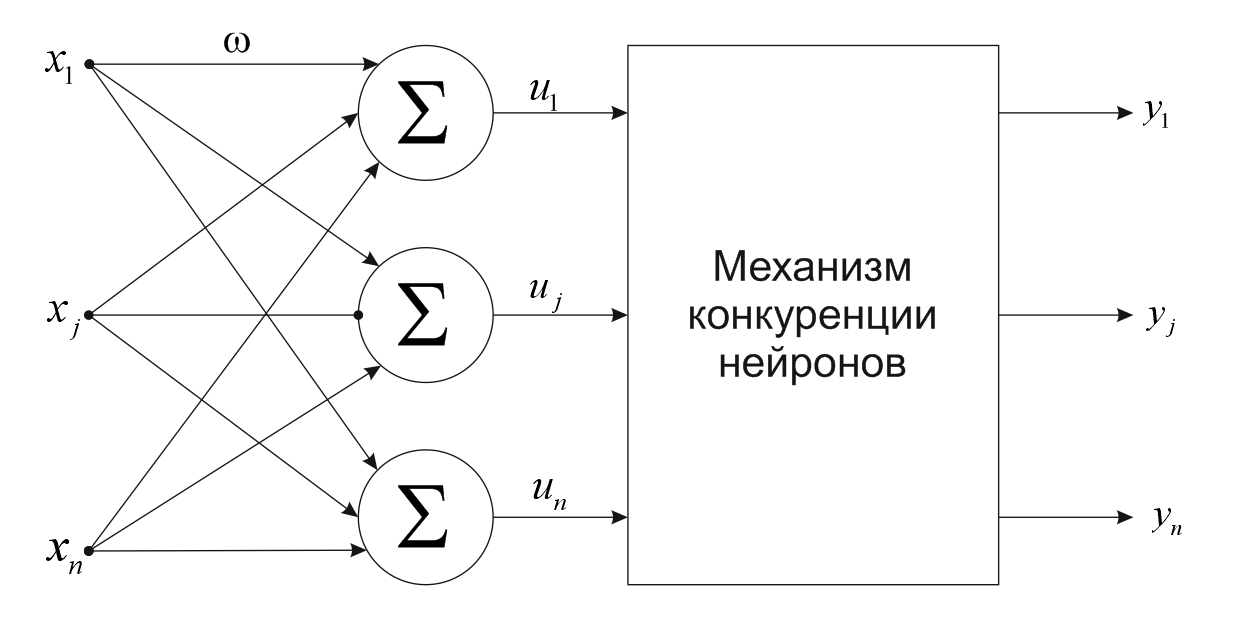

Нейрон типа wta (Winner Takes All)

Нейроны

типа WTA

имеют входной модуль в виде стандартного

сумматора, рассчитывающего сумму

входящих сигналовс соответствующими

весами

.

Выходной сигнал рассчитывается по

формуле:

.

Выходной сигнал рассчитывается по

формуле:

Группа

конкурирующих между собой нейронов

получает одни и те же входящие сигналы

.

В зависимости от фактических значения

весовых коэффициентов суммарные сигналы

.

В зависимости от фактических значения

весовых коэффициентов суммарные сигналы отдельных нейронов могут отличаться.

По результатам сравнения этих значений

победителем признается нейрон, значение

отдельных нейронов могут отличаться.

По результатам сравнения этих значений

победителем признается нейрон, значение которого оказалось наибольшим.

Нейрон-победитель вырабатывает на

выходном значении 1, остальные 0.

которого оказалось наибольшим.

Нейрон-победитель вырабатывает на

выходном значении 1, остальные 0.

Для обучения нейрона типа WTA не требуется учитель. Оно протекает аналогично обучению инстара с использованием нормализованных входящих вектором. На начальном этапа случайным образов выбираются весовые коэффициенты. После подачи первого входного вектора x определяется победитель этапа. Победивший в этом соревновании нейрон переходит в состояние 1, что позволяет ему произвести уточнение весов его входных линий по правилу Гроссберга. Проигравние нейроны формируют на своих выходах состояние 0, что блокирует процесс уточнения весовых коэффициентов.

Схема

соединения нейронов типа WTA:

Рисунок 22Схема соединения нейронов WTA

Проблемы, возникающие при обучении:

Победителем этапа оказывается нейрон, вектор весов которого оказывается наиболее близким к текущему обучающему вектору x. В результате победы нейрона уточняются его весовые коэффициенты, значения которых приближаются к значениям текущего обучающего вектора x. Если на вход будет подаваться множество близких по значению векторов, побеждать будет один и тот же нейрон, поэтому его веса стану равными усредненному значениям тех векторов, благодаря которым нейрон стал победителем. Проигравшие нейроны не изменяют свои веса. Следствием такой конкуренции становится самоорганизация процесса обучения.

Проблемой при обучении нейронов типаWTA является проблема «мёртвых» нейронов, которые после инициализации ни одного раза не победили в конкурентной борьбе и остались в состоянии сформированном в начальный момент времени. Каждый мертвый нейрон уменьшает эффективное количество элементов, проходящих обучение, и увеличивает общую погрешность распознавания данных.

Для

решения этой проблемы предлагается

модифицированное обучение, основанное

на учете побед каждого нейрона и временной

дисквалификации тех, которые побеждали

чаще всего. Она может осуществляться

либо по достижении предельного числа

побед, либо уменьшением фактического

значения числа

при нарастании числа побед нейрона.

при нарастании числа побед нейрона.

08.10.2011 Модель нейрона Хэбба

Связь

между двумя клетками усиливается, если

обе клетки становятся активны в одни и

тот же момент времени. Если j-ая

клетка с выходным сигналом

связана

сi-ой

клеткой, имеющей выходной сигнал

связана

сi-ой

клеткой, имеющей выходной сигнал

,

связью

,

связью ,

то на силу связи влияют значения выходных

сигналов

,

то на силу связи влияют значения выходных

сигналов ,

, .

В соответствии с правилом Хэбба, вес

.

В соответствии с правилом Хэбба, вес нейронов изменяется пропорционально

произведению входного и выходного

сигналов.

нейронов изменяется пропорционально

произведению входного и выходного

сигналов.

Рисунок 23 Модель нейрона Хэбба

Нейрон

Хэбба может обучаться как с учителем,

так и без него. При обучении без учителя

в правиле Хэбба подставляется фактическое

значение

.

При обучении с учителем вместо

.

При обучении с учителем вместо подставляется

подставляется .

.

Проблема Хэбба характеризуется те, что в результате его применения веса могут принимать произвольно большие значения, поскольку в каждом цикле обучения происходит суммирование текущего значения и некоторого приращения.

Один

из способов стабилизации обучения

состоит в учете последнего значения

уменьшенного

на коэффициент забывания

уменьшенного

на коэффициент забывания .

При этом проблема Хэбба представляется

в виде

.

При этом проблема Хэбба представляется

в виде .

Значение

.

Значение выбирается из интервала [0,1] и чаще всего

составляет некий процент отn.

Применение больших значений

выбирается из интервала [0,1] и чаще всего

составляет некий процент отn.

Применение больших значений

приводит к тому, что нейрон забывает

значительную часть того, чему он научился

в прошлом.

приводит к тому, что нейрон забывает

значительную часть того, чему он научился

в прошлом.