- •Методы построения ЭС и классификация ЭС по методам построения

- •Оценка погрешности для полинома Лагранжа

- •Разделенные разности

- •Численное интегрирование

- •В задаче линейного программирования (ЛП) целевая функция может быть представлена как сумма произведений переменных на некие константы:

- •Требования к стандартному виду задачи ЛП:

- •Разбиения

- •Классификация языков

31. Биологический подход к решению задач искусственного интеллекта. Генетические алгоритмы и их использование. Нейронные сети и их использование.

Биологический подход:

Развитие системы искуственного интеллекта (ИИ) сразу разделилось на 2 направления: биологическое и информационное.

Биологич-ое: Так как мы моделируем биологич-е системы, то необх-мо иммитировать или копировать построение реальных биологич-х систем. В данном направлении развиты:

1) бионика (разработка роботов по аналогии с биологичми существами);

2)генетич-е алгоритмы (основаны на системах естесственного отбора, системах адаптации в биологии);

3)нейронные сети (моделируются нейроны); 4)моделир-ние конкуренции, мотивации; агентные

системы (моделир-е жизни, развития, адаптации); 5)нейрокибернетика (теория управления, основанная на

нейронных сетях). Генетические алгоритмы (ГА):

В природе мощный механизм естественного отбора, который в рамках 1 популяции проходит следующие этапы:

1)начальная популяция – набор исходных биолог-х существ;

2)искусственный отбор – в результате воздействия окруж-й среды и конкуренции из популяции отбир-ся лучшие эл-ты;

3)появл-е (рожд-е) нового поколения с использ-ем 2-х мехмов – мутации в генах и скрещивания между генами родителей.

Мутация – это случ-ое изменение генов под действием

радиации, химии и т.д.

1

Скрещивание (кроссовер)– это процесс образования ДНК потомка на основе частей ДНК родителей.

В рез-те последоват-го возд-я зтих 3-х процессов в природе осущ-ся адаптация, приспособленность видов, генетич-й отбор и т.д., которые позволяют живым существам достигать оптимальности за сравнительно небольшое число популяций. Поэтому основной сферой применения ГА явл-ся решение задач оптимизации, в которых ГА показаликачества не хуже самых оптимальных численных алгоритмов.

Структура ГА:

Построение ГА состоит в конструировании общей схемы, включающей набор перечисленных этапов, расположенных в определенном порядке.

Рассмотрим примерный вариант ГА.

∙Начальная популяция

∙Вычисление Fполез.

∙Отбор

∙Скрещивание

∙Мутация

∙Вычисление Fполез.

∙Отбор

∙Условие остановки

1 этап. Нужно сформировать начальную популяцию. С точки зрения предыдущей аналогии с ДНК каждый элемент популяции – это вектор, который содержит запись, причем длины всех записей одинаковы. На этом этапе можно выбрать 2 параметра модели: длина записи (сколько букв или цифр) d, кол-во элементов популяции N.

Выбор начальной популяции может быть случайным, в центре искомой области или аналитическим (по какому-то закону).

2 этап. На втором этапе мы считаем, что одни вектора лучше других. Чтобы это определить, вводится специальная

2

функция полезности (индекс сверху–номер вектора, индекс снизу–номер буквы вектора); результат вычисления

F (X k ) – положительное или равное нулю число. Можно

сравнить F(X k ) и F(X m ), т.е. ответить на вопрос: какая из

популяций полезнее. Функция полезности должна быть вычислена на втором этапе для всех элементов.

3 этап. Нужно отобрать N’ элементов, лучших среди всей совокупности N, т.е. N’<N. Мы должны выбрать максимальные или минимальные элементы популяции по значениям функции полезности. Выбор максимальных или минимальных определяется по соотношению N’ и N. Если N’ < N/2, то выгоднее выбирать максимальные, в противном случае - минимальные. Если больше худших, то выбираются лучшие; если больше лучших, то – худшие.

4 этап. Нужно определить число составляемых пар для скрещивания.

5 этап. Необходимо провести процедуру мутации, имеющую как минимум 2 параметра P и N’’’. После проведения мутации вновь проводят вычисление функции полезности и отбор лучших элементов.

После этого одна итерация алгоритма выполнена, теперь нужно проверить условие выхода-остановки. Это условие должно определять: достаточно ли этих итераций или необходимо выполнить ещё одну.

Возможны следующие варианты условия выхода:

1)Задается фиксированное количество итераций. Поскольку одна итерация – одно поколение, то задаём количество поколений (параметр KP), достигнув последнего поколения, завершаем процесс алгоритма.

2)Задаётся изменчивость поколений (Gизм).Это функция, которая определяется как разность лучшей функции полезности в N и N-1 поколениях:

Gизм=Fлуч(N)-Fлуч(N-1)

3

Таким образом. если мы видим, что от поколения к поколения полезность сильно не увеличивается и изменчивость мала, то можно прекратить этот алгоритм.

3) Задаётся необходимое условие для максимальной функции полезности (Fmax). Если в каком-то поколении Fmax будет превышено, то мы прекращаем вычисления. Иногда можно рассматривать условие для максимальной функции полезности для одного элемента (чемпиона) или для набора элементов (получено заданное количество качественных элементов).

Начальная популяция → Вычисление Fполез. → Отбор → Скрещивание → Мутация → Вычисление Fполез → Отбор → Условие остановки (например, достижение предельной популяции, когда наступает насыщение, т.е. популяция не изменяется).

Внутри j-того объекта популяции можно задать коэф-т мутации Смут, который будет измерять, много или нет эл-тов меняется.

Отбор:

Отбор можно добавить на каждом этапе ГА.

Отбор |

заключает |

в себе функцию эффективности ( |

|

γ = |

N0 |

N |

). Отбор эл-тов в поколении выполняется |

|

|

|

|

с пом-ю спец. функции, которая наз-ся функцией полезности. Чем > значение этой функции, тем лучше считается элемент.

Кроссовер:

Объекты популяции состоят из сложных эл-тов – аналогов генов (молекул нуклеотидов 4-х видов: А, Т, С, G). Это своего рода алфавит, на котором записывается текст сообщения ДНК. Как и в любом тексте важно, какие буквы и в какой послед-ти они следуют. Если поменять местами 2 нуклеотида, то это будет совсем другая особь.

4

Как известно, ДНК потомка образуетс из генов 2-х родителей – это парный кроссовер. (В теории тройной кроссовер). В природе только парный кроссовер:

Ax |

Ay |

|||

A |

|

|

|

|

|

|

|

|

|

B |

|

|

|

|

|

|

|

|

|

Bx |

By |

|||

Вначале ученые моделировали кроссовер просто: брали ½ от объекта А и ½ от объекта В и соединяли в единого потомка. Получали как мин-м 4-е вар-та соед-я: AxBx, AxBy, AyBx, AyBy. Потом биологи док-ли, что гены передаются не поровну, тогда возникла идея модификации ГА, выбирая неравные части эл-тов. Модуляция кроссовера свелась к моделир-ю шим.

Теория шим:

Шимаангл. «маска». Идея: по 2-м родительским группам вычисляют потомка. Суть метода: если прорезать в некот-х клетках отверстия, то часть букв будет видна. Одни буквы берем у 1-го, другие - у 2-го родителя. Шиму можно промоделировать двоичным числом (1-открытая буква, 0- закрытая). Тогда маскаэто двоичное число (или 4-х битное число).

Наложение шимы

0 |

1 |

0 |

1 |

1 |

1 |

1 |

1 |

0 |

0 |

1 |

1 |

С |

помощью |

шимы мы уходим от вероятности. При |

|||

моделир-и шим только 2 пар-ра: k- выбор шимы и p- число прорезей в шиме.

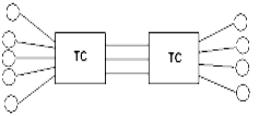

Нейронные сети:

В настоящее время особое место в искусственном интеллекте занимает имитационное моделирование биологии человеческого мозга с помощью специальных моделей нейронов и нейронных сетей. Нейроны головного

5

мозга образуют систему, которая обрабатывает поступающую от органов чувств информацию. У нейронов есть аксон (отросток), с другой стороны к нему подходят дендриты. Окончание на аксоне – синапс, который необходим для передачи инф-ции от 1-ой клетки к дендритам другой.

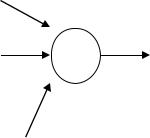

Нейрон–система, у которой есть несколько входов и один выход. Через дендриты информация проникает в нейрон:

дендриты

аксон

Усложнение системы состоит в том, что нейроны объединяются в виде пленки – сеть. Они обладают достаточной сложностью, чтобы производить прием сигнала. Был обнаружен пороговый характер нейрона (пока сигнал не дойдет до опред-й величины, нейрон его не передает). Так как входов у нейрона неск-ко и они поразному ослабляют сигнал, то j-тому входу можно

поставить соотв-щий вес. Тогда сигнал ослабления [0,1] .

Сигнал в большинстве случаев можно считать битом (0 – нет, 1 -есть), все входы можно считать большим двоичным числом, выходы - другим двоичным числом. действие сети

– преобразование больших двоичных чисел.

Эффекты: 1) нейрон способен уставать (есть фазы активности и пассивности); 2) между нейронами конкуренция, неработающие отмирают; 3) сигналы от разных дендритов могут мешать и помогать друг другу; 4) появл-ся эффет самосогласования.

Модели нейронов:

Свойства сетей зависит от каких нейронов она состоит. Т.к. можно придумать разные модели нейронов, то эти модели

6

стараются приблизить к биологии человеческого нейрона, здесь возникает сложность, т.к. эти объекты до конца не изучены.

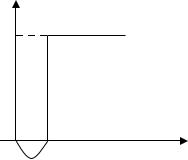

1. Модель Персептрона.

Исторически первой моделью нейрона была модель Мак-

Uвых

1

Uвх

Каллока и Питтса. Это была самая простая модель. Они назвали свою модель Персептроном. Как у нейрона у него несколько входов и один выход (входы синапсы, а выход – аксон).

Синапсы получают сигналы от аксонов других нейронов, а аксоны соединяются с синапсами других нейронов, и образуется многослойная сеть.

Так же как в природе у каждого синапса есть весовой коэф- т wi и сигнал xi , то сумма сигналов с разным весом

образует 1 сигнал – вх-й: |

Bx = |

å wi xi |

|

|

|

Wi |

|

|

xi |

|

|

Т.о. в персептроне входной сигнал – это сумма сигналов разного веса.

Персептрон может генерировать выходной сигнал, если

7

wi xi ³ U0 |

Þ |

Uвых |

= |

|||

å = í |

|

|

|

å |

|

|

ì |

1,U0 |

£ |

wi xi |

. Т.о. персептрон обладает |

||

ï |

||||||

ï |

0,U |

|

> |

å |

w x |

|

|

0 |

|

i i |

|

||

î |

|

|

|

|||

пороговым эффектом, т.е. сигнал на выходе получается только при достижении порога U 0 . Поэтому персептрон называют пороговым нейроном.

Uвых

1

0

Uвх

U0

Т. к. вход связан с другим нейроном j , то w зав-т от 2-х

величин: i – номер входа данного нейрона и j – др нейрон, с которым связан данный, тогда оценивая влияние на j-й

вход др нейрона, вводят yi: å wij xi yj .

Как правило, в моделях рассматривается вес 0 ≤ wij ≤ 1, i -

номер входа у данного нейрона, j - номер входа другого нейрона, x и y – значения только 0 или 1.

Если рассмотреть сеть из персептронов, то она похожа на двоичный автомат. Существуют методы анализа такого автомата с пом булевых ф-ций. Поэтому модель Мак- Каллока-Питтса стала самой распространенной.

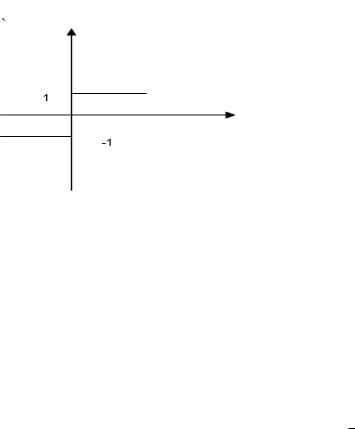

2. Сигмоидальный нейрон.

В этом нейроне перешли от дискретной модели к непрерывной, где порог непрерывный( т.е. не только 0 и 1),

8

сигнал непрерывный. Нужно |

|

было подобрать ф-цию. |

||||||

Нашли такую: |

f (Uвх ) = |

|

|

|

|

1 |

|

|

1 |

+ |

e |

− β (Uвх − U0 ) |

|||||

|

||||||||

|

|

|

|

|||||

Чем больше β , тем быстрее дойдем до единицы. Т. е. при

β |

→ |

∞ |

мы стремимся к персептрону. Когда β =10; |

12 |

рез-ты |

ничем не огтличаются от персептрона. |

|

U вх |

≈ 0 . В персептроне параметры : веса и U0, здесь |

||

еще Uвх. сигмоидальный более четкий. Но ни персептрон, ни сигмоидальный не похожи на настоящий нейрон, их исследуют с целью получения более высокого соот-я с нейронной сетью.

3. Модель Видроу.

У этой модели две особенности: адаптивный подбор весовых коэффициентов и деление нейронов на два вида: аутстар и инстар.

-instar (в звезду)

-austar

В инстаре как у персептрона 1 выход, много входов. Аутстар – много выходов, 1 вход.

Получили нейроны разных типов, но в природе все нейроны одинаковы, одного типа, но они переплетены. Такое переплетение можно отразить с пом outstar’ов.

9

Замечание. Известно, что в природе нейрон может менять проводимость своих дендритов.

В видроу возможность самообразовываться введена в саму модель.

Этот алгоритм адаптивный и существует попытка приблизится к устойчивому состоянию сети. В аутстаре вводится не вес входящий, а вес выходящий, т. е. этот нейрон работает в обратном режиме.

Аутстары и инстары в видроу наз. Adaptive Linear Neuron (адаптивный линейный нейрон).

Очень часто с помощью адалайна моделируют процессы самообразования, самосагласования и даже появился термин: Many ADALINE (MADALINE) - сеть, состоящая из элементов типа ADALINE.

Причем характеристика ADALINE необычна: она пороговая, нет 0, на выходе либо +1 либо -1:

Т. о. Видроу формировал адалайны на основе логических операций no, and, or и мажоритарных соединений (когда сигналы равны на входе и на выходе).

Гроссберг был автором инстара и аутстара. У Видроу был просто адалайн с +1 и -1. Гроссберг придумал для своих инстар, аутстаров спец методы обучения, которые наз

методы обучения Гроссберга.

4. WTA (победитель получает все).

Эта модель конкурентной борьбы нейронов. Его идея: выходной сигнал формируется не на основе суммы

10

сигналов, а по результатам самого сильного сигнала (если сигнал преодолел порог, то он существует).

Одновременно нейроны WTA по аналогии с адалайном могут быть сформированы в группы конкурирующих между собой нейронов.

на входе сигналы делятся одинаково на все нейроны, дальше сигналы от всех нейронов сравниваются и на выходе один сигнал – победитель.

Т.о. появляются три типа WTA:

1)внутренняя конкуренция между входными сигналами

2)внешняя конкуренция между нейронами. Сигнал передается от выигравшего нейрона.

3)используется и внутренняя и внешняя конкуренция.

5. Нейроны Хебба.

Хебб долго изучал реальные нейроны нервных клеток, он изучал механизмы самосагласования клеток.

Варианты:

1)одна клетка подавляет другую (отрицательное действие).

2)одна клетка содействует возбуждению другой клетки (положительное действие).

3)клетки помогают друг другу (когда ни одна клетка не возбуждается отдельно, а вместе у них получается).

Хебб сделал вывод: изменение весов должно быть пропорционально произведению сигналов на 2-х моделях,

т.е. |

wij ~ yi y j . Если – |

wij , то сигнал |

|

отриц-й и они друг друга гасят. |

Если + |

wij , то |

|

сигналы помогают др другу. |

|

|

|

11

Вывод наз. правилом Хебба. Нейроны и нейронные сети, которые подчиняются правилу Хебба, называются Хеббовскими.Как и у Гроссберга правило Хебба дает возможность создать обучение, т.е. обучение по Хеббу. Хеббовскими наз нейроны, веса которых подбираются по правилу Хебба.

6. Стохастическая модель.

Это вероятностная модель. В данной модели рез-ты на выходе зависит не только от входящей информации, как во всех др моделях, но и от некой случ-й составляющей, случайности событий.

Сущ-ет неск-ко вар-тов введения в модель этой составляющей.

1.выход делают случайным, т.е. сигнал либо проходит либо запирается.

2.в модели сигнаидального нейрона может случайно

меняться параметр β , а в модели персептрона меняют U0

.

3. в модели может случайно отключаться (или вкл-ся) один их входов.

Замечание. В настоящее время во многих моделях нейрона вводятся понятия «активности» и «усталости». Передав сигнал (особенно в условиях конкуренции, WTA), нейрон отдыхает (становится неактивным), чтобы позже проявить активность Þ ввели параметр усталости: чем > сигнал на выходе, тем сильнее усталость. Т.о. у нейрона формируются фазы активности и усталости. Особенно важны эти фазы, где введено в модели нейронных сетей отмирание.

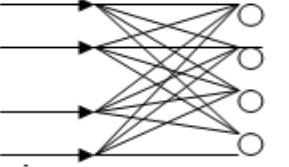

Виды нейронных сетей (НС):

НС образ-ся путемсоед-я однородных нейронов, т.е. нейронов одной модели, следоват-но, сети, например, персептронные, WTA, Гроссберга и т.д.

12

По построению сети делят на: 1)однослойные (нейроны образуют 1 слой);

2)2-хслойные (когда выходы из одной сетиэто входы для второй).

Двухслойные сети делятся на сети без обратной связи и сети с обратной связью.

3)многослойные сети (есть входной слой, выходной слой, 1 или неск-ко внутр. слоев).

Также посторение сети идет:

1)линейное соединение (слой за слоем);

2)рекуррентное (есть обратная связь между вх. и вых. слоем);

3)радиальная сеть (слои образуют окружность).

Особое место в НС заняли реккурентные сети (с обратной связью): обратная связь бывает положит-ая (делает систему неустойчивой, т.к. усиливает отклонение от равновесия) и отрицат-ая (делает систему более устойчивой, ее очень трудно отвести от равновесия). реккурентная сеть с режимом обратной связи была использована для разработки спец. памяти, которая наз. BAM (… assotiation memory)- ассоциативная память, хар-на тем, что запоминает знания, а не данные (например, в рисунках, фотках).

Особые виды НС:

1. Сеть с самоорганизацией (WTA сети, …), когда в сети

ярко выражена саморг-ция: периоды отдыха и активизации, конкуренция групп и отмирание нейронов. (самоорг-ция за счет обратной связи сюда не входит). Кохонен придумал правила самоорганизации, конкуренции, самообучения в НС.

2. Корреляционные сети (сети Хебба) – это самооргщаяся сеть, но на основе правил Хебба. Делятся на 2 категории: PCA (компонентный анализ) и ICA (анализ независимых компонент).

13

3. Нечеткие (случ-е) сети - используют нечеткую логику. Прохождение сигнала через случ-й нейрон опр-ся не только уровнем сигнала, но и случ. величиной. Если случ-е нейр-ы объед-ся в сети, то образ-ся очень сложная случ-ая система, которая наз. случайными сетями. Здесь есть алгоритмы самоорг-ции, но особого вида.

14

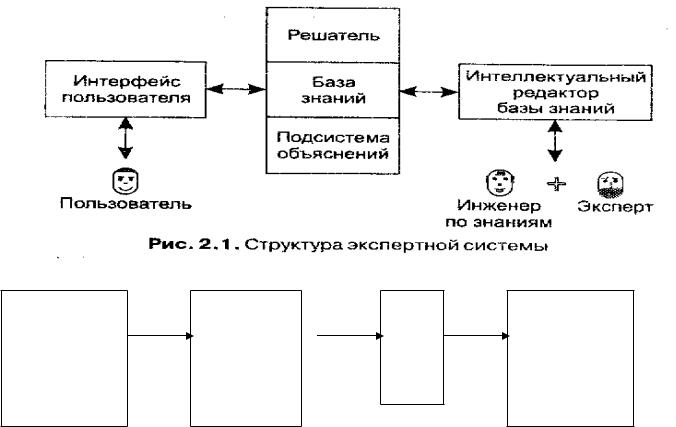

32.Экспертные системы: структура, назначение, классификация. Методы построения экспертных систем. Понятие о инженерии знаний.

ЭС – система моделирующая поведение человека-эксперта в какой-то области знаний Современные ЭС создаются на основе баз знаний,

используют интеллектуальный интерфейс, интеллектуальные подсистемы вывода ответа на запрос, использующие нечеткую логику и интеллектуальный анализ данных. Для работы и обслуживания ЭС даже введен специальный инженер по знаниям, который должен следить за качеством используемых знаний.

Общая харак-ка, назначение ЭС.

На сегодняшний день самое важное – сфера создания экспертных систем.

Часто формируют динамическую часть БЗ.

Внастоящее время ЭС не мыслятся без СО. СО служит для модернизации всех структур ЭС. СО формируется как отдельная система, тогда когда ней используются средства построения и добычи знаний.

Знанияне просто факты, их нужно обрабатывать и сжать.

Всовременных системах стремятся перейти к естественному интерфейсу.

Назначение ЭС

Моделировать работу человекаэксперта. Ему задают вопросы он выдаёт ответ. Вопрос должен быть формализован. Их принято называть запросами.

Запросы, которые можно подавать ЭС, определяют её область применения. Чем шире эта область, тем больше применения ЭС, но теряются скорость и точность работы. ЭС строит ответы на вопросы исходя из соей БЗ.

При создании ЭС существует этап заполнения БЗ. И предусматривают какойлибо метод накопления, обработки, совершенствования и оптимизации знаний.

15

Наилучший вариант самообучения, но приходится иметь инженера знаний.

Пользователь – это человек, который получает информацию от экспертной системы, а так же может закладывать факты и правила в эту систему.

Интерфейс – это программа, которая обеспечивает взаимодействие пользователя с экспертной системой (ввод, вывод информации).

Общая схема ЭС:

Структура экспертной системы.

Интерфейс |

Механизм |

База |

Система |

пользователя |

Логического |

знаний |

Машинного |

|

вывода |

|

обуче- |

|

|

|

ния |

1.Пользовательчеловек; который получает сведения из ЭС, и может закладывать факты и правила в ЭС.

2.Интерфейспрограмма, которая обеспечивает взаимодействие пользователя с ЭС.

3.МЛВнабор правил, которые позволяют строить ответы на запросы со стороны интерфейса обращается к БЗ.

4.БЗнабор правил и фактов, которые не вошли в МЛВ. МЛВ и БЗ взаимно обмениваются информацией. МЛВ может изменить, удалить, добавить факты.

База Знаний

Зависит от модели представления знаний

16

Для логической БЗ (Пролог) состоит из набора сущностей: Факты – связывают константы Правила – связывают элементы с помощью условия

Механизм логического вывода (МЛВ) – набор правил, которые позволяют строить ответы на запросы со стороны интерфейса. За необходимыми данными этот блок обращается к базе знаний. БЗ – набор фактов и некоторых правил, которые не входят в МЛВ. МЛВ и БЗ взаимно обмениваются информацией – это значит, что МЛВ может изменить, удалить или добавить какие-то факты. Часто для этого формируют динамическую часть БЗ.

Системы Обучения – система обучения. В настоящее время экспертные системы содержат системы обучения. Она служит для модернизации структур всей системы: изменения интерфейса, механизма ввода, вывода БЗ. СО формируется как отдельная система тогда, когда в ней используются средства построения и добычи знаний. Т.е. знания это не просто факты, их еще необходимо обработать и сжать в виде спец-х правил.

Интеллектуальный интерфейс

Всовременных системах стремятся перейти к естественному интерфейсу, близкому человеку (естественный язык, восприятия образов, интеллектуальный диалог).

ЭС задают вопросы, она выдает ответ. Вопрос\Запрос должен быть формализован (построен по определенным правилам).

Интелектуальный анализ данных

ВИАД 2 основные технологии:

Раскопка знаний\данных: Data Mining – это переработка большого объема данных с попыткой выявить взаимосвязь (ассоциативные методы анализа, логические методы – дедукция, индукция, абдукция).

17

Открытие знаний\данных: KnowLeadge Discovery – обобщение, кластеризация и классификация знаний.

Интеллектуальные ЭС.

Наибольшее развитие получили ИИС. Сравним интеллектуальные ИС (ИИС) и обычные ИС. Их отличия: 1. Изменение интерфейса. Стараются сделать его интеллектуальным. Здесь интерфейс активный, т. е. инф. Система становится агентной системой. Агент – это развитие понятия «объект». Объект, также как и фрейм соединяет в себе св-ва и методы, с пом. которых можно изменять эти св-ва и выполнять какие-то действия. Т. О. объект может реагировать на события(событийное управление). Агент дополнительно к этому имеет внутренние методы, которые побуждают его к действию – сбор фактов и изучение ситуации, приспосабливание к ситуации, установление контактов с др. объектами и пользователями, стремление к некой сверхзадаче. На сегодн. день сущ как одноагент., так и многоагентные системы. Интерфейс информац-ой агентной системя отл. тем, что агентная система не просто отв. На вопросы, но и сама стремится задать уточняющий вопрос и т. д.

2. Изменение структуры данных. Расширяются формы представления данных, т. е. помимо стандартных моделей появляются новые модели данных. Принято разделять данные на БД и БЗ. БЗ – набор правил, с пом. которых м. разыскивать данные в БД. Принято формировать БЗ в виде хранилища данных. Хр. данных характерно для СУБД ORACLE, Informix. В каждом хранилище данных сущ. программа, кот. Обрабатывает данные и формирует БЗ по двум осн. технологиям: раскопки знаний, открытие знаний. Разница между технологиями определяется методами правил БЗ. Раскопка знаний наз. OLAP и Data Mining. Открытие – Knowledge Discovery. Data Mining – перерабатывание большого объёма данных с попыткой

18

выявить взаиамосвязь; откр. знаний – это значит установить скрытую связь. Кроме программы обработки в хранилище данных важную роль игр. Формирование структуры БД. Как известно, сущ. так называемые правила нормализации данных. Следующим этапом является формирование такой структуры, чтобы не только был мин. объём информации, но и самый быстр. поиск. теоретически самый быстр. поиск идёт по бинарному дереву. Но практически иногда выгодны др. формы. Характерные формы: звезда, созвездие, дерево.

3. использование методов системного анализа для инженерии знаний. Хранилище данных должно пополняться, оптимизироваться и т. д. Сами данные часто обрабатываются, чтобы отделить несущественные. Поэтому между источником данных и хранилищем сущ. система, кот. наз. системой облучения. Она м. б. автоматич. или управляемой. Задача инженера знаний: собирать данные, кот. имеют практическую значимость, а также формировать и модифицировать БЗ дополнительно. инженер знаний должен: а) опр-ть источники информации; б) опр-ть достоверность и активность инф-ии; в) формировать правильные правила для БЗ. Решить эти задачи м. только профессионал в этой области. Но областей много, а инж. знаний д. б. ещё специалистом по экспертным системам, значит он пользуется спец. методом экспертных оценок.

4. Деление БД и БЗ на статистич. и динамич. составляющую.Первые варианты использования динамических структур (хэш-памяти) использовались ещё в обычных ИС, но в хранилищах данных эти технологии значительно усовершенствовались. Вся структура данных динамич. Части, ресурсы сервера храеилища данных ориентированы на оптимизацию динамической части, т. к. она хранится в оперативной памяти. В оперативной памяти

19

в осн. отправляется БЗ. т. к. там самые ёмкие данные. Т. О. ИИС становятся настолько сложными системами, что практически не сущ. вариантов подобных СУБД общего назначения. Это всё специализированные, но не специализированы они не в области знаний, а по решаемым задачам. Зад. прогноза, зад. динамич. оптимизации, ситуации неопределённости и т. д. Кроме того, особую область занимают агентные и мультиагентные системы, которые могут служить основой робототехники и т. д. , т. е. для особых задач.

Методы построения ЭС и классификация ЭС по методам построения

ЭС принято классифицировать либо по назначению, либо по принципу организации.

Классификация по принципу организации

1)интеллектуальные ИС 2)системы поиска на основе семантических сетей и

тезаурусе. Иногда их наз-ют интеллектуальнопоисковые системы.

3)Системы, построенные на нейронных сетях. Начиная с 1998 года, стали выпускаться промышленные образцы ассоциативной памяти на нейронных сетях, системы обработки инф-ции на нейронных сетях.

4)Система основанная на распознавании образов. Здесь активно используется кластерный анализ, интересны также разработки в области когнитивной графики, т.е. графики, которая может адаптироваться.

5)Агентные и многоагентные системы, которые не относятся к информационным системам.

6)Системы, основанные на случайных характеристиках: байсовских сетях, сетях Петри. Случайными характеристиками могут обладать и нейронные сети. Главное, что объединяет эти сети – использование

20

нечеткой логики, они называются нечеткими системами.

7)Фреймовые системы. В настоящее время идет соединение фреймовых и агентных систем.

8)Системы основанные на декларативном подходе (логическое или функциональное программирование). Здесь выделяют логические системы и системы, основанные на структурных данных. В логических системах необходимо: а) построить аксиоматику, т.е. выделить положения аксиом, которые играют роль фактов; б) установить правило логического вывода, заключений с помощью которых из аксиом можно доказать другие утверждения; в) сформировать интерфейс запросов.

Классификация по назначению ЭС.

1)информационные системы позволяют отвечать на вопросы в рамках существования информации. Для данных систем можно использовать любые подходы, но в основном это логические системы, структурные и нейронные системы.

2)Аналитически поисковые системы: в них используются поисковые системы и системы распознавания образов. Особые направления в данной области – это развитие систем ассоциативной связи (ассоциативная обработка информации с помощью нейронных систем, нечетких систем и сетей добытия знаний ИАД – интеллектуальный анализ данных).

3)Направление работы с естественным языком, т.е. ЭС в области языка: переводчики, проверка правописания и др. Они основаны на методах распознавания образов, семантических сетях, нечетких системах.

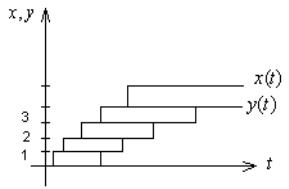

4) Системы прогноза:: |

задача |

– построить |

экстраполяцию текущих |

данных, |

основываясь на |

обработке текущей информации. Суть экстраполяции:

21

чем больше используются данные о предшествующих событиях, тем точнее возможна экстраполяция. Главная проблема – правильно выбрать нужную информацию: чтоб она было min и значимой. Здесь используется ИАД; попытка оценить вероятность тех или иных будущих событий. Т.о. необходимо просматривать варианты будущих событий и отображать наиболее вероятные. Здесь важную роль играют нейронные системы, генетические, нечеткие системы. Особую роль играют в таком анализе байсовские сети, которые так удобны для решения этих задач, долгое время они являлись лидером.

5)Системы управления являются продолжением систем прогноза, для этого необходимо на основе прогноза строить обратную связь, т.е. добавить в систему обратные связи. В формировании обратной связи особую роль играют ИАД, рекуррентные, нейронные сети, логические системы.

6)Системы принятия решений: это усовершенствованные системы управления. Если есть системы управления, действия системы и системы прогноза, то можно строить не только корректирование системы управления, но и системы собственного вектора. Система принятия решений переводит самостоятельные и функционированные ЭС на новый уровень.

7) Системы самостоятельного поиска и самоорганизационные системы: на основе агентных систем можно усовершенствовать и систематизировать принятия решений, сделав ее на много самостоятельной. Агентные системы обладают неким подобием свободы воли, т.е. они обладают возможностью адаптироваться к ситуации, общаться и

22

учиться и формировать свое поведение на основе неких правил общения.

8)ЭС логического анализа: с 40-х годов, с тех пор как были созданы искусственные логические системы, идет постоянное усовершенствование таких систем. Перед ними становятся следующие цели: а) заменить человека в такой рутинной деятельности как математические преобразования, доказательство теорем (системы ТРНЗ, их целю была разработка конструктивной изобретательной и научной деятельности); б) решение сложных логических задач и компьютерных игр.

9)ЭС в области классификации: одним из направлений деятельности человека– классификация: распознавание, систематизация защита, диагностика. Проблемы диагностики с одной стороны сложны, с другой–важны, ЭС в диагностике получает свое собственное развитие. Системы диагностики прежде всего основаны на ИАД и системах распознавания образов (в ИАД есть особое направление – методы классификации).

Инженерия знаний

Усложнение процессов разработки, внедрения и сопровождения ЭС привели к появлению особой специальности – инженер знаний. Инженерия знаний – особый раздел инженерной деятельности, связанный с обслуживанием баз знаний.

При использовании интеллектуальных систем для решения задач в данной предметной области необходимо собрать о ней и создать концептуальную модель этой области. Источниками знаний могут быть документы, статьи, книги, фотографии и многое другое. Из этих источников надо извлечь содержащиеся в них знания. Этот процесс может оказаться достаточно трудным, ибо надо заранее оценить

23

важность и необходимость тех или иных знаний для работы интеллектуальной системы. Специалисты, которые занимаются всеми вопросами, связанными со знаниями, теперь называются инженерами знаний. Эта новая профессия порождена развитием искусственного интеллекта.

Значительная часть профессионального опыта остается вне источников информации, из которых инженер вносит знания в интеллектуальную систему, в головах у профессионалов, не могущих словесно их выразить. Такие знания часто называют профессиональным умением или интуицией. Для того, чтобы приобрести такие знания, нужны специальные приемы и методы. Они используются в инструментальных системах по приобретению знаний, создание которых одна из современных задач инженерии знаний.

Полученные от экспертов знания необходимо оценить с точки зрения их соответствия ранее накопленным знаниям и формализовать их для ввода в память интеллектуальной системы. Кроме того, знания, полученные от различных экспертов, надо еще согласовать между собой. Все эти задачи и выполняет инженер по знаниям.

24

33.Математические модели в физике, химии, биологии и экономике

Мы будем рассматривать в данном разделе аналитические модели. В аналитических моделях вход. и выход. Параметры связаны явными выражениями: уравнениями, неравенствами и т.д. Если мы решаем системы уравнений Колмогорова-Эрланга, это аналитическое моделирование, если же мы останавливаемся на графовой модели и проводим статистический эксперимент, определяем как обслуживает система поток заявок, то это имитационное моделирование. Для решения аналитической модели обычно приходится применять численные методы решения задач, но некоторые модели дают и аналитическое решение, т.к. для решения разных математических задач используются разные методы, иногда аналитические модели делят по методам (интегральные, дифференциальные, линейные и т.д.), но обычно по сферам применения (физические, химические, биологические, педагогические, технические). Рассмотрим некоторые примеры аналитической мат. моделей, которые являются наиболее простыми и в то же время классическими.

Математические модели в физике и технике

В физике моделирование в основном используется для описания процессов в производстве, связанных с решением дифференциальных уравнений и частных производных. Все другие модели, это обычно упрощенный вариант этих процессов. Основой для построения моделей являются следующими законами и уравнениями:

∙ Δυ =0 - уравнение Лапласа( – 2-ая

производная)(описывает поведение электрических и магнитных полей, упругость);

25

∙

∙

∙

∙

Δυ = ρ(x, y,z) -уравнение Пуассона(используется в

механике); |

|

|

∂2 T |

=aΔT - уравнение теплопроводимости; |

|

∂ t |

|

|

∂2 υ |

=CΔυ |

- волновое уравнение, это частным |

∂t2 |

||

|

|

|

случаем может быть названо уравнением колебаний.

= |

∂ 2 |

∂ 2 |

∂ 2 |

|||

|

+ |

|

+ |

|

- оператор Лапласа в декартовой |

|

∂ x2 |

∂ y2 |

∂ z2 |

||||

системе координат.

Часть уравнений записывается в одномерном виде или с помощью радиус-вектора

|

|

|

|

|

|

|

d 2 |

|

|

|

|

|

d |

|

|

|

r |

||

|

|

|

r |

|

a = |

||||

ν = |

; |

||||||||

dt |

dt 2 |

||||||||

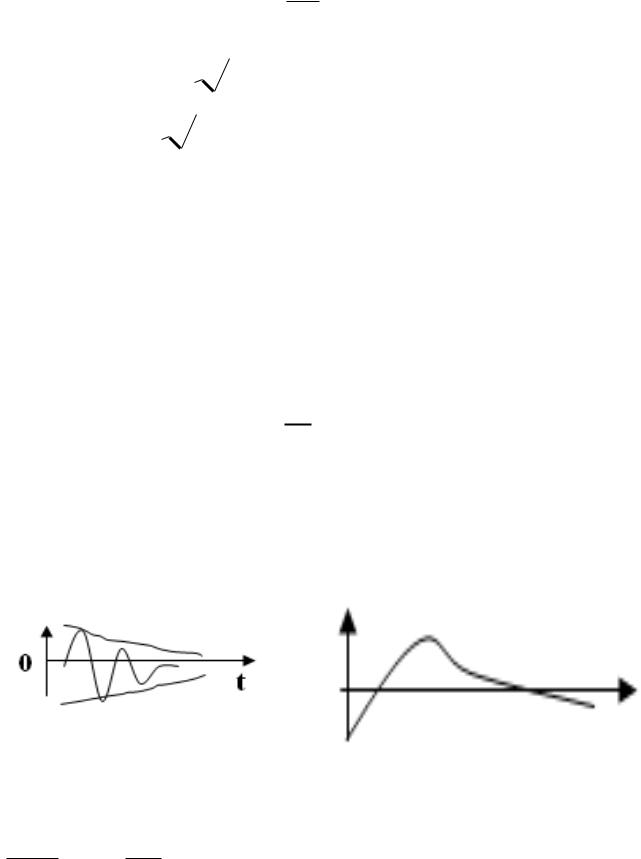

2. Модель колебательной системы

Рассмотрим ее от простого к сложному. В качестве примера могут служить очень многие окружающие на предметы, где важна вибрация (двигатели). Колебания свойственны и электрическим системам. Будем считать, что у нас одномерные колебания (вдоль одной оси).

Положение предмета

определяется одной координатой х, уравнение будет

∂2 x + cx = 0 .

∂t 2

26

Решение этого диф. уравнения хорошо известно, оно представляет из себя

x = Acos(

ct) +

ct) +

+ Bsin( |

|

|

|

|

|

ct) = |

|||

~ |

|

|

|

|

ct + ϕ ) |

||||

Acos( |

||||

Колебания Гармонические со сдвигом фазы, незатухающие.

Усложняем модель - вводим затухание

d 2 x |

+ K |

dx |

+cx = 0 (К- коэффициент затухания) |

|

dt 2 |

dt |

|||

|

|

Если К мало (К<<1), то решение не будет сильно отличаться. Решение системы приводит к возникновению

x = Ae− kt cos(

ct +ϕ ) .

ct +ϕ ) .

К=0,1- затухание хорошо видно (переодич.). При увеличении К ( ≈ 1)- апериодическое затухание, когда нет ни одного периода.

Дальше Усложняем задачувведение периодичность внешней силы

∂∂ t2 2x + K ∂∂ xt + cK = βcos(pt)

27

Собственная частота ω=

c , частота внутри силы р. Когда частоты равны, получаем резкое увеличение амплитуды колебаний - резонанс, ω= p . Если

c , частота внутри силы р. Когда частоты равны, получаем резкое увеличение амплитуды колебаний - резонанс, ω= p . Если

резонанс производить при колебании, собственные колебания затухнут, останутся вынужденные с частотой вынужденной силы.

К<<1, W>>p.

Модуляция. Внутри собственные колебания, их амплитуда моделируется с частотой собственных колебаний (биения)

Если К<0, м.б. β=0 (т.к. она только мешает) – параметрический резонанс.

Фактически параметрический резонанс при отрицательном затухании - это получение энергии извне. Процессы собственных колебаний важны, когда колебания паразитные (вредны), когда делают демпферы (делают затухания апериодичными).

Пример: рессоры автомобиля (обычно полезны для раскачки колебаний).

28

Резонанс может быть отрицательным и положительным по значению. Излучение электромагнитных волн основано на резонансах, как обычных, так и параметрических. Излучение и прием электромагнитных волн резонансные. Параметрический резонанс выгоден тем, что гораздо мощнее обычного. Это удобное средство для генерации, например, СВЧ-колебаний (магнитофон). Для параметрического резонанса собственная частота не нужна, поэтому можно вкачивать энергию до самого разрушения этого резонатора. Но может быть и вред, разрушение, что неприятно.

Модуляция – основа радиосвязи. Есть несущая частота, которую модулируют, а потом де модулируют. Звук низкочастотен (36 КГц), а радиоволна распространяется на высокой частоте, значит, нужны мегагерцы. Есть амплитудная, фазовая и частотная модуляция. Эффект биений обычно вредный, мешающий – это источник шума. Иногда с помощью биений делают специальные шумовые генераторы.

Модель теплопроводности тонкого слоя

Т1 |

|

Т2 |

|

|

|

ab

X

X

стекло |

(тонкое, длинное), |

|

Т (t,λ ) - температура будет |

||||

|

|

|

∂ T |

∂ 2T |

t1 x = 0 = T2 |

||

равномерна, следовательно |

|

= a |

|

. |

T (t1 x = t) = T1 |

||

∂ t |

∂ x2 |

||||||

гранич. |

T (0, x) = T3 (x) |

Обычно |

это |

уравнение не |

|||

29

решается в явном виде, а с помощью клеточной аппроксимации. Решая эту систему уравнений, мы находим значения в узлах сетки. Подобным же способом моделируются другие задачи теплопроводности, электростатики и электродинамики. Основная проблема – сложность вычисления, поэтому требуются мощные ЭВМ. Еще одна модель – движение тела, брошенного под углом к горизонту. Для ее решения используют так называемый метод стрельбы, он уже близок к имитационному моделированию.

Еще – модель движения ракеты:

Mg |

F тяги |

|

|

|

|

|

|

m = m0 |

- α × t |

|

d 2 h |

F |

F |

− mg − KV 2 |

|

||||

|

|

|

|

|

тяги |

|

- |

уравнение |

dt 2 = |

m = |

|

m |

|

||||

Циолковского.

Кинетические и структурные модели в химии

В химии в основном распространены модели химических реакций и строение модели хим. соединений. Для хим. реакций самое важное –кинетика, т.е. изменение течение реакций со временем, т.е. чем быстрее идет реакция, тем меньше остается реагирующего вещества, и наоборот. В начале ХХ века Адольф Лотка сформулировал модель кинетических реакций, которая была названа модель Вольтерра-Лотки. Цепочка превращений веществ:

30

|

|

K |

K |

K |

® |

B _ |

|

|

A ¾ ¾0 ® |

X ¾ ¾1 ® |

Y ¾ ¾2 |

|

|||||

где _(K0 , K1, K2 - скорости) |

|

|||||||

|

∂ x |

=K 0−K 1 XY |

|

|

|

∂ y |

=K 1 XY −K 2 Y |

|

|

|

|

|

|

||||

|

|

|

|

|

∂t |

|||

|

∂ t |

|

|

|

|

|

||

∂∂Bt = K 2 Y

Получена система диф. уравнений. Эти уравнения по смыслу похожи на уравнения КолмогороваЭрланга. Это показывает, что то были тоже кинетические уравнения и все кинетические процессы похожи друг на друга.

В химии кинетические уравнения усложняются тем, что величины K 0 , K 1 , K 2 не являются постоянными, а зависят

от таких величин как t , p ,

химический состав веществ (температура подчиняется закону теплоемкости, р зависит от диффузии, которая

определяется уравнением ΔN + B ∂∂Nt = 0 - закон диффузии

Фика. Похожее соотношение имеет и закон фильтрационного переноса Дарси). В результате приходится решать одновременно с кинетической еще и эти сложные уравнения.

В химии большое значение имеют структурные модели молекул: Н-О-Н, особенно удобна для органических веществ (у них очень сложная структура).

При изучении нового хим. вещества делают новый хим. анализ - определяют пропорции содержащие тех или иных

31

веществ. Тогда можно определить из каких атомов состоит молекула, но и от того, как они соединены. Вводится валентная связь. Одни атомы имеют 1-ю валентную связь, другие 2-ю и т.д. Были обнаружены изомеры вещества с одинаковым количеством молекул, но с разными свойствами.

Þ2 задачи:

Определить внутреннюю структуру молекулы и связать ее структуру и хим. свойства, т.е. изучение изомеров.

Проектирование изомеров - научиться создавать устойчивые структуры для молекул различных видов и давать их предположит. свойства.

Обе эти задачи стали настолько популярны в органической химии, что даже были созданы специальные системы моделирования молекул.

Математические модели в биологии

Биология чрезвычайно связана с химией и биохимией => структурное моделирование из химии перешло и в биологию. Биологические структуры – очень сложные химические структуры => появилась наука биохимия, которая изучает химию биологических структур. Здесь методы структурного моделирования оказались очень полезны. Наиболее известные задачи, связанные с моделированием генов.

Гены – молекулы, из которых формируется так называемые информационные компоненты живых существ-ДНК, РНК. В основном гены уже изучены и известны, но остались вопросы какие гены входят в ту или иную ДНК и как они связаны между собой. Т.к. даже в простейшем ДНК генов десятки тысяч, возник мировой проект «модель ДНК» , сначала у простейших существ, теперь человека (завершение) . Структурное моделированиеведущее в биохимии.

32

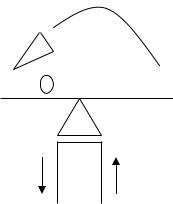

Модели внутривидовой борьбы

Особи одного вида конкурируют между собой. В начале, когда особей мало, а условия благоприятные идет быстрый рост популяции, ограничения наступают из-за борьбы между особями одного вида. Самой первой простой моделью стала модель роста – модель безудержного роста. В этой модели отсутствует внутривидовая конкуренция, она будет модернизироваться.

Ni+ 1 |

= |

|

Ni * R |

||

1 |

+ aNi |

||||

|

|

||||

Чем больше a, тем меньше рост, однако, и эта модель не могла описать некоторые явления, которые возникали в реальных экосистемах. В некоторых системах возникали колебания численности из года в год. Ввели еще один параметр, усложнили модель

Ni+ 1 = |

Ni * R |

1+ (aNi )b |

Коэффициент b определяет нелинейную зависимость скорости роста R от численности. Численное изучение этой модели позволило обнаружить 4 характерные ситуации:

- монотонный рост

- ситуация затухающих колебаний

- ситуация незатухающих колебаний

- ситуация флуктуаций (случайных изменений) Данные модели дискретные, но можно построить и

непрерывную, кинетическую, ее уравнение:

dNdt = rM . при этом r – некий аналог скорости. Эта

двухпараметричная модель называется логистической кинетической моделью (модель Вольтера - Лоттки).

33

Модели межвидовой конкуренции

Если сосуществуют 2 вида, которые активно воздействуют друг на друга, то возникают процессы межвидовой конкуренции и борьбы. Наиболее известна модель (кинетическая) Вольтера - Лотки конкуренция двух видов:

dN1 |

= rN1 * |

(k1 − N1 ) − α 12 N2 |

||

dt |

|

|

k1 |

|

dN2 |

= rN2 |

* |

(k2 − N2 ) − α 21 N1 |

|

k2 |

||||

dt |

|

|

||

Коэффициенты определяют связь между 2 видами. Если, то увеличение особей второго вида идет к уменьшению особей первого вида. Второй вид подавляет первый. Если, то особи второго вида не влияют. Очевидно, чем больше волков, тем меньше зайцев. В модели 6 параметров – ее изучение очень сложно, поэтому обычно фиксируют часть параметров. В общем случае изучение этой параметрической модели показало, что популяции хищников и жертв испытывают циклические изменения. В биологии очень часто используют так же имитационное моделирование.

Имитационное моделирование в биологии Модель «жизнь»

В ней имитируется размножение простейших существ, задаются некоторые ограничения на размножение, гибель и т.д., а затем запускается эксперимент и прослеживается динамика со временем. Простейший вариант (школьный). Берем таблицу клеток пустых и заполненных (живых). Задаются правила, например если живая клетка окружена 4 и более живыми, то она погибает от перенаселения, если

34

возле нее один или нет, погибает от одиночества. Если к мертвой примыкает 3 живые, она оживает. Эксперимент:

-задается начальная случайная конфигурация живых клеток

-задается количество моментов времени, которое будет прослежено

-в цикле по моментам времени производят обновление таблицы по заданным правилам, и наблюдают за изменением картинки. Подобные системы изучались, и оказалось, что в такой таблице могут существовать устойчивые конфигурации, которые не разрушаются.

Модели в экономике

Экономические науки – одна из наиболее важных сфер применения моделирования, именно здесь модели дают наибольшую эффективность, например если оптимизировать в одной модели траты всего государства, эффект будет выражаться в миллиардах долларов. Можно выделить следующие типы моделей:

- модель ЛП (линейные) – модель ресурсов, запасов и

т.д.

- модели, построенные на транспортной задаче (распространение и перевозка грузов)

- модели целочисленного программирования (результат принадлежит области целых чисел, количество человек, число заводов и т.д.) – модели первого типа с целочисленными параметрами.

- модели динамического программирования – в основном связанные с развитием какого-либо производства, фирмы и т.д.

- игровые модели, связанные с противоборством, конкуренцией.

- прогностические модели, связанные с прогнозом ситуации при недостатке информации или случайных событиях.

35

- модели автоматического управления (сделать систему управления оптимальной)

нелинейные модели решаются только в отдельных случаях.

36

34. Стохастическое моделирование. Метод МонтеКарло в моделировании. Генерирование случайных и псевдослучайных чисел. Методы и алгоритмы генерации. Генерирование случайных чисел распределенных по экспоненциальному, нормальному и произвольно заданному закону распределения.

Стохастическое программирование – раздел математического программирования, совокупность методов решения оптимизационных задач вероятностного характера. Это означает, что либо параметры ограничений (условий) задачи, либо параметры целевой функции, либо и те и другие являются случайными величинами (содержат случайные компоненты).

Оптимизационная задача - экономико-математическая задача, цель которой состоит в нахождении наилучшего распределения наличных ресурсов. Решается с помощью оптимальной модели методами математического программирования, т. е. путем поиска максимума или минимума некоторых функций при заданных ограничениях (условная оптимизация) и без ограничений (безусловная оптимизация). Решение оптимизационной задачи называется оптимальным решением, оптимальным планом, оптимальной точкой.

Случайные величины характеризуются средними значениями, дисперсией, корреляцией, регрессией, функция распределения и т.д.

Статистическое моделирование – моделирование с использованием случайных процессов и явлений. Существует 2 варианта использования статистического моделирования:

– в стохастических моделях может существовать случайные параметры или взаимодействия. Связь между

параметрами носит случайный |

или очень сложный |

характер. |

|

37

– даже для детерминированных моделей могут использоваться статистические методы. Практически всегда используются статическое моделирование в имитационных моделях Модели, где между параметрами существует однозначная

связь и нет случайных параметров называются

детерминированными.

Детерминированные процессы – определенные процессы, в которых всякие процессы определены законами.

Человек считает все процессы детерминированными, однако со временем обнаружены случайные процессы. Случайный процесс – это такой процесс, течение которого может быть различным в зависимости от случая, причем вероятность того или иного течения определена.

Исследование процессов показало, что они бывают 2-х типов:

а) Случайные по своей природе процессы; б) Очень сложные детерминированные процессы;

Доказана центральная теорема, в соответствии с которой сложение различных процессов увеличивает случайный характер. Так, если сложить совершенно разные последовательности, не связанные между собой, то результат в пределе стремится к нормальному распределению. Но известно, что нормальное распределение – независимые события, следовательно, объединение детерминированных событий в пределе ведет к их случайности.

Т.о. в природе не существует совершенно чисто детерминированных процессов, всегда есть смесь детерминированных и случайных процессов. Действие случайного фактора называется “шумом”. Источники шума

– сложные детерминированные процессы (броуновское движение молекул).

38

Вимитационном моделировании часто сложные процессы заменяют случайными, следовательно, для того чтобы сделать имитационную модель, нужно научиться моделировать случайные процессы методами статического моделирования. Представляют случайные процессы в КМ последовательностью случайных чисел, величина которых случайно меняется.

Встатистическом моделировании очень часто используется метод статистических испытаний МонтеКарло. Метод Монте-Карло – это численный метод

решения математических задач при помощи моделирования случайных величин.

Суть метода: для того, чтобы определить постоянную или детерминированную характеристику процесса можно использовать статический эксперимент, параметры которого в пределе связаны с определяемой величиной. Сущность метода Монте-Карло состоит в следующем: требуется найти значение а некоторой изучаемой величины. Для этого выбирают такую случайную величину

X , математическое |

ожидание |

которой |

равно |

a : |

||||

M( X ) = a . Практически же поступают так: производят |

n |

|||||||

испытаний, в результате которых получают |

n |

|||||||

возможных |

значений |

X ; вычисляют |

их |

среднее |

||||

арифметическое |

x = |

(å |

xi )/n |

и принимают |

x |

в |

||

качестве |

оценки |

(приближенного значения) |

a* |

|||||

искомого числа a |

: a ≈ |

a* = |

x . |

|

|

|

|

|

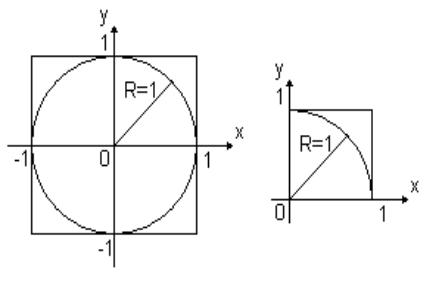

Рассмотрим суть метода на примерах его использования:

39

1) |

проверка |

равномерности |

|

распределения |

|

генератора |

|

случайных чисел. |

|

В |

статическом |

моделировании |

|

принято источники |

|

случайных чисел называть

генераторами. Обычно используют генератор случайных чисел равномерно распределенных на диапазоне от 0 до 1. Распределение называется равномерным, если вероятность появления числа на любом из отрезков одинакова. После создания генератора можно проверить, насколько равномерно его распределение. Это можно сделать методом Монте-Карло. Рассмотрим ПДСК (x;y) и построим окружность R=1. Вокруг окружности построим квадрат. Рассмотрим первую четверть:

Найдём площади квадрата и окружности: Sкв.=1; Sчасти кр.= Sкр./4=πR2/4=π/4.

Проводим статистический эксперимент, для этого генерируем 2 последовательности xi [0;1] и yi [0;1] .

Пара этих чисел дает точку на плоскости (xi , yi ) . Т.о.,

эти две последовательности дают последовательность точек, но часть точек попадает в окружность, а часть будет вне окружности. Подсчитываем количество точек внутри Nвн. и общее количество точек Nобщ.. С точки зрения теории вероятности, если множество точек равномерно распределено по площади, то кол-во точек зависит от размера площади:

40

Nlimобщ → ∞ |

Nвнутри |

= |

Sсектора |

= |

π |

|

|

4 . |

|||

Nобщее |

Sквадрата |

Проверяем, так ли это в нашем эксперименте. В принципе точно π/4 мы не получим, но должны получить число близкое к нему. Проводят несколько экспериментов, а потом найденную величину усредняют.

Если средняя величина ближе к π/4, чем каждое из вычисленных величин, то считают, что гипотеза о равномерном распределении оказалась правильной. Для метода Монте-Карло это характерно: делаем гипотезу, затем проводим статистический эксперимент и проверяем эту гипотезу. Если гипотеза справедлива, то распределение равномерно, в противном случае – не равномерно.

2) Вычисление интеграла.

xx(), где S+ - площадь под кривой, там где функция >0.

S− - площадь под кривой, там где функция <0.

41

Рассмотрим прям.1 и проведем в нем эксперимент, найдем S+ . Проведем эксперимент в прям.2 и найдем S− .

Потом можно найти интеграл. Основания прям. одинаковые (от a до b), а высота разная (высота Прям.1

fmax , а высота Прям.2 |

fmin ). |

Если |

fmax ≤ 0, |

S+ |

=0, |

значит, функция внизу; |

если |

fmin |

³ 0 , S− = |

0, |

то |

функция вверху. Поэтому, чтобы найти интеграл одномерной функции, нужно найти максим. и миним.

значения функции на этом отрезке, проверить fmax ≤ 0

или fmin ³ 0 . Интеграл равен S+ - S− . Для того чтобы определить, что точка попадает в положительную область

yi |

≤ |

f (xi ) , |

при |

этом |

yi ³ 0, yi Î [0; fmax ] |

и |

yi |

³ |

f (xi ) |

, при этом |

yi ≤ |

0, yi [0; fmin ] ,\. |

|

3) Методы случайного поиска Поиск – задача определения максимума или минимума

функции, она сложная для многомерного случая. Если нет дополнительных условий-ограничений, то можно использовать методы градиентного поиска и метод координатной релаксации. Но существует возможность использовать и метод Монте-Карло:

Пусть задана некая область S в системе координат. В этой

области есть одна точка экстремума (максимума или минимума). Нужно найти эту точку. Для метода МонтеКарло сгенерируем две последовательнсти: n, сгенерируем

42

xi |

= |

xmax + |

|

(xmax − |

xmin )ξ i |

, |

|

|

|

|

|

|||||||||||||

yi |

= |

ymax + |

( ymax − ymin )η i |

|

|

|

|

|

|

|

|

|

и |

|||||||||||

|

|

|

|

|

|

|

|

|

||||||||||||||||

, |

|

|

|

ξ |

i |

[ |

] |

|||||||||||||||||

|

|

|

|

|

|

|

|

0;1 |

|

|||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||

η i [0;1] |

|

|

|

ymax |

|

|

|

|

|

|

|

|

||||||||||||

|

|

|

|

|

|

, |

xmax |

, |

|

xmin |

|

|

|

|||||||||||

, где |

|

, |

ymin |

- |

границы |

|||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||

|

|

|

|

|

. Тогда |

( xi ; yi ) |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

области |

|

S |

|

точки |

|

|

лежат |

|

в |

области. |

||||||||||||||

Вычислим в |

|

|

|

|

|

|

|

функций |

||||||||||||||||

|

этих |

точках значения |

|

|

||||||||||||||||||||

fi = f (xi ; yi ) . Затем среди этих значений найдем

максимальное/минимальное. По теории вероятности следует, что если количество опытов устремить в бесконечность, то это экстремальное значение стремится к искомому значению. Тогда существуют следующие

варианты:

а) простой поиск, берем побольше точек и считаем, что максимальное значение соответствует нашему максимальному значению; б) поиск с аккомодацией – проводим несколько

экспериментов, но каждый раз область уменьшаем так, чтобы максимальное значение было в центре. При этом центр области выбирается в текущем максимальном значении. Очевидно, что этот метод более быстрый и требует меньше случайных точек, так как при этом уменьшается область, их плотность увеличивается.

43

в) метод последовательного поиска – точки с самого начала берутся в маленьком окошке, но это окошко перемещается так от шага к шагу, чтобы максимальное значение было в центре.

Так как во 2 и 3 случаях повторять процесс можно до бесконечности, то мы остановимся тогда, когда размер области или расстояние перемещения для центра окна меньше заданной погрешности. Существуют так же варианты, которые совмещают в себе 2-й и 3-й подходы.

В статистич. моделировании принято использовать случайные числа, кот-е наз генераторами. Обычно используют генератор случ чисел равномерно распределенных на диапазоне от 0 до 1. Имея такой генератор можно строить все другие последовательности. Распределение наз равномерным если вероятность появления на любом из отрезков равновероятна. Вероятность на отрезке прямопропорциональна длине отрезка.

Псевдослучайные числа отличаются от случайных тем, что они не случайные, но очень похожи на случайные, фактически они генерируются по формуле:.

xi+1 = f (xi, xi-1,…)

Псевдослучайная последовательность всё время одна и та же, повторяется, её менять можно только меняя точку входа.Как правило, в псевдослучайной последовательности существует период Т, т.е. через период элемент повторяется: xi+Т = xi. Этот период должен быть больше чем длина последовательности. Последействие выражается в том, что есть корреляция между элементами. Корреляция – это зависимость между двумя последовательностями случайных чисел, определяется коэффициентом корреляции.Для построения генератора равномерно распределенной пос-ти дейст-х чисел от 0 до 1 исполь. следующие методы:

44

1)аппаратный, в этом мет-е генер-р предст-т из себя отдельный прибор, в кот-м есть источник шума, теплового, квантового или радиоактив-го. Тепловой шум может создавать радиоакт. лампа или полупроводниковый прибор. Однако данный вариант не очень надежен, т.к. накладные шумы от внешней температуры. Источник квантового шума-это туннельный диод . Это самый дешевый способ, есть проблема надежности из-за влияния окружающей среды. Радиоакти-й источник надежно, но дорого. Аппарат создает эл. эмпульсы величина или расстояние м/д кот-ми меняется случ. образом. Далее спец. схема оцифровки превращает этот сигнал в после-ть чисел.

2)табличный, кем-то спец-м образом сгенерированы десятки-тысяч чисел, к-рые проверены и помещены в спец. таблицу, таб. расположена в файле, оттуда мы можем брать начиная с любого места нужную нам пос-ть чисел. Здесь

одна проблема таб. должна быть большой. |

|

|

3)алгоритмический, исполь-ся итерац-я |

фор-ла |

вида |

xin = f (xi , xi − 1,...) по кот-ой выч-ся |

эл-ты |

пос-ти |

псевдослучайных чисел. Псевдослуч-ое число похоже на слу-ое, но опреде-ся всетаки детерминированным процессом т.е. итерац. фор-ой. Изуч-е псевдослуч. чисел показывает, что по сравнению с случ числами у них есть след. недостатки: а)каждый раз генерир-ся одна и таже пость;б) в этой пос-ти есть период Т, такой , что xi + T = xi ; в)в пости есть последействия, т.е. текущий эл-т зависит от предшествующих, хотя для настоящих случ. чисел такой пос-ти не должно быть. Последействие опред-ся спец фуней корреляцией, к-ая опред-т зависим-ть м/д величинами. В тоже время алгоритмический генер. обладает большими достоинстваминет необ-ти покупать спец. прибор, можно всегда сгенирировать столько чисел сколько нужно не занимая места на диске, поэтому ученые стали стали

45

изучать различные генер-ы пытаясь сделать так, чтобы период был очень большим, последействие очень мало, а первая проблема снималась тем, что точка входа в итерац-

ю посл-ть постоянно меняется, т.е.меняется x0 .

Генератор Фон-Неймана. Исторически одним из1-ых был предложен Ф- Ней., но использовал метод середины квадрата. Пусть x0 начальное целое число, ко-ое состоит из 5 цифр. Тогда квадрат этого числа будет содержать 10 цифр, тогда возьмем из середины этого числа 5 цифр. Эти 5 цифр

дадут число x1 . В рез-те такого проц-са получ послед-ть

чисел, кот-ые похожи на случ-ые Þ их можно представить как дробную часть числа распределенную от0 до 1. Однако изуч. этой посл-ти показало, что в ней возник-т проц-ы вырождения. Обычно число приходит к 0 или 1. Поэтому этот мет-д не получил большого распространения.

Линейный конгруэнтный метод. Он сущ. в 2-х вариантах

виде |

смешанного |

|

генератора |

(Леммера) |

xi + 1 = |

(axi + C) mod M |

и мультипликативного |

||

xi + 1 = |

(axi ) mod M . |

Мультипликативный–частный |

||

случай смешанного при с=0. Было док-но, что период такого генератора яв-ся простым сомножителем числа М Þ что М выгоднее выбирать простым числом, чтобы период был больше. Возникла проблема найти такие большие простые числа. Очень удачным оказалось число Мерсонаэто наибольшее простое число, к-ое могло быть записано в 32-х разрядах ЭВМ, т.к. долгое время компью-ы были 32-х разрядными. То число Мерсона стало стандартным 231 − 1 . Кроме числа Мерсона матем-ки исследовали посл-ть при различных значениях а и с , были найдены оптимальные значения а и с.

46

Сдвиговый генератор Таусворта. Выпол. выч-я в таб. приходится не с 10-ми числами, а с двоичными. Поэтому Таусворд предложил модификацию генератора Леммера с учетом двоичных вычислений. На каждом шаге приходится умножать и делить целые числа, что довольно сложно в двоичной системе. Поэтому он предложил заменить эти операции на двоичное умножение и взятие двоичного остатка. Вместо больших чисел в его итерац-х числах получили разряды двоичных чисел 0 или 1. Если брать вместо числа М число 2, то фактическое значение последнего разряда произведения, определяется умножением последних разрядов произведения. Т.о. в методе Таусворда мы фактически вычисляем только 1

разряд |

по |

предыдущему |

|

разряду. |

xk |

= (C1 xk −1 + C2 xk −2 |

+ ... |

в рез- |

|

+ Cn xk −n ) mod 2 |

|

|||

|

|

|||

те действия генератора Таусворда формируется длинная пос-ть 1 и 0. Наилучший период T ≈ 2n − 1 , n –число

разрядов числа С. Далее из этой пос-ти 1 и 0 можно нарезать разных чисел. Данные генераторы были использованы с помощью следующих тестов: 1) тест на равномерность распределения; 2) тест на последействие, использовалась корреляция; 3) выборочный тест; 4) определение периода. Для того, чтобы улучшить качества генератора были созданы спец. методы улучшения кач-ва: метод возмущений и модификация с использованием разных последовательностей.

47

Экспоненциальное. F(x) = |

x |

ρ (t)dt . Пусть у нас есть |

||||||

ò |

|

|||||||

|

|

|

|

|

− ∞ |

|

|

|

случ. величина |

ξ [0;1] - |

равномерно |

распределена. |

|||||

Fξ (x) = P(η < x) òx ρ |

η (t)dt = Fη (x) |

|

||||||

|

|

|

− ∞ |

|

|

|

|

|

ρ |

η |

= λ e− λ t |

F = |

x λ e− λ t dt = - e− λ t |x |

= - e− λ x + 1 |

|||

|

|

η |

ò |

|

|

0 |

|

|

|

|

|

|

0 |

|

|

|

|

− λ x = ln(− F + 1) |

x = − |

1 |

ln(− F + 1) |

|

||||

|

|

|||||||

|

|

|

η |

|

λ |

η |

|

|

|

|

|

|

|

|

|

||

ρ ξ = 1

x

F(x) = 0ò ρ ξ (t)dt = x - 0 = x

xξ |

= |

Fξ , |

η |

= |

|

ξ |

) |

|

|

|

|

|

|

x |

= |

x |

|

|

|

|

g( |

. Мы |

должны |

η |

|

ξ |

, |

||||||||

|

|

|

|

|

|

|

|

|

|

|

|||||||

|

|

|

|

g( |

) |

|

|

|

1 |

|

|

|

|

|

|

|

|

чтобы найти |

|

ξ |

|

η |

|

= - |

ln(ξ + |

1) . Т.о.чтобы |

|||||||||

|

|

|

λ |

||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

получить |

ρ η |

= |

λ e− λ t |

мы |

|

должны |

все |

значения |

ξ |

|

|||||||

преобразовать |

в |

|

η . |

Т.о. |

можно |

получить |

любое |

||||||||||

распределение. Если мы можем найти в явном виде его фун-ю распределения. В данном примере мы получили фор-лу с помощью которой можно получить по равномерному распределению экспоненциальное расп-е,

48

т.е. если xi распределено равномерно на [0;1], то |

|

|

yi |

будут |

||||||||||||

распределяться по экспо-у закону |

yi |

= − |

|

1 |

|

ln (1− |

xi ) . |

|||||||||

|

λ |

|||||||||||||||

|

|

|

|

|

|

|

|

|

[0;∞ |

) |

|

|

|

|||

Нормальное. |

|

− |

(x− x)2 |

, |

A = |

|

|

1 |

|

|

. |

Взять |

||||

ρ (x) = |

|

2 |

|

|

|

|

|

|

|

|||||||

|

|

|

|

|

|

|

|

|||||||||

|

|

|

|

|

2π σ |

|||||||||||

|

Ae |

2σ |

|

|

|

|

|

|

|

|

|

|

|

|||

первообразную от этой фун-и нельзя, но можно воспользося методом сложения посл-ти. Пусть мы с помощью генератора генерируем не 1 пос-ть, а несколько

xi\ , xi\ \ , xi\ \ \ ,... |

|

строим |

сумму. |

|||

|

x| |

+ x|| + x||| + ... |

|

|

||

yi = |

i |

i |

i |

|

, где N-число посл- |

|

|

|

|

|

|||

тей. В соответствии с центр. Теоремой теоремой вероятности, чем больше будет таких пос-тей, тем ближе

распред-е yi будет ближе к нормальному. Для получения

нормального распределения нужно 5 раз сгенерировать равномерно распределенные пос-ти. Затем сложить м/д собой эти пос-ти и найти их среднее.

Произвольное. Метод дистограмм наиболее трудоемкий, но зато позволяет построить любое расп-е, кот-ое задано графиком плотности. Разделим отрезок [a; b] на n равных

частей длиной h = |

|

a − |

b |

. В концах отрезка восстановим |

||||

|

n |

|

||||||

|

|

|

|

|

|

|

|

|

значение |

фун-и, |

это |

будут узлы. |

yi [ai ,bi ] , |

||||

R = ρ (y |

i |

) -высота |

столбика. |

|||||

i |

|

|

|

|

|

|

|

|

49

R = å |

Ri Þ α i = |

Ri |

-относительная |

высота. |

|

R |

|||||

i |

|

|

|

||

å α i |

= 1 Высота |

прямоугольников Ri д.б. |

|||

пропорциональна отрезку [ai ;bi ] . α i |

-вероятность, что |

||||

y [ai ,bi ] отсюда и идея метода дистограмм. Если мы

будем распределять случ.числа по этим отрезкам так, чтобы внутри отрезка вер-ть была равномерна, а м/д

отрезками опред-сь бы вероя-тью α i . Чем больше будет

этих отрезков, тем больше фун-я будет похожа на заданную, т.е. лучше будет аппроксимация.На каждом

отрезке |

|

распределение |

равномерное |

||

y |

i |

= |

a |

+ hx , x [0;1] |

нужно эти отрезки |

|

|

i |

i i |

|

|

переводить по очереди. Отсюда 1-ый вариант послед-но прямоуг-к за прямоуг-ом генерирует эти числа. Возникает проблема, что вер-ть попадания в каждый прямоуг-к разная зависит от высоты Þ кол-во точек которое попадает в каждый прямоуг-к разное и пропорциональное

α i . Мы могли бы опред-ть кол-во точек для каждого

отрезка, если бы знали общее кол-во точек, которое нам потребо-сь, но это известно не всегда. Поэтому предлаг-ся другой способ распределение чисел равномерно. Возьмем отрезок [0;1] разобьем на n частей, но не равных а

пропорциональных α i |

. å α i = 1 Тогда на [0;1] |

50

будут |

отрезки |

[Sk − 1, Sk ],Sk = |

åk α i |

||

|

|

|

|

|

i= 1 |

Sk = Sk − 1 + α |

k , S0 = |

0 |

Þ пусть |

мы |

|

|

|

||||

генерируем случ числа xi равномерно распределенные. Тогда вер-ть того, что xi попаджет на к отрезок будет равна длине этого отрезка α k . Мы получили следующие

yi |

преобразования по |

формуле |

y |

i |

= |

a |

k |

+ hx |

тогда |

||||

|

|

|

|

|

i |

||||||||

y |

k |

[a |

k |

;b ] |

причем вероя-ть |

|

попадания в |

этот |

|||||

|

|

k |

|

|

|

|

|

|

|

|

|

||

отрезок |

равна |

α k . |

Значит, что |

мы |

построили |

||||||||

распределение для |

yi виде дистограмм. |

|

|

|

|

||||||||

51

35.Моделирование потоков случайных событий. Сисмы массового обслуживания. Основные понятия и харки потоков. Класс-ция с-м масс.обс-ния. Оценка осн. Парпметров сис-м обс-ния(очередь, время ожидания)Формула Литтла.

Поток событий- последова-ть случ. событий, следующих одно за друг, в какие-то случ. моменты времени. Напр. поток вызовов на телефонной станции, поток ж.д.составов, поступающих на сортировочную станцию. Поток событ. можно наглядно изобразить рядом точек на оси времени Ot, положение кажд. из них случайно. Событ., образующие поток, сами по себе вероят-ми не обладают; вер-тями облад. др., производные от них события. В реальности события и заявки могут быть 2 видов:

1)однородные–это те заявки, которые всегда одинаковые по виду обслуживания.

2)неоднородные – обслуживаются по разному. При этом

заявки в потоке считаются неодновременными и практически мгновенными. Поток, в кот. не могут быть двух заявок одновременно, назыв. одинарным. Между событиями есть промежутки времени. Если эти промежутки времени строго фиксированы, то такой поток называется регулярным. Если время между событиями меняется случайно, то такой поток называется случайным. Доказано, что любой неоднородный поток может стать однородным, если его время обслуживания соединять с промежутками между событиями. Стационарный поток – это случайный поток, характеристика которого не меняется со временем. Под характеристикой понимается плотность потока λ, которая равна среднему количеству заявок, проходящих за ед. времени. Одинарный поток назыв. ещё простейшим

потоком. Интенсивность потока ( λ )-сред. число

52

событий, приходящееся на ед. времени. Интенс-ть может быть постоянной и зависящей от времени t.

Регулярный поток-когда соб. следуют одно за другим ч/з определенные равные промежутки времени.

Ещё одна характеристика: распределение определяет вероятность того, что событие произойдёт в какой-то промежуток времени.

Пуассоновский поток – это поток без последействия, т.е. вероятность появления события не зависит от предшествующих событий. Этот поток является наиболее случайным из всех возможных. Стационарный пуассоновский поток имеет следующее распределение (которое называется распределением пуасона):Pm(τ)=(λτ)m/m!*e-λτ, где λ – плотность потока; τ – промежуток времени;m – кол-во событий

Если пуассон-ий поток не стационарен,то P0(τ,t0)=am/m!

*e-a.

Функция λ(t) – это функция, которая показывает зав-сть плотности потока от времени для нестационарного режима.В любой фиксированный момент λ(tф)= λф – мгновенная плотность. Совершенно случайным потоком явл. только пуассоновский. Потоки с другим распределением можно представить как сумму случ. и детерминированных потоков. Причём случайная составляющая может представляться как сумма нескольких пуассоновских потоков с различным λ. → пуассоновские потоки должны иметь последействие, т.е. вероятность появления нового события от предшествующих событий.

Поток Пальма – это пуассоновский поток, в кот. на последействие наложены ограничения.Обычно потоки Пальма образуются с пом. потоков Эрланга (они наз. ещё

рекуррентными).Потоки Эрланга можно получить из пуассоновских потоков путём просеивания. Если из потока

53

выбирать каждую вторую заявку, то это поток Эрланга второго порядка, каждую третью – третьего и т.д.Док-но, что чем > порядок потока Эрланга, тем > последействие. При n→∞ получим регулярный поток. Тогда пуассоновский поток это поток Эрланга 1-го порядка. Следует учитывать, что для создания потоков Эрланга испся стационарные потоки. Поэтому стационарный пуассоновский поток называют простейшим.

СМО – это дискретные системы, которые могут быть как стахостические, так и детерминированные. Обычно это стахостические. Обычно СМО решается как имитационная модель. Началом теории СМО было решение задачи Эрланга: в 20-е годы ХХв. в Европе проходил процесс телефонизации. Эрланга телефонная компания попросила решить их проблему.Дано n-абонентов. Все они связаны с телефонной станцией. Проблема возникает, когда абоненты связываются с абонентами другой ТС. Между станциями существует m каналов, каждый канал – это дорогая вещь. Поэтому каналов < абонентов, т.е. m<n и возможна ситуация когда все каналы заняты, тогда абонент получает отказ (сбой) соединения. Фирма попросила определить оптимальное число каналов, чтобы с одной стороны их было поменьше (т.е. стоимость <), а качество соединения удовлетворяло заданным требованиям.