Все задания за 4 курс 7 семестр / Основы теории информации / Методические указания к лабораторной работе № 4. Источник дискретных сообщений

.pdfЛАБОРАТОРНАЯ РАБОТА № 3

«Исследование источника дискретных сообщений»

Цель работы: изучить характеристики источника дискретных сообщений

(ИДС). Овладеть практическими навыками определения характеристик заданной модели ИДС.

Краткие теоретические сведения

Источник информации или сообщения - это физический объект, система или явление, формирующие передаваемое сообщение. Само сообщение - это значение или изменение некоторой физической величины, отражающие состояние объекта (системы или явления). Как правило, первичные сообщения - речь,

музыка, изображения, измерения параметров окружающей среды и т.д. -

представляют собой функции времени неэлектрической природы. С целью передачи по каналу связи эти сообщения преобразуются в электрический сигнал,

изменения которого во времени отображает передаваемое сообщение.

Значительная часть передаваемых сообщений, особенно в последнее время, по своей природе не является сигналами - это массивы чисел, текстовые или иные файлы и тому подобное. Сообщения такого типа можно представить в виде векторов [1].

A a1,a2 ,.....ak ...

Если сигнал представляет собой функцию S(t), принимающую для любого фиксированного значения t, только определенные, наперед заданные значения Sk,

такой сигнал и отображаемое им сообщение называются дискретными.

Множество возможных значений дискретного сообщения (или сигнала) ДС

представляет собой алфавит сообщения. Алфавит сообщения обозначается заглавной буквой, например, А, а в фигурных скобках указываются все его

возможные значения - символы. Число символов алфавита называется объемом

алфавита (K – объем алфавита).

Основными информационными характеристиками источников дискретных сообщений являются:

A ai A 1 i K

1.Число символов алфавита источника A, то есть объем алфавита K;

2.Вероятность выдачи каждого символа ai → P(ai)

3.Количество информации в отдельных символах или собственная информация символа I(ai), единица измерения бит.

4.Энтропия источника Н(А), единица измерения бит.

5.Избыточность источника R(A), единица измерения бит.

6.Производительность источника Н(А)', единица измерения бит/с.

Рассмотрим данные характеристики более подробно. Для сравнения между собой различных источников сообщений необходимо ввести некоторую

количественную меру, которая дала бы возможность объективно оценить

информацию, содержащуюся в сообщении. Такая мера впервые была введена K.

Шенноном в 1948 г. Рассмотрим основы информационного подхода Шеннона.

Всякая информация получается потребителем после приема сообщения, то есть в результате опыта. Сообщение, получаемое на приемной стороне, несет полезную информацию лишь в том случае, если имеется неопределенность относительно состояния источника. Если опыт может закончиться только одним исходом и наблюдатель заранее знает исход опыта, то по его результату он не получает никакой информации. Например, если сообщат, что солнце всходит на востоке, то никакой информации это сообщение не принесет, поскольку все знают, что это верно. В таком событии, как ежедневный восход солнца на востоке, нет ничего неопределенного, вероятность этого события равна единице и

количество информации, приносимое сообщением о таком событии, равно нулю.

Информация появится лишь тогда, когда источник будет иметь по крайней мере более одного возможного состояния [1].

Пусть алфавит источника содержит символы A=(a1, a2,…ai…ak). Символы алфавита появляются на выходе источника последовательно во времени,

статистически независимо и случайно в соответствии с заданным распределением вероятностей: P(a1), P(a2), …P(ai)….P(aK). Такой источник называют источником без памяти с конечным дискретным алфавитом. Сообщения, вырабатываемые таким источником, называются простыми сообщениями.

В каждом элементарном символе сообщения ai для его получателя содержится некоторая информация. До того, как связь состоялась, у получателя всегда имеется большая или меньшая неопределенность относительно того, какой символ сообщения ai из числа возможных будет передан. Совершенно очевидно,

что степень этой неопределенности, или неожиданности передачи ai, зависит от вероятности передачи того или иного символа. Например, если вероятность передачи какого-либо символа ai очень высока, то еще до передачи мы почти наверняка знаем, какой символ будет передан, и его прием не принесет нам почти никакой новой информации [1].

K

P(ai ) 1

i 1

Сумма вероятностей появления символов всегда равна единице.

I(ai ) log2 |

1 |

log |

2 P(ai ) |

|

|||

|

P(ai ) |

|

|

Таким образом, собственная информация I(ai) (количество информации),

содержащейся в элементарном символе сообщении ai, является функцией от вероятности передачи этого символа P(ai) и определяется по формуле:

Определенная таким образом единица измерения информации называется

двоичной единицей, или битом информации. Например, если какой-либо из

элементарных символов сообщения ai может быть выбран из алфавита и передан с вероятностью P(ai) = 1/8, то говорят, что в нем содержится log2(1/8) = 3 бита информации. Иногда в качестве основания логарифма выбирают e, тогда информация измеряется в натуральных единицах, или натах.

K

H(A) P(ai ) log2 P(ai )

i 1

Количество информации, содержащееся в одном элементарном символе сообщении ai, еще никак не характеризует источник. Одни элементарные сообщения могут нести много информации, но передаваться очень редко, другие -

передаваться чаще, но нести меньше информации. Поэтому источник может быть охарактеризован средним количеством информации, приходящимся на одно элементарное сообщение, носящим название энтропия источника и

определяемым следующим образом:

Энтропия – это мера неопределенности в поведении источника дискретных сообщений. Энтропия, как количественная мера информативности источника,

обладает следующими свойствами:

1.Энтропия есть величина вещественная, ограниченная и неотрицательная. Эти ее свойства вытекают из вида выражения для Н(A), а также с учетом того, что 0 <

P(ai) < 1.

2.Энтропия детерминированных сообщений равна нулю, то есть Н(A) = 0, если хотя бы один из символов сообщения имеет вероятность, равную единице.

3.Энтропия максимальна, если символы сообщения ai равновероятны, то есть

P(a1) = P(a2) = ....... P(ak) = 1/K , и тогда

K

Hmax (A) 1K log2 1K log2 K.

i 1

Как видно из последнего выражения, в случае равновероятных символов

сообщения энтропия растет с увеличением объема алфавита источника (ростом

числа символов). При неравновероятных элементарных символах сообщения ai

энтропия, соответственно, уменьшается. Данная формула, не учитывающая случайного характера формирования сообщений, как мера количества информации источника, была предложена Р. Хартли в 1928 г.

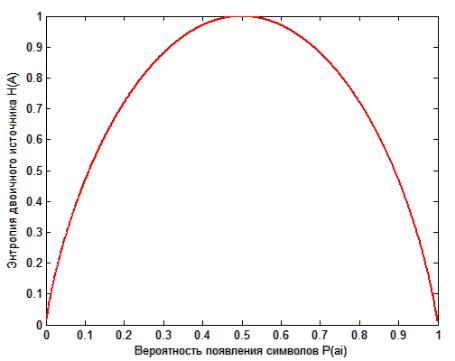

4. Энтропия двоичного источника (K = 2) может изменяться от нуля до единицы.

Действительно, энтропия системы с алфавитом из двух символов a1 и a2

H(A) P(a1)* log2 P(a1) P(a2)* log2 P(a2)

P(a1)* log2 P(a1) {1 P(a1)}* log2{1 P(a1)}.

Из последнего выражения видно, что энтропия равна нулю при P(a1) = 0; P(a2) =

1, или P(a1) = 1; P(a2) = 0; при этом максимум энтропии будет иметь место,

когда P( 1) = P( 2) = 1/2 и ее максимальное значение будет равно 1 бит.

Зависимость энтропии двоичного источника от вероятностей появления его символов приведена на рис. 3.1. Данная зависимость называется функцией Шеннона.

Рис. 3.1. Зависимость энтропии двоичного источника от вероятностей появления его символов

В связи с тем, что реальные источники с одним и тем же размером алфавита могут иметь совершенно различную энтропию, вводят такую характеристику источника, как избыточность. Избыточностью источника называется разность между реальным значением энтропии источника и ее максимальным значением,

определяется по формуле:

R(A) = Hmax(A) - H(A), бит

Относительная избыточность определяется следующим образом:

r(A) 1 H(A)

Hmax (A)

Производительность источника – это среднее количество информации,

выдаваемое источником за секунду

H'(A) H(A),

T

где Т – среднее время передачи одного символа. Единица измерения бит/с.

Для каналов передачи информации вводят аналогичную характеристику –

скорость передачи информации C. Максимальное её значение называется

пропускной способностью канала. Так как производительность источника – это фактически скорость создания информации источником, эта величина не должна быть больше пропускной способности канала передачи

Порядок выполнения лабораторной работы

1.Изучить теоретический материал по теме лабораторной работы. Для самопроверки использовать контрольные вопросы.

2.Выполнить задания в соответствии с вариантом.

3.Составить отчёт о проделанной работе.

Задание 1. Построить модель источника дискретных сообщений, в соответствии с вариантом (см. табл. А1).

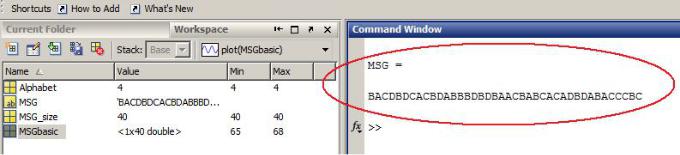

Программа, моделирующая работу ИДС приведена в листинге 3.1.

% Программа моделирования источника дискретных сообщений

clear all;

clc;

%Задаём длину сообщения, выдаваемого источником:

MSG_size = 40;

%Задаём размер алфавита источника:

Alphabet = 4;

% Генерируем и выводим на экран сообщение:

MSGbasic = round(unidrnd(Alphabet,1,MSG_size)+64);

MSG = char(MSGbasic)

Листинг 3.1. Программа моделирования источника дискретных сообщений

Пример сообщения получаемого в результате работы программы приведен на рис 3.2.

Рис. 3.2. Сообщение получаемое в результате работы программы

Задание 2. Определение характеристик ИДС

2.1. Рассчитать характеристики полученного сообщения:

-вероятность появления каждого символа в сообщении;

-собственную информацию каждого символа в сообщении;

-максимальную энтропию источника, достижимую в случае равномерного распределения символов в сообщении;

-реальную энтропию источника;

-абсолютную и относительную избыточность.

2.2. Построить гистограмму распределения вероятностей появления символов в сообщении.

Задание 3.

3.1. Оставляя параметры модели неизменными повторить эксперимент 3 раза,

рассчитать характеристики и занести полученные результаты в табл. 3.1.

3.2. Увеличить длину сообщения источника на 20 символов и провести эксперимент. Повторить п. 3.2. еще 2 раза. Результаты занести в табл. 3.1.

3.3.Увеличить размер алфавита источника на 2 символа и провести эксперимент. Повторить п. 3.3. еще 2 раза. Результаты занести в табл. 3.1.

3.4.Проанализировать полученные результаты и сделать вывод.

Табл. 3.1.

№ |

Размер |

Длина |

H, бит. |

Hmax, бит. |

R, бит. |

|

алфавита |

||||||

опыта |

сообщения |

|||||

|

источника |

|

|

|

|

|

1 |

N |

M |

|

|

|

|

2 |

N |

M |

|

|

|

|

3 |

N |

M |

|

|

|

|

4 |

N |

M |

|

|

|

|

5 |

N |

M + 20 |

|

|

|

|

6 |

N |

M + 40 |

|

|

|

|

7 |

N |

M + 60 |

|

|

|

|

8 |

N + 2 |

M |

|

|

|

|

9 |

N + 4 |

M |

|

|

|

|

10 |

N + 6 |

M |

|

|

|

где N и M, соответственно исходные размер алфавита и длина сообщения из

табл. 3.2.

Задание 4. Построение графиков

Используя данные табл. 3.1 построить графики зависимости максимальной энтропии источника от размера алфавита и длины сообщения, реальной энтропии от размера алфавита и длины сообщения.

Контрольные вопросы по лабораторной работе

1.Чем источник дискретных сообщений отличается от непрерывного (аналогового) источника?

2.Что представляет собой сообщение дискретного источника?

3.Для чего применяется такая характеристика как собственная информация символа в сообщении?

4.Если символ в сообщения появляется с вероятностью равной 1 (P(a) = 1), то говорят, что сообщение не несёт никакой информации. Поясните смысл данного утверждения.

5.Дайте определение энтропии источника. Чем максимальная энтропия отличается от реальной?

6.Почему функция Шеннона имеет максимум при P(a1) = P(a2) = 0.5.

7.Как определить производительность источника дискретных сообщений?