- •В чем заключается отличие интеллектуальной системы от классической неинтеллектуальной сау (состоящей из п, и-регуляторов и пр.)? [вверх]

- •Являются ли инфузория-туфелька интеллектуальной системой? Поясните свое решение. [вверх]

- •Назовите несколько императивных и декларативных языков программирования. [вверх]

- •Дайте определение понятию «Знание» в контексте сии. [вверх]

- •Назовите 4 составных элемента логической модели представления знаний. [вверх]

- •Охарактеризуйте суть сетевой модели представления знаний. [вверх]

- •Как выглядит предложение-продукция в продукционной модели знаний? [вверх]

- •Дайте определение понятию «фрейм» в рамках фреймовой мпз. [вверх]

- •Представьте графически с помощью сетевой мпз область знаний «Подразделения сф ОмГту». [вверх]

- •Дайте определение понятию «предикат». [вверх]

- •Дайте определение понятию «факт» с точки зрения логики. [вверх]

- •Какие правила и методы используются в логической мпз для получения истинного высказывания. [вверх]

- •Дайте определение понятию «силлогизм». [вверх]

- •В чем заключается правило резолюций. [вверх]

- •Какие методы ии можно отнести к направлению биологического моделирования. [вверх]

- •Назовите и дайте определение двум основным подобластям направления в ии, связанного с накоплением и использованием знаний. [вверх]

- •В чем состоит задача классификации? [вверх]

- •Назовите и раскройте суть двух основных этапов формулирования задачи для решения её методами ии. [вверх]

- •Назовите причины возникновения и развития теории нечетких множеств и нечеткой логики. [вверх]

- •Укажите отличия нечеткого подмножества от четкого. [вверх]

- •Раскройте понятие функции принадлежности (характеристической функции). [вверх]

- •Дайте определению нейрону с математической точки зрение и опишите его в виде уравнения (укажите смысл используемых переменных). [вверх]

- •Для чего используется дополнительный вход нейрона обозначаемый как w0x0 (или t). [вверх]

- •Перечислите модификации линейной передаточной функции и охарактеризуйте их. [вверх]

- •Охарактеризуйте пороговую передаточную функцию и изобразите её график. [вверх]

- •Назовите 2 преимущества сигмоидальной передаточной функции и функции гиперболического тангенса над линейной и пороговой передаточными функциями. [вверх]

- •Изобразите нейрон реализующий операцию дизъюнкции. [вверх]

- •Перечислите 4-ре категории инс характеризующие способ взаимосвязи нейронов. [вверх]

- •На какие два основных класса разделяют инс. Опишите эти классы. [вверх]

- •В каком случае многослойная нс эквивалентна однослойной. [вверх]

- •В чем заключается цель обучения инс? [вверх]

- •Перечислите 3 парадигмы обучения инс и кратко их охарактеризуйте. [вверх]

- •Перечислите типы элементов составляющих перцептрон и опишите порядок их взаимодействия. [вверх]

- •Дайте общее определение алгоритма обучения инс (системы подкрепления). [вверх]

- •Запишите правило Хебба об обучении инс. [вверх]

- •О чем говорит теорема сходимости перцептрона, описанная и доказанная ф. Розенблаттом? [вверх]

- •Какие задачи решают с помощью самоорганизующихся карт Кохонена. [вверх]

- •Запишите базовое рекуррентное уравнение, вычисляющее текущие веса синапсов n-го слоя инс. [вверх]

- •На чём основывается способность нейронной сети к прогнозированию и сжатию данных. [вверх]

- •Какими характеристиками обладает инс в отличие от вм фон Неймана. [вверх]

- •Какая теорема лежит в основе генетических алгоритмов, и что она доказывает? [вверх]

- •Дайте определение понятию «эволюционные алгоритмы». [вверх]

- •Дайте определение понятию «генетические алгоритмы». [вверх]

- •Опишите шаги работы генетического алгоритма. [вверх]

- •Что определение «функции приспособленности» и укажите какую роль она играет в га. [вверх]

- •Назовите и опишите генетические операции, с помощью которых происходит получение новых решений в га. [вверх]

- •Перечислите критерии остановки генетического алгоритма. [вверх]

- •Назовите несколько областей применения генетических алгоритмов. [вверх]

- •Дайте определение понятию «экспертные системы». [вверх]

- •Изобразите структуру типичной экспертной системы. [вверх]

- •Что является ядром и самым важным компонентом экспертной системы? [вверх]

- •Зачем нужен инженер по знаниям при создании экспертной системы? [вверх]

- •В каких режимах может работать экспертная система, кратко охарактеризуйте их. [вверх]

- •Перечислите этапы разработки экспертная система и кратко охарактеризуйте их. [вверх]

Перечислите типы элементов составляющих перцептрон и опишите порядок их взаимодействия. [вверх]

Перцептрон Розенблатта

Это математическая и компьютерная модель восприятия информации мозгом (кибернетическая модель мозга), предложенная Фрэнком Розенблаттом в 1957 году и реализованная в виде электронной машины «Марк-1» в 1960 году. Перцептрон стал одной из первых моделей нейросетей, а «Марк-1» — первым в мире нейрокомпьютером.

Перцептрон состоит из трёх типов элементов, а именно: поступающие от сенсоров сигналы передаются ассоциативным элементам, а затем реагирующим элементам. Таким образом, перцептроны позволяют создать набор «ассоциаций» между входными стимулами и необходимой реакцией на выходе.

Перцептроны могут быть классифицированы как искусственные нейронные сети:

с одним скрытым слоем;

с пороговой передаточной функцией;

с прямым распространением сигнала.

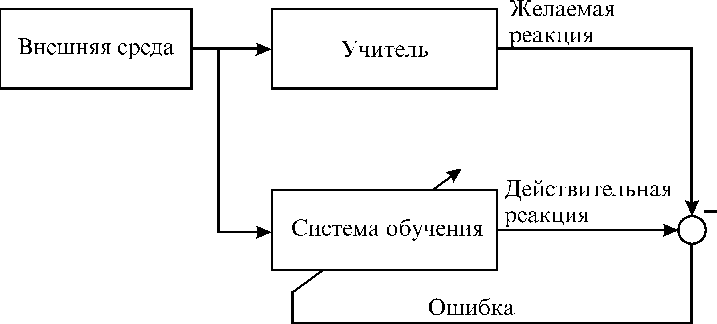

Обучение с учителем

Классический метод обучения перцептрона — это метод коррекции ошибки. Он представляет собой такой вид обучения с учителем, при котором вес связи не изменяется до тех пор, пока текущая реакция перцептрона остается правильной. При появлении неправильной реакции вес изменяется на единицу, а знак (+/-) определяется противоположным от знака ошибки.

Допустим, мы хотим обучить перцептрон разделять два класса объектов так, чтобы при предъявлении объектов первого класса выход перцептрона был положителен (+1), а при предъявлении объектов второго класса — отрицательным (−1). Для этого выполним следующий алгоритм:

1. Случайным образом выбираем пороги для A-элементов и устанавливаем связи S—A (далее они изменяться не будут).

2. Начальные коэффициенты wi полагаем равными нулю.

3. Предъявляем обучающую выборку: объекты (например, круги либо квадраты) с указанием класса, к которым они принадлежат.

– показываем перцептрону объект первого класса. При этом некоторые A-элементы возбудятся. Коэффициенты wi, соответствующие этим возбуждённым элементам, увеличиваем на 1.

– предъявляем объект второго класса и коэффициенты wi тех A-элементов, которые возбудятся при этом показе, уменьшаем на 1.

4. Обе части шага 3 выполним для всей обучающей выборки. В результате обучения сформируются значения весов связей wi.

Теорема сходимости перцептрона, описанная и доказанная Ф. Розенблаттом, показывает, что элементарный перцептрон, обучаемый по такому алгоритму, независимо от начального состояния весовых коэффициентов и последовательности появления стимулов всегда приведет к достижению решения за конечный промежуток времени.

Обучение без учителя

Кроме классического метода обучения перцептрона Розенблатт также ввёл понятие об обучении без учителя, предложив следующий способ обучения:

Альфа-система подкрепления – это система подкрепления, при которой веса всех активных связей cij, которые ведут к элементу uj, изменяются на одинаковую величину r, а веса неактивных связей за это время не изменяются.

Затем, с разработкой понятия многослойного перцептрона, альфа-система была модифицирована и её стали называть дельта-правило. Модификация была проведена с целью сделать функцию обучения дифференцируемой (например, сигмоидной), что в свою очередь нужно для применения метода градиентного спуска, благодаря которому возможно обучение более одного слоя.

Дельта-правило – метод обучения перцептрона по принципу градиентного спуска по поверхности ошибки. Дельта-правило развилось из первого и второго правил Хебба. Его дальнейшее развитие привело к созданию метода обратного распространения ошибки.

Метод обратного распространения ошибки

Для обучения многослойных сетей рядом учёных, в том числе Д. Румельхартом, был предложен градиентный алгоритм обучения с учителем, проводящий сигнал ошибки, вычисленный выходами перцептрона, к его входам, слой за слоем. Сейчас это самый популярный метод обучения многослойных перцептронов. Его преимущество в том, что он может обучить все слои нейронной сети, и его легко просчитать локально. Однако этот метод является очень долгим, к тому же, для его применения нужно, чтобы передаточная функция нейронов была дифференцируемой. При этом в перцептронах пришлось отказаться от бинарного сигнала, и пользоваться на входе непрерывными значениями.

В общем случае задача обучения НС сводится к нахождению некой функциональной зависимости Y=F(X) где X – входной, а Y – выходной векторы. В общем случае такая задача, при ограниченном наборе входных данных, имеет бесконечное множество решений. Для ограничения пространства поиска при обучении ставится задача минимизации целевой функции ошибки НС, которая находится по методу наименьших квадратов..