- •В чем заключается отличие интеллектуальной системы от классической неинтеллектуальной сау (состоящей из п, и-регуляторов и пр.)? [вверх]

- •Являются ли инфузория-туфелька интеллектуальной системой? Поясните свое решение. [вверх]

- •Назовите несколько императивных и декларативных языков программирования. [вверх]

- •Дайте определение понятию «Знание» в контексте сии. [вверх]

- •Назовите 4 составных элемента логической модели представления знаний. [вверх]

- •Охарактеризуйте суть сетевой модели представления знаний. [вверх]

- •Как выглядит предложение-продукция в продукционной модели знаний? [вверх]

- •Дайте определение понятию «фрейм» в рамках фреймовой мпз. [вверх]

- •Представьте графически с помощью сетевой мпз область знаний «Подразделения сф ОмГту». [вверх]

- •Дайте определение понятию «предикат». [вверх]

- •Дайте определение понятию «факт» с точки зрения логики. [вверх]

- •Какие правила и методы используются в логической мпз для получения истинного высказывания. [вверх]

- •Дайте определение понятию «силлогизм». [вверх]

- •В чем заключается правило резолюций. [вверх]

- •Какие методы ии можно отнести к направлению биологического моделирования. [вверх]

- •Назовите и дайте определение двум основным подобластям направления в ии, связанного с накоплением и использованием знаний. [вверх]

- •В чем состоит задача классификации? [вверх]

- •Назовите и раскройте суть двух основных этапов формулирования задачи для решения её методами ии. [вверх]

- •Назовите причины возникновения и развития теории нечетких множеств и нечеткой логики. [вверх]

- •Укажите отличия нечеткого подмножества от четкого. [вверх]

- •Раскройте понятие функции принадлежности (характеристической функции). [вверх]

- •Дайте определению нейрону с математической точки зрение и опишите его в виде уравнения (укажите смысл используемых переменных). [вверх]

- •Для чего используется дополнительный вход нейрона обозначаемый как w0x0 (или t). [вверх]

- •Перечислите модификации линейной передаточной функции и охарактеризуйте их. [вверх]

- •Охарактеризуйте пороговую передаточную функцию и изобразите её график. [вверх]

- •Назовите 2 преимущества сигмоидальной передаточной функции и функции гиперболического тангенса над линейной и пороговой передаточными функциями. [вверх]

- •Изобразите нейрон реализующий операцию дизъюнкции. [вверх]

- •Перечислите 4-ре категории инс характеризующие способ взаимосвязи нейронов. [вверх]

- •На какие два основных класса разделяют инс. Опишите эти классы. [вверх]

- •В каком случае многослойная нс эквивалентна однослойной. [вверх]

- •В чем заключается цель обучения инс? [вверх]

- •Перечислите 3 парадигмы обучения инс и кратко их охарактеризуйте. [вверх]

- •Перечислите типы элементов составляющих перцептрон и опишите порядок их взаимодействия. [вверх]

- •Дайте общее определение алгоритма обучения инс (системы подкрепления). [вверх]

- •Запишите правило Хебба об обучении инс. [вверх]

- •О чем говорит теорема сходимости перцептрона, описанная и доказанная ф. Розенблаттом? [вверх]

- •Какие задачи решают с помощью самоорганизующихся карт Кохонена. [вверх]

- •Запишите базовое рекуррентное уравнение, вычисляющее текущие веса синапсов n-го слоя инс. [вверх]

- •На чём основывается способность нейронной сети к прогнозированию и сжатию данных. [вверх]

- •Какими характеристиками обладает инс в отличие от вм фон Неймана. [вверх]

- •Какая теорема лежит в основе генетических алгоритмов, и что она доказывает? [вверх]

- •Дайте определение понятию «эволюционные алгоритмы». [вверх]

- •Дайте определение понятию «генетические алгоритмы». [вверх]

- •Опишите шаги работы генетического алгоритма. [вверх]

- •Что определение «функции приспособленности» и укажите какую роль она играет в га. [вверх]

- •Назовите и опишите генетические операции, с помощью которых происходит получение новых решений в га. [вверх]

- •Перечислите критерии остановки генетического алгоритма. [вверх]

- •Назовите несколько областей применения генетических алгоритмов. [вверх]

- •Дайте определение понятию «экспертные системы». [вверх]

- •Изобразите структуру типичной экспертной системы. [вверх]

- •Что является ядром и самым важным компонентом экспертной системы? [вверх]

- •Зачем нужен инженер по знаниям при создании экспертной системы? [вверх]

- •В каких режимах может работать экспертная система, кратко охарактеризуйте их. [вверх]

- •Перечислите этапы разработки экспертная система и кратко охарактеризуйте их. [вверх]

Дайте общее определение алгоритма обучения инс (системы подкрепления). [вверх]

Важным свойством любой нейронной сети является способность к обучению. Розенблатт пытался классифицировать различные алгоритмы обучения перцептрона, называя их системами подкрепления.

Система подкрепления - это любой набор правил, на основании которых можно изменять с течением времени матрицу взаимодействия (или состояние памяти) перцептрона.

Описывая эти системы подкрепления и уточняя возможные их виды, Розенблатт основывался на идеях Д. Хебба об обучении, которые можно перефразировать в следующее правило, состоящее из двух частей:

Если два нейрона по обе стороны синапса (соединения) активизируются одновременно (то есть синхронно), то прочность этого соединения возрастает.

Если два нейрона по обе стороны синапса активизируются асинхронно, то такой синапс ослабляется или вообще отмирает.

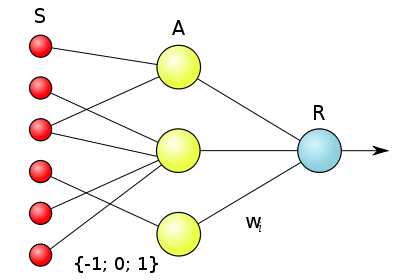

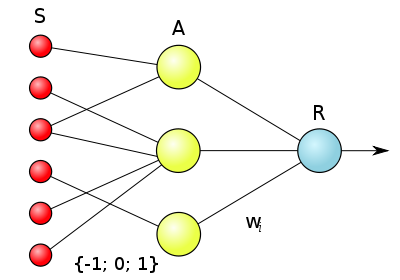

Логическая схема элементарного перцептрона. Веса S—A связей могут иметь значения −1, +1 или 0 (то есть отсутствие связи). Веса A—R связей W могут быть любыми.

Запишите правило Хебба об обучении инс. [вверх]

Описывая эти системы подкрепления и уточняя возможные их виды, Розенблатт основывался на идеях Д. Хебба об обучении, которые можно перефразировать в следующее правило, состоящее из двух частей:

Если два нейрона по обе стороны синапса (соединения) активизируются одновременно (то есть синхронно), то прочность этого соединения возрастает.

Если два нейрона по обе стороны синапса активизируются асинхронно, то такой синапс ослабляется или вообще отмирает.

Логическая схема элементарного перцептрона. Веса S—A связей могут иметь значения −1, +1 или 0 (то есть отсутствие связи). Веса A—R связей W могут быть любыми.

О чем говорит теорема сходимости перцептрона, описанная и доказанная ф. Розенблаттом? [вверх]

Теорема сходимости перцептрона, описанная и доказанная Ф. Розенблаттом, показывает, что элементарный перцептрон, обучаемый по такому алгоритму, независимо от начального состояния весовых коэффициентов и последовательности появления стимулов всегда приведет к достижению решения за конечный промежуток времени.

Какие задачи решают с помощью самоорганизующихся карт Кохонена. [вверх]

Самоорганизующаяся карта Кохонена

Такие сети представляют собой соревновательную нейронную сеть с обучением без учителя, выполняющую задачу визуализации и кластеризации. Является методом проецирования многомерного пространства в пространство с более низкой размерностью (чаще всего, двумерное), применяется также для решения задач моделирования, прогнозирования и др. Является одной из версий нейронных сетей Кохонена. Самоорганизующиеся карты Кохонена служат, в первую очередь, для визуализации и первоначального («разведывательного») анализа данных.

Сигнал в сеть Кохонена поступает сразу на все нейроны, веса соответствующих синапсов интерпретируются как координаты положения узла, и выходной сигнал формируется по принципу «победитель забирает всё» — то есть ненулевой выходной сигнал имеет нейрон, ближайший (в смысле весов синапсов) к подаваемому на вход объекту. В процессе обучения веса синапсов настраиваются таким образом, чтобы узлы решетки «располагались» в местах локальных сгущений данных, то есть описывали кластерную структуру облака данных, с другой стороны, связи между нейронами соответствуют отношениям соседства между соответствующими кластерами в пространстве признаков.

Удобно рассматривать такие карты как двумерные сетки узлов, размещенных в многомерном пространстве. Изначально самоорганизующаяся карта представляет собой сетку из узлов, соединенный между собой связями. Кохонен рассматривал два варианта соединения узлов — в прямоугольную и гексагональную сетку — отличие состоит в том, что в прямоугольной сетке каждый узел соединен с 4-мя соседними, а в гексагональной — с 6-ю ближайшими узлами. Для двух таких сеток процесс построения сети Кохонена отличается лишь в том месте, где перебираются ближайшие к данному узлу соседи.

Начальное вложение сетки в пространство данных выбирается произвольным образом. В авторском пакете SOM_PAK предлагаются варианты случайного начального расположения узлов в пространстве и вариант расположения узлов в плоскости. После этого узлы начинают перемещаться в пространстве согласно следующему алгоритму:

1. Случайным образом выбирается точка данных x.

2. Определяется ближайший к x узел карты (BMU — Best Matching Unit).

3. Этот узел перемещается на заданный шаг по направлению к x. Однако, он перемещается не один, а увлекает за собой определенное количество ближайших узлов из некоторой окрестности на карте. Из всех двигающихся узлов наиболее сильно смещается центральный — ближайший к точке данных — узел, а остальные испытывают тем меньшие смещения, чем дальше они от BMU. В настройке карты различают два этапа — этап грубой (ordering) и этап тонкой (fine-tuning) настройки. На первом этапе выбираются большие значения окрестностей и движение узлов носит коллективный характер — в результате карта «расправляется» и грубым образом отражает структуру данных; на этапе тонкой настройки радиус окрестности равен 1-2 и настраиваются уже индивидуальные положения узлов. Кроме этого, величина смещения равномерно затухает со временем, то есть она велика в начале каждого из этапов обучения и близка к нулю в конце.

4. Алгоритм повторяется определенное число эпох (понятно, что число шагов может сильно изменяться в зависимости от задачи).