- •Основные понятия математической статистики. Теоретические и эмпирические оценки начальных и центральных моментов.

- •Основные понятия математической статистики. Теоретические и эмпирические оценки ковариационных и корреляционных моментов.

- •Основные понятия математической статистики. Теоретические и эмпирические оценки автокорреляции, автокорреляционное расстояние.

- •Методы многопараметрического анализа. Задача кластерного анализа. Методы древовидной кластеризации. Форма представления результатов.

- •Методы многопараметрического анализа. Задача кластерного анализа. Метод k-средних. Форма представления результатов.

- •Методы многопараметрического анализа. Задача кластерного анализа. Алгоритм clope: критерий разделения на кластеры, градиент, функция стоимости.

- •Методы многопараметрического анализа. Задача кластерного анализа. Алгоритм clope: этапы алгоритма кластеризации, задача кластеризации по алгоритму, вычислительная сложность алгоритма.

- •Методы многопараметрического анализа. Задача кластерного анализа. Меры расстояний между объектами (метрики).

- •Методы многопараметрического анализа. Задача кластерного анализа. Проверка достоверности кластеризации: критерии, дискриминантный анализ.

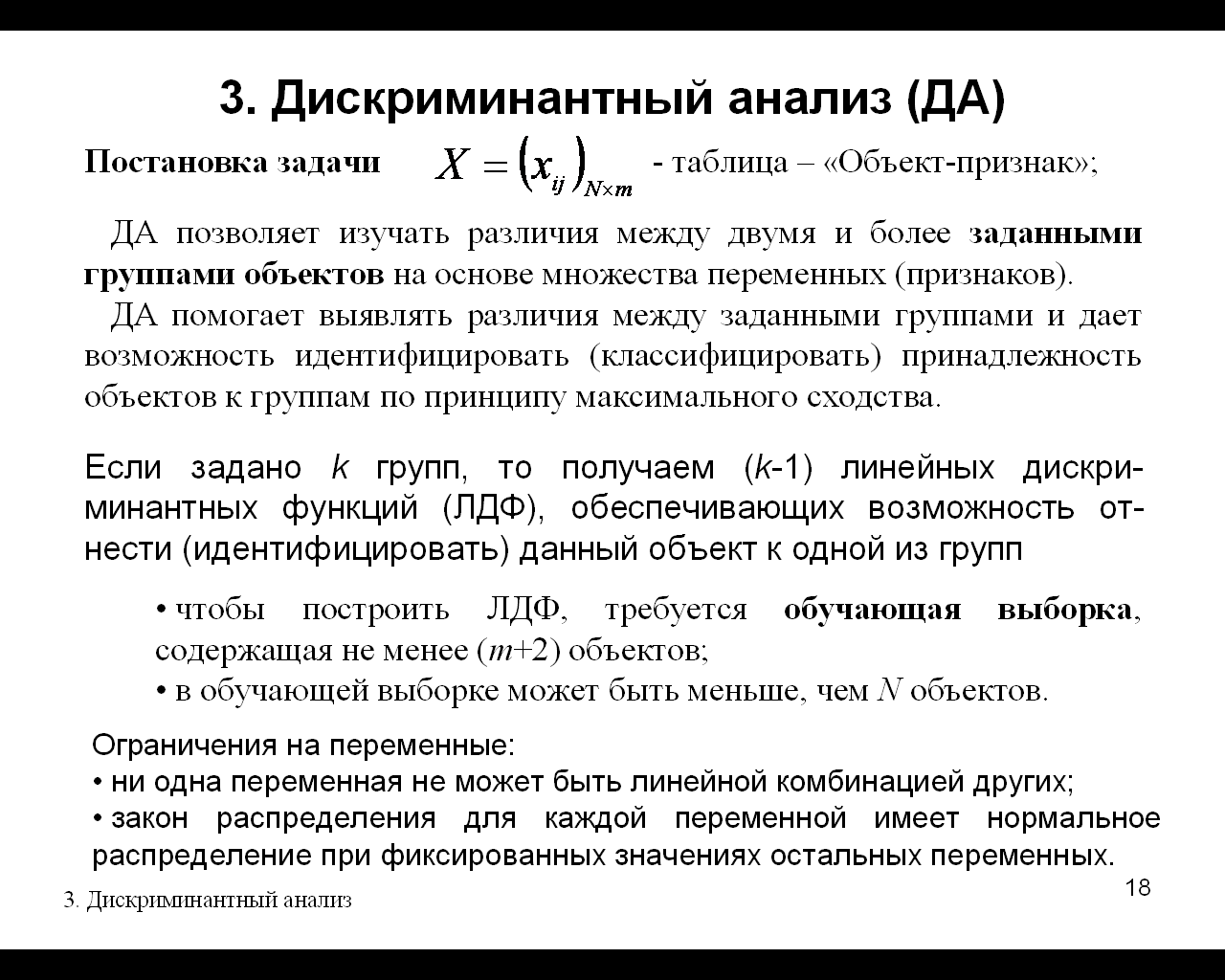

- •Методы многопараметрического анализа. Задача дискриминантного анализа (да). Ограничения на исходные данные. Применение функции Фишера и расстояния Махаланобиса в да

- •Методы многопараметрического анализа. Модели дискриминантного анализа (да): стандартная, пошаговый да с включением и исключением, форма представления результатов, критерий Уилкса

- •Методы многопараметрического анализа. Модель факторного анализа. Факторные нагрузки, общности и общий вклад фактора

- •Методы многопараметрического анализа. Модель факторного анализа. Задача о выборе числа факторов, критерии Кайзера и «каменистой осыпи».

- •Методы многопараметрического анализа. Модель факторного анализа. Вращение факторной структуры, остаточные корреляции

- •Статистические методы. Вычисление m-мерного интеграла по методу Монте-Карло. Условия, при которых возможен поиск решения. Зависимость абсолютной погрешности от количества испытаний

-

Методы многопараметрического анализа. Задача кластерного анализа. Алгоритм clope: критерий разделения на кластеры, градиент, функция стоимости.

-

Методы многопараметрического анализа. Задача кластерного анализа. Алгоритм clope: этапы алгоритма кластеризации, задача кластеризации по алгоритму, вычислительная сложность алгоритма.

Пусть имеется база транзакций D, состоящая из множества транзакций {t1,t2,…,tn}. Каждая транзакция есть набор объектов {i1,…,im}. Множество кластеров {C1,…,Ck} есть разбиение множества {t1,…,tn}, такое, что C1 … Ck={t1,…,tn} и Ci <> ^Сi Cj = 1<=i, j<=k. Каждый элемент Ci называется кластером, n, m, k – количество транзакций, количество объектов в базе транзакций и число кластеров соответственно.

Каждый кластер C имеет следующие характеристики:

|

D(C)

– множество уникальных объектов;

Occ(i,C)

– количество вхождений (частота)

объекта i в кластер C;

|

Гистограммой кластера C называется графическое изображение его расчетных характеристик: по оси OX откладываются объекты кластера в порядке убывания величины Occ(i,C), а сама величина Occ(i,C) – по оси OY (рис. 2).

Рисунок

2. Иллюстрация гистограммы кластера

Рисунок

2. Иллюстрация гистограммы кластера

На рис. 2 S(C), равное 8, соответствует площади прямоугольника, ограниченного осями координат и пунктирной линией. Очевидно, что чем больше значение H, тем более "похожи" две транзакции. Поэтому алгоритм должен выбирать такие разбиения, которые максимизируют H.

Однако учитывать одно только значение высоты H недостаточно. Возьмем базу, состоящую из 2х транзакций: {abc, def}. Они не содержат общих объектов, но разбиение {{abc, def}} и разбиение {{abc}, {def}} характеризуются одинаковой высотой H=1. Получается, оба варианта разбиения равноценны. Но если для оценки вместо H(C) использовать градиент G(C)=H(C)/W(C)=S(C)/W(C)2, то разбиение {{abc},{def}} будет лучше (градиент каждого кластера равен 1/3 против 1/6 у разбиения {{abc, def}}).

Обобщив вышесказанное, запишем формулу для вычисления глобального критерия – функции стоимости Profit(C):

|Ci| – количество объектов в i-том кластере, k – количество кластеров, r – положительное вещественное число большее 1.

С помощью параметра r, названного авторами CLOPE коэффициентом отталкивания (repulsion), регулируется уровень сходства транзакций внутри кластера, и, как следствие, финальное количество кластеров. Этот коэффициент подбирается пользователем. Чем больше r, тем ниже уровень сходства и тем больше кластеров будет сгенерировано.

Формальная постановка задачи кластеризации алгоритмом CLOPE выглядит следующим образом: для заданных D и r найти разбиение C: Profit(C,r) -> max.

-

Методы многопараметрического анализа. Задача кластерного анализа. Меры расстояний между объектами (метрики).

![]()

-

Методы многопараметрического анализа. Задача кластерного анализа. Проверка достоверности кластеризации: критерии, дискриминантный анализ.

-

Методы многопараметрического анализа. Задача дискриминантного анализа (да). Ограничения на исходные данные. Применение функции Фишера и расстояния Махаланобиса в да

Дискриминантный анализ позволяет выяснить, действительно ли группы различаются между собой, и каким образом (какие переменные вносят наибольший вклад в имеющиеся различия).

Ограничения: 1- ни одна переменная не может быть линейной комбинацией других переменных. 2-закон распределения для каждой переменной имеет нормальное распределение при фиксированных значениях остальных переменных.

Расстояние Махаланобиса: d(Xi,Xj)=(Xi-Xj)T * S -1 *(Xi-Xj)

где xik , x jk - значения k-й переменной i-го и j-го объекта; Xi , X j - векторы значений переменных у i-го и j-го объектов; S* - общая ковариационная матрица.

линейный дискриминант Фишера

Предположим, что два

наблюдаемых класса имеют средние

![]() и

ковариационные матрицы

и

ковариационные матрицы

![]() .Тогда

для линейной комбинации признаков

.Тогда

для линейной комбинации признаков

![]() средними

будут

средними

будут

![]() ,

а ковариационные матрицы будут иметь

вид

,

а ковариационные матрицы будут иметь

вид

![]() для

для

![]() .Фишер

взял за расстояние между этими

распределениями величину, равную

отношению межклассовой дисперсии к

внутриклассовой:

.Фишер

взял за расстояние между этими

распределениями величину, равную

отношению межклассовой дисперсии к

внутриклассовой:

Эта величина в некотором смысле характерезует соотношение сигнал-шум для разметки классов.Можно показать, что наилучшим образом классы разделимы при

![]() .

.

Если выполняются предположения нормальности и равенства дисперсий, то полученное выше равенство эквивалентно ЛДА.