- •Основные понятия математической статистики. Теоретические и эмпирические оценки начальных и центральных моментов.

- •Основные понятия математической статистики. Теоретические и эмпирические оценки ковариационных и корреляционных моментов.

- •Основные понятия математической статистики. Теоретические и эмпирические оценки автокорреляции, автокорреляционное расстояние.

- •Методы многопараметрического анализа. Задача кластерного анализа. Методы древовидной кластеризации. Форма представления результатов.

- •Методы многопараметрического анализа. Задача кластерного анализа. Метод k-средних. Форма представления результатов.

- •Методы многопараметрического анализа. Задача кластерного анализа. Алгоритм clope: критерий разделения на кластеры, градиент, функция стоимости.

- •Методы многопараметрического анализа. Задача кластерного анализа. Алгоритм clope: этапы алгоритма кластеризации, задача кластеризации по алгоритму, вычислительная сложность алгоритма.

- •Методы многопараметрического анализа. Задача кластерного анализа. Меры расстояний между объектами (метрики).

- •Методы многопараметрического анализа. Задача кластерного анализа. Проверка достоверности кластеризации: критерии, дискриминантный анализ.

- •Методы многопараметрического анализа. Задача дискриминантного анализа (да). Ограничения на исходные данные. Применение функции Фишера и расстояния Махаланобиса в да

- •Методы многопараметрического анализа. Модели дискриминантного анализа (да): стандартная, пошаговый да с включением и исключением, форма представления результатов, критерий Уилкса

- •Методы многопараметрического анализа. Модель факторного анализа. Факторные нагрузки, общности и общий вклад фактора

- •Методы многопараметрического анализа. Модель факторного анализа. Задача о выборе числа факторов, критерии Кайзера и «каменистой осыпи».

- •Методы многопараметрического анализа. Модель факторного анализа. Вращение факторной структуры, остаточные корреляции

- •Статистические методы. Вычисление m-мерного интеграла по методу Монте-Карло. Условия, при которых возможен поиск решения. Зависимость абсолютной погрешности от количества испытаний

-

Основные понятия математической статистики. Теоретические и эмпирические оценки начальных и центральных моментов.

-

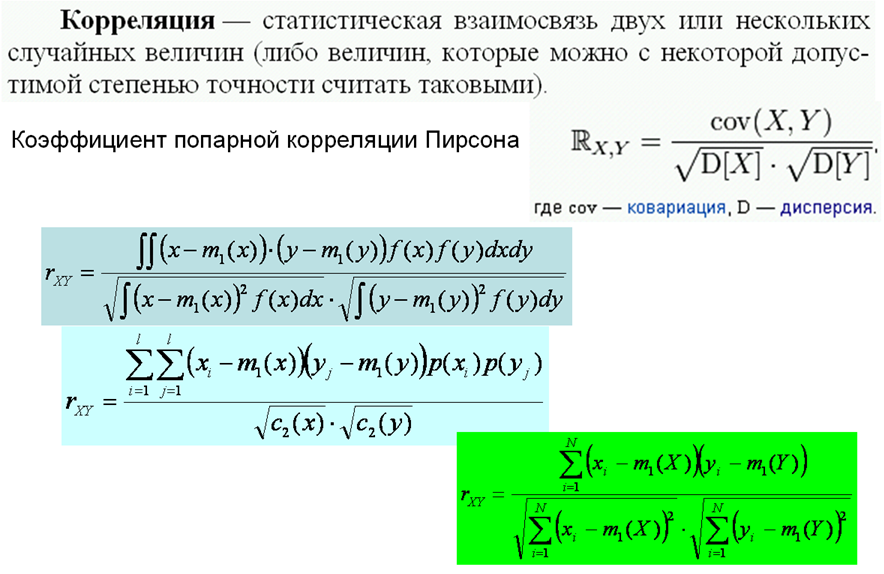

Основные понятия математической статистики. Теоретические и эмпирические оценки ковариационных и корреляционных моментов.

Особую роль играет второй смещенный центральный момент:

![]() ,

,

называемый корреляционным моментом (иначе - "моментом связи")случайных величин Х и Y.

Корреляционный момент есть характеристика системы случайных величин, описывающая, помимо рассеивания величин Х и Y, еще и связь между ними. Для того, чтобы убедиться в этом отметим, что корреляционный момент независимых случайных величин равен нулю.

Заметим, что корреляционный момент характеризует не только зависимость величин, но и их рассеивание. Поэтому для характеристики связи между величинами (Х;Y) в чистом виде переходят от момента Kxy к характеристике

![]() ,

(3)

,

(3)

где σx, σy - средние квадратичные отклонения величин Х и Y. Эта характеристика называется коэффициентом корреляции величин Х и Y.

-

Основные понятия математической статистики. Теоретические и эмпирические оценки автокорреляции, автокорреляционное расстояние.

Автокорреляция - корреляция ряда X с самим собой, с задержкой на k наблюдений.

Пусть X(t) - значение случайного процесса в момент времени t. Если X(t) имеет среднее значение m и дисперсию D, то вычисление коэффициентов автокорреляции r(k) осуществляется следующим образом.

где "E" - это математическое ожидание.

Предполагая порядок процесса k-1, стандартная ошибка r(k) определяется:

![]() N

-

число наблюдений ряда.

N

-

число наблюдений ряда.

В статистике имеется несколько выборочных оценок теоретических значений автокорреляции r(k) процесса по конечному временному ряду из n наблюдений. Наиболее популярной оценкой является нециклический коэффициент автокорреляции с задержкой k:

Наиболее важным из различных коэффициентов автокорреляции является первый - r1, измеряющий тесноту связи между уровнями x(1), x(2) ,..., x(n -1) и x(2), x(3), ..., x(n).

Последовательность коэффициентов корреляции rk , где k 1, 2,...,n , как функция интервала k между наблюдениями называется автокорреляционной функцией (АКФ).

-

Методы многопараметрического анализа. Задача кластерного анализа. Методы древовидной кластеризации. Форма представления результатов.

КА позволяет:

-

Проведение классификации объектов с учетом признаков, отражающих сущность, природу объектов. Решение такой задачи, как правило, приводит к углублению знаний о совокупности классифицируемых объектов;

-

Проверка выдвигаемых предположений о наличии некоторой структуры в изучаемой совокупности объектов, т.е. поиск существующей структуры;

-

Построение новых классификаций для слабоизученных явлений, когда необходимо установить наличие связей внутри совокупности и попытаться привнести в нее структуру.

Задача кластерного анализа

Пусть множество I ={I1, I 2 ,..I n} обозначает n объектов (индивидов), принадлежащих некоторой популяции π I . Пусть m — целое число, меньшее, чем n. Задача кластерного анализа заключается в том, чтобы на основании данных, содержащихся в множестве X, разбить множество объектов I на m кластеров (подмножеств) π 1 , π 2 ,...,π m так, чтобы каждый объект Ii принадлежал одному и только одному подмножеству разбиения и чтобы объекты, принадлежащие одному и тому же кластеру, были сходными, в то время как объекты, принадлежащие разным кластерам, были разнородными (не сходными).

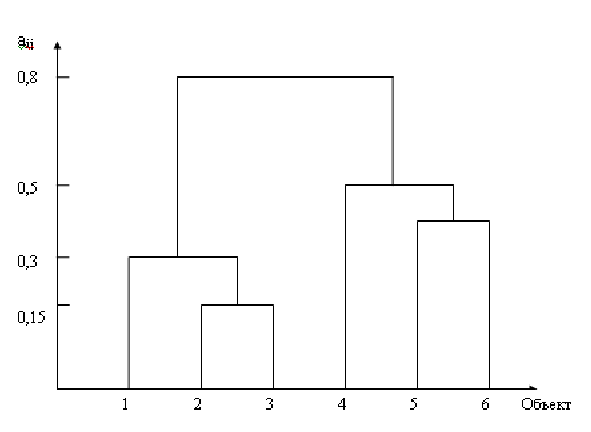

Иерархический кластерный анализ

Из всех методов кластерного анализа самыми распространенными являются иерархические агломеративные методы. Сущность этих методов заключается в том, что на первом шаге каждый объект выборки рассматривается как отдельный кластер. Процесс объединения кластеров происходит последовательно: на основании матрицы расстояний или матрицы сходства объединяются наиболее близкие объекты. Если матрица сходства первоначально имеет размерность m х m, то полностью процесс кластеризации завершается за m – 1 шагов, в итоге все объекты будут объединены в один кластер. Последовательность объединения легко поддается геометрической интерпретации и может быть представлена в виде графа.

Дендрограмма (dendrogram) - древовидная диаграмма, содержащая n уровней, каждый из которых соответствует одному из шагов процесса последовательного укрупнения кластеров. На дендрограмме указываются номера объединяемых объектов и расстояние (или иная мера сходства), при котором произошло объединение.

Дендрограмма на рисунке 1.1 показывает, что в данном случае на первом шаге были объединены в один кластер объекты n2 и n3. Расстояние между ними 0,15. На втором шаге к ним присоединился объект n1. Расстояние от первого объекта до кластера, содержащего объекты n2 и n3, было 0,3 и т. д.

Множество методов иерархического кластерного анализа различается не только используемыми мерами сходства (различия), но и алгоритмами классификации. Из них наиболее распространены метод одиночной связи, метод полных связей, метод средней связи, метод Уорда.