3841

.pdf

Для решения проблемы приобретения знаний нейронные сети дополняются свойством автоматического получения правил нечеткой логики из числовых данных.

Вычислительный процесс представляет собой использование следующих нечетких нейронных сетей. Процесс начинается с разработки "нечеткого нейрона", который основан на распознавании биологических нейронных морфологий согласно механизму обучения. При этом можно выделить следующие три этапа вычислительного процесса нечеткой нейронной сети:

разработка нечетких нейронных моделей на основе биологических нейронов;

модели синоптических соединений, которые вносят неопределенность в нейронные сети;

разработка алгоритмов обучения (метод регулирования синоптических весовых коэффициентов).

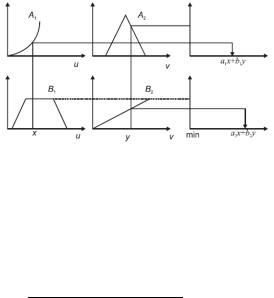

На рис. 2.20 и 2.21 представлены две возможные модели нечетких нейронных систем.

Полученное лингвистическое утверждение интерфейсный блок нечеткой логики преобразует во входной вектор многоуровневой нейронной сети. Нейронная сеть может быть обучена вырабатывать необходимые выходные команды или решения.

Рис. 2.20. Первая модель нечеткой нейронной системы.

Многоуровневая нейронная сеть запускает интерфейсный механизм нечеткой логики.

91

Основные обрабатываемые элементы нейронной сети называют искусственными нейронами, или просто нейронами. Сигнал с нейронных входов считается однонаправленным, направление обозначено стрелкой, то же касается нейронного выходного сигнала.

Рис. 2.21. Вторая модель нечеткой нейронной системы

Простая нейронная сеть представлена на рис. 2.22. Все сигналы и веса задаются вещественными числами.

Рис. 2.22. Простая нейронная сеть Входные нейроны не изменяют входной сигнал, поэто-

му выходные и входные параметры совпадают. |

|

|

||||

При взаимодействии с весовым коэффициентом |

для |

|||||

cигнала получаем результат |

|

, i = 1, ..., n. Элементы |

||||

входной информации |

складываются и в результате дают |

|||||

|

= |

+ |

. |

|

||

входное значение для нейрона: |

|

|

||||

Нейрон |

= + + = |

|

|

|||

применяет свою передаточную функцию f, которая может быть сигмоидальной функцией вида:

92

|

|

|

1 |

|

|

для вычисления |

выходного значения: |

|

|||

( ) = |

1+ |

|

). |

||

Эту |

= ( |

) = ( |

+ + |

||

|

простую нейронную сеть, которая производит ум- |

||||

ножение, сложение и вычисляет сигмоидальную функцию f, назовем стандартной нейронной сетью.

Гибридная нейронная сеть — это нейронная сеть с не-

четкими сигналами и весами, |

и нечеткими |

передаточными |

функциями. Однако: (1) можно |

объединить |

и , используя |

другие непрерывные операции; (2) сложить компоненты с помощью других непрерывных функций; (3) передаточная функция может иметь вид любой другой непрерывной функции.

Обрабатывающий элемент гибридной нейронной сети называется нечетким нейроном.

Следует отметить на то, что все входные, выходные параметры и веса гибридной нейронной сети представляют собой вещественные числа из интервала [0, 1] (рис. 2.23).

Рис. 2.23. Передаточная функция гибридной нейронной сети

Нечеткие нейроны

Определение 1 — нечеткий нейрон И. Сигналы и объединяются оператором максимума и дают:

= { , }, = 1,2.

93

Элементы входной информации объединяются с помощью оператора минимума и в результате дают выходную

информацию нейрона: |

{ , } = |

{ |

|

, |

} |

= |

|

||||

|

|

|

|

. |

Определение 2 — нечеткий нейрон ИЛИ. Сигнал и вес объединяются оператором минимума (рис. 2.24):

={ , }, = 1,2.

Элементы входной информации объединяются с помощью оператора максимума и в результате дают выходную информацию нейрона:

={ , }

Определение 3 — нечеткий нейрон ИЛИ (максимум произведения). Сигнал и вес объединяются оператором умножения:

=, = 1,2.

Элементы входной информации объединяются с помощью оператора максимума и в результате дают выходную информацию нейрона:

= { , }

Рис. 2.24. Передаточная функция нечеткого нейрона ИЛИ

Нечеткие нейроны И и ИЛИ осуществляют стандартные логические операции над значениями множества. Роль соединений заключается в том, чтобы различить конкретные уровни воздействия, которое может быть оказано отдельными входными параметрами на результат их объединения.

94

Известно, что стандартные сети являются универсальными аппроксиматорами, т. е. они могут аппроксимировать любую непрерывную функцию на компактном множестве с любой точностью. Задача с таким результатом является неконструктивной и не дает информации о том, как построить данную сеть.

Гибридные нейронные сети применяются для реализации правил нечеткой логики IF-THEN конструктивным путем.

Хотя гибридные нейронные сети не способны использовать напрямую стандартный алгоритм вывода с обратным ходом, они могут быть обучены методами наискорейшего спуска распознавать параметры функций принадлежности, представляющих собой лингвистические термины в правилах.

Обучение методами спуска

Процедура обучения исправлению ошибок представляет собой всего лишь концепцию. Данная процедура состоит в следующем: в течение обучения входная информация поступает в сеть, где по возможным путям проходит преобразование, выдавая множество выходных значений.

Далее полученные экспериментально выходные значения сравниваются с теоретическими значениями и вычисляется несоответствие. Если экспериментальные и теоретические значения совпадают, то параметры сети не изменяются. Однако если эти значения расходятся, необходимо произвести изменения соединений в соответствии с полученным несоответствием.

Пусть функция f:R→R дифференцируемая, всегда возрастает в направлении своей производной и убывает в проти-

воположном направлении. |

|

|

|

|

В методе спуска для минимизации функции следующий |

||

шаг |

должен удовлетворять условию: |

|

|

|

функции f в точке |

должно быть |

|

|

То есть значение( |

) < ( ) |

|

меньше значения функции на предыдущем шаге . 95

В процедуре обучения исправлению ошибок на каждой итерации метода спуска рассчитывается направление спуска (противоположное направление производной) от точки , следовательно, при достаточно малых η > 0 должно выпол-

няться |

неравенство: |

( − |

|

( )) |

< ( |

,где |

есть |

|

вектор |

|

|

) |

|

||||

|

Пусть функция f:R→R вещественная( ) . |

|

|

|||||

|

В методе спуска последующая= − |

итерация. |

должна |

|||||

удовлетворять условию: |

|

|

|

|

|

|

||

|

То есть значение(функции) |

f в точке |

меньше, чем ее |

|||||

значение в предыдущем приближении< ( |

) . |

|

|

|||||

|

На каждой итерации метода спуска рассчитывается на- |

|||||||

правление спуска в точке |

|

(направление, противоположное |

||||||

направлению производной), это означает, что при достаточно малых η > 0 должно выполняться неравенство:

− ( ) < ( ), где есть вектор

=− ( ).

Нечеткие схемы рассуждений

Пусть экспертная система на основе продукционных правил имеет вид:

1: if x is A1 and y is B1 then z is C12: if x is A2 and y is B2 then z is C2

…………………………………………………………

: |

consequence: z is С |

где и |

— нечеткие: =множества=, i=1, ..., п. |

Процедура получения нечеткой выходной информации такой базы знаний включает следующие три этапа:

найти границы применения каждого правила;

найти выходные параметры каждого правила;

объединить отдельные выходные параметры правил для получения полной выходной информации системы.

96

|

Суджено и Такаги используют следующие правила: |

|||||||||||

|

: |

|

|

|

|

|

|

|

= |

|

+ |

; |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Границы: |

|

|

|

правил |

вычисляются по форму- |

||||||

лам: |

применения |

), |

|

|

= |

|

+ |

; |

||||

затем |

|

= |

( ) |

|

( |

|

= |

( ) |

|

( |

), |

|

|

|

|

|

|

|

|

|

|

||||

|

выходная информация каждого отдельного правила вы- |

|||||||||||

водится из отношения: |

|

|

, |

= |

|

+ |

|

|

|

|||

|

|

= |

+ |

|

|

|

|

|

||||

идействие четкого управления выражается как

+

=+ = +

где |

и — нормированные значения |

и |

по отноше- |

|||||||||

нию к сумме ( + ), т.е.: |

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

рассуждений |

||||

|

|

|

|

|

|

|||||||

|

ПРИМЕР 1.= |

Проиллюстрируем |

метод |

|||||||||

|

+ |

, |

|

= |

|

+ |

|

|

|

|||

Sugeno на следующем примере:

if х is SMALL and у is BIG then o=x–y; if x is BIG and y is SMALL then o=x+y; if x is BIG and у is BIG then o=x-2y,

гдефункциипринадлежностиSMALLи BIGопределяютсятак:

|

1 |

|

|

1 |

|

|

( ) = |

1− |

|

−1 |

1 |

5 |

|

|

4 |

|||||

|

0 |

|

|

|

|

|

|

1 |

(5 − |

1 |

|||

( ) = |

1 − |

) |

1 |

5 |

||

|

4 |

|

||||

|

0 |

|

|

|

|

|

|

|

|

97 |

|

|

|

Предположим, что имеются следующие входные пара-

раметры |

= 3 |

и |

= 3 |

. Каковы будут при этом выходные па- |

||

метры |

|

|

||||

|

системы? |

|

|

|

{0,5,0,5} = 0,5 |

|

Граница применения первого правила: |

||||||

|

= |

|

{ |

(3), |

(3)} = |

|

характерный выходной параметр первого правила:

=− = 3 − 3 = 0.

Граница применения второго правила:

= { (3), |

(3)} = {0,5,0,5} = 0,5 |

характерный выходной параметр второго правила:

=− = 3+3 = 6

Рис. 2.25. Выходная информация правила

Граница применения третьего правила:

= { (3), (3)} = {0,5,0,5} = 0,5

характерный выходной параметр третьего правила:

=+2 = 3+6 = 9.

выходной параметр системы, o, вычисляется из уравнения:

= 0 0,5+6 0,5+9 0,5 1,5

98

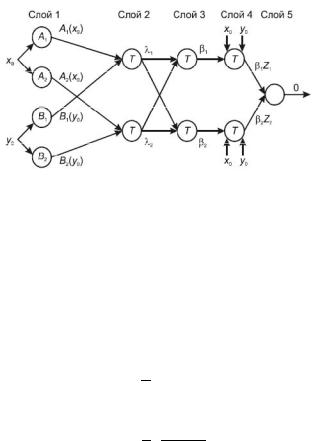

В качестве примера покажем способ построения гибридной нейронной сети (названной Jang-адаптивной сетью), которая по функциональности является эквивалентом интерфейсного механизма Суджено.

Гибридная нейронная сеть, по вычислительным алгоритмам идентичная механизму Суджено, отражена на рис.2.26.

Рис. 2.26. Гибридная нейронная сеть Для простоты будем учитывать только два правила и

два лингвистических значения для каждого входного параметра.

Уровень 1. Выходной параметр узла представляет собой степень соответствия данного входного параметра лингвистической метке, связанной с этим узлом. Обычно выбираются колоколообразные функции принадлежности:

( ) = |

− |

1 |

|

− |

|

, |

|

2 |

|

|

|

||||

|

) = |

|

1 |

− |

2 |

2 |

|

( |

−2 |

2 |

|

, |

|||

определяющие лингвистические термины, где |

{ , , , } |

- множество параметров. |

|

99 |

|

По мере изменения значений этих параметров соответственно меняются колоколообразные функции, принимая таким образом, различные формы функций принадлежности для лингвистических меток Ai и Bi.

На самом деле, любые такие непрерывные функции принадлежности, как трапециевидные и треугольные, также являются квантифицируемыми вариантами узловых функций данного уровня. Параметры этого уровня относятся к исходным параметрам.

Уровень 2. Для каждого узла вычисляется мощность действия соответствующего правила.

Выходная информация, помещаемая на вершину нейрона, составляет:

|

|

|

|

|

|

|

( |

), |

|

информация основания нейрона: |

|||||||

а выходная |

= |

( ) |

( ) |

= |

( |

) |

||

Оба узла=данного( ) уровня( ) |

имеют |

метку Т, потому что |

||||||

= |

( |

) |

( |

) |

||||

можно выбрать другие t-нормы для моделирования логического оператора и. Узлы этого уровня называются узлами правил.

Уровень 3. Каждый узел данного уровня имеет метку N, указывая на нормированность границ применения правил. Выходная информация вершины нейрона нормализует (при этом осуществляется операция сложения и нормализации нормированности границ) границу применения первого правила:

= + .

Выходная информация основания нейрона нормирует. При этом осуществляется операция сложения и нормализации нормированности границу:

= + .

Уровень 4. Выходная информация вершины нейрона является результатом нормированной границы применения и отдельного выходного параметра первого правила

100