- •Основы молекулярной физикии и термодинамики.

- •1.Статистический и термодинамический методы исследования макроскопических систем.Состояние систем.Процессы.

- •2. Идеальный газ-простейшая статистическая система.Основное уравнение молекулярной-кинетической теориигазов для давления.

- •3.Число степеней свободы молекулы.Закон равномерного распределения энергии по степеням свободы молекул.

- •4.Работа газа при изменении обьёма.Первое начало термодинамики.

- •5.Классическая теория теплоемкостей идеального газа и её ограниченность.

- •6. Адиабатный процесс

- •7.Распределение молекул идеального газа по скоростям и энергиям теплогого движения

- •8.Идеальный газ в однородном поле тяготения.Барометрическая формула.Закон Больцмана.

- •9. Термодинамическая вероятность макросостояния (статистический вес)

- •10. Тепловые машины.Феномологические формулировки 2 начала термодинамики

9. Термодинамическая вероятность макросостояния (статистический вес)

Рассмотрим простую модель системы, состоящей всего из двух подсистем (ячеек), в которых находятся четыре частицы с номерами от 1 до 4. Ячейки соответствуют либо двум разным координатам частиц (расположению частиц в двух разных местах), либо два разным импульсам частиц (смотри таблицу).

Способ распределения частиц по ячейкам без учета их номеров называется макросостоянием системы.

В рассматриваемом примере возможны всего пять разных макросостояний (три из них схематически изображены в таблице). 1 – все четыре частицы находятся в левой ячейке, 2 – три частицы в левой ячейке и одна в правой, 3 – две частицы в левой ячейке и две в правой. Ещё два макросостояния симметричны первому и второму.

Возможные макро и микросостояния для модели системы, состоящей из двух ячеек с четырьмя частицами

Способ распределения частиц по ячейкам с учетом их номеров называется микросостоянием системы. Возможные микросостояния представлены в третьей колонке таблицы. Вероятность застать систему невзаимодействующих частиц в любом из перечисленных микросостояний одна и та же. Но число микросостояний, реализующих макросостояние 3, максимальное, и это макросостояние возникает чаще других. Оно является предпочтительным для системы.

Число микросостояний, соответствующих какому-либо макросостоянию системы, называется термодинамической вероятностью (статистическим весом) этого макросостояния. Термодинамическую вероятность будем обозначать буквой W. В последнем столбце приведены значения термодинамической вероятности для первых трех макросостояний. В простом рассматриваемом примере эти числа невелики, тогда как термодинамическая вероятность макросостояний систем, состоящих из большого числа частиц (порядка числа Авогадро), выражается, соответственно, числами очень высоких порядков.

Рассмотрим свойства термодинамической вероятности.

1). Равновесие и флуктуации. Если на термодинамическую систему нет внешних воздействий, то в результате теплового движения частиц она случайно оказывается то в одном, то в другом макросостоянии. Но чаще всего осуществляются состояния с высокой термодинамической вероятностью. Равновесному состоянию соответствует максимальная термодинамическая вероятность. Состояния, очень близкие к равновесному, также имеют высокие термодинамические вероятности, и система случайным образом осуществляет переходы между ними вблизи равновесия. Используют термин: термодинамическая вероятность флуктуирует вблизи максимального значения. При этом флуктуируют и некоторые параметры состояния. Например для газа в маленьких локальных областях наблюдаются малые флуктуации давления вблизи равновесного его значения. Также флуктуационным является воздействие молекул жидкости на броуновскую частицу.

Главное свойство термодинамической вероятности: W® max в самопроизвольных процессах.

2). Термодинамическая вероятность – характеристика состояния. Термодинамическая вероятность любого макросостояния системы не зависит от предшествующих и будущих состояний. Изменение термодинамической вероятности при переходе от одного макросостояния к другому не зависит от пути перехода, а зависит только от начального и конечного макросостояний. При циклическом процессе термодинамическая вероятность возвращается к исходному значению.

3). Мультипликативность. Если сложная система состоит из отдельных невзаимодействующих подсистем, то термодинамическая вероятность состояния сложной системы равна произведению термодинамических вероятностей состояний подсистем: .

Последнее свойство не является “удобным”. Физика стремится вводить в рассмотрение не мультипликативные, а аддитивные величины, то есть такие, которые складываются друг с другом (как масса, энергия и др.), а не перемножаются, как термодинамические вероятности. Переход к аддитивным величинам не всегда возможен, но в данном случае придумана очень удобная величина со свойством аддитивности – энтропия.

Свойства энтропии

|

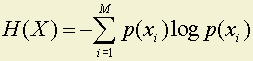

Энтропия дискретного источника всегда положительна. Это определяется способом ее подсчета.

,

,

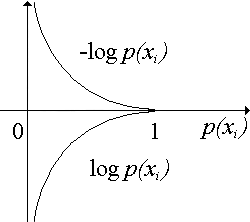

где 0 ≤ p(xi) ≤ 1 – положительное число;

0 ≤ [–log p(xi)] ≤ ∞ – положительное число;

0 ≤ –p(xi)log p(xi) ≤ 0.531 – положительное число;

H(x) – сумма положительных чисел.

Рис.

2.2

Рис.

2.2

Энтропия равна нулю только в том случае, когда вероятность появления одной из букв источника равна 1, а всех остальных – нулю.

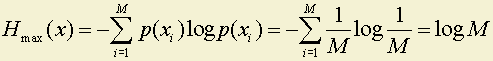

2. Можно доказать, что максимум энтропии достигается при равных вероятностях появления букв алфавита, то есть

Покажем это на примере источника из двух букв.

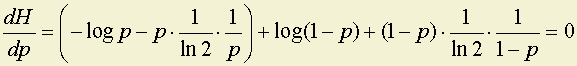

H(x) = –plog p – qlog q = –plog p – (1 – p)log(1 – p),

где H(x), будет максимально, когда H '(x), то есть

,

,

откуда следует, что –log p + log(1 – p) = 0; и p = 0.5 = q.

Максимум H(x) равен в данном случае 1 или Hmax(x) = log M.

3. Если в системе событие xk состоит из двух событий x'k и x"k с вероятностями q1 и q2 (q1 + q2 = pk), то общая энтропия системы будет равна сумме энтропий исходной системы и энтропии разветвленной части с весом pk и условными вероятностями ветвления q1⁄pk и q2 ⁄pk , то есть H{x1; x2; ... xk-1; x'k; x"k} = H{x1; x2; ... xk-1; xk} + pkH(x'k; x"k).

Покажем это на примере.

Пусть имеется система с двумя состояниями.

H(x1; x2) = (–0.5log 0.5) · 2 = 1 бит.

Пусть состояние x2 разбилось на два.

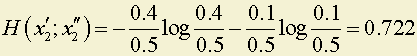

бита.

бита.

Энтропию новой системы можно подсчитать двумя способами:

1.

Hсист = –0.5log 0.5 – 0.4log 0.4 – 0.1log 0.1 = 0.5 + 0.529 + 0.332 = 1.361 бита.

2. Hсист = H(x1; x2) + p(x2) · H(x'1; x"2) = 1 + 0.5 · 0.722 = 1.361 бита.

Как видим, ответ получился один и тот же, но при втором способе расчета не нужно пересчитывать всю систему, а только к старой энтропии добавить энтропию разветвления.

Рассмотрим примеры на расчет энтропии по Шеннону и сравним ее с информацией по Хартли.