- •1. Теория информации – дочерняя наука кибернетики.

- •2. Что такое информация. Свойства информации. Этапы обращения информации. Информационные системы. Что такое информация

- •Свойства информации

- •Этапы обращения информации

- •Информационные системы

- •3. Система передачи информации.

- •4. Виды информации

- •5. Задачи и постулаты прикладной теории информации.

- •6. Количественная оценка информации

- •7. Что такое канал связи. Шум в канале связи Канал связи

- •Шум в канале связи

- •8. Кодирование информации. Код. Способы кодирования. Кодирование текстовой, графической, звуковой информации.

- •Кодирование текстовой информации.

- •Кодирование графической информации.

- •Кодирование звуковой информации.

- •9. Принципы хранения, измерения, обработки и передачи информации.

- •10. Информация в материальном мире, информация в живой природе, информация в человеческом обществе, информация в науке, классификация информации. Информация в материальном мире

- •Информация в живой природе

- •Информация в человеческом обществе

- •Информация в науке

- •Классификация информации

- •11. Информатика, история информатики.

- •История информатики

- •12. Измерение количества информации. Подходы к измерению информации.

- •13. Единицы измерения информации, носитель информации

- •14. Передача информации, скорость передачи информации.

- •15. Экспертные системы. Назначение экспертных систем.

- •Назначение экспертных систем

- •16. Классификация экспертных систем.

- •17. Представление знаний в экспертных системах.

- •18. Методы поиска решений в экспертных системах.

- •19. Вероятностный подход к измерению дискретной и непрерывной информации.

- •20. Информация Фишера.

- •21. Теорема отсчетов Котельникова или Найквиста-Шеннона.

- •22. Математическая модель системы передачи информации

- •23. Энтропия. Виды энтропии. Условная энтропия.

- •24. Энтропия. Виды энтропии. Взаимная энтропия.

- •25. Энтропия. Виды энтропии. B-арная энтропия

- •26. Энтропийное кодирование.

- •27. Пропускная способность дискретного канала.

- •28. Интерполяционная формула Уиттекера-Шеннона

- •29. Частота Найквиста.

- •30. Семантика. Семантическая модель.

- •31. Семантика естественных и формальных языков. Семантическая информация.

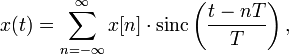

28. Интерполяционная формула Уиттекера-Шеннона

Интерполяционная формула Уиттекера — Шеннона служит для восстановления непрерывного сигнала с ограниченным спектром из последовательности равноотстоящих отсчётов.

Интерполяционная формула, как её обычно называют, восходит к работе Эмиля Бореля, датированной 1898 годом, и к работе Эдмунда Уиттекера, датированной 1915 годом. Интерполяционная формула была процитирована из работы сына Эдмунда Уиттекера — Джона Макнагтена Уиттекера, датированной 1935 годом, в виде теоремы отсчётов Найквиста — Шеннона в 1949 году, автором редакции был Клод Шеннон, до Шеннона данную теорему сформулировал Котельников. Также интерполяционную формулу обычно называют интерполяционной формулой Шеннона, или интерполяционной формулой Уиттекера.

Теорема

отсчётов гласит, что

при некоторых ограничивающих

условиях, функция ![]() может

быть восстановлена из её дискретизации,

может

быть восстановлена из её дискретизации, ![]() ,

согласно интерполяционной формуле

Уиттекера — Шеннона:

,

согласно интерполяционной формуле

Уиттекера — Шеннона:

где ![]() —

период дискретизации,

—

период дискретизации, ![]() —

частота дискретизации,

—

частота дискретизации, ![]() —

нормализированная sinc-функция.

—

нормализированная sinc-функция.

Есть два

граничных условия, которым должна

удовлетворить функция ![]() ,

для того чтобы выполнялась интерполяционная

формула:

,

для того чтобы выполнялась интерполяционная

формула:

должно

быть ограничено. Преобразование

Фурье для функции

должно

обладать следующим свойством: ![]() для

для ![]() ,

где

,

где ![]() .

.

Частота

дискретизации

должна

в два раза превышать диапазон частот, ![]() ,

или что эквивалентно:

,

или что эквивалентно:

![]()

где ![]() —

период дискретизации.

—

период дискретизации.

Интерполяционная формула воссоздаёт оригинальный сигнал , только тогда, когда эти два условия будут выполнены. В противном случае возникает наложение высокочастотных компонентов на низкочастотные — алиасинг.

29. Частота Найквиста.

Частота Найквиста — в цифровой обработке сигналов частота, равная половине частоты дискретизации. Названа в честь Гарри Найквиста. Изтеоремы Котельникова следует, что при дискретизации аналогового сигнала потерь информации не будет только в том случае, если спектр (спектральная плотность)(наивысшая частота полезного сигнала) сигнала равен или ниже частоты Найквиста. В противном случае при восстановлении аналогового сигнала будет иметь место наложение спектральных «хвостов» (подмена частот, маскировка частот), и форма восстановленного сигнала будет искажена. Если спектр сигнала не имеет составляющих выше частоты Найквиста, то он может быть (теоретически) продискретизирован и затем восстановлен без искажений. Фактически «оцифровка» сигнала (превращение аналогового сигнала в цифровой) сопряжена с квантованием отсчётов — каждый отсчёт записывается в виде цифрового кода конечной разрядности, в результате чего к отсчетам добавляются ошибки квантования (округления), при определенных условиях рассматриваемые как «шум квантования».

Реальные сигналы конечной длительности всегда имеют бесконечно широкий спектр, более или менее быстро убывающий с ростом частоты. Поэтому дискретизация сигналов всегда приводит к потерям информации (искажению формы сигнала при дискретизации—восстановлении), как бы ни была высока частота дискретизации. При выбранной частоте дискретизации искажение можно уменьшить, если обеспечить подавление спектральных составляющих аналогового сигнала (до дискретизации), лежащих выше частоты Найквиста, для чего требуется фильтр очень высокого порядка, чтобы избежать наложения «хвостов». Практическая реализация такого фильтра весьма сложна, так как амплитудно-частотные характеристики фильтров имеют не прямоугольную, а гладкую форму, и образуется некоторая переходная полоса частот между полосой пропускания и полосой подавления. Поэтому частоту дискретизации выбирают с запасом, к примеру, в аудио компакт-дисках используется частота дискретизации 44100 Герц, в то время как высшей частотой в спектре звуковых сигналов считается частота 20000 Гц. Запас по частоте Найквиста в 44100 / 2 - 20000 = 2050 Гц позволяет избежать подмены частот при использовании реализуемого фильтра невысокого порядка.