[Alekseev_A.P.]_Informatika_2015(z-lib.org)

.pdf

Основные понятия теории информации |

11 |

__________________________________________________________________________________

времени (информация представляется в виде совокупности знаков, например, письмо, статья, книга).

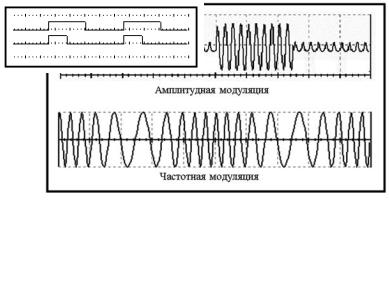

В современных системах связи чаще всего используются электрические и оптические сигналы. Передача информации осуществляется путем изменения какого-либо параметра сигнала в соответствии с передаваемым сообщением. Например, путем изменения амплитуды, частоты, фазы гармонических колебаний или длительности прямоугольных импульсов. Процесс изменения параметров сигнала на передающей стороне, происходящий в соответствии с содержанием передаваемого сообщения, называется модуляцией. Благодаря модуляции сигнал получает возможность распространяться на большие расстояния с помощью системы связи. Процесс восстановления сообщения из принятого сигнала называется демодуляцией (или детектированием).

На рисунке показаны две осциллограммы, иллюстрирующие сигналы с двумя видами модуляции - амплитудной и частотной. Здесь в качестве сигнала, несущего информацию, использованы синусоидальные гармонические колебания. В первом случае предаваемая информация содержится в изменении амплитуды колебаний (размаха по вертикали). Во втором случае информативным параметром является частота – плотность колебаний по горизонтали. Таким образом, можно передать по аналоговому каналу, например, цифровые сигналы 1 и 0.

В качестве сигналов, переносящих информацию, может быть использована последовательность прямоугольных импульсов. В этом случае при модуляции могут изменяться длительность импульсов, их временное положение или частота.

12 Основные понятия теории информации

__________________________________________________________________________________

На рисунке показано, как, изменяя скважность импульсов (отношение периода следования импульсов к их длительности), можно передавать единицы и нули.

Линией связи называется физическая среда, которая используется для транспортировки сигналов от передатчика к приемнику. В качестве примера линии связи можно назвать оптоволоконный и коаксиальный кабели связи, пространство, в котором распространяются радиоволны.

Совокупность технических средств, предназначенных для передачи сообщений от отправителя к получателю, называется системой связи. В качестве составных частей в систему связи входят: передающее устройство (передатчик), канал связи и приемное устройство (приемник).

Отправителями и получателями информации могут быть субъекты (пользователи, абоненты, корреспонденты) и объекты (датчики, компьютеры, факс-модемы, принтеры, устройства автоматики и т.п.).

Каналом связи называют часть системы связи, которая обеспечивает передачу сигналов между передатчиком и приёмником информации. В состав канала связи входят линии связи и каналообразующая аппаратура (КА). Задачей каналообразующей аппаратуры является уплотнение сигналов, то есть передача по одной физической линии информации сразу от нескольких отправителей.

Существуют каналы проводной связи (кабельные, световодные и др.) и каналы радиосвязи (телевизионные, радио и сотовые станции). Широкое распространение получили радиорелейные линии (РРЛ). В радиорелейных линиях радиосигнал передается от одной станции к другой (ретранслируется) как бы по эстафете в пределах прямой видимости. Разновидностью РРЛ являются тропосферные линии, которые используют отражения радиосигнала от неоднородностей тропосферы. Существуют спутниковые сети - радиорелейные линии, в которых ретранслятор располагается на искусственном спутнике земли.

ОтпраПеревитель датчик

Канал связи |

|

КА |

КА |

Линия связи |

|

При- |

|

Полу- |

емник |

|

чатель |

|

|

|

Основные понятия теории информации |

13 |

__________________________________________________________________________________

Применительно к глобальной сети Интернет можно сказать, что она содержит самые разнообразные каналы связи, которые соединяют между собой узлы с коммутационным оборудованием и компьютерами-серверами.

При обмене сообщениями с помощью мессенджера ICQ или при работе социальной сети получатель информации не знает, какую клавишу на клавиатуре в данный момент нажал отправитель сообщения. Другими словами, существует неопределённость состояния системы связи при приеме информации (неизвестно, какой сигнал передается в данный момент времени по каналу связи). Чем выше неопределенность (неизвестность, неосведомленность, хаотичность), тем больше энтропия системы.

Энтропия характеризует степень упорядоченности передаваемого текста, степень его отклонения от полного хаоса. В наиболее хаотичном тексте вероятности появления любых букв (символов) текста практически одинаковые. В этом случае текст представляет собой нечитаемый набор бессмысленных символов. Примером такого текста является шифрограмма, полученная с помощью криптостойкого шифра. Бессмысленный нечитаемый текст, состоящий из равновероятных символов, имеет наибольшую энтропию.

Предположим, что получатель информации имеет какие-то предварительные (априорные) сведения о некоторой системе . Мерой неосведомленности получателя информации о системе является функция H( ).

После получения по каналу связи некоторого сообщения получатель приобретает дополнительную информацию I ( ). Полученная информация уменьшает имевшуюся (априорную) неосведомленность H( ), которая в результате получения сообщения становится равной H ( ). Новую неопределенность H ( ) называют апостериорной, то есть неопределенностью после

проведения опыта (после передачи и приема сообщения ).

Таким образом, количество принятой информации можно выразить соотношением:

I ( ) = H( ) - H ( ).

Простыми словами это соотношение можно прокомментировать так:

количество информации I ( ), содержащейся в полученном сообщении , измеряется величиной уменьшения неосведомленности (незнания) о состоя-

нии системы . То есть полученная информация увеличивает знание.

|

|

|

|

|

|

|

|

|

|

Количество |

= |

Априорная |

|

= |

|

Апостериорная |

|

|

информации |

неопределенность |

|

|

неопределенность |

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Порядок расчета энтропии системы и количества полученной информации зависит от того, какова вероятность появления каждого знака (симво-

14 Основные понятия теории информации

__________________________________________________________________________________

ла) в сообщении. Если вероятности появления всех символов выбранного алфавита одинаковые (например, в криптограмме), то используется формула Хартли. Если вероятности появления каждого символа в сообщении различны, то используется формула Шеннона.

Формула Хартли применяется в случаях, когда появление различных символов в сообщении равновероятно. Это бывает, например, при передаче по каналу связи результатов математических расчетов (набор цифр), криптографических ключей, шифрограмм, паролей и т.п. Получение по каналу связи одного символа из N допустимых (возможных) символов используемого алфавита дает получателю такой объем информации:

I log2 N .

Здесь N – число допустимых символов (знаков), которое отправитель может использовать при формировании своего сообщения.

Указанную величину I можно трактовать, как количество информации, приходящееся на один символ (знак) сообщения. Согласно формуле Хартли количество информации, содержащейся в двоичном числе, равно количеству двоичных разрядов в этом числе. Один разряд двоичного числа позволяет сформировать два знака (символа): 0 и 1. Если N = 2, то I = 1 бит. Если N=32, то каждый символ несет 5 бит информации. Для алфавита, состоящего из 256 символов, объем информации, который несёт каждый символ I = 8 бит = 1 байт.

Формула Хартли является частным случаем формулы Шеннона. Формула Шеннона используется при расчете энтропии в ситуациях, когда вероятности появления символов различны (передается осмысленный текст):

N

I ( p1 log2 p1 p2 log2 p2 ... pN log2 pN ) pi log2 pi .

i 1

Здесь pi – вероятность появления i-го символа.

Указанную величину I следует трактовать, как среднее значение (математическое ожидание) информации, приходящееся на один из неравновероятных символов.

Знак минус в формуле поставлен для того, чтобы измерять информацию положительными числами. В противном случае логарифм числа, меньшего единицы, даст отрицательное значение. Заметим, что

N

pi 1.

i 1

Безусловно, формулы Хартли и Шеннона не охватывают всех возможных случаев расчета энтропии. Например, эти формулы нельзя использовать для расчета условной энтропии.

Установлено, что текстовые (осмысленные) сообщения содержат много избыточной информации. Так, например, если во время передачи сообщения, произошел отказ в работе канала связи, и на приемной стороне было

Основные понятия теории информации |

15 |

__________________________________________________________________________________

принято оборванное (неполное) сообщение типа «Спартак – чемпи», то легко «догадаться», что, вероятно, полное сообщение было «Спартак – чемпион». Содержательный анализ принятого сообщения позволяет восстановить пропущенный или недостающий фрагменты осмысленного текста.

К.Шеннон установил, что в английских текстах избыточная информация достигает 80% от общего объема информации, заключенной в письменном сообщении. Оставшиеся 20% текста являются источником снятия неопределенности, непредсказуемости полученного текста. Именно эти 20% текста несут новую информацию, снимают неопределенность, дают знание.

В русском языке (так же, как и в языках других народов) существует статистическая устойчивость вероятности появления каждой буквы алфавита. Так буква «о» в русских текстах появляется значительно чаще, чем буква «ъ». Кроме того, существует зависимость вероятности появления буквы от того, какая буква в осмысленном тексте ей предшествовала. Очевидно, что вероятность появления сочетания букв «ма» значительно выше, чем у сочетания букв «мъ».

Знание правил грамматики конкретного естественного языка позволяет с высокой вероятностью заранее предсказать очередную букву сообщения, если по каналу связи был получен какой-то осмысленный текст (то есть из контекста). Полученную с помощью существующих правил грамматики информацию К.Шеннон определил, как «избыточную» - лишнюю. Это объясняется тем, что знание правил построения сообщений позволяет предсказывать появление букв раньше, чем они будут переданы по каналу связи.

Избыточность текста наблюдается в тех случаях, когда вероятности появления различных символов различны, и когда вероятность появления очередного символа зависит от ранее принятого символа. Избыточность позволяет правильно понять содержание осмысленного текста даже при наличии в нем ошибок или пропуска символов. Для подобных случаев выведены формулы, которые учитывают тот факт, что вероятность появление очередного символа зависит от принятых предыдущих символов (учитывается условная энтропия.

Современные достижения в области теории информации позволили разработать эффективные криптографические системы, системы массового обслуживания. На основании теории информации разработаны алгоритмы и программы для сжатия файлов, а также для кодирования, обнаружения и исправления ошибок в полученных данных. Теория информации помогла разработать эффективные способы ослабления действия помех, действующих в каналах связи.

Теория информации позволила эффективно решить множество прикладных вопросов, например, создать модемы для телефонных каналов, у которых скорость передачи информации приблизилась к теоретической пропускной способности существующих каналов связи.

16 Этапы развития вычислительной техники

__________________________________________________________________________________

1.3. Этапы развития вычислительной техники

Лучший способ спрогнозировать будущее – изобрести его.

А.Кэй

Основные этапы развития вычислительной техники представлены в таблице.

Этап |

Период развития |

Ручной |

не установлен |

Механический |

с середины XVII века |

Электромеханический |

с 90-х годов XIX века |

Электронный |

с 40-х годов ХХ века |

Рассмотрим особенности каждого этапа.

Более трех тысяч лет назад в Средиземноморье было распространено простейшее приспособление для счёта: доска, разделённая на полосы, где перемещались камешки. Такая счетная дощечка называлась абак и использовалась для ручного счёта. В Древнем Риме абак назывался calculi или abaculi и изготавливался из бронзы, камня, слоновой кости или цветного стекла. Слово calculus означает «галька», «голыш». От этого слова произошло латинское слово calculatore (вычис-

лять), а затем слово «калькуляция». Первое механическое счетное уст-

ройство было построено немецким математиком и астрономом Вильгельмом Шиккардом (1592 – 1635 г.г.). Устройст-

во было реализовано в единственном экземпляре (предположительно в 1623 г.) и предназначалась для выполнения арифметических операций. Из-за недостаточной известности машины Шиккарда более 300 лет считалось, что первую суммирующую машину сконструировал Блез Паскаль.

Блез Паскаль (французский математик, физик, религиозный философ и писатель) в 1642 г. построил механическую счетную машину, выполнявшую сложение. В 1674 г. Готфрид Лейбниц расширил возможности машины Паскаля, добавив операции умножения, деления и извлечения квадратно-

Этапы развития вычислительной техники |

17 |

__________________________________________________________________________________

го корня. Для своей машины Лейбниц применил систему счисления, использующую вместо привычных для человека десяти цифр две: 1 и 0. Двоичная система счислений широко используется в современных ЭВМ.

Ни одна из перечисленных машин не была автоматической и работала под управлением человека. В 1834 г. Чарлз Бэббидж (Charles Babbage) первым разработал подробный проект автоматической вычислительной машины. Однако построить эту машину не удалось, так как в то время невозможно было достичь требуемой точности изготовления ее механических деталей.

Ч. Бэббидж выделял в своей машине следующие составные части:

«склад» для хранения чисел (по со-

временной терминологии — память);

«мельницу» для производства арифметических действий (арифметическое устройство, процессор);

устройство, управляющее последовательностью выполнения операций (устройство управления);

устройства ввода и вывода данных.

Вкачестве источника энергии для приведения в действие механизмов машины Ч. Бэббидж предполагал использовать паровой двигатель.

Ч.Бэббидж предложил управлять работой своей машины с помощью перфорированных карт, содержащих коды команд, подобно тому, как использовались перфокарты в ткацких станках Жаккара. На перфокартах с помощью отверстий, пробитых в определенных местах, размещалась управляющая программа.

Ч. Бэббидж довольно подробно рассматривал вопросы, связанные, как мы сейчас говорим, с

программированием. В частности, им была разработана важная для программирования идея «условной передачи управления». Идеи Бэббиджа заложили фундамент, на ко-

тором со временем были построены ЭВМ.

18 Этапы развития вычислительной техники

__________________________________________________________________________________

Первые программы для вычислительной машины Ч.Бэббиджа создавала Ада Лавлейс (Ada Lovelace) — дочь известного поэта Джорджа Байрона, в честь которой впоследствии был назван один из языков программирования. Выражаясь современным языком, Лавлейс составила программу вычисления чисел Бернулли. Ада Лавлейс разработала основные принципы программирования, которые остаются актуальными до настоящего момента времени. Ряд терминов, введенных Адой Лавлейс, используются и сейчас, например, «цикл», «рабочие ячейки».

Теоретические основы современных цифровых вычислительных машин заложил английский математик Джордж

Буль (1815—1864). Он разработал алгебру логики, ввел в обиход логические операторы И, ИЛИ и НЕ.

В1888 г. Германом Холлеритом (Herman Hollerith) была сконструи-

рована первая электромеханическая машина для сортировки и подсчета перфокарт. Эта машина, названная табулятором, содержала реле, счетчики, сортировочный ящик. Изобретение Холлерита было использовано при подведении итогов переписи населения в США. Успех вычислительных машин с перфокартами был феноменален. То, чем за десять лет до этого занимались 500 сотрудников в течение семи лет, Холлерит сделал с 43 помощниками на 43 вычислительных машинах за 4 недели.

В1896 г. Герман Холлерит основал фирму Computing Tabulation Company. Спустя несколько лет, это предприятие переименовали в извест-

нейшую теперь фирму International Business Machine Corporation (IBM).

Немецкий инженер Конрад Цузе (Konrad Zuse) был первым, кто успешно осуществил идею создания автоматической электромеханической вычислительной машины на основе двоичной системы счисления. В 1936 г. он начал конструировать вычислительный аппарат, работающий в двоичной системе счисления, который впоследствии был назван Zuse 1 (Z1). В 1941 г. Была построена действующая модель Zuse 3, которая состояла из 600 реле счетного устройства и 2000 реле устройства памяти.

В1943 г. в Англии было разработано полностью автоматическое вычислительное устройство Colossus. Основным назначением этого устройства было дешифрование перехваченных сообщений противника.

Еще одна полностью автоматическая вычислительная машина, изобретенная профессором Гарвардского университета Говардом Айкеном

(Aiken Howard, 1900—1973) при участии группы инженеров фирмы IBM, была построена в 1944 г. Она была названа ASCC (другое название Mark 1),

Этапы развития вычислительной техники |

19 |

__________________________________________________________________________________

и была электромеханической (построена на реле), состоящей приблизительно из 750 тысяч компонентов. На умножение она тратила около 4 секунд. До знакомства с работами Цузе научная общественность считала машину ASCC первой электромеханической машиной.

В 1937 г. в США Джон Атанасов начал работы по созданию электронной вычислительной машины. Им были созданы и запатентованы первые электронные схемы отдельных узлов ЭВМ. Совместно с К. Берри к 1942 г. была построена электронная машина ABC (Atanasoff-Berry Computer).

Электронная вычислительная машина, разработанная Эккертом и Маучли (John W. Mauchly and J. Presper Eckert, Jr.) в США в 1946 г., была названа ENIAC. При создании этой машины Эккерт и Маучли заимствовали основные идеи у Дж. Атанасова. Машина ENIAC была примерно в 1000 раз быстрее, чем ASCC. Она состояла из 18 тысяч электронных ламп, 1500 реле, имела вес более 30 тонн, потребляла мощность более 150 кВт.

Фотография позволяет наглядно оценить прогресс вычислительной техники. Несколько человек находятся внутри ENIAC. Современные ЭВМ уже можно разместить внутри человека.

Первоначально ENIAC программировалась путем соединения проводами соответствующих гнезд на коммутационной панели, что делало составление программы очень медленным и утомительным занятием. Амери-

канский математик и физик венгерского происхождения Джон фон Нейман (1903—1957) предложил хранить программу — последовательность команд управления ЭВМ — в памяти ЭВМ, что позволяло оперировать с программой так же, как с данными. Последующие ЭВМ строились с большим объемом памяти, с учетом того, что там будет храниться программа.

Фон Неймана выделил пять базовых элементов компьютера:

арифметико-логическое устройство (АЛУ);

устройство управления (УУ);

запоминающее устройство (ЗУ);

20 Этапы развития вычислительной техники

__________________________________________________________________________________

система ввода информации;

система вывода информации.

Описанную структуру ЭВМ принято называть архитектурой фон Ней-

мана.

ЭВМ первого поколения в качестве элементной базы использовали электронные лампы и реле.

Изобретение в 1948 г. транзисторов и запоминающих устройств на магнитных сердечниках оказало глубокое воздействие на вычислительную технику. Ненадежные вакуумные лампы, которые потребляли большую мощность для нагревания катода, заменялись небольшими германиевыми (впоследствии кремниевыми) транзисторами. Компьютеры, построенные в середине 50-х годов ХХ в., стали называть машинами второго поколения.

Революционный прорыв в миниатюризации и повышении надежности компьютеров произошел в 1958 г., когда американский инженер Д. Килби (Jack Kilby) разработал первую интегральную микросхему. В середине 60-х годов прошлого столетия появилось третье поколение ЭВМ, основу элементной базы которых составляли микросхемы малой и средней степени интеграции.

Другая революция в технологии изготовления ЭВМ произошла в 1971 г., когда американский инженер Маршиан Эдвард Хофф (Marcian E. Hoff) объединил основные элементы компьютера в один небольшой кремниевый чип (кристалл), который он назвал микропроцессором. Первый микропроцессор получил маркировку Intel 4004.

ЭВМ четвертого поколения строятся на интегральных микросхемах с большой степенью интеграции. На одном кристалле размещается целая микроЭВМ. Заметим, что переход от третьего поколения ЭВМ к четвертому не был революционным. Отличия коснулись не столько принципов построения ЭВМ, сколько плотности упаковки элементов в микросхемах.

Развитие ЭВМ идет по пути непрерывного повышения быстродействия, надежности, расширения функциональных возможностей, уменьшения габаритов и потребляемой мощности, упрощения правил работы на компьютере. Среди ЭВМ четвертого поколения появились персональные компьютеры (ПК или ПЭВМ), которые позволяют индивидуально работать каждому пользователю.

Первой ПЭВМ можно считать компьютер Altair-8800, созданный в 1974 г. Э. Робертсом. Для этого компьютера П. Аллен и Б. Гейтс в 1975 г. создали транслятор с популярного языка Basic. Впоследствии (1976 г.) П. Аллен и Б. Гейтс создали известную компанию Microsoft.

В заслугу Б.Гейтса (и компании Microsoft) можно поставить разработку следующих программных продуктов: операционных систем MS-DOS (1981 г.), ОС семейства MS Windows (от Windows 1.0, 1985 г. до Windows 8.1, 2013 г.), языка программирования Visual Basic (1991 г.), приложений MS