- •1 Раздел.

- •1.Вероятностный эксперимент. Пространство элементарных событий.

- •2.Дискретные и непрерывные пространства элементарных событий. Примеры.

- •3.Случайные события: определение, примеры.

- •4.Классификация событий.

- •5.Операции над событиями.

- •6.Сумма и произведение случайных событий.

- •7.Разность событий, противоположные события.

- •8. Определение вероятности, аксиомы Колмогорова.

- •9.Относительные частоты, их свойства.

- •10.Классический метод вычисления вероятности.

- •11.Элементы комбинаторики и тв

- •12. Статистический метод вычисления вероятности.

- •13. Аксиоматический метод задания вероятности.

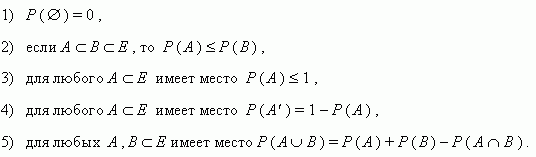

- •14. Свойства вероятностей.

- •15. Условные вероятности. Аксиомы Колмогорова (для случая условных вероятностей).

- •16. Независимость событий (для двух и для трёх событий).

- •17. Теоремы умножения вероятностей (для двух и для трёх событий). Условия их применения.

- •18. Теоремы сложения вероятностей (для двух и для трёх событий). Условия их применения.

- •19. Формула полной вероятности.

- •20. Формула Байеса.

- •21. Схема испытаний Бернулли.

- •22. Формула Бернулли. Наиболее вероятное число наступления «успехов» в схеме.

- •23. Локальная теорема Муавра-Лапласа

- •24. Интегральная теорема Муавра-Лапласа

- •25. Теорема Пуассона

- •2 Раздел.

- •1.Определение случайной величины, типы случайных величин, примеры. Закон распределения вероятностей случайной величины.

- •2.Фукция распределения вероятностей случайных величин, ее свойства.

- •3.Типы случайных величин. Примеры.

- •4.Дискретная случайная величина. Как можно задать закон распределения дискретной случайной величины?

- •5.Непрерывная случайная величина. Что называется плотностью распределения вероятностей?

- •6.Взаимосвязь между функцией распределения и плотностью распределения.

- •7.Свойства плотности распределения.

- •8.Числовые характеристики распределения случайной величины.

- •9.Математическое ожидание случайной величины, ее свойства.

- •10.Мода случайной величины.

- •11.Медиана случайной величины, геометрический смысл медианы.

- •12.Дисперсия случайной величины, ее свойства. Среднее квадратическое отклонение.

- •13.Коэффициент асимметрии.

- •14.Коэффициент эксцесса.

- •2.Статистический закон распределения дискретной случайной величины.

- •3.Статистический закон распределения непрерывной случайной величины.

- •4.Графическое изображение статистических законов распределения.

- •5.Точечные оценки числовых характеристик: математического ожидания, моды, медианы.

- •7.Статистические гипотезы. Параметрические и непараметрические гипотезы.

- •8.Статистические гипотезы. Нулевая и альтернативная гипотеза.

- •9.Проверка статистических гипотез. Статистический критерий значимости. Примеры статистических критериев.

- •10.Область допустимых значений и критическая область статистического критерия.

- •11.Ошибки, совершаемые при проверке статистических гипотез. Уровень значимости статистического критерия.

- •12. Непараметрические статические гипотезы. Гипотеза о виде закона распределения.

- •13. Проверка гипотезы о виде закона распределения. Критерий Пирсона.

- •14. Интервальные оценки параметров распределения

- •15. Доверительная вероятность, доверительный интервал.

- •16. Доверительные Интервалы для математического ожидания нормально распределенной случайной величины

- •17. Функциональная, статистическая, регрессионная зависимость.

- •18. Корреляционное поле. Выбор модели регрессионной зависимости.

- •20.Коэффициент корреляции, его свойства.

- •21.Проверка значимости коэффициента корреляции.

- •22. Построение нелинейного выборочного уравнения регрессии.

- •24.Проверка значимости коэффициента детерминации.

- •25.Для чего применяется метод наименьших квадратов в регрессионном анализе?

12. Статистический метод вычисления вероятности.

Существует большой класс событий, вероятности которых нельзя вычислить с помощью классического метода определения вероятностей. Например: - выпадение некоторой грани игральной кости со смещенным центром тяжести, - попадание в цель при одном выстреле, - выход из строя прибора в течение гарантийного срока и т.д.

Можно предположить, что каждое из таких событий обладает некоторой вероятностью, которая при многократном повторении соответствующих опытов будет отражаться в относительной частоте событий. Относительной частотой события А в некоторой серии из N испытаний называется отношение числа испытаний NА, в которых событие А произошло, к общему числу произведенных испытаний N.

Экспериментальным фактом является то, что при неограниченном увеличении числа испытаний относительная частота события А приближается к вероятности события А и стабилизируется около этого значения.

При статистическом определения вероятности в качестве вероятности события используется относительная частота этого события в большой серии испытаний.

13. Аксиоматический метод задания вероятности.

Пусть проводится вероятностный эксперимент Е и Ώ – дискретное пространство этого эксперимента.

Теорема. Если в дискретном пространстве Ώ содержащем конечное или счетное множество элементарных исходов задана вероятностная мера.

Р = { p(ώ 1), p(ώ 2)…p(ώ n)}, P(ώi) =>0, Σ P(ώi) =1, то вероятность появления произвольного события А

А = { ώА1, ώA2… ώAn} равна Р(А) = Σ Р(Ааi).

Доказательство следует из 3-ей аксиомы Колмогорова.

14. Свойства вероятностей.

Пусть задано пространство элементарных событий Е , а вероятности Р определены на событиях из Е . Тогда:

15. Условные вероятности. Аксиомы Колмогорова (для случая условных вероятностей).

Условной вероятностью события A при условии B (обозначается P(A|B)) называется вероятность события A, вычисленная при условии, что событие B произошло. По определению

P(A | B) = P(A B)/P(B).

Вычисление условных вероятностей – это, по существу, переход в новое, урезанное заданным условием B пространство элементарных событий. Вероятности элементарных событий P(i) (iB) пропорциональны исходным. Для соблюдения условия нормировки в новом пространстве элементарных событий они делятся на P(B).

Аналогично

P(B | A) = P(A B)/P(A)

в случае, если P(A) 0.

16. Независимость событий (для двух и для трёх событий).

С понятием условной вероятности тесно связано понятие независимости событий.

Понятие независимости можно перевести на язык математики:

Е….где (Ώ, А, Р) – матем. Модель этого эксперимента.

Говорят, что событие А не зависит от события В, если наступление события В не изменяет вероятности наступления события А.

Т.е. p (A | B)=Р(А).

Если p (A | B)не равно Р(А)., то событие А называется зависимым от события В.

Р(А∩В)=Р(А)*Р(В) – теорема умножения независимых событий.

Понятие независимости можно распространить на случай 3-х и более событий.

События А, В, С называются попарно независимыми если выполняются следующие равенства.

Р(А∩В)=Р(А)*Р(В)

Р(А∩С=Р(А)*Р(С)

Р(В∩С)=Р(В)*Р(С).

События А, В, С независимы в совокупности если выполняются следующие равенства

Р(А∩В)=Р(А)*Р(В)

Р(А∩С=Р(А)*Р(С)

Р(В∩С)=Р(В)*Р(С).

Р(А∩В∩С)=Р(А)*Р(В)*Р(С)

Теорема. Если 2 события А и В наблюдаются в 1-ом эксперименте, то независимы также А и В(против), А(против) и В, А(против) и В(против).

Это означает, что

p (A | B)=Р(А)

p (В | А)=Р(В)

Р(А∩В)=Р(А)*Р(В) – независимы

Р(А∩В)=Р(А)*Р(В| А)= Р(В)* p (A | B) – зависимы.