2. Сравнить с помощью t-критерия Стьюдента коэффициенты вначале исследования и после, проиллюстрировать на графике.

Итак, покажем, как использовать критерий стьюдента (англ. Student). Грубо говоря, критерий работает так: мы задаём входные параметры – количество элементов выборки (2000) и уровень доверия или значимости (0,05). Дальше программа, следуя теоретическому алгоритму, который обрабатывает значения наших данных, показывает, есть ли зависимость. Это отображается как красный цвет строк зависимых параметров. Теоретические алгоритмы разные: зависит от того, как связаны исследуемые переменные, т.е. выборки. Если есть связь, используется один алгоритм, ежели нету – другой.

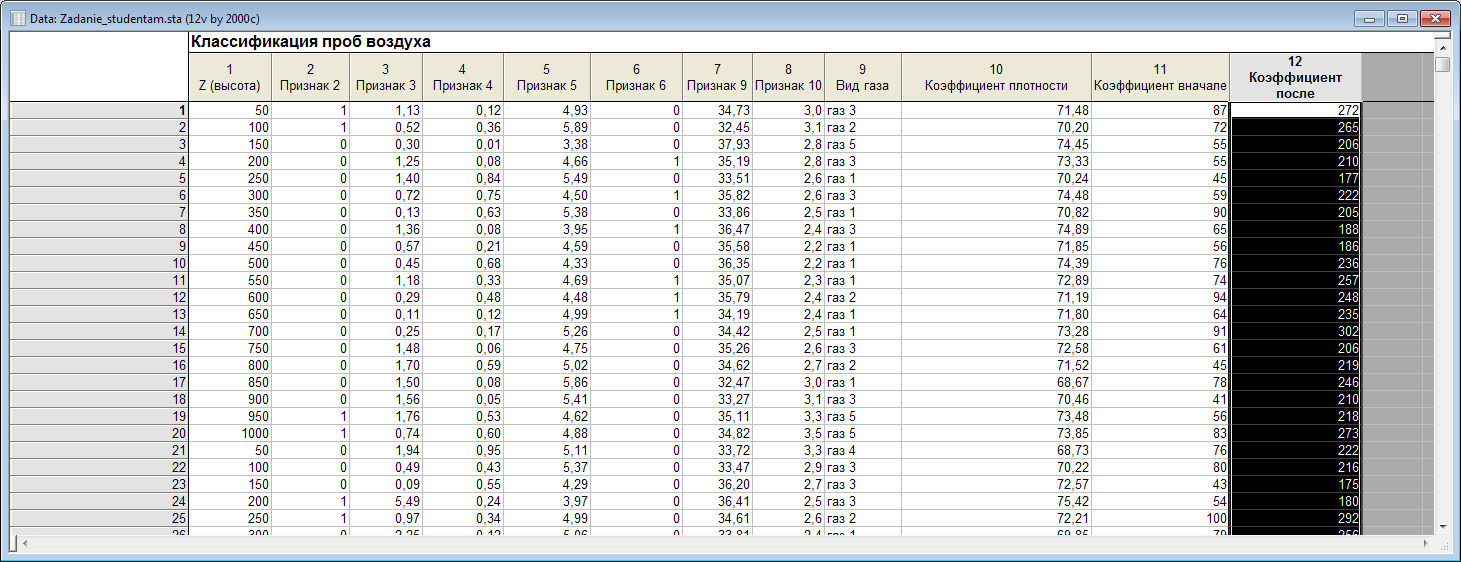

Нам предлагается исследовать на зависимость две переменные: «Коэффициенты вначале» и «Коэффициенты после». Они зависимы между собой, это вытекает из структуры предлагаемых данных, увидеть это можно так:

в окне данных, дважды нажимаем на последнюю переменную

появится окно

внизу которого написан закон, по которому каждое поле этой переменной вычислялась:

лично мне не совсем

понятно, почему и слева и справа стоит

,

но я трактовал это так, что сперва

была заполнена некоторыми данными, а

затем к ней добавили значения

,

но я трактовал это так, что сперва

была заполнена некоторыми данными, а

затем к ней добавили значения

,

умноженные на два.

,

умноженные на два.

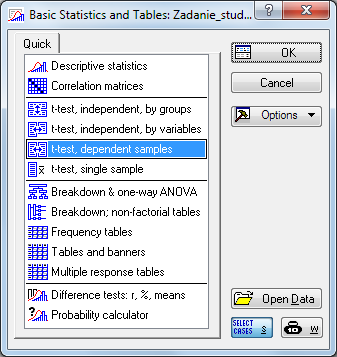

Заходим в

,

затем выбираем пункт, который соответствует

природе наших переменных, т.е. зависимые

между собой:

.

.

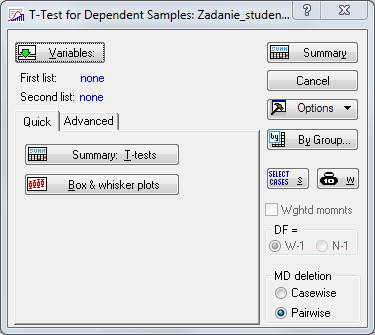

При этом не забываем установить значения переменных (т.е. снять галочку в ). После этого нажимаем . Появится окно

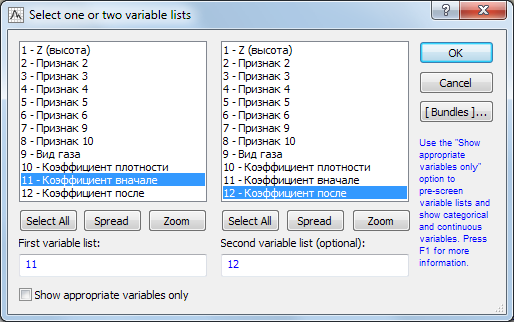

нажимаем , выбираем соответственно «Коэффициенты вначале» и «Коэффициенты после»

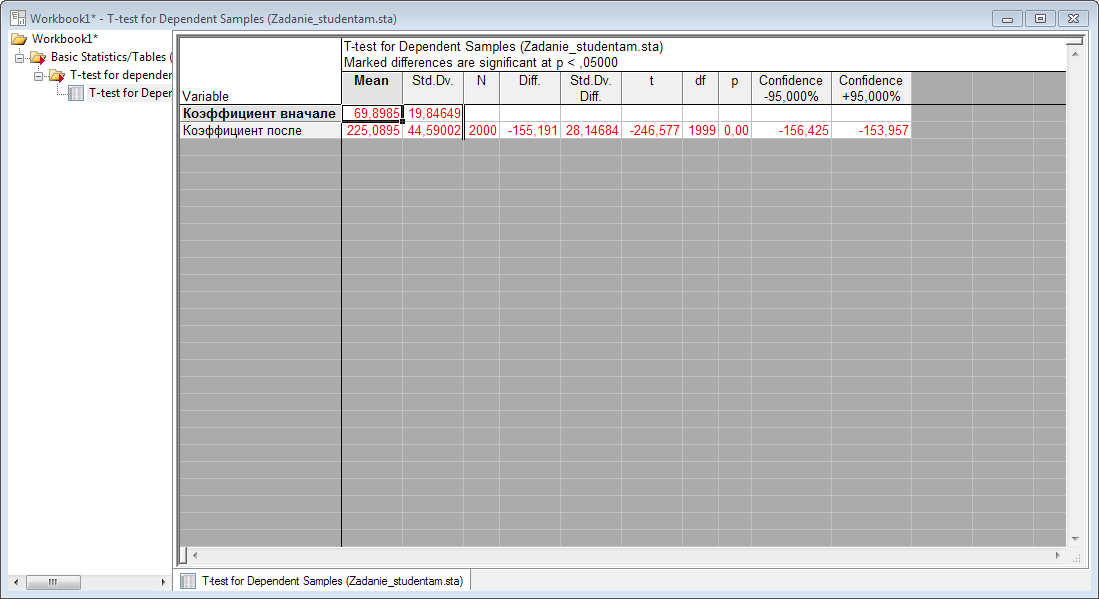

затем нажимаем , потом . Получим результат

собственно, как в моей курсовой работе. Таким образом, показали, что зависимость есть. В своей курсовой я также показывал насколько сильно разнятся средние значения обоих переменных на диаграммах размаха, для этого в окне

нужно перейти в

вкладку

![]() и именно в ней нажать кнопку

и именно в ней нажать кнопку

![]() ,

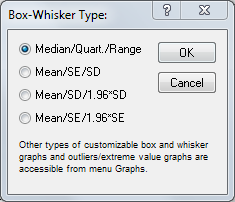

после которой появится диалоговое окно

,

после которой появится диалоговое окно

в котором предлагается

выбрать, как высчитывать «центр» и

границы прямоугольника для диаграммы

размаха. Вариант

![]() говорит о том, что центр, это медиана, а

границы прямоугольника – верхняя и

нижние квартили. Вариант же

говорит о том, что центр, это медиана, а

границы прямоугольника – верхняя и

нижние квартили. Вариант же

![]() говорит о том, что центр, это среднее, а

границы прямоугольника – стандартное

отклонение. В чем между ними различие

и что это такое читайте в ответнике в

вопросах

говорит о том, что центр, это среднее, а

границы прямоугольника – стандартное

отклонение. В чем между ними различие

и что это такое читайте в ответнике в

вопросах

,

,

,

,

.

.

Стандартное

отклонение (в статистике обозначается

SD)

- это

квадратный

корень из суммы квадратов разности

элементов выборки от среднего, делённое

на

.

.

SE

– стандартная ошибка ( ,

где

,

где

выборочная дисперсия (наилучшее

оценивание совокупной дисперсии) и

выборочная дисперсия (наилучшее

оценивание совокупной дисперсии) и

число наблюдений в выборке).

число наблюдений в выборке).

Выбирая последовательно два варианта, получим два результата, таких же как в моей курсовой.

Повторю, что скриншотить можно только таблицы. Все графики легко копируются в непосредственно.

Теперь посчитаем корреляционную матрицу.

Вообще, цель

корреляционного анализа – установить,

есть ли зависимость между переменными

(в отличие от критерия Стьюдента не

обязательно между двумя переменными).

Результат такого анализа – матрица, по

столбцам и по строкам которой стоят

выбранные нами переменные, а значения

матрицы – числа в промежутке от

до

до

.

Природа зависимости (линейная,

квадратичная, обратная и т.п.) зависит

от выбираемого метода вычисления

корреляционной матрицы. Мы будем

рассматривать метод Пирсона и Спирмена.

Оба эти метода устанавливают, есть ли

между переменными линейная зависимость.

Чем ближе значение матрицы на пересечении

строки и столбца к

,

тем ближе зависимость к линейной. И

наоборот, значение, к примеру

.

Природа зависимости (линейная,

квадратичная, обратная и т.п.) зависит

от выбираемого метода вычисления

корреляционной матрицы. Мы будем

рассматривать метод Пирсона и Спирмена.

Оба эти метода устанавливают, есть ли

между переменными линейная зависимость.

Чем ближе значение матрицы на пересечении

строки и столбца к

,

тем ближе зависимость к линейной. И

наоборот, значение, к примеру

,

может сказать нам, что зависимость

полиномиальная. Различие между методом

Спирмена и методом Пирсона в том, что

Спирмена выполняется быстрее, в силу

того, что он робастен (устойчив) к

значением самих переменных. Ему важна

индексация, которая вводится особым

образом. Метод Спирмена считается «в

лоб», прогоняя значения, поэтому он

работает медленнее чем, метод Спирмена,

но зато более точно.

,

может сказать нам, что зависимость

полиномиальная. Различие между методом

Спирмена и методом Пирсона в том, что

Спирмена выполняется быстрее, в силу

того, что он робастен (устойчив) к

значением самих переменных. Ему важна

индексация, которая вводится особым

образом. Метод Спирмена считается «в

лоб», прогоняя значения, поэтому он

работает медленнее чем, метод Спирмена,

но зато более точно.

Ясно, что в

корреляционной матрице на главной

диагонали будут стоять 1

(переменная зависит линейно от самой

себя:

).

Также матрица симметрична (т.е.

).

Также матрица симметрична (т.е.

,

,

– операция транспонирования), это

следует из того, что переменная

– операция транспонирования), это

следует из того, что переменная

зависит от переменной

зависит от переменной

точно так же, как и переменная

от

,

потому в матрице элемент

точно так же, как и переменная

от

,

потому в матрице элемент

.

.

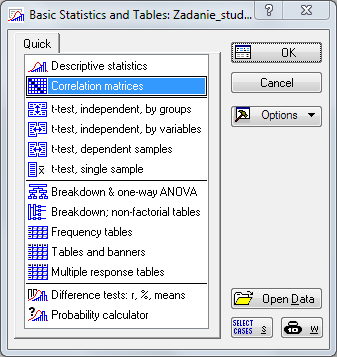

Перейдём к построению корреляционной матрицы. Нажимаем , затем в окне выбираем

в

снимаем галочку, устанавливая тем самым

диапазон от

до

,

нажимаем

,

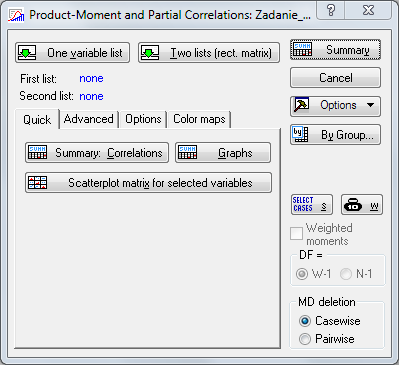

появится окно

,

нажимаем

,

появится окно

в котором нажимаем

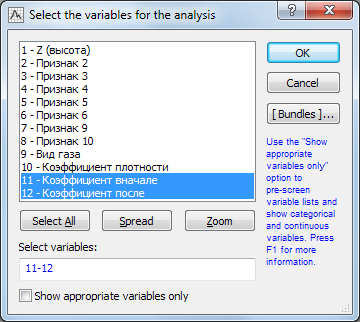

![]() и выбираем список переменных, зависимости

которых хотим исследовать (зажимаем

и выбираем список переменных, зависимости

которых хотим исследовать (зажимаем

и последовательно кликаем мышкой по

нужным переменным)

и последовательно кликаем мышкой по

нужным переменным)

нажимаем

,

затем переходим в вкладку

![]() и уберём галочку

и уберём галочку

![]() ,

для того, чтобы не отображать в матрице

корреляций средние и стандартные

отклонения. Можете их оставить, но

результат не будет является корреляционной

матрицей, а будет матрица

,

для того, чтобы не отображать в матрице

корреляций средние и стандартные

отклонения. Можете их оставить, но

результат не будет является корреляционной

матрицей, а будет матрица

,

где

,

где

матрица

средних и дисперсий, а

матрица

средних и дисперсий, а

– корреляционная

матрица (символ

– корреляционная

матрица (символ

означает

приписывание матрицы

сразу после

).

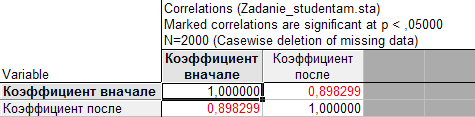

Нажимаем

и получаем следующий результат

означает

приписывание матрицы

сразу после

).

Нажимаем

и получаем следующий результат

Коэффициент близок к 1, значит зависимость близка к линейной. Заносим в работу.

Теперь научимся строить диаграмму рассеяния. Она показывает насколько «рассеяны» данные относительно некоторой прямой. Это частный случай линейной регрессии, о которой речь пойдёт позже.

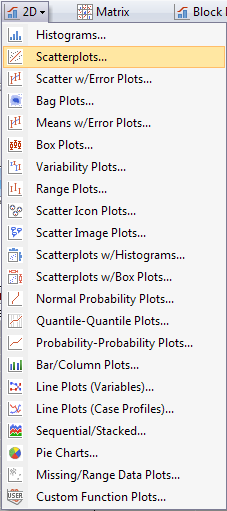

На ленте заходим

во вкладку

,

нажимаем

![]() ,

вывалится контекстное меню, в котором

выбираем

,

вывалится контекстное меню, в котором

выбираем

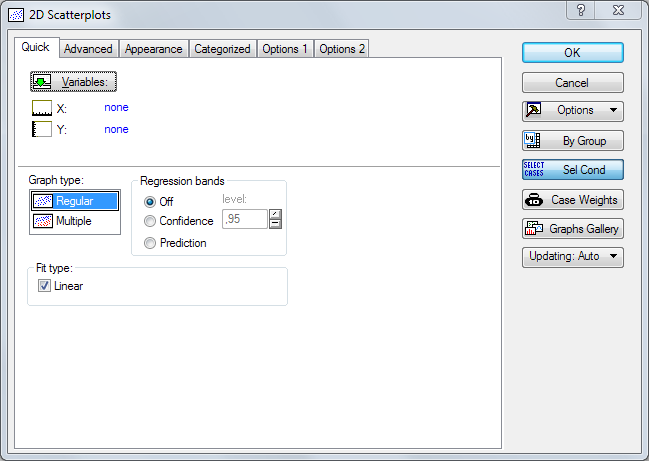

вывалится окно

выбираем диапазон

в

,

в

выбираем переменные соответственно по

и по

и по

,

жмём

.

Получаем результат. Заносим в работу.

,

жмём

.

Получаем результат. Заносим в работу.