- •1. Передача информации между двумя оконечными устройствами. Тип соединения оконечных устройств

- •2. Основные определения: информация, сообщение, система связи, сигнал, алфавит.

- •3. Обобщенная структура схемы системы связи

- •4. Источники сообщения в системах связи. Вероятностный характер источников сообщений.

- •5. Форматирование информации. Форматирование текстовых данных. Существующие стандарты.

- •6. Передача сообщений по каналу, искажения, краевые искажения, дробление

- •7. Аналоговые источники сообщений. Преобразование аналоговых сигналов в цифровые. Квантование по уровню. Ошибка квантования.

- •8. Дискретизация аналоговых сигналов по времени. Понятие о теореме Котельникова.

- •9. Преобразование аналоговых сигналов в цифровые. Дискретизация по методу «выборка-хранение». (доработать)

- •10. Сигнал, как реализация процесса. Классификация процессов.

- •11. Классификация процессов. Детерминированные процессы. Гармонические и переходные непериодические процессы.

- •12. Полигармонические и непериодические процессы их спектральные характеристики.

- •13. Определение случайного процесса. Непрерывные и дискретные случайные процессы.

- •14. Измерение случайных процессов.

- •15. Числовые характеристики случайных процессов, их инженерно-физический смысл.

- •16.Законы распределения и основные характеристики случайных процессов

- •17. Автокорреляционная функция случайного процесса. Примеры автокорр. Функций.

- •18. Взаимная корреляционная функция случайных процессов. Примеры применения корреляционных характеристик.

- •19. Усреднение по ансамблю и по времени. Эргодическое свойство случайных процессов.

- •20. Стационарность случайных процессов. Стационарность в широком и узком смыслах.

- •21. Информационные модели сигналов. Формула Хартли.

- •22. Информационные модели сигналов. Формула Шеннона.

- •23. Энтропия источника сообщений. Свойства энтропии источника дискретных сообщений.

- •24. Избыточность при передаче сообщений. Роль избыточности при передаче информации.

- •25. Математические модели сигналов. Временное и частотное представление сигналов.

- •26. Ряд Фурье по произвольной ортогональной системе функций.

- •31. Спектральные характеристики непериодического сигнала. Прямое и обратное преобразования Фурье.

- •32. Оценивание спектральной плотности с помощью дпф

- •33. Дискретное преобразование Фурье (дпф). Гармонический анализ.

- •34. Примеры ортогональных базисов. Функции Уолша.

- •35. Модуляция. Зачем она нужна

- •36. Амплитудная модуляция.Спектр ам сигнала. Примеры модуляторов.

- •37 Амплитудно-модулируемый сигнал сложной формы, его спектр.

- •38 Демодуляция ам сигнала. Работа простейшего амплитудного детектора.

- •43. Спектр колебаний с угловой модуляцией

- •44. Сравнение методов амплитудной и угловой модуляций

- •45. Двоичное представление информации. Механизм восстановления двоичных импульсов.

- •46. Спектральные характеристики случайных процессов.

- •47. Преобразование кодов.

- •48. Корректирующие коды. Ход Хемминга

- •49. Неравномерные коды. Код Хаффмана.

- •50. Неравномерные коды. Код Шеннона-Фано

- •51. Дискретизация аналоговых сигналов по времени. Понятие о теореме котельникова.

- •52. Спектр прямоугольного сиганала

- •53. Свойства энтропии источника дискретных сообщений.

53. Свойства энтропии источника дискретных сообщений.

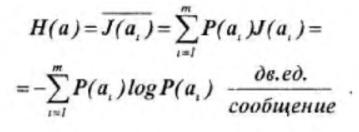

До сих пор определялось количество информации, содержащееся в отдельных сообщениях. Вместе с тем во многих случаях, когда требуется согласовать канал с источником сообщений, таких сведений оказывается недостаточно. Возникает потребность в характеристиках, которые позволяли бы оценивать информационные свойства источника сообщений в целом. Одной из важных характеристик такого рода является среднее количество информации, приходящееся на одно сообщение. В простейшем случае, когда все сообщения равновероятны, количество информации в каждом из них одинаково и определяется выражением:

![]()

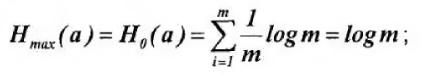

При этом среднее количество информации равно logm . Следовательно, при равновероятных независимых сообщениях информационные свойства источника зависят только от числа сообщений в ансамбле m.

Однако в реальных условиях сообщения, как правило, имеют разную вероятность. Так, буквы алфавита О, Е, А встречаются в тексте сравнительно часто, а буквы Щ, Ы, Ъ — редко. Поэтому знание числа сообщений m в ансамбле является недостаточным, необходимо иметь сведения о вероятности каждого сообщения: P(a1), P(a2),…, P(am).

Так как вероятности сообщений неодинаковы, то они несут различное количество информации: J(ai) = - logP(ai) Менее вероятные сообщения несут большее количество информации и наоборот. Среднее количество информации, приходящееся на одно сообщение источника, определяется как математическое ожидание J(ai).

В еличина Н(а) называется

энтропией. Этот термин заимствован из

термодинамики, где имеется аналогичное

по своей форме выражение, характеризующее

неопределенность состояния физической

системы. В теории информации энтропия

Н(а) также характеризует неопределенность

ситуации до передачи сообщения, поскольку

заранее неизвестно, какое из сообщений

ансамбля источника будет передано. Для

нас самым существенным является то,

что чем больше энтропия, тем сильнее

неопределенность и тем большую информацию

в среднем несет одно сообщение источника.

еличина Н(а) называется

энтропией. Этот термин заимствован из

термодинамики, где имеется аналогичное

по своей форме выражение, характеризующее

неопределенность состояния физической

системы. В теории информации энтропия

Н(а) также характеризует неопределенность

ситуации до передачи сообщения, поскольку

заранее неизвестно, какое из сообщений

ансамбля источника будет передано. Для

нас самым существенным является то,

что чем больше энтропия, тем сильнее

неопределенность и тем большую информацию

в среднем несет одно сообщение источника.

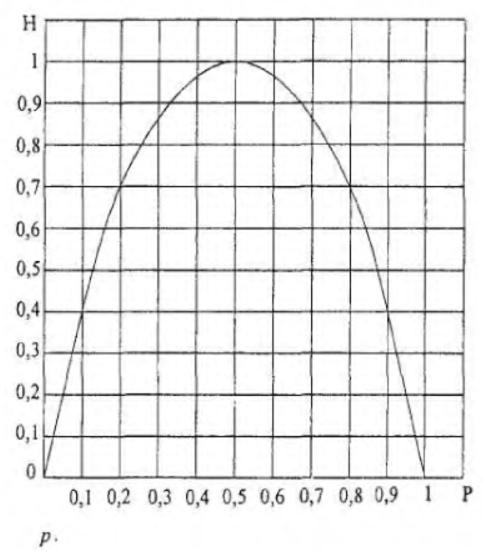

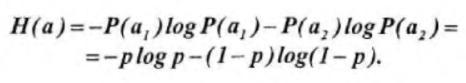

В качестве примера вычислим энтропию источника сообщений, который характеризуется ансамблем, состоящим из двух сообщений a1 и а2 с вероятностями P(a1)=p и P(a2)=1-p. На основании (6.10) энтропия такого источника будет равна:

Зависимость Н(а) от р показана на рис 6.1.

Рис. 6.1. Зависимость энтропии от вероятности

Максимум энтропии имеет место при p=1/2, т. е. когда ситуация является наиболее неопределенной. При р = 1 или р = 0, что соответствует передаче одного из сообщений а1, или а2, неопределенности отсутствуют. В этих случаях энтропия Н(а) равна нулю.

Среднее количество информации, содержащееся в последовательности из n-сообщений, равно:

![]()

Отсюда следует, что количество передаваемой информации можно увеличить не только за счет числа сообщений, но и путем повышения энтропии источника, т. е. информационной емкости его сообщений.

Обобщая эти результаты, можно сформулировать основные свойства энтропии источника независимых сообщений (6.10):

• энтропия — величина всегда положительная, так как

![]()

• при равновероятных сообщениях, когда:

![]()

энтропия максимальна и равна:

• энтропия равняется нулю лишь в том случае, когда все вероятности P(at) равны нулю, за исключением одной, величина которой равна единице;

• энтропия нескольких независимых источников равна сумме энтропии этих источников: H(a,b,...,r)=H(a)+ (b) + + ... + Н(r).

Оглавление

1. Передача информации между двумя оконечными устройствами. Тип соединения оконечных устройств 1

2. Основные определения: информация, сообщение, система связи, сигнал, алфавит. 1

3. Обобщенная структура схемы системы связи 3

4. Источники сообщения в системах связи. Вероятностный характер источников сообщений. 4

5. Форматирование информации. Форматирование текстовых данных. Существующие стандарты. 5

6. Передача сообщений по каналу, искажения, краевые искажения, дробление 6

7. Аналоговые источники сообщений. Преобразование аналоговых сигналов в цифровые. Квантование по уровню. Ошибка квантования. 7

8. Дискретизация аналоговых сигналов по времени. Понятие о теореме Котельникова. 9

9. Преобразование аналоговых сигналов в цифровые. Дискретизация по методу «выборка-хранение». (доработать) 10

10. Сигнал, как реализация процесса. Классификация процессов. 11

11. Классификация процессов. Детерминированные процессы. Гармонические и переходные непериодические процессы. 12

12. Полигармонические и непериодические процессы их спектральные характеристики. 14

13. Определение случайного процесса. Непрерывные и дискретные случайные процессы. 16

14. Измерение случайных процессов. 18

15. Числовые характеристики случайных процессов, их инженерно-физический смысл. 19

16.Законы распределения и основные характеристики случайных процессов 21

17. Автокорреляционная функция случайного процесса. Примеры автокорр. функций. 22

19. Усреднение по ансамблю и по времени. Эргодическое свойство случайных процессов. 25

20. Стационарность случайных процессов. Стационарность в широком и узком смыслах. 27

21. Информационные модели сигналов. Формула Хартли. 28

22. Информационные модели сигналов. Формула Шеннона. 29

23. Энтропия источника сообщений. Свойства энтропии источника дискретных сообщений. 30

24. Избыточность при передаче сообщений. Роль избыточности при передаче информации. 31

25. Математические модели сигналов. Временное и частотное представление сигналов. 32

26. Ряд Фурье по произвольной ортогональной системе функций. 33

27. Ряд Фурье по основной тригонометрической системе функций. 34

28. Разложение периодических функций в ряд Фурье. Спектр амплитуд и спектр фаз. 36

29. Ряд Фурье в комплексной форме. Спектр фаз и спектр амплитуд. 37

30. Спектр мощности сигнала. Практическая ширина спектра. Равенство Парсеваля. 38

31. Спектральные характеристики непериодического сигнала. Прямое и обратное преобразования Фурье. 41

32. Оценивание спектральной плотности с помощью ДПФ 43

33. Дискретное преобразование Фурье (ДПФ). Гармонический анализ. 44

34. Примеры ортогональных базисов. Функции Уолша. 46

35. Модуляция. Зачем она нужна 48

36. Амплитудная модуляция.Спектр АМ сигнала. Примеры модуляторов. 50

37 Амплитудно-модулируемый сигнал сложной формы, его спектр. 51

38 Демодуляция АМ сигнала. Работа простейшего амплитудного детектора. 52

39-40 Балансовая модуляция. Спектр и ширина полосы. 53

41. Угловая модуляция (частотная + фазная) 55

43. Спектр колебаний с угловой модуляцией 56

44. Сравнение методов амплитудной и угловой модуляций 57

45. Двоичное представление информации. Механизм восстановления двоичных импульсов. 58

46. Спектральные характеристики случайных процессов. 59

47. Преобразование кодов. 60

48. Корректирующие коды. Ход Хемминга 61

49. Неравномерные коды. Код Хаффмана. 62

50. Неравномерные коды. Код Шеннона-Фано 64

51. Дискретизация аналоговых сигналов по времени. Понятие о теореме котельникова. 65

Теорема Котельникова (в англоязычной литературе — теорема Найквиста — Шеннона или теорема отсчётов) гласит, что, если аналоговый сигнал имеет финитный (ограниченный по ширине) спектр, то он может быть восстановлен однозначно и без потерь по своим дискретным отсчётам, взятым с частотой строго большей' удвоенной верхней частоты : 65

65

x(t)→x(ti) →x(k∆t) 65

52. Спектр прямоугольного сиганала 66

53. Свойства энтропии источника дискретных сообщений. 69