Ответы к кт 2

Виды каналов связи.

1. Канал называется дискретным по входу (по выходу), если множество входных (выходных) сигналов является счетным;

2. Канал называется непрерывным по входу (по выходу), если множество входных (выходных) сигналов является континуумом;

3. Канал называется дискретным по входу и непрерывный по выходу — если множество входных сигналов конечно, а множество выходных сигналов несчетно. Такие каналы называют еще полунепрерывными.

4. Канал носит название с дискретным временем, если сигналы на его входе и выходе представляют собой конечные или бесконечные последовательности некоторых ансамблей.

4а. Дискретный по входу и выходу канал с дискретным временем называется дискретным каналом.

5. Канал называется каналом с непрерывным временем — если сигналы на его входе и выходе являются непрерывными функциями времени.

5а. Непрерывный по входу и выходу канал с непрерывным временем называют непрерывным каналом.

Режимы работы цифрового канала связи.

Искажения каналов передачи.

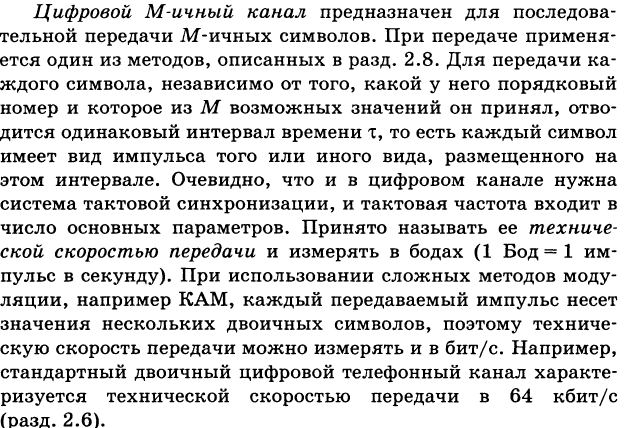

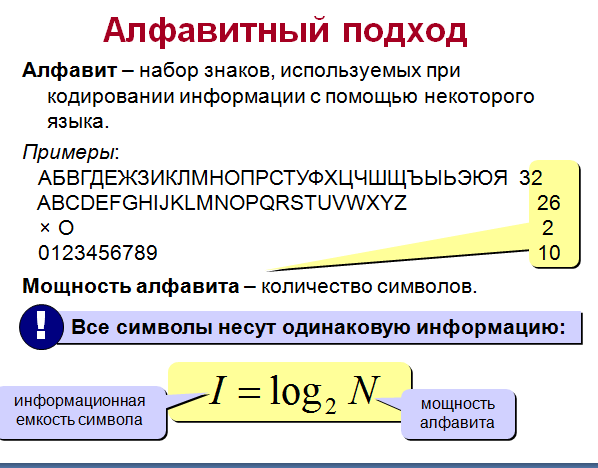

Алфавитный подход к измерению количества информации.

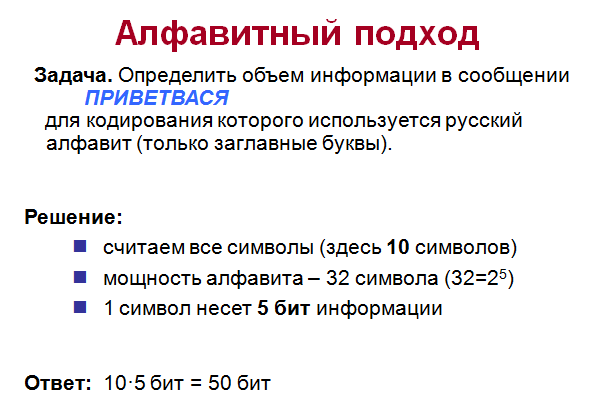

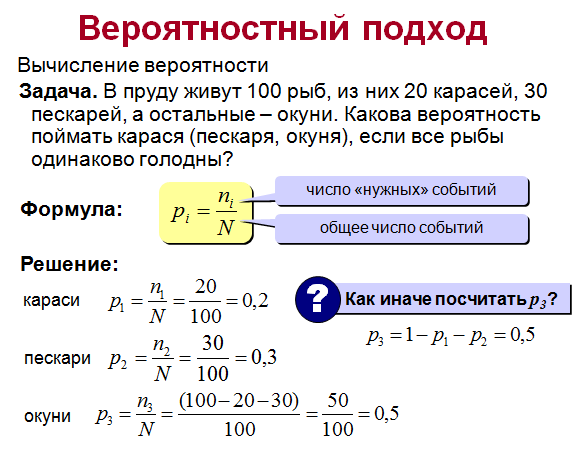

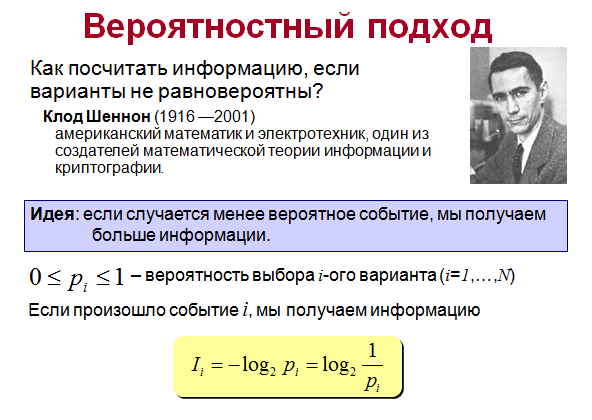

Вероятностный подход к измерению количества информации.

Количественная мера информации.

Понятие количество информации отождествляется с понятием информация. Эти два понятия являются синонимами. Мера информации должна монотонно возрастать с увеличением длительности сообщения (сигнала), которую естественно измерять числом символов в дискретном сообщении и временем передачи в непрерывном случае. Кроме того, на содержание количества информации должны влиять и статистические характеристики, так как сигнал должен рассматриваться как случайный процесс.

При этом наложено ряд ограничений:

1. Рассматриваются только дискретные сообщения.

2. Множество различных сообщений конечно.

3. Символы, составляющие сообщения равновероятны и независимы.

Хартли впервые предложил в качестве меры количества информации принять логарифм числа возможных последовательностей символов.

I=log mk=log N

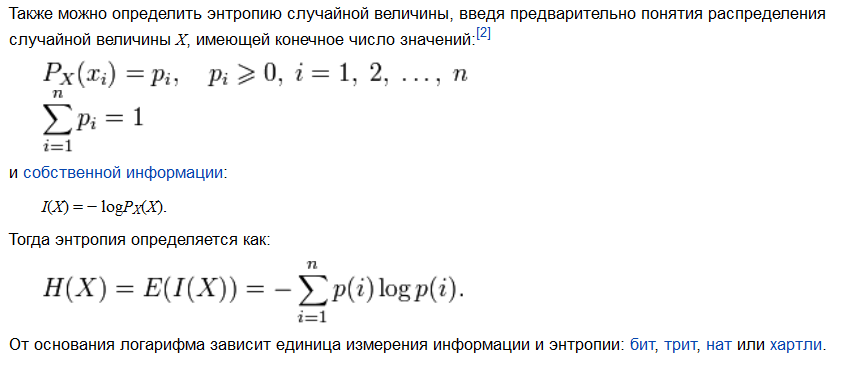

С

обственная

энтропия.

обственная

энтропия.

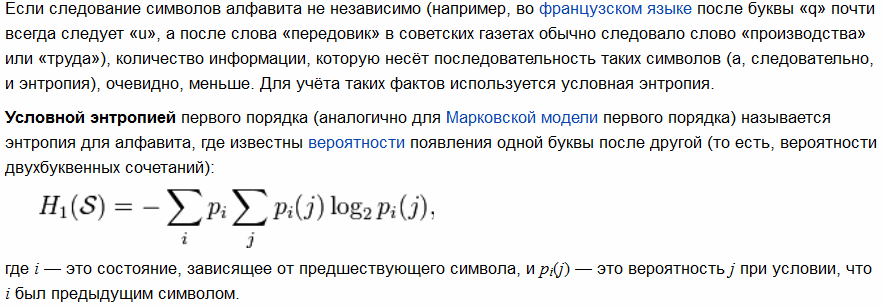

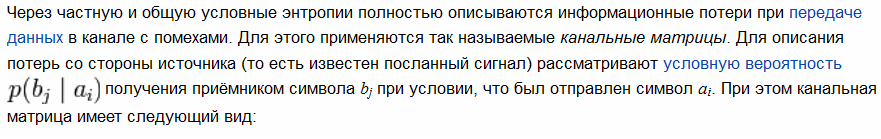

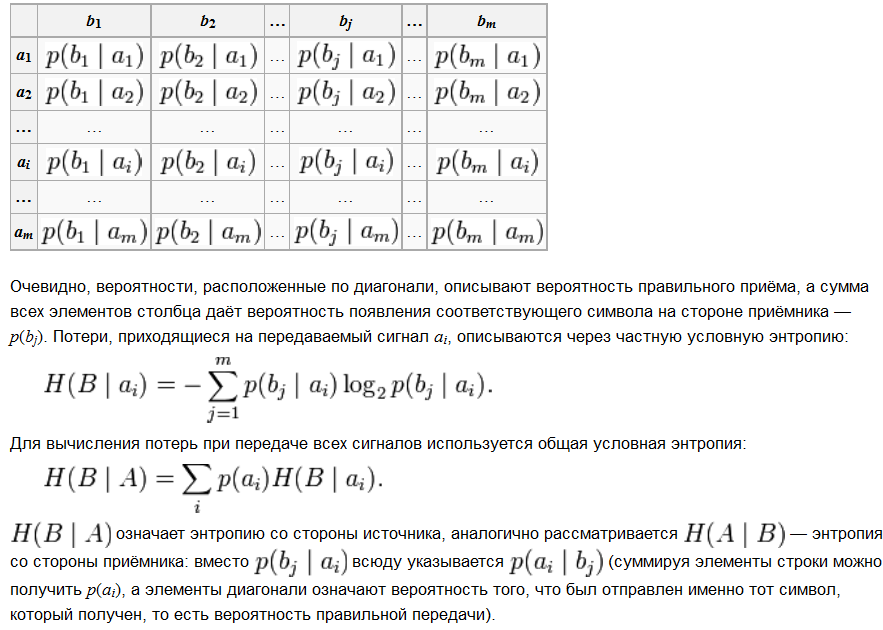

Условная энтропия.

Взаимная энтропия.

Избыточность сигнала.

Структурная избыточность возникает при преобразовании изображения и телевизионный электрический видеосигнал, содержащий служебные сигналы синхронизации и импульсы гашения обратного хода лучей по строкам и подкадрам (полям). Форма и временное положение гасящих импульсов априорно известны, поэтому их можно не передавать, а синтезировать на приемной стороне по сигналам синхронизации. Устранение гасящих импульсов из структуры цифрового телевизионного сигнала позволяет снизить требуемую скорость передачи примерно на 25%.

Статистическая избыточность определяется свойствами исходного аналого-вого сигнала и способами его преобразования в цифровую форму. Этот вид избыточности проявляется в наличии определенных корреляционных связей между выборками сигнала. В соответствии с теорией информации сигнал безызбыточен, если его выборки статистически независимы и распределены равновероятно. Целью алгоритмов уменьшения статистической избыточности является достижение возможно меньшей скорости цифрового потока при обеспечении требуемой точности передачи исходного аналогового сигнала и приемлемой сложности реализации.

Теорема Шенона о кодировании в дискретном канале без помех.

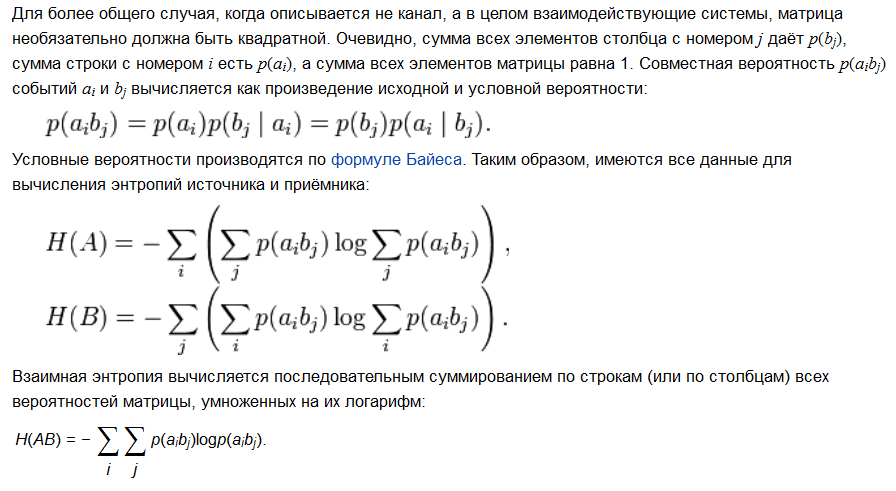

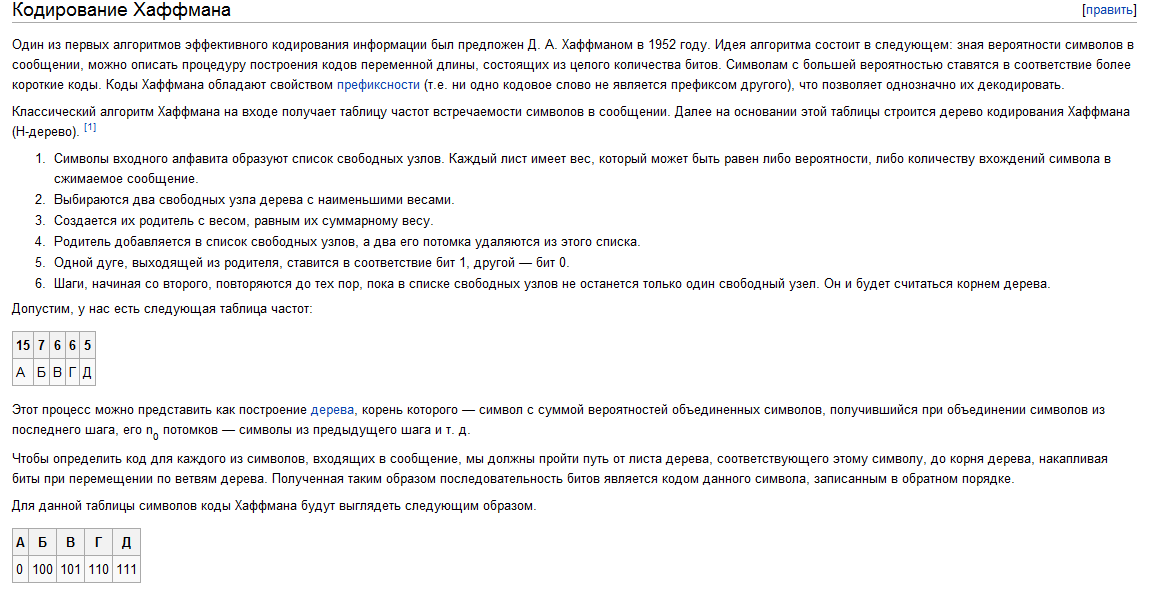

Код Хафмана.

Пропускная способность канала связи.

Теорема Шенона о кодировании в дискретном канале с помехами.

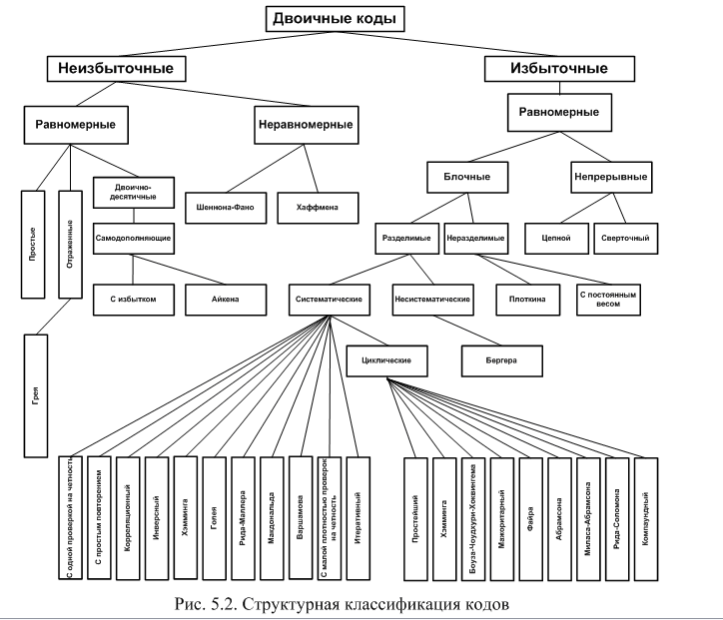

Классификация кодов.

Коды можно разделить на две самостоятельные группы. К первой относятся коды, использующие все возможные комбинации – неизбыточные коды. В литературе их еще называют простыми, или первичными. Ко второй группе относятся коды, использующие лишь определенную часть всех возможных комбинаций, такие коды называются избыточными. Оставшаяся часть комбинаций используется для обнаружения или исправления ошибок, возникающих при передаче сообщений. В этих кодах количество разрядов кодовых комбинаций можно условно разделить на определенное число разрядов, предназначенных для информации (информационные разряды), и число разрядов, предназначенных для коррекции ошибок (проверочные разряды).

Обе группы кодов, в свою очередь, подразделяются на равномерные и неравномерные. Равномерные коды – это коды, все кодовые комбинации которых содержат постоянное количество разрядов. Неравномерные коды содержат кодовые комбинации с различным числом разрядов. Ввиду того что неравномерные избыточные коды не нашли применения на практике из-за сложности их технической реализации, в дальнейшем их рассматривать не будем.

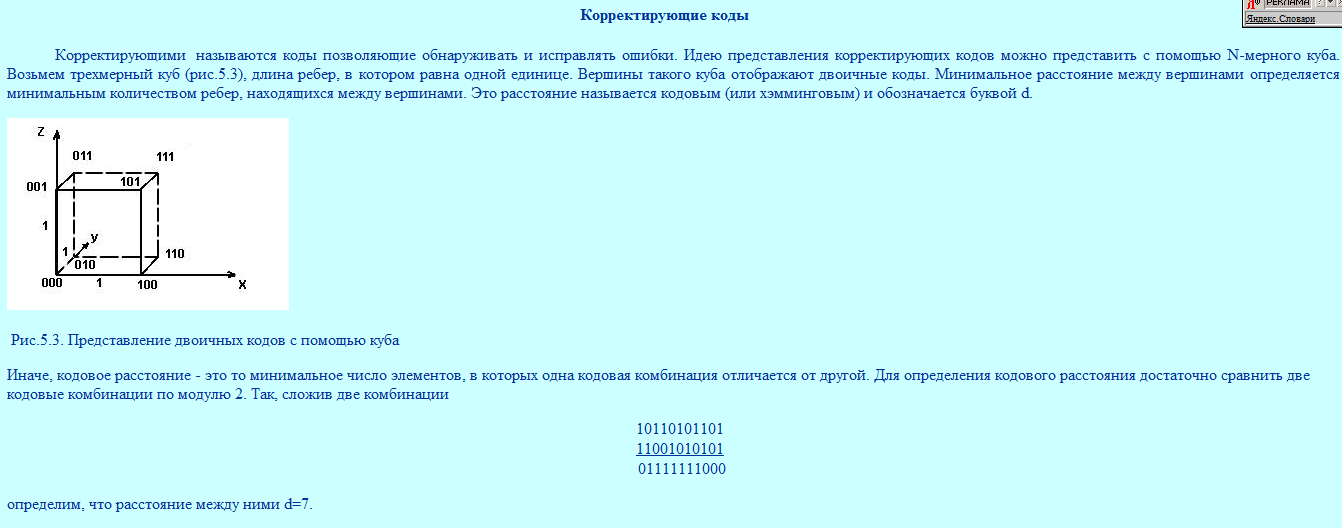

Корректирующие коды.

Расстояние Хемминга.

Расстояние Хэмминга — число позиций, в которых соответствующие символы двух слов одинаковой длины различны[1]. В более общем случае расстояние Хэмминга применяется для строк одинаковой длины любых q-ичных алфавитов и служит метрикой различия (функцией, определяющей расстояние в метрическом пространстве) объектов одинаковой размерности.

Линейные блочные коды.

Линейный блочный код - класс кодов, которые могут использоваться с целью обнаружения или исправления ошибок.

Коды Хэмминга.

Коды Хэмминга — наиболее известные и, вероятно, первые из самоконтролирующихся и самокорректирующихся кодов. Построены они применительно к двоичной системе счисления.

Свойство кодов Хэмминга таково, что контрольное число указывает номер позиции, где произошла ошибка. При отсутствии ошибки в коде данная последовательность будет содержать только нули. Полученное число описывает таким образом n=(m+k+1) событий. Следовательно, справедливо неравенство

2k>=(m+k+1)