- •1.Принципы организации и функционирования искусственных нейронных сетей

- •1.1. Основные нейрофизиологические данные о биологических нейронных сетях

- •1.2. Основы организации информационных процессов в искусственных нейронных сетях

- •1.3. Элементы искусственной нейронной сети. Основные определения

- •1.4.Понятие «искусственная нейронная сеть»

- •1.5.Геометрическое описание связей

- •2. Законы обучения

- •2.1.Основные определения

- •2.2.Классификация методов обучения

- •2.3.Обучение с супервизором

- •2.4.Обучение с подкреплением

- •2.5.Обучение самоорганизацией

- •2.5.1.Закон обучения Кохонена

- •2.5.2.Закон обучения Гроссберга

- •2.5.3.Пространственно-временное обучение

- •3.Архитектуры инс

- •3.1.Ассоциативные нейронные сети

- •3.2.Сети преобразования данных

- •3.2.1.Сети с обратным распространением ошибки

- •3.2.2.Сети со встречным распространением ошибки

- •3.3.Стохастические сети. Машина Больцмана

- •3.4.Иерархические сети

- •4.Применение инс

2.2.Классификация методов обучения

Существует три основных класса методов обучения ИНС:

обучение с супервизором;

обучение с подкреплением;

самообучение.

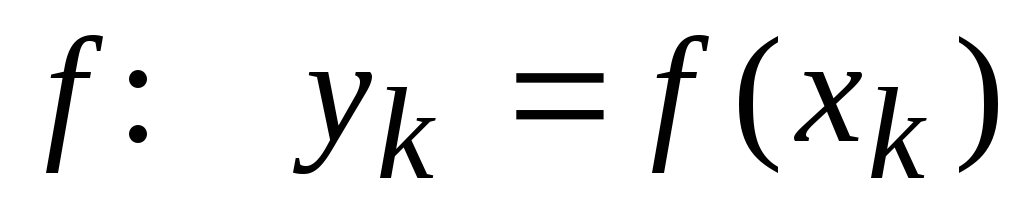

Обучение

с супервизором предполагает ситуацию,

в которой ИНС получает входной вектор

![]() и формирует выходной вектор

и формирует выходной вектор

![]() .

Для такой системы обучение с супервизором

означает режим, в котором сети

предоставляются образцы

.

Для такой системы обучение с супервизором

означает режим, в котором сети

предоставляются образцы

![]() корректных пар вход-выход.

корректных пар вход-выход.

Обозначим

действительный выход сети

![]() ,

а желаемый —

,

а желаемый —

![]() .

Действительный выходной вектор до

окончания процедуры обучения будет

отличаться от желаемого, что и является

исходной информацией для изменения

параметров ИН и весов межнейронных

связей ИНС. В этом случае

.

Действительный выходной вектор до

окончания процедуры обучения будет

отличаться от желаемого, что и является

исходной информацией для изменения

параметров ИН и весов межнейронных

связей ИНС. В этом случае

![]() ,

а

,

а

![]() .

.

Cуществуют два вида систем, обучающихся таким образом:

системы, которые испытывают фиксированную функцию

.

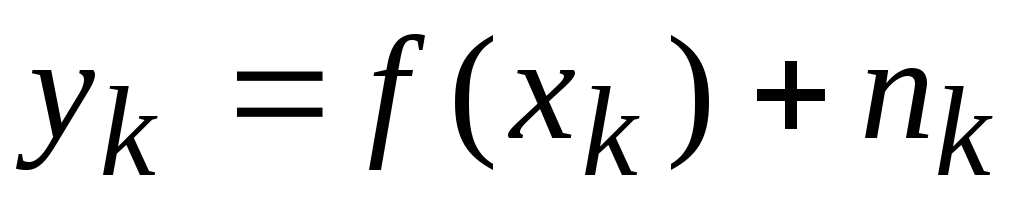

.системы, которые испытывают функцию, имеющую статистический характер:

,

где

,

где

случайный шум

случайный шум

.

.

Обучение

с подкреплением

аналогично

обучению с супервизором, но вместо

корректного (желаемого) значения

![]() ИНС

получает только характеристику насколько

хорошо действительный выход сети

приближен к значениям последовательности

испытаний (т. е. пар вход-выход).

ИНС

получает только характеристику насколько

хорошо действительный выход сети

приближен к значениям последовательности

испытаний (т. е. пар вход-выход).

Самоорганизация

предполагает

изменение значений весовых коэффициентов

лишь на основании сведений о входных

сигналах

![]() .

.

2.3.Обучение с супервизором

В основе принципов построения законов обучения с супервизором — гипотеза Хебба об увеличении эффективности межнейронных связей между одновременно активными искусственными нейронами. Поэтому во многих источниках этот закон носит название «закон обучения Хебба».

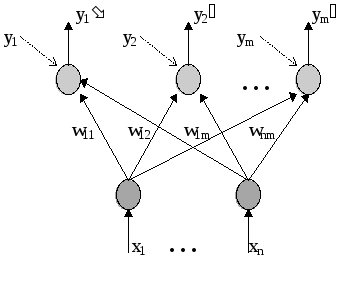

На рис. 2.1 изображена архитектура сети, называемая линейным ассоциатором. Эта нейронная сеть будет использована для обсуждения закона Хебба.

Рис. 2.1.Линейный ассоциатор

Входной

сигнал сети — вектор

![]() ,

распределенный в пространстве

,

распределенный в пространстве

![]() в соответствии с плотностью вероятности

в соответствии с плотностью вероятности

![]() .

Выходные сигналы

.

Выходные сигналы

![]() вычисляются по правилу

вычисляются по правилу

![]() , где

, где

![]() .

ИНС обучается набору из

.

ИНС обучается набору из

![]() пар значений вход-выход

пар значений вход-выход

![]() .

Если один из векторов

.

Если один из векторов

![]() поступает на вход ИНС, то выходной вектор

поступает на вход ИНС, то выходной вектор

![]() должен

принять значение

должен

принять значение

![]() .

В этом случае считается, что сеть

правильно ассоциирует

.

В этом случае считается, что сеть

правильно ассоциирует

![]() с

с

![]() .

Если на вход ИНС поступает вектор

.

Если на вход ИНС поступает вектор

![]() ,

т.е. вектор, близко расположенный к

вектору

,

т.е. вектор, близко расположенный к

вектору

![]() ,

то и выходной вектор должен быть близко

расположен к вектору

,

то и выходной вектор должен быть близко

расположен к вектору

![]() ,

т.е. принимать значение

,

т.е. принимать значение

![]() .

.

Задача,

решаемая линейным ассоциатором, состоит

в поиске наилучшей весовой матрицы

![]() для обеспечения отклика

для обеспечения отклика

![]() на входное воздействие

на входное воздействие

![]() .

.

Основная идея закона обучения Хебба состоит в том, что если на некотором шаге, в некоторый момент времени происходит срабатывание некоторого нейрона сети, то связи, которые являются входными для этого нейрона, должны изменить свои весовые коэффициенты.

Поэтому

закон Хебба выглядит так:![]() ,

где

,

где

![]() и

и

![]() - j-й и i-й компоненты векторов

- j-й и i-й компоненты векторов

![]() и

и

![]() ,

или в матричной форме —

,

или в матричной форме —

![]() .

Предполагается, что перед началом

обучения весовые коэффициенты всех

связей ИН инициируются нулевыми

значениями.

.

Предполагается, что перед началом

обучения весовые коэффициенты всех

связей ИН инициируются нулевыми

значениями.

Значения

весовых коэффициентов можно модифицировать

и после окончания

![]() испытаний. Тогда весовая матрица

формируется после окончания обучения

суммированием всех изменений от

применения каждой обучающей пары:

испытаний. Тогда весовая матрица

формируется после окончания обучения

суммированием всех изменений от

применения каждой обучающей пары:

![]() .

.

Пусть

векторы

![]() ортонормированы, тогда

ортонормированы, тогда

![]()

т.е. линейный ассоциатор работает правильно. Если же выбрать для обучения неортонормированные векторы, то на выходе ИНС появится ошибка:

![]() .

.

Таким

образом, для обучения по методу Хебба

требуются ортонормированные входные

векторы. Такое ограничение означает,

что количество обучающих пар должно

совпадать с размерностью пространства

![]() ,

так как размерность пространства

определяет максимальное количество

ортогональных векторов в нем.

,

так как размерность пространства

определяет максимальное количество

ортогональных векторов в нем.

Существуют методы оптимизации ошибки линейного ассоциатора, однако они требуют отдельного обсуждения.

Ответ

на вопрос, каким образом может быть

найдена матрица

![]() линейного ассоциатора, может быть

получен с использованием методов

линейной алгебры.

линейного ассоциатора, может быть

получен с использованием методов

линейной алгебры.

Даны

![]() пар

пар

![]() обучающих векторов. Среднеквадратическая

ошибка (СКО)

обучающих векторов. Среднеквадратическая

ошибка (СКО)

![]() линейного ассоциатора может быть

определена как

линейного ассоциатора может быть

определена как

![]() .

.

Отсюда

следует, что если

![]()

![]() ортонормированы, то закон обучения

Хебба дает нулевую СКО.

ортонормированы, то закон обучения

Хебба дает нулевую СКО.

Показано

[15], что справедливо выражение

![]()

![]() ,

где

,

где

![]() — матрица

— матрица

![]() векторов

векторов

![]() ,

в которой столбцами являются векторы

,

в которой столбцами являются векторы

![]() ,

,

![]() ;

;

![]() —матрица

—матрица

![]() векторов

векторов

![]() ,

в которой столбцами являются векторы

,

в которой столбцами являются векторы

![]() ,

,

![]() .

.

Поскольку

для некоторой матрицы

![]() справедливо

справедливо

![]() ,

то в терминах матриц

,

то в терминах матриц

![]() и

и

![]() формула для вычисления

формула для вычисления

![]() имеет вид

имеет вид

![]() ,

где

,

где

![]() — псевдообратная матрица1

для матрицы

— псевдообратная матрица1

для матрицы

![]() .

Определение матрицы

.

Определение матрицы

![]() по этой формуле минимизирует СКО

по этой формуле минимизирует СКО

![]() .

.

Следует отметить, что закон Хебба ограничен в своих возможностях. Тем не менее, метод прост и применяется, если для достижения хорошего качества распознавания достаточно обучить сеть на наборе ортонормированных векторов.