- •Глава 1

- •1.2. Процедурные языки

- •1.3. Языки, ориентированные на данные

- •1.4. Объектно-ориентированные языки

- •1.5. Непроцедурные языки

- •1.6. Стандартизация

- •1.7. Архитектура компьютера

- •1.8. Вычислимость

- •1.9. Упражнения

- •Глава 2

- •2.2. Семантика

- •2.3. Данные

- •2.4. Оператор присваивания

- •2.5. Контроль соответствия типов

- •2.7. Подпрограммы

- •2.8. Модули

- •2.9. Упражнения

- •Глава 3

- •3.1. Редактор

- •3.2. Компилятор

- •3.3. Библиотекарь

- •3.4. Компоновщик

- •3.5. Загрузчик

- •3.6. Отладчик

- •3.7. Профилировщик

- •3.8. Средства тестирования

- •3.9. Средства конфигурирования

- •3.10. Интерпретаторы

- •3.11. Упражнения

- •Глава 4

- •4.1. Целочисленные типы

- •I: Integer; -- Целое со знаком в языке Ada

- •4.2. Типы перечисления

- •4.3. Символьный тип

- •4.4. Булев тип

- •4.5. Подтипы

- •4.6. Производные типы

- •4.7. Выражения

- •4.8. Операторы присваивания

- •4.9. Упражнения

- •Глава 5

- •5.1. Записи

- •5.2. Массивы

- •5.3. Массивы и контроль соответствия типов

- •Подтипы массивов в языке Ada

- •5.5. Строковый тип

- •5.6. Многомерные массивы

- •5.7. Реализация массивов

- •5.8. Спецификация представления

- •5.9. Упражнения

- •Глава 6

- •6.1. Операторы switch и case

- •6.2. Условные операторы

- •6.3. Операторы цикла

- •6.4. Цикл for

- •6.5. «Часовые»

- •6.6. Инварианты

- •6.7. Операторы goto

- •6.8. Упражнения

- •Глава 7

- •7.1. Подпрограммы: процедуры и функции

- •7.2. Параметры

- •7.3. Передача параметров подпрограмме

- •7.4. Блочная структура

- •7.5. Рекурсия

- •7.6. Стековая архитектура

- •7.7. Еще о стековой архитектуре

- •7.8. Реализация на процессоре Intel 8086

- •7.9. Упражнения

- •Глава 8

- •8.1 . Указательные типы

- •8.2. Структуры данных

- •8.3. Распределение памяти

- •8.4. Алгоритмы распределения динамической памяти

- •8.5. Упражнения

- •Глава 9

- •9.1. Представление вещественных чисел

- •9.2. Языковая поддержка вещественных чисел

- •9.3. Три смертных греха

- •Вещественные типы в языке Ada

- •9.5. Упражнения

- •Глава 10

- •10.1. Преобразование типов

- •10.2. Перегрузка

- •10.3. Родовые (настраиваемые) сегменты

- •10.4. Вариантные записи

- •10.5. Динамическая диспетчеризация

- •10.6. Упражнения

- •Глава 11

- •11.1. Требования обработки исключительных ситуаций

- •11.2. Исключения в pl/I

- •11.3. Исключения в Ada

- •11.5. Обработка ошибок в языке Eiffei

- •11.6. Упражнения

- •Глава 12

- •12.1. Что такое параллелизм?

- •12.2. Общая память

- •12.3. Проблема взаимных исключений

- •12.4. Мониторы и защищенные переменные

- •12.5. Передача сообщений

- •12.6. Язык параллельного программирования оссаm

- •12.7. Рандеву в языке Ada

- •12.9. Упражнения

- •Глава 13

- •13.1. Раздельная компиляция

- •13.2. Почему необходимы модули?

- •13.3. Пакеты в языке Ada

- •13.4. Абстрактные типы данных в языке Ada

- •13.6. Упражнения

- •Глава 14

- •14.1. Объектно-ориентированное проектирование

- •В каждом объекте должно скрываться одно важное проектное решение.

- •14.3. Наследование

- •14.5. Объектно-ориентированное программирование на языке Ada 95

- •Динамический полиморфизм в языке Ada 95 имеет место, когда фактический параметр относится к cw-типу, а формальный параметр относится к конкретному типу.

- •14.6. Упражнения

- •Глава 15

- •1. Структурированные классы.

- •15.1. Структурированные классы

- •5.2. Доступ к приватным компонентам

- •15.3. Данные класса

- •15.4. Язык программирования Eiffel

- •Если свойство унаследовано от класса предка более чем одним путем, оно используется совместно; в противном случае свойства реплицируются.

- •15.5. Проектные соображения

- •15.6. Методы динамического полиморфизма

- •15.7. Упражнения

- •5Непроцедурные

- •Глава 16

- •16.1. Почему именно функциональное программирование?

- •16.2. Функции

- •16.3. Составные типы

- •16.4. Функции более высокого порядка

- •16.5. Ленивые и жадные вычисления

- •16.6. Исключения

- •16.7. Среда

- •16.8. Упражнения

- •Глава 17

- •17.2. Унификация

- •17.4. Более сложные понятия логического программирования

- •17.5. Упражнения

- •Глава 18

- •18.1. Модель Java

- •18.2. Язык Java

- •18.3. Семантика ссылки

- •18.4. Полиморфные структуры данных

- •18.5. Инкапсуляция

- •18.6. Параллелизм

- •18.7. Библиотеки Java

- •8.8. Упражнения

7.7. Еще о стековой архитектуре

Доступ к переменным на промежуточных уровнях

Мы обсудили, как можно эффективно обращаться к локальным переменным по фиксированным смещениям от указателя дна, указывающего на запись активации. К глобальным данным, т. е. данным, объявленным в главной программе, также можно обращаться эффективно. Это легко увидеть, если рассматривать глобальные данные как локальные для главной процедуры. Память для глобальных данных распределяется при входе в главную процедуру, т. е. в начале программы. Так как их размещение известно на этапе компиляции, точнее, при компоновке, то действительный адрес каждого элемента известен или непосредственно, или как смещение от фиксированной позиции. На практике глобальные данные обычно распределяются независимо (см. раздел 8.3), но в любом случае адреса фиксированы.

Труднее обратиться к переменным на промежуточных уровнях вложения.

procedure Main is

G: Integer,

procedure Proc_1 is

L1: Integer;

Ada |

procedure Proc_2 is

L2: Integer;

begin L2 := L1 + G; end Proc_2;

procedure Proc_3 is

L3: Integer;

begin L3 := L1 + G; Proc_2; end Proc_3;

begin -- Proc_1

Proc_3;

end Proc_1;

begin — Main

Proc_1;

end Main;

Мы видели, что доступ к локальной переменной L3 и глобальной переменной G является простым и эффективным, но как можно обращаться к L1 в Ргос_3? Ответ прост: значение указателя дна сохраняется при входе в процедуру и используется как указатель на запись активации объемлющей процедуры Ргос_1. Указатель дна хранится в известном месте и может быть немедленно загружен, поэтому дополнительные затраты потребуются только на косвенную адресацию.

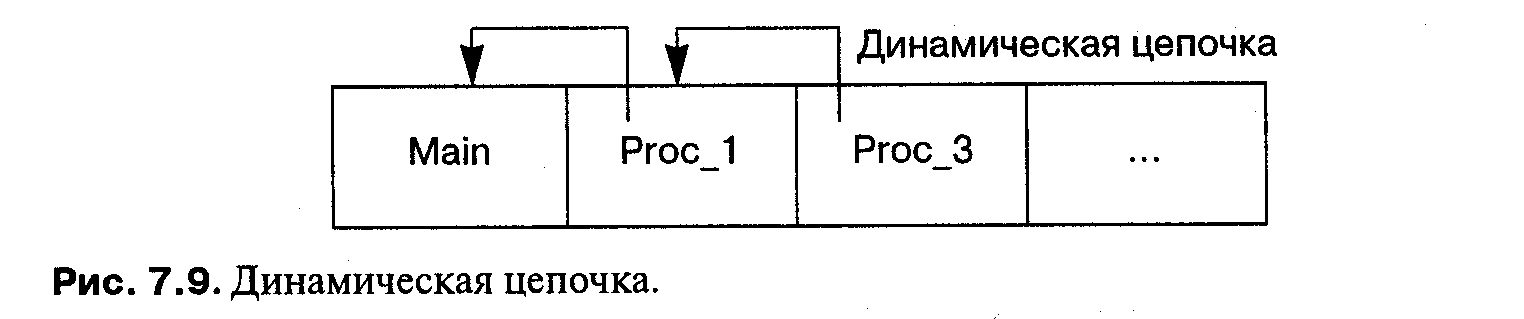

При более глубоком вложении каждая запись активации содержит указатель на предыдущую запись активации. Эти указатели на записи активации образуют динамическую цепочку (см. рис. 7.9). Чтобы обратиться к вышележащей переменной (вложенной менее глубоко), необходимо «подняться» по динамической цепочке. Связанные с этим затраты снижают эффективность работы с переменными промежуточных уровней при большой глубине вложенности. Обращение непосредственно к предыдущему уровню требует только одной косвенной адресации, и эпизодическое глубокое обращение тоже не должно вызывать никаких проблем, но в циклы не следует включать операторы, которые далеко возвращаются по цепочке.

Вызов вышележащих процедур

Доступ к промежуточным переменным фактически еще сложнее, потому что процедуре разрешено вызывать другие процедуры, которые имеют такой же или более низкий уровень вложения. В приведенном примере Ргос_3 вызывает Ргос_2. В записи активации для Ргос_2 хранится указатель дна для процедуры Ргос_3 так, что его можно восстановить, но переменные Ргос_3 недоступны в Ргос_2 в соответствии с правилами области действия.

Так или иначе, программа должна быть в состоянии идентифицировать статическую цепочку, т.е. цепочку записей активации, которая определяет статический контекст процедур согласно правилам области действия, в противоположность динамической цепочке вызовов процедур во время выполнения. В качестве крайнего случая рассмотрим рекурсивную процедуру: в динамической цепочке могут быть десятки записей активации (по одной для каждого рекурсивного вызова), но статическая цепочка будет состоять только из текущей записи и записи для главной процедуры.

Одно из решений состоит в том, чтобы хранить в записи активации статический уровень вложенности каждой процедуры, потому что компилятор знает, какой уровень необходим для каждого доступа. Если главная программа в примере имеет нулевой уровень, то обе процедуры Ргос_2 и Ргос_3 находятся на уровне 2. При продвижении вверх по динамической цепочке уровень вложенности должен уменьшаться на единицу, чтобы его можно было рассматривать как часть статической цепочки; таким образом, запись для Ргос_3 пропускается, и следующая запись, уже запись для Ргос_1 на уровне 1, используется, чтобы получить индекс дна.

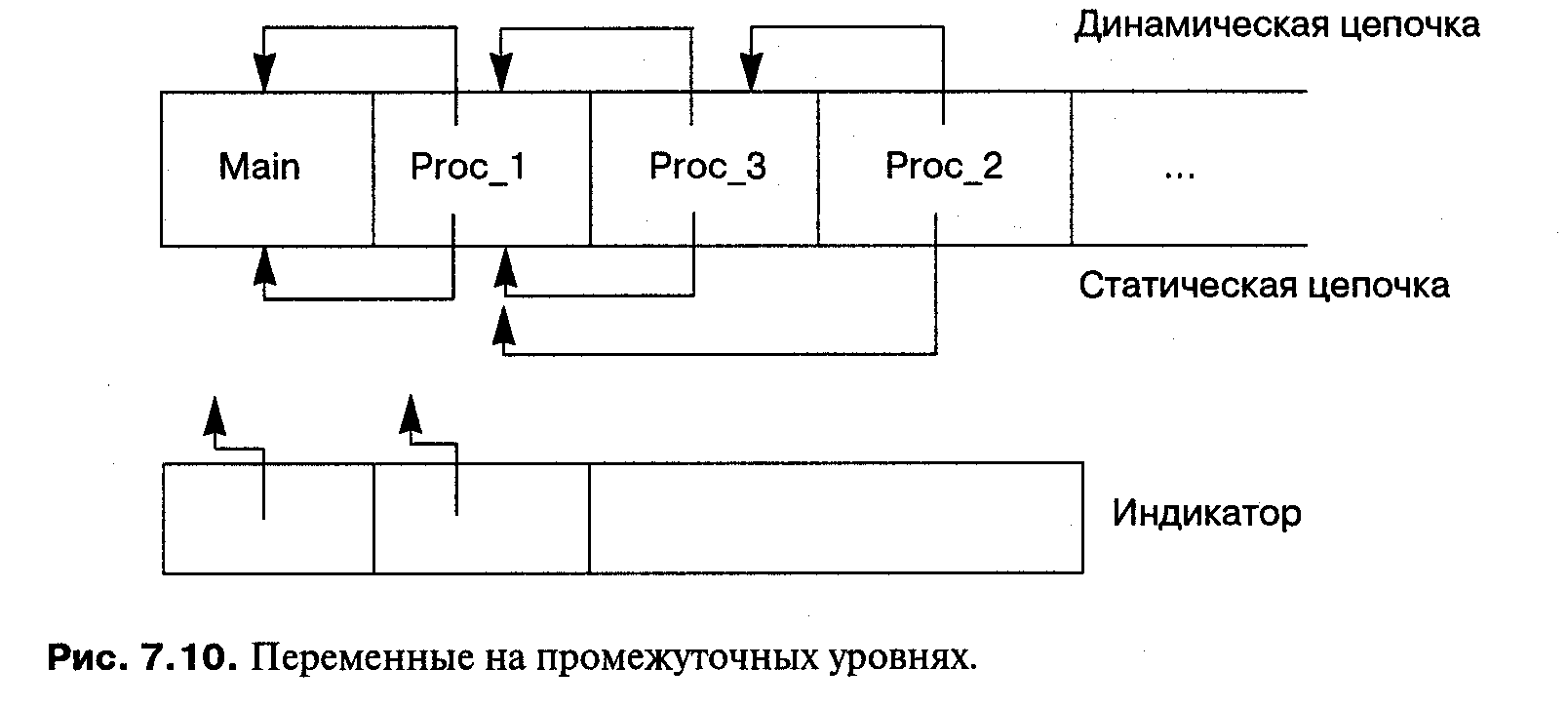

Другое решение состоит в том, чтобы явно включить статическую цепочку в стек. На рисунке 7.10 показана статическая цепочка сразу после вызова Ргос_2 из Ргос_3 . Перед вызовом статическая цепочка точно такая же, как динамическая, а после вызова она стала короче динамической и содержит только главную процедуру и Ргос_1.

Преимущество явной статической цепочки в том, что она часто короче, чем динамическая (вспомните здесь о предельном случае рекурсивной процедуры). Однако мы все еще должны осуществлять поиск при каждом обращении к промежуточной переменной. Более эффективное решение состоит в том, чтобы использовать индикатор, который содержит текущую статическую цепочку в виде массива, индексируемого по уровню вложенности (см. рис. 7.10). В этом случае для обращения к переменной промежуточного уровня, чтобы получить указатель на правильную запись активации, в качестве индекса используется уровень вложенности, затем из записи извлекается указатель дна, и, наконец, прибавляется смещение, чтобы получить адрес переменной. Недостаток индикатора в том, что необходимы дополнительные затраты на его обновление при входе и выходе из процедуры.

Возможная неэффективность доступа к промежуточным переменным не должна служить препятствием к применению вложенных процедур, но программистам следует учитывать такие факторы, как глубина вложенности, и правильно находить компромисс между использованием параметров и прямым доступом к переменным.