- •77. Нечеткие множества и лингвистические переменные. Операции над нечеткими множествами.

- •78. Нечеткие алгоритмы. Общие принципы построения нечетких алгоритмов управления динамическими объектами.

- •79. Процедура синтеза нечетких регуляторов. Синтез адаптивной сау с эталонной моделью на основе нечеткой логики. Нечеткий регулятор Такаги-Сугено.

- •80. Моделирование нейронов мозга. Многослойные персептроны. Алгоритмы обучения. Задача аппроксимации функции.

- •81. Архитектуры нейронных сетей: радиально-базисные сети; нейронные сети Хопфилда; нейронные сети Кохонена; рекуррентные нейронные сети.

- •82. Общие принципы построения нейросетевых систем управления динамическими объектами. Применение нейронных сетей в задачах идентификации динамических объектов.

- •83. Стандартный генетический алгоритм. Пример оптимизации с помощью генетического алгоритма. Модификации генетических алгоритмов и особенности их применения.

- •84. Генетическое программирование. Особенности реализации генетического программирования. Практические примеры построения систем управления с использованием генетических алгоритмов.

80. Моделирование нейронов мозга. Многослойные персептроны. Алгоритмы обучения. Задача аппроксимации функции.

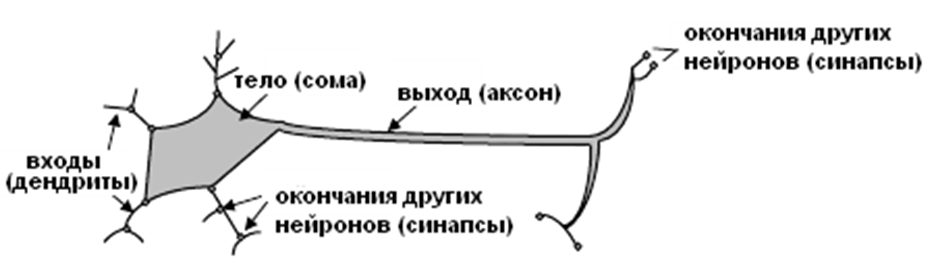

Способностью нейрона является прием, обработка и передача электрических сигналов по нервным путям, которые создают коммуникационную систему мозга.

Рисунок 1. Биологический нейрон

Формальный нейрон (первая модель предложена в 1943 г. У. Мак-Каллоком и В. Питтсом) – это элемент обладающий, следующими свойствами:

он может находиться в одном из двух устойчивых состояний («возбужден» - «невозбужден»), соответственно на выходе – 1 или 0;

для возбуждения нейрона необходимо подать на его входы некоторое количество сигналов, число которых превышает порог возбуждения;

порог возбуждения предполагается неизменным;

имеются 2 вида входов: возбуждающие и тормозящие;

возбуждение любого тормозящего синапса предотвращает возбуждение нейрона, независимо от числа возбуждающих сигналов;

имеет место временная задержка прохождения сигналов в синапсах.

В 1952г. Мак-Каллок усовершенствовал эту модель. В новой модели тормозящие входы эквивалентны возбуждающим. Допускается флуктуация порога возбуждения. Ещё одно важное отличие – введение запрещающего входа, осуществляющего взаимодействие между входами нейрона.

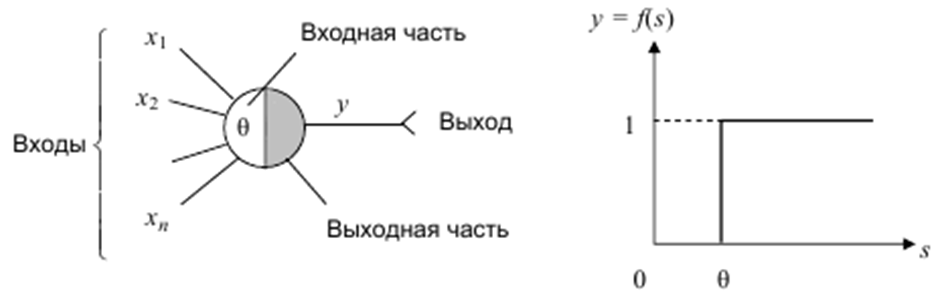

Схема формального нейрона Мак-Каллока-Питтса для случая бинарных сигналов (без тормозящих входов и учета задержки) (f(s) – функция активации):

Условие

возбуждения нейрона:

![]() ,

,

![]() - порог возбуждения нейрона, s

– суммарное возбуждение нейрона, хi

– значение i-го

входа,

- порог возбуждения нейрона, s

– суммарное возбуждение нейрона, хi

– значение i-го

входа,

![]() .

.

Каноническая форма схемы нейрона:

![]() -

дополнительный вход – смещение (bias);

-

дополнительный вход – смещение (bias);

![]() -

веса входов

-

веса входов

![]() ;

;

![]() ;

порог возбуждения принят = 0 (

;

порог возбуждения принят = 0 (![]() ).

).

Т. о. условие возбуждения формального нейрона:

![]() или

или

![]() .

.

Теорема. Для любого логического выражения, удовлетворяющего некоторым условиям, можно найти нейронную сеть составленную из формальных нейронов, поведение которой описывается данным логическим выражением.

Обобщенная модель искусственного нейрона:

На

нейрон поступает набор входных сигналов

![]() .

Каждый входной сигнал xi

умножается на соответствующий ему вес

wi

и поступает на суммирующий блок (

.

Каждый входной сигнал xi

умножается на соответствующий ему вес

wi

и поступает на суммирующий блок (![]() ).

Там вычисляется уровень

активности

s

нейрона:

).

Там вычисляется уровень

активности

s

нейрона:

![]() .

Реакция на выходе нейрона

.

Реакция на выходе нейрона

![]() определяется путем пропускания сигнала

S

через нелинейную функцию f.

Функция f(S)

называется функцией

активации нейрона

и удовлетворяет условиям: а)

определяется путем пропускания сигнала

S

через нелинейную функцию f.

Функция f(S)

называется функцией

активации нейрона

и удовлетворяет условиям: а)

![]() - ограниченность функции; б)

- ограниченность функции; б)

![]() - монотонная (обычно неубывающая) функция

аргумента s.

- монотонная (обычно неубывающая) функция

аргумента s.

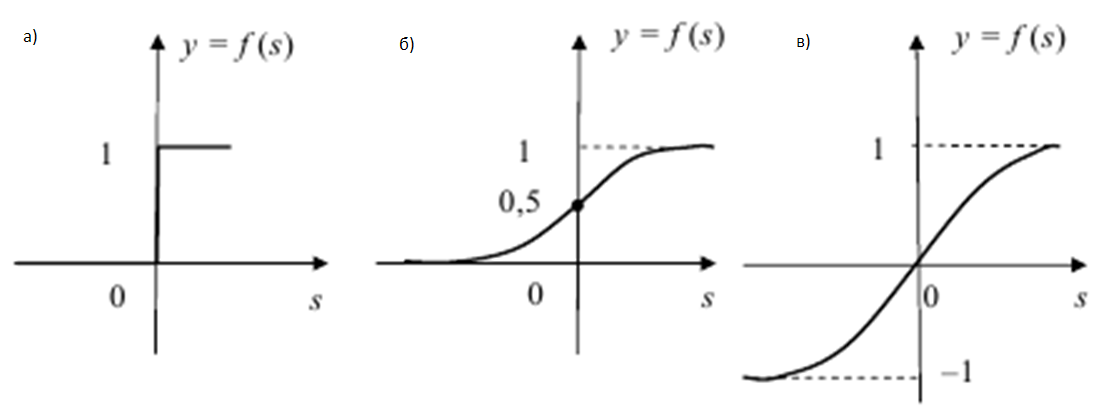

В качестве функций активации на практике используют нелинейные функции вида:

а )

пороговая (логическая) функция:

)

пороговая (логическая) функция:

![]() .

.

б )

сигмоидная (логистическая) функция:

)

сигмоидная (логистическая) функция:

![]() .

.

в)

функция гиперболического тангенса:

![]() .

.

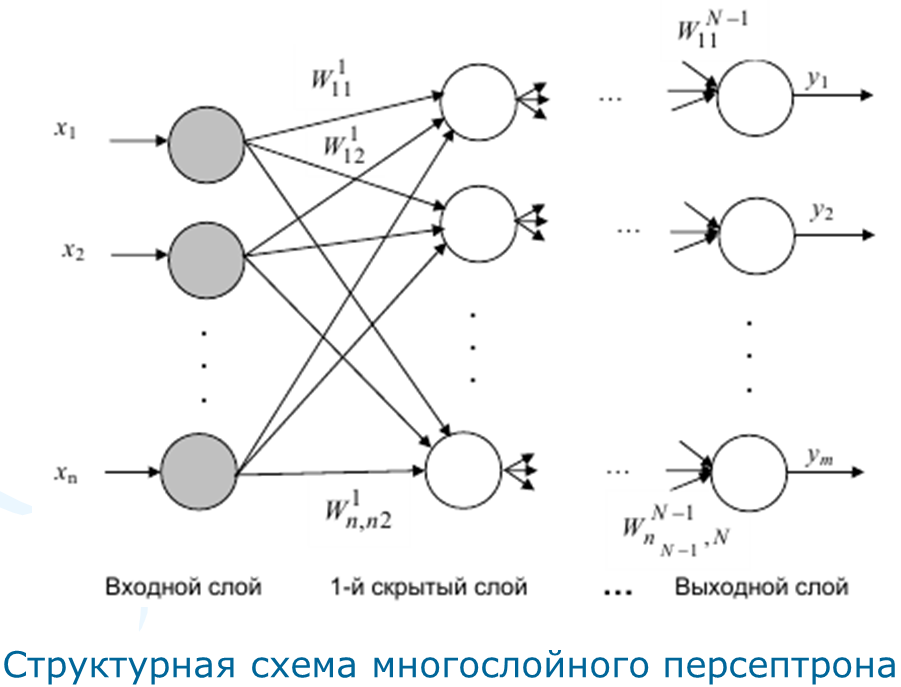

Многослойные персептроны – сети прямого распространения (т.е. без обратных связей).

П усть

усть

![]() набор входных сигналов нейронов

набор входных сигналов нейронов

![]() -го

слоя;

-го

слоя;

![]() - матрица весов синаптических связей,

соединяющих нейроны

-го

слоя с нейронами

- матрица весов синаптических связей,

соединяющих нейроны

-го

слоя с нейронами

![]() -го

слоя,

-го

слоя,

![]() .

Тогда работа персептрона описывается

следующими уравнениями:

.

Тогда работа персептрона описывается

следующими уравнениями:

для входного слоя ( =1):

,

где

,

где

- входной вектор.

- входной вектор.для 1-ого скрытого слоя ( =2):

;

;для 2-ого скрытого слоя ( =3):

;

;

... … … … … … … … …

для входного слоя ( =N):

.

.

![]() -

число нейронов

-го

слоя (

-

число нейронов

-го

слоя (![]() );

N

– число слоев НС;

- функция активации нейрона.

);

N

– число слоев НС;

- функция активации нейрона.

Выбрав

соответствующим образом веса синаптических

связей

![]() можно обеспечит желаемые характеристики

«вход-выход» персептрона в целом.

можно обеспечит желаемые характеристики

«вход-выход» персептрона в целом.

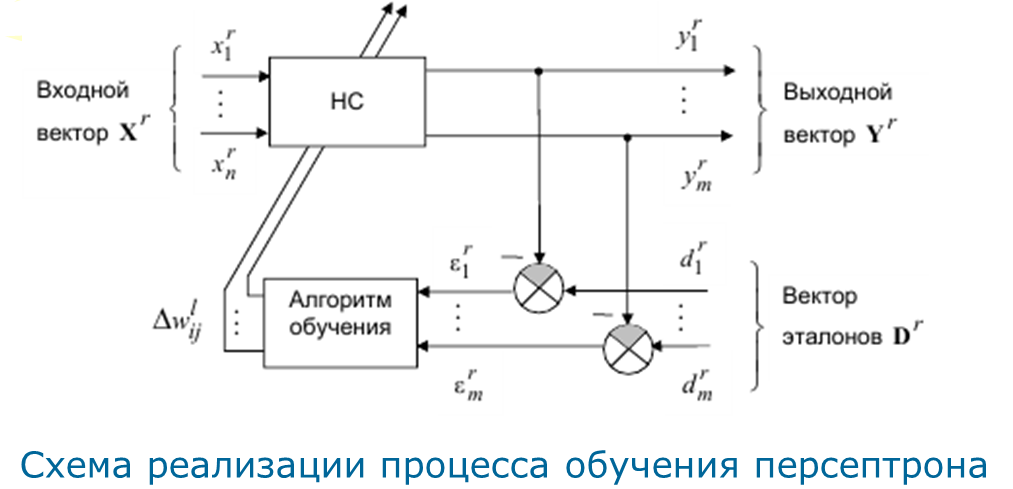

Процедура нахождения весов синаптических связей называется обучением нейронной сети. Процедура обучения сети:

инициализируются случайным образом веса синаптических связей НС.

на входы НС поочередно подаются «образы» (входные векторы)

из обучающей выборки

из обучающей выборки

,

,

- желаемая реакция (вектор «эталонов»)

НС.

- желаемая реакция (вектор «эталонов»)

НС.вычисляется реакция

НС.

НС.вычисляется вектор ошибки сети

вычисляется суммарная квадратичная ошибка

проверка выполнения условия

,

где

,

где

- заданное малое (допустимое) значение

ошибки. Если условие выполняется, то

обучение НС законченно, иначе переходим

к следующему шагу

- заданное малое (допустимое) значение

ошибки. Если условие выполняется, то

обучение НС законченно, иначе переходим

к следующему шагупроизводится изменение весов НС в направлении уменьшения ошибки обучения (

),

после чего – переход к шагу 2.

),

после чего – переход к шагу 2.

Наиболее

простой способ настройки весов НС –

использование градиентного алгоритма

минимизации ошибки Е:

![]()

![]() .

.

Алгоритмы обучения НС

Алгоритм обратного распространения: Суть алгоритма – подстройка весов синаптических связей послойно, начиная с последнего (выходного) и заканчивая 1-м слоем.

Пусть обучающая выборка состоит из одной пары (X,D), т.е. R=1, тогда:

для выходного слоя:

;

;для последнего скрытого слоя:

;

и т.д.

;

и т.д.

Пусть

функция активного нейрона

![]() - сигмоидная функция. Тогда

- сигмоидная функция. Тогда

![]() и получаем:

и получаем:

для выходного слоя:

;

;для последнего скрытого слоя:

…

… … … … … … … … … … … … … … … … …

… … … … … … … … … …

…

… … … … … … … … … … … … … … … … …

… … … … … … … … … …

для первого скрытого слоя:

Т.

о., приращение силы связи

![]() пропорционально произведению сигнала

ошибки

пропорционально произведению сигнала

ошибки

![]() и выходного сигнала

и выходного сигнала

![]() -го

слоя. Вычисляя

и

слой за слоем по направлению ко входу,

можно скорректировать все веса НС.

-го

слоя. Вычисляя

и

слой за слоем по направлению ко входу,

можно скорректировать все веса НС.

Задача аппроксимации функции

Теорема

(А.Н. Колмогоров):

Любая непрерывная функция n

переменных

![]() может быть представлена в виде суммы

конечного числа одномерных функций :

может быть представлена в виде суммы

конечного числа одномерных функций :

,

где

,

где

![]() и

и

![]() - непрерывные и одномерные функции;

- непрерывные и одномерные функции;

![]() - постоянные коэффициенты.

- постоянные коэффициенты.

Теорема: Любую непрерывную функцию нескольких переменных можно с любой степени точности реализовать с помощью трехслойного (считая входной слой) персептрона, имеющего достаточное количество нейронов в скрытом слое.