- •Характеристика основных направлений в исследованиях по искусственному интеллекту.

- •Перспективы искусственного интеллекта.

- •3. Проблемы нейрокибернетики и возможные пути их решения.

- •Искусственный интеллект. Основные понятия.

- •Характеристика программно-прагматического направления в исследованиях по искусственному интеллекту.

- •Характеристика бионического направления в исследованиях по искусственному интеллекту.

- •7.Знания и модели их представления.

- •8.Логические модели представления знаний.

- •9. Продукционные модели представления знаний.

- •10. Сетевые модели представления знаний.

- •11. Фреймовые модели представления знаний.

- •12. Экспертные системы. Основные понятия.

- •13. Обобщенная структура экспертной системы.

- •14. Нейрокомпьютер и основы нейроинформатики.

- •15. Нейрон, нейронные сети. Основные понятия.

- •16. Классификаций нейронных сетей.

- •17. Характеристика моделей нейронных сетей.

- •18. Характеристика многослойных однонаправленных сетей.

- •19. Характеристика полносвязных сетей Хопфилда

- •20,21,22. Характеристика двунаправленной ассоциативной памяти

- •23. Характеристика самоорганизующихся сетей Кохонена

- •24. Области применения нейроинформатики

- •Этапы проектирования экспертной системы

- •26. Классификация интеллектуальных информационных систем

- •27. Организация базы знаний. Формы представления знаний

- •28. Методы рассуждения в интеллектуальных информационных системах

- •2.1 Рассуждения на основе прецедентов

- •2.2 Моделирование рассуждений на основе ограничений

- •2.3 Немонотонные модели рассуждений

- •2.4 Рассуждения о действиях и изменениях

- •2.5 Рассуждения с неопределенностью

- •29.Характеристика этапа постановки задачи и концептуализации при разработке экспертной системы.

- •30.Развитие прототипа до промышленной экспертной системы.

- •31.Характеристика этапа формализации проектирования экспертной системы.

- •32. Характеристика этапов реализации при проектировании экспертной системы

- •33.Характеристика этапа тестирования экспертной системы.

- •34.Характеристика этапа опытной эксплуатации системы

- •37.Приобретение знаний.

- •38.Извлечение знаний из данных.

- •39.Технология разработки экспертных систем.

- •40.Характеристика этапов оценки, стыковки и поддрежки экспертной системы при ее разработке. Этап оценка системы

- •Этап стыковка системы

- •Этап поддержка системы

- •41. Аспекты получения знаний: психологический, лингвистический, гносеологический

- •42. Стратегии получения знаний

- •43. Практические методы извлечения знаний. Их классификация и характеристика

- •44. Структурирование знаний. Концептуальная и функциональная структура предметной области

- •46.Инструментальные средства построения экспертных систем.

18. Характеристика многослойных однонаправленных сетей.

Такие сети называются также сетями прямого распространения, или многослойными персептронами. В дальнейшем (там, где это не может привести к неодноз начности) будем называть такие сети многослойными.

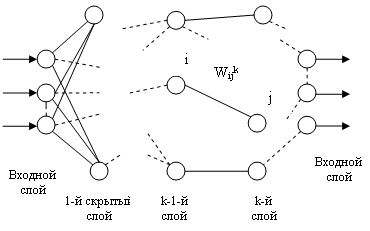

Сети этого типа состоят из нескольких слоев нейронов: входного слоя, выходного и нескольких «скрытых слоев». На рис. 13.3 изображена сеть, у которой К слоев. Нейроны каждого слоя не связаны между собой. Выходной сигнал с каждого ней рона поступает на входы всех нейронов следующего слоя. Нейроны входного слоя не осуществляют преобразования входных сигналов, их функция заключается в распределении этих сигналов между нейронами первого скрытого слоя.

Функционирование многослойной сети осуществляется следующим образом: входной сигнал, подаваемый на сеть, поступает на нейроны входного слоя, прохо дит по очереди через все слои и снимается с выходов нейронов выходного слоя. По мере распространения сигнала по сети он претерпевает ряд преобразований, которые зависят от его начального значения, от преобразующих функций и величин весов связей.

Пусть сеть состоит из К слоев: одного

входного, одного выходного и ( K >-2)

скрытых слоев, — каждый слой состоит

из n ( k ) нейронов. Набор выходных

сигналов нейронов k - ro слоя ( k = 1:

K ) обозначим . Далее обозначим wk набор

весов синаптических связей, соединяющих

нейроны k - 1-го слоя с нейронами k -го

слоя;

![]() — вес связи, соединяющий i - й нейрон

k -1-го слоя c j -м нейроном k -го слоя

— вес связи, соединяющий i - й нейрон

k -1-го слоя c j -м нейроном k -го слоя

![]() Т огда прямое функционирование сети

описывается следующи ми соотношениями:

Т огда прямое функционирование сети

описывается следующи ми соотношениями:

y 1 = x

![]() — выход нейронной сети.

— выход нейронной сети.

Схема многослойной однонаправленной сети

В основе методов обучения многослойных нейросетей наиболее часто лежит так называемое дельта-правило. Дельта-правило используется при обучении с учите лем и реализуется следующим образом:

![]()

где h — параметр (шаг обучения);

d — эталонное (требуемое) значение выхода элемента.

Таким образом, изменение силы связей происходит в соответствии с ошибкой выходного сигнала 5 = ( d — у) и уровнем активности входного элемента х.. Обобщение дельта-правила , называемое обратным распространением ошибки ( Back — propagation ), применимо к сетям с любым числом слоев.

Обучение сети в этом случае состоит из следующих шагов:

1. Выбрать очередную обучающую пару ( х , d ). Подать входной вектор на вход сети.

2. Вычислить выход сети у.

3. Вычислить разность между выходом сети и требуемым выходом (ошибку).

4. Подкорректировать веса сети так, чтобы минимизировать ошибку.

5. Повторять шаги с 1-го по 4-й для каждой обучающей пары, пока ошибка не

достигнет приемлемого уровня.

Ошибка функционирования сети обычно определяется как

![]()

г де у j =

![]() — выход сети.

— выход сети.

Для уменьшения этой ошибки следует изменить веса сети по правилу

![]()

Эта формула описывает процесс градиентного спуска в пространстве весов. Очевидно, для выходного слоя

![]()

Т ак как

![]()

то для промежуточных (скрытых)

слоев (то есть для

![]()

Если в качестве нелинейной преобразующей функции используется сигмоидная функция, то удобно использовать рекуррентные формулы:

![]() - для выходного слоя;

- для выходного слоя;

![]() -для скрытых c лоев ,

-для скрытых c лоев ,

тогда

![]()

Эти соотношения называются формулами обратного распространения ошибки. Если при прямом функционировании входной сигнал распространяется по сети от входного слоя к выходному, то при подстройке весов ошибка сети распростра няется от выходного слоя к входному.

Область применения многослойных

нейросетей обусловлена тем, что они апп

>роксимируют отображение

![]() используя для этого предва рительное

обучение на наборах тренировочных

данных (х 1 , d 1 ), ( x 2 , d 2 ), ..., ( xL , dL

), где de = F ( xe ). Таким образом, сеть

можно рассматривать как модель у = φ ( х

) реального объекта у = F ( x ) . Доказаны

теоремы о том, что с помощью сети с обрат

ным распространением ошибок можно

аппроксимировать любую функцию с любой

точностью.

используя для этого предва рительное

обучение на наборах тренировочных

данных (х 1 , d 1 ), ( x 2 , d 2 ), ..., ( xL , dL

), где de = F ( xe ). Таким образом, сеть

можно рассматривать как модель у = φ ( х

) реального объекта у = F ( x ) . Доказаны

теоремы о том, что с помощью сети с обрат

ным распространением ошибок можно

аппроксимировать любую функцию с любой

точностью.