КОНСПЕКТ ЛЕКЦИЙ КОДЭИ

.pdf

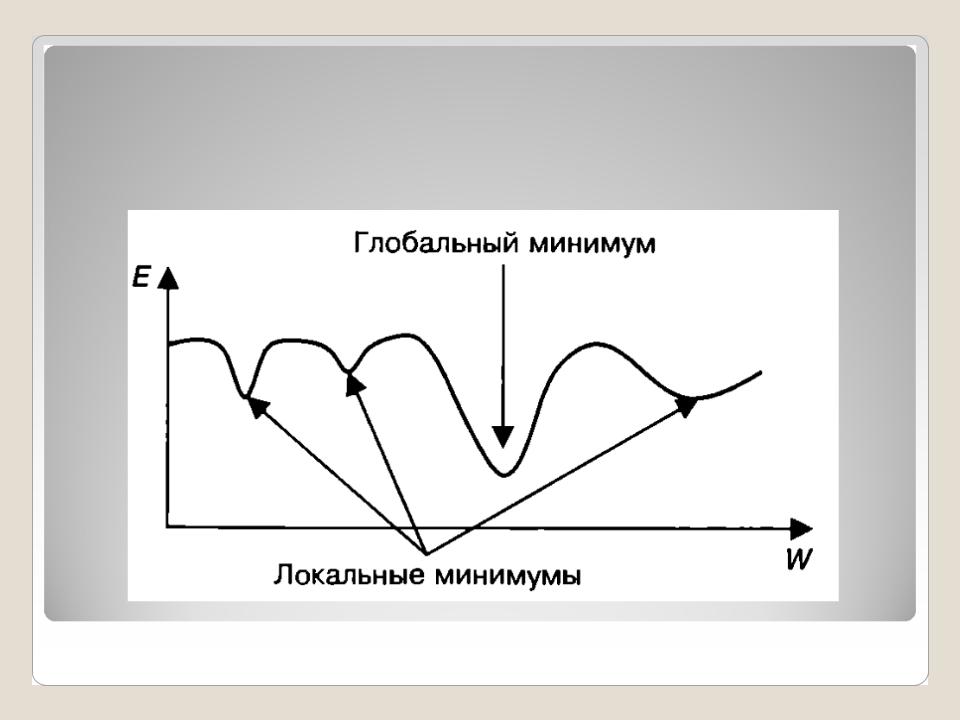

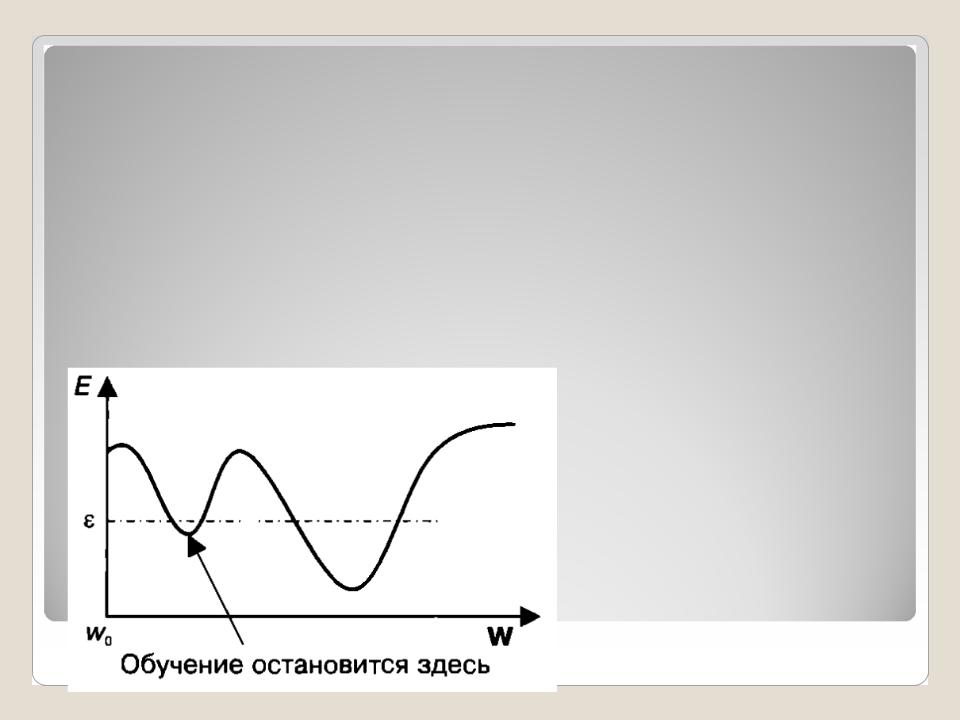

2. Нейронные сети, которые содержат более чем один нейрон в скрытом слое, имеют не одно, а несколько оптимальных состояний, обусловленных наличием у функции ошибки нескольких минимумов. Однако истинно оптимальным состоянием является только одно, где обеспечивается «наименьший», или, как говорят, глобальный, минимум. Остальные минимумы функции ошибки называются локальными. Наличие множества минимумов существенно затрудняет поиск глобального оптимума.

12.03.13 Доцент С.Т. Касюк |

4 |

На рисунке представлена зависимость ошибки сети Е от некоторого обобщенного состояния вектора весов сети W, которая имеет три локальных минимума.

12.03.13 Доцент С.Т. Касюк |

5 |

Внастоящее время для решения задач оптимизации разработано большое количество различных методов. На их основе создаются

алгоритмы обучения нейронных сетей.

Вобщем случае предпочтение следует отдать тому алгоритму, который:

1) позволяет достичь оптимального состояния модели за меньшее число итераций; 2) обладает приемлемыми трудоемкостью и

объемом требуемых вычислительных затрат; 3) обеспечивает наименьшую результирующую ошибку сети; 4) обладает устойчивостью к низкому качеству

данных — наличию в них аномалий, шумов, противоречий и т. д.

12.03.13 Доцент С.Т. Касюк |

6 |

Методы оптимизации, применяемые при обучении нейронных сетей, делятся на два основных направления:

1)методы локальной оптимизации, использующие анализ производной функции ошибки (градиентные методы);

2)методы глобальной оптимизации.

12.03.13 Доцент С.Т. Касюк |

7 |

Нахождение оптимального состояния весов сети можно сравнить с поиском экстремума на выпуклой поверхности. Алгоритм начинает работу со случайного набора весов, а затем делает небольшие коррекции весов в разных направлениях. После этого выбирается та коррекция, которая дает наибольшее сокращение ошибки, а затем процедура повторяется. Можно провести аналогию с нахождением наивысшей точки в холмистой местности. При этом нет гарантии, что вершина, на которой будет остановлен поиск, является самой высокой.

12.03.13 Доцент С.Т. Касюк |

8 |

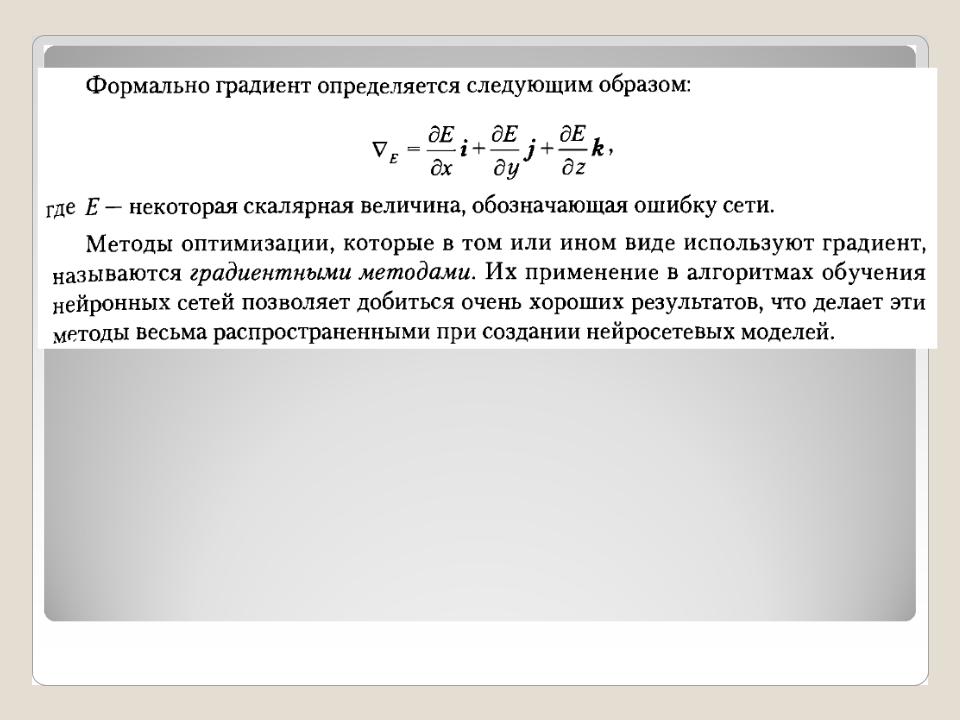

Градиентные методы

Введем в рассмотрение одно из важнейших понятий, используемых при решении задач оптимизации, — градиент (от лат. gradientis — «шагающий»). Это характеристика, показывающая направление наискорейшего возрастания некоторой величины, значение которой меняется от одной точки пространства к другой. Например, если взять высоту поверхности земли над уровнем моря (двумерное пространство), то ее градиент в каждой точке поверхности будет показывать вверх.

12.03.13 |

Доцент С.Т. Касюк |

Операция градиента преобразует «холм», если смотреть на него сверху, в поле векторов, направление которых в каждой точке совпадает с направлением наиболее крутого подъема, а длина пропорциональна крутизне подъема. Видно, что все векторы направлены к вершине. На пологом участке у «подножия холма» длина векторов небольшая. На самом крутом участке векторы имеют максимальную длину. И наконец, там, где вершина «холма» образует купол, длина векторов уменьшается.

12.03.13 |

Доцент С.Т. Касюк |

Коррекция весов нейронной сети в направлении антиградиента функции ошибки называется

градиентным спуском.

12.03.13 |

Доцент С.Т. Касюк |

Методы глобальной оптимизации

Большинство методов обучения нейронных сетей являются локальными, то есть выполняют поиск локальных минимумов функции ошибки. Обучение производится до тех пор, пока алгоритм не достигнет минимума, значение ошибки в котором окажется меньше некоторого заданного порога ε. При этом глобальный минимум, то есть оптимальное состояние сети, не будет достигнут.

Доцент С.Т. Касюк