- •Нейрокомпьютерная техника: Теория и практика

- •Предисловие

- •Благодарности

- •Введение

- •Почему именно искусственные нейронные сети?

- •Свойства искусственных нейронных сетей

- •Обучение

- •Обобщение

- •Абстрагирование

- •Применимость

- •Исторический аспект

- •Искусственные нейронные сети сегодня

- •Перспективы на будущее

- •Искусственные нейронные сети и экспертные системы

- •Соображения надежности

- •Литература

- •Глава 1. Основы искусственных нейронных сетей

- •Биологический прототип

- •Искусственный нейрон

- •Активационные функции

- •Однослойные искусственные нейронные сети

- •Многослойные искусственные нейронные сети

- •Нелинейная активационная функция

- •Сети с обратными связями

- •Терминология, обозначения и схематическое изображение искусственных нейронных сетей

- •Терминология

- •Дифференциальные уравнения или разностные уравнения

- •Графическое представление

- •Обучение искусственных нейронных сетей

- •Цель обучения

- •Обучение с учителем

- •Обучение без учителя

- •Алгоритмы обучения

- •Литература

- •Глава 2. Персептроны персептроны и зарождение искусственных нейронных сетей

- •Персептронная представляемость

- •Проблема функции исключающее или

- •Линейная разделимость

- •Преодоление ограничения линейной разделимости

- •Эффективность запоминания

- •Обучение персептрона

- •Алгоритм обучения персептрона

- •Дельта-правило

- •Трудности с алгоритмом обучения персептрона

- •Литература

- •Глава 3. Процедура обратного распространения

- •Введение в процедуру обратного распространения

- •Обучающий алгоритм обратного распространения

- •Сетевые конфигурации

- •Многослойная сеть.

- •Обзор обучения

- •Дальнейшие алгоритмические разработки

- •Применения

- •Предостережение

- •Паралич сети

- •Локальные минимумы

- •Размер шага

- •Временная неустойчивость

- •Литература

- •Глава 4. Сети встречного распространения

- •Введение в сети встречного распространения

- •Структура сети

- •Нормальное функционирование

- •Слои Кохоненна

- •Слой Гроссберга

- •Обучение слоя кохонена

- •Предварительная обработка входных векторов

- •Выбор начальных значений весовых векторов

- •Режим интерполяции

- •Статистические свойства обученной сети

- •Обучение слоя гроссберга

- •Сеть встречного распространения полностью

- •Приложение: сжатие данных

- •Обсуждение

- •Литература

- •Глава 5. Стохастические методы

- •Использование обучения

- •Больцмановское обучение

- •Обучение Коши

- •Метод искусственной теплоемкости

- •Приложения к общим нелинейным задачам оптимизации

- •Обратное распространение и обучение коши

- •Трудности, связанные с обратным распространением

- •Трудности с алгоритмом обучения Коши

- •Комбинирование обратного распространения с обучением Коши

- •Обсуждение

- •Литература

- •Глава 6. Сети Хопфилда

- •Конфигурации сетей с обратными связями

- •Бинарные системы

- •Устойчивость

- •Ассоциативная память

- •Непрерывные системы

- •Сети Хопфилда и машина Больцмана

- •Термодинамические системы

- •Статистичекие сети Хопфилда

- •Обобщенные сети

- •Приложения

- •Аналого-цифровой преобразователь

- •Задача коммивояжера

- •Обсуждение

- •Локальные минимумы

- •Скорость

- •Функция энергии

- •Емкость сети

- •Литература

- •Глава 7. Двунаправленная ассоциативная память

- •Структура дап

- •Восстановление запомненных ассоциаций

- •Кодирование ассоциаций

- •Емкость памяти

- •Непрерывная дап

- •Адаптивная дап

- •Конкурирующая дап

- •Заключение

- •Литература

- •Глава 8. Адаптивная резонансная теория

- •Архитектура apt

- •Описание apt

- •Упрощенная архитектура apt

- •Функционирование сети apTв процессе классификации

- •Реализация apt

- •Функционирование сетей apt

- •Пример обучения сети apt

- •Характеристики apt

- •Инициализация весовых векторов т

- •Настройка весовых векторов Вj

- •Инициализация весов bij

- •Теоремы apt

- •Заключение

- •Литература

- •Глава 9. Оптические нейронные сети

- •Векторно-матричные умножители

- •Электронно-оптические матричные умножители

- •Сети Хопфилда на базе электронно-оптических матричных умножителей

- •Голографические корреляторы

- •Объемные голограммы

- •Оптическая сеть Хопфилда, использующая объемные голограммы

- •Заключение

- •Литература

- •Глава 10. Когнитрон и неокогнитрон

- •Когнитрон

- •Структура

- •Обучение

- •Неокогнитрон

- •Структура

- •Обобщение

- •Вычисления

- •Обучение

- •Заключение

- •Литература

- •Приложение а. Биологические нейронные сети

- •Человеческий мозг: биологическая модель для искусственных нейронных сетей

- •Организация человеческого мозга

- •Мембрана клетки

- •Компьютеры и человеческий мозг

- •Приложение б. Алгоритмы обучения

- •Обучение с учителем и без учителя

- •Метод обучения хэбба

- •Алгоритм обучения Хэбба

- •Метод сигнального обучения Хэбба

- •Метод дифференциального обучения Хэбба

- •Входные и выходные звезды

- •Обучение входной звезды

- •Обучение выходной звезды

- •Обучение персептрона

- •Метод обучения уидроу-хоффа

- •Методы статистического обучения

- •Самоорганизация

- •Литература

Характеристики apt

Системы APTимеют ряд важных характеристик, не являющихся очевидными. Формулы и алгоритмы могут казаться произвольными, в то время как в действительности они были тщательно отобраны с целью удовлетворения требований теорем относительно производительности систем APT.В данном разделе описываются некоторые алгоритмы APT,раскрывающие отдельные вопросы инициализации и обучения.

Инициализация весовых векторов т

Из ранее рассмотренного примера обучения сети можно было видеть, что правило двух третей приводит к вычислению вектора Скак функции И между входным векторомХи выигравшим соревнование запомненным векторомТj. Следовательно, любая компонента вектораСбудет равна единице в том случае, если соответствующие компоненты обоих векторов равны единице. После обучения эти компоненты вектораТjостаются единичными; все остальные устанавливаются в нуль.

Это объясняет, почему веса tijдолжны инициализироваться единичными значениями. Если бы они были проинициализированы нулевыми значениями, все компоненты вектораСбыли бы нулевыми независимо от значений компонент входного вектора, и обучающий алгоритм предохранял бы веса от изменения их нулевых значений.

Обучение может рассматриваться как процесс «сокращения» компонент запомненных векторов, которые не соответствуют входным векторам. Этот процесс необратим, если вес однажды установлен в нуль, обучающий алгоритм никогда не восстановит его единичное значение.

Это свойство имеет важное отношение к процессу обучения. Предположим, что группа точно соответствующих векторов должна быть классифицирована к одной категории, определяемой возбуждением одного нейрона в слое распознавания. Если эти вектора последовательно предъявляются сети, при предъявлении первого будет распределяться нейрон распознающего слоя, его веса будут обучены с целью соответствия входному вектору. Обучение при предъявлении остальных векторов будет приводить к обнулению весов в тех позициях, которые имеют нулевые значения в любом из входных векторов. Таким образом, запомненный вектор представляет собой логическое пересечение всех обучающих векторов и может включать существенные характеристики данной категории весов. Новый вектор, включающий только существенные характеристики, будет соответствовать этой категории. Таким образом, сеть корректно распознает образ, никогда не виденный ранее, т. е. реализуется возможность, напоминающая процесс восприятия человека.

Настройка весовых векторов Вj

Выражение, описывающее процесс настройки весов (выражение (8.6) повторено здесь для справки) является центральным для описания процесса функционирования сетей APT.

(8.6)

(8.6)

Сумма в знаменателе представляет собой количество единиц на выходе слоя сравнения. Эта величина может быть рассмотрена как «размер» этого вектора. В такой интерпретации «большие» векторы Спроизводят более маленькие величины весовbij,чем «маленькие» вектораС. Это свойство самомасштабирования делает возможным разделение двух векторов в случае, когда один вектор является поднабором другого; т. е. когда набор единичных компонент одного вектора составляет подмножество единичных компонент другого.

Чтобы продемонстрировать проблему, возникающую при отсутствии масштабирования, используемого в выражении (8.6), предположим, что сеть обучена двум приведенным ниже входным векторам, при этом каждому распределен нейрон в слое распознавания.

Заметим, что Х1является поднаборомХ2. В отсутствие свойства масштабирования весаbijи tijполучат значения, идентичные значениям входных векторов. Если начальные значения выбраны равными 1,0, веса образов будут иметь следующие значения:

Если Хприкладывается повторно, оба нейрона в слое распознавания получают одинаковые активации; следовательно, нейрон 2, ошибочный нейрон, выиграет конкуренцию.

Кроме выполнения некорректной классификации, может быть нарушен процесс обучения. Так какТ2равно 1 1 1 0 0, только первая единица соответствует единице входного вектора, иСустанавливается в 1 0 0 0 0, критерий сходства удовлетворяется и алгоритм обучения устанавливает вторую и третью единицы векторовТ2иВ2в нуль, разрушая запомненный образ.

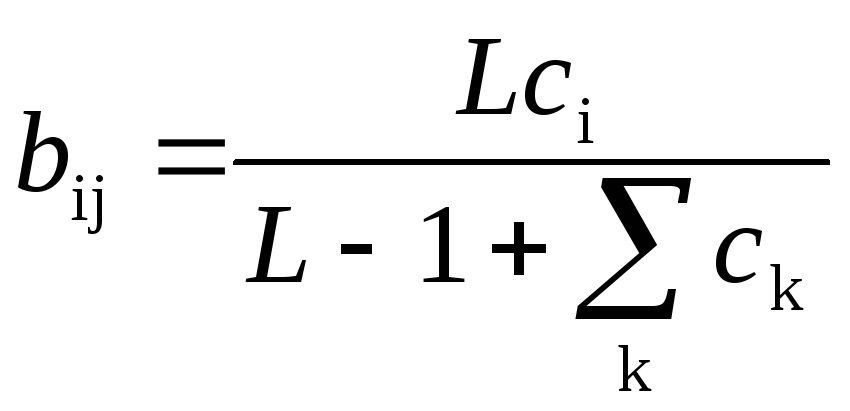

Масштабирование весов bijпредотвращает это нежелательное поведение. Предположим, что в выражении (8.2) используется значение L=2,тем самым определяя следующую формулу:

Значения векторов будут тогда стремиться к величинам

Подавая на вход сети вектор Х1, получим возбуждающее воздействие 1,0 для нейрона 1 в слое распознавания и ½ для нейрона 2; таким образом, нейрон 1 (правильный) выиграет соревнование. Аналогично предъявление вектораХ2вызовет уровень возбуждения 1,0 для нейрона 1 и 3/2 для нейрона 2, тем самым снова правильно выбирая победителя.