978-5-7764-0767-3

.pdf

Для приобретения знаний (формирования новых решений) с применени-

ем эволюционных моделей могут использоваться генетические алгоритмы,

генетическое программирование, обучающиеся классификаторы, эволюци-

онное программирование, искусственная жизнь [8,15,22].

Математическая

статистика

Классические

Экспериментальные методы математические

дисциплины

|

Машинное |

|

Интеллектуальный |

обучение |

Методы |

|

||

анализ |

|

индуктивного |

|

|

|

данных |

|

обучения |

Когнитивная |

Инженерия |

инженерия |

знаний |

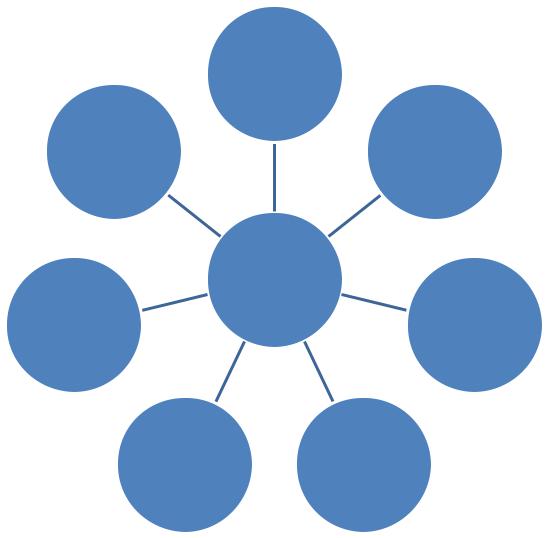

Рис. 4.5. Междисциплинарный характер машинного обучения

В контексте решения задач непрерывного образования в авиакосмиче-

ской области с использованием эволюционирующих знаний, особое внима-

ние уделяется методам машинного обучения, основанным на символьном представлении информации и знаний. К настоящему времени известны и широко используются различные подходы и методы в системах машинного обучения. Машинное обучение является мультидисциплинарным направле-

нием ИИ и находится на стыке математической статистики, методов оптими-

зации, классических математических дисциплин, методов индуктивного обу-

151

чения, как альтернативы статическим подходам, извлечением информации,

интеллектуальным анализом данных, экспериментальных методов (рис. 4.5).

В основе машинного обучения, использующего символьное представление информации и знаний, применяется множество прецедентов (примеров, си-

туаций, объектов), для каждого из которых подобраны соответствующие данные, являющиеся их описанием. Множество прецедентов, используемых для обучения, представляют собой обучающую выборку.

В общем виде модель обучения может быть представлена следующим образом. Имеются:

обучающая выборка, представляющая собой набор признаков, описыва-

ющих ситуации реального мира и поступающих на вход системы обучения – множество входных сигналов XL = (x1, x2, … , xn);

соответствующее множество выходов YL = (y1, y2, … , yn);

искомое отображение (классификация, интерпретация) χL (χL XL YL),

являющееся истинным и известное только учителю. Данное отображение осуществляет преобразование набора входных признаков в выходное значе-

ние XL → YL;

множество отображений {fL} F из некоторого класса F (fL: XL YL),

которые строятся системой в процессе обучения;

критерий обучения QL = QL (χL, fL), отражающий степень близости клас-

сификации (интерпретации) fL, сформированной системой в ходе обучения, к

истинной классификации (интерпретации) известной учителю χL.

В соответствии с заданными обозначениями задача обучения L может быть представлена следующей пятеркой:

L = < XL , YL , χL, F, QL >

Существует множество подходов к представлению и решению задач обучения в различных областях. Наибольшее распространение методы обу-

чения получили в рамках исследований по распознаванию образов.

152

Формальная модель обучения новым понятиям L, с использованием ин-

тегрированного метода представления знаний, может быть представлена сле-

дующим образом.

Имеются:

примеры ситуаций в виде наборов признаков, поступающих на вход си-

стемы обучения (подсистемы обучения системы управления базой зна-

ний) – множество признаков активизации концептов (ПАК) (вершин классификатора, понятий)

ПАКL = (пак1, пак2, … , пакML);

множество концептов (формируемых вершин классификатора) которые могут соответствовать предъявляемым примерам ситуаций

GL = ({gi}, i (1, 2, … , NG)),

где {gi} – множество формируемых понятий,

NG – максимально возможное число вершин классификатора;

множество связей от активизированных вершин (концептов), которые должны обеспечить активность той вершины классификатора, которая наиболее (идеально) соответствует предъявляемой ситуации

ŘL (ŘL ПАКL GL),

где ŘG – множество связей от активированных вершин к формируемой,

которые наиболее соответствуют рассматриваемой ситуации;

множество связей от активизированных вершин к формируемой, кото-

рые сформированы системой

RL (RL: ПАКL GL);

критерий успешности обучения QL = QL (ŘG, RG), отражающий степень близости распознавания с помощью связей RG, сформированных сис-

темой в ходе обучения, к распознаванию с помощью связей наиболее

(идеально) соответствующих рассматриваемой ситуации ŘL.

Вэтом случае задача обучения L может быть формально представлена как некоторая оптимизационная модель, определяемая пятеркой

L = <ПАКL, GL, ŘL, RL, QL>

153

Вводится понятие алгоритма А, решающего задачу обучения L, а также понятие алгоритмической сложности С(А,n) алгоритма А в зависимости от размерности задачи n.

Требуется найти такой А*, для которого С(А*,n) → min.

До последнего времени, одним из распространенных являлось обучение по примерам. Формально этот вид обучения может быть представлен следу-

ющим образом:

Задаются примеры (обучающая последовательность)

{( пак1 g1, ŕ 1), ( пак2 g2, ŕ 2), … , {( пакn gn, ŕ n)}.

Необходимо сформировать такое множество связей r* RL (найти такую классификацию), которое бы по возможности приближалось к множеству связей наиболее (идеально) соответствующих рассматриваемой ситуации ŘL

(классификации учителя) и минимизировало используемый критерий каче-

ства обучения QL = QL (ŘG, RG), на обучающей и проверочной выборке ПАК = ПАКL ПАКпров,

где ПАКпров – проверочная выборка.

Математическая модель задачи обучения в этой постановке имеет вид:

{ QL (ŘL, RL,ПАК)}.

Общая постановка задачи обучения может быть представлена следую-

щим образом.

Имеется конечное (или достаточно обозримое) множество ситуаций

(объектов, концептов) с некоторыми данными – описаниями. Совокупность всех описаний ситуаций (прецедентов) представляет обучающую выборку.

Требуется по заданной обучающей выборке выявить общие зависимости, за-

кономерности, взаимосвязи, свойственные не только заданной обучающей выборке, но и всем ситуациям (объектам, прецедентам), которые еще не наблюдались.

Для описания ситуаций часто используется признаковое описание, пред-

ставляющее собой совокупность k показателей, которые измеряются для всех

154

ситуаций. Решение задачи начинается с выбора модели восстанавливаемой зависимости. Для оценки, насколько хорошо модель описывает наблюдаемые ситуации, вводится функционал качества. С помощью вычислительных про-

цедур ведется настройка модели так, чтобы функционал качества, для ис-

пользуемой обучающей выборки, принимал оптимальное значение.

В дальнейшем рассматриваются существующие подходы к обучению на основе символьного представления действительности. В рамках этого направления происходит явное представление в кибернетической системе знаний об области определения задачи. В ходе функционирования, накапли-

вая свой опыт, обучаемая система строит или модифицирует выражение на формальном языке и сохраняет полученные знания для дальнейшего исполь-

зования. Подходы к обучению, в данном направлении, строятся на предпо-

ложении, что основное влияние на поведение системы оказывают знания об области определения в их явном представлении.

Кнастоящему времени разработано и используется множество методов

иподходов к машинному обучению. Ниже рассматриваются некоторые (из наиболее известных и используемых) методы машинного обучения.

Классификация понятий. В основу большинства рассматриваемых систем заложено индуктивное формирование понятий [6], которое сводит-

ся к выделению конъюнкций значений признаков в положительной (отри-

цательной) выборке примеров или в отдельных их частях. Результатом анализа обучающей выборки L, содержащей объекты, заданные явным набором признаков, является ряд понятий. В самом простом случае каж-

дому из значений признаков объектов (примеров) выборки ставится в со-

ответствие переменная, принимающая значение «1» или «0», в зависимо-

сти от того, имеет или не имеет объект данное значение признака. С уче-

том этого объект может быть описан логическими выражениями, имею-

щими значение «1» для всех положительных объектов этого понятия и значение «0» – для отрицательных объектов [6].

155

Простейшим понятием является конъюнктивное понятие, описываемое

конъюнкцией значений признаков, т.е. выражением вида i sij , где Sij – j-е

значение i- го признака.

Под простым понятием понимается понятие вида i j sij , содержащее

только значения признаков положительных объектов. Например,

(S11 S12) (S22 S23 S27).

В конъюнктивных понятиях с исключающими признаками, кроме зна-

чений признаков положительных объектов присутствуют значения призна-

ков, которыми отличаются отрицательные объекты от положительных.

Простое понятие с исключающими признаками в качестве дизъюнктов могут содержать значения того или иного признака, взятого с отрицанием.

Алгоритм формирования конъюнктивных понятий. Предложен Пен-

нипэкером (Pennypacker) [14,58,62]. В основу алгоритма положены психоло-

гические эксперименты Брунера, Гуднау и Остина [36]. Брунер и его коллеги описывают стратегию, которая применяется некоторыми испытуемыми в про-

цессе формирования понятий. Она состоит из следующих шагов.

1.Начинать с положительного примера, т.е. с объекта, содержащего все значения, определяющие понятия. Запомнить в качестве гипотезы эти значения по каждому из признаков.

2.Изменять гипотезу только тогда, когда представлен пример положи-

тельного объекта понятия, отличающийся от гипотезы. Формировать новую гипотезу, которая включает в себя только те значения призна-

ков, которые являются общими, как для предыдущей гипотезы, так и для данного примера.

Такие действия продолжаются до того момента, пока не будут про-

анализированы все примеры обучающей выборки.

Алгоритм формирования простых понятий. Предложен Виндекнех-

том и программно реализован Шнедикером [62]. Идея данного алгоритма состоит в следующем [6]:

156

В процессе обучения при вводе положительных объектов обучающей

выборки строится последовательность множеств K,K,K,...K,, в которой

1 2 m

каждое последующее множество образуется из предыдущего путем изъятия значений признаков, входящих в описание очередного положительного объ-

екта. Через K обозначено множество всех значений признаков.

Аналогичная последовательность K,K,K,...K, формируется при

1 2 n

вводе отрицательных объектов. Если через V(K) обозначить объем просто-

го понятия, построенного из значений признаков, составляющих множество К, то условие окончания работы алгоритма определяется получением мно-

|

K |

|

K |

|

|

|

|

|

|

жеств |

m и |

n |

, для которых |

V(K ) X2 |

и |

V(K ) X1 |

|||

|

|

m |

n |

, где X1 и Х2 соот- |

|||||

ветственно множества всех положительных и отрицательных объектов.

Алгоритм Кочена [14]. По методу Кочена понятия строятся в виде дизъюнкций конъюнкций значений признаков. Понятие формируется путем последовательного анализа объектов обучающей выборки, в процессе кото-

рого очередной объект сопоставляется со всеми предыдущими объектами и понятием, построенным к моменту его ввода.

В случае если понятие, построенное к моменту ввода объекта, не обеспечивает его правильное распознавание, осуществляется корректировка понятия. Алгоритм корректировки имеет следующий вид.

1.Для нового положительного объекта делается попытка отыскать в уже построенном понятии конъюнкцию, которую можно было бы изменить путем исключения одного или нескольких значений признаков так, чтобы новый объект распознавался правильно и не нарушалось распознавание предыдущих объектов.

2.Для нового отрицательного объекта делается попытка отыскать в уже построенном понятии конъюнкцию, которую можно было бы изменить путем добавления одного значения признака так, чтобы новый объект рас-

познавался правильно и не нарушалось распознавание предыдущих объек-

тов.

157

3. Если для нового положительного объекта п.1 невыполним, то к поня-

тию через знак дизъюнкции добавляется новая конъюнкция, обеспечиваю-

щая правильное распознавание нового объекта и не нарушающая распозна-

вание предыдущих объектов.

4. Если для нового отрицательного объекта п.2 невыполним, то все конъюнкции, за счет которых новый объект распознается неправильно,

разбиваются на две части, каждая из которых образуется путем добавления к исходной конъюнкции значения признака, обеспечивающего правильное распознавание нового объекта.

Алгоритм Бонгарда. Понятие отыскивается в форме дизъюнкции конъюнкций переменных или их отрицаний [2]. Отбор признаков (отдельных конъюнкций переменных или их отрицаний) выполняется с учетом следую-

щих требований-действий.

1. Сформированное понятие должно содержать небольшое число конъ-

юнкций, соединенных связкой «или».

2. При отборе конъюнкций вводится некоторый порог Р, характеризу-

ющий число объектов, охваченных выбранной конъюнкцией. Если при задан-

ном пороге Р не удается построить понятие, разделяющее объекты обуча-

ющей выборки на положительные и отрицательные, то значение Р уменьша-

ется, что эквивалентно готовности удовольствоваться более «длинными» понятиями.

3.Конъюнкция, характеризующая объекты одного класса, не должна удовлетворять ни одному объекту другого класса.

4.Один из важнейших критериев отбора конъюнкций связан с провер-

кой степени независимости разных признаков.

В результате работы алгоритма, учитывающего перечисленные крите-

рии, образуется описание класса объектов, состоящее из двух таблиц. Одна из таблиц содержит признаки, входящие в описание всех положительных объектов обучающей выборки, другая – признаки, не принадлежащие ни од-

ному из положительных объектов. На этапе распознавания объект считается

158

положительным, если его описание содержит хотя бы один признак первой таблицы и ни одного признака второй.

Алгоритм Ханта предполагает выполнение следующих действий [33].

1. На первом шаге предпринимается попытка отыскать среди, объектов обучающей выборки значение признака или группу значений признаков,

присутствующих в описаниях всех положительных объектов и не встречаю-

щихся ни в одном из описаний отрицательных объектов. При нахождении такой группы значений признаков работа алгоритма оканчивается. В каче-

стве выделенного понятия берется конъюнкция всех значений признаков,

входящих в группу.

2. При отрицательном исходе действий п. I делается попытка выпол-

нить такую же процедуру для отрицательных объектов. При нахождении та-

кой группы значений признаков, общих для всех отрицательных объектов и не встречающихся ни в одном из описаний положительных объектов, работа алгоритма оканчивается и в качестве выделенного понятия берется отрица-

ние конъюнкции всех значений признаков, входящих в группу.

3. Если действия, выполняемые в п.2, оказывается безрезультатными,

выделяется значение признака, наиболее часто встречающееся в описаниях положительных объектов.

4. Обучающая выборка разбивается на две подвыборки:

1) состоящую из всех объектов, которые содержат значение признака,

отобранное в п.З; 2) состоящую из остальных объектов. В случае, если среди получен-

ных подвыборок имеется подвыборки, содержащие как положительные, так и отрицательные объекты, для них повторяются действия, начиная с п. 1.

Работа алгоритма оканчивается, если не остается ни одной подвы-

борки, которая бы содержала и положительные, и отрицательные объекты.

Процесс формирования понятий по описанному алгоритму может быть пред-

ставлен «деревом» последовательных решений, по которому можно восста-

новить логическую структуру понятий.

159

Алгоритм Гладуна. Система формирования понятий Гладуна [4,5,6]

основывается на растущих пирамидальных сетях (РПС). РПС состоит из ре-

цепторов, воспринимающих значения признаков объектов и ассоциативных элементов, которые отражают взаимосвязь значений признаков объектов обучающей выборки. Каждый рецептор соответствует одному значению при-

знака. Ассоциативный элемент производит выходной сигнал, если в течение определенного интервала времени поступают сигналы на все его входы.

Восприятие объекта осуществляется путем одновременной подачи значений признаков на входы рецепторов [4,5].

Каждому элементу сети ставятся в соответствие два числа К и М: где К – число возбуждений этого элемента при восприятии всех положи-

тельных объектов обучающей выборки;

М – число рецепторов, связанных с теми элементами РПС, от которых имеются пути к данному элементу.

В процессе обучения в РПС выделяются специальные элементы, с по-

мощью которых в дальнейшем осуществляется распознавание объектов из объема понятия. Их называют положительными или отрицательными кон-

трольными элементами данного понятия. В результате восприятия положи-

тельных и отрицательных объектов обучающей выборки алгоритмом строит-

ся понятие о множестве положительных объектов. Образуемые понятия со-

держат отличительные признаки отрицательных объектов, т.е. принадлежат к классу понятий с исключающими признаками.

Понятие, которое создается в результате выполнения алгоритма, отоб-

ражено в структуре РПС, Для его использования в режиме экзамена, т.е. для проверки с помощью сформированного понятия принадлежности произволь-

ного объекта объему этого понятия, необходимо сохранить сеть, построен-

ную в процессе обучения.

Системы индуктивного обучения для изучения понятий начинают свою работу с набора положительных (частично) отрицательных примеров целевого класса [15,22]. В результате обучения должно сформироваться об-

160