- •Теория вероятностей и математическая статистика Основные понятия теории вероятностей Рекомендуемая литература

- •1.1. Предмет теории вероятностей

- •1.2. Области применения теории вероятностей

- •1.3. Краткая историческая справка

- •1.4. Испытания и события. Виды событий

- •1.5. Алгебра событий

- •1.6. Классическое определение вероятности

- •1.7. Основные формулы комбинаторики

- •Лекция №2. Основные понятия и определения

- •2.1. Относительная частота. Устойчивость относительной частоты

- •2.2. Ограниченность классического определения вероятности. Статистическая вероятность

- •2.3. Геометрические вероятности

- •2.4. Теорема сложения вероятностей

- •2.5. Полная группа событий

- •2.6. Противоположные события

- •2.7. Принцип практической невозможности маловероятных событий

- •2.8. Произведение событий. Условная вероятность

- •2.9. Теорема умножения вероятностей

- •2.10. Независимые события. Теорема умножения для независимых событий

- •2.10. Вероятность появления хотя бы одного события

- •Лекция №3 следствия теорем сложения и умножения

- •3.1. Теорема сложения вероятностей совместных событий

- •3.2. Формула полной вероятности

- •3.3. Вероятность гипотез. Формулы Бейеса

- •4. Повторение испытаний

- •4.1. Формула Бернулли

- •4.2. Предельные теоремы в схеме Бернулли

- •4.3. Локальная и интегральная теоремы Муавра-Лапласа

- •4.3. Вероятность отклонения относительной частоты от постоянной вероятности в независимых испытаниях

- •5. Случайные величины

- •5.1. Понятие случайной величины. Закон распределения случайной величины

- •5.2. Закон распределения дискретной случайной величины. Многоугольник распределения

- •5.3. Биномиальное распределение

- •5.4. Распределение Пуассона

- •5.5. Геометрическое распределение

- •5.6. Гипергеометрическое распределение

- •6. Математическое ожидание дискретной случайной величины

- •6.1. Числовые характеристики дискретных случайных величин

- •6.2. Математическое ожидание дискретной случайной величины

- •6.3. Вероятностный смысл математического ожидания

- •6.4. Свойства математического ожидания

- •6.5. Математическое ожидание числа появлений события в независимых испытаниях

- •7. Дисперсия дискретной случайной величины

- •7.1. Целесообразность введения числовой характеристики рассеяния случайной величины

- •7.2. Отклонение случайной величины от ее математического ожидания

- •7.3. Дисперсия дискретной случайной величины

- •7.4. Формула для вычисления дисперсии

- •7.5. Свойства дисперсии

- •7.6. Дисперсия числа появлений события в независимых испытаниях

- •7.7. Среднее квадратическое отклонение

- •7.8. Среднее квадратическое отклонение суммы взаимно независимых случайных величин

- •7.9. Одинаково распределенные взаимно независимые случайные величины

- •7.10. Начальные и центральные теоретические моменты

- •8. Закон больших чисел

- •8.1. Предварительные замечания

- •8.2. Неравенство Чебышева

- •8.3. Теорема Чебышева

- •8.4. Сущность теоремы Чебышева

- •8.5. Значение теоремы Чебышева для практики

- •8.6. Теорема Бернулли

- •Функция распределения вероятностей случайной величины

- •9.1. Определение функции распределения

- •9.2. Свойства функции распределения

- •9.3. График функции распределения

- •10. Плотность распределения вероятностей непрерывной случайной величины

- •10.1. Определение плотности распределения

- •10.2. Вероятность попадания непрерывной случайной величины в заданный интервал

- •10.3. Закон равномерного распределения вероятностей

- •11. Нормальное распределение

- •11.1. Числовые характеристики непрерывных случайных величин

- •11.2. Нормальное распределение

- •11.3. Нормальная кривая

- •11.4. Влияние параметров нормального распределения на форму нормальной кривой

- •11.5. Вероятность попадания в заданный интервал нормальной случайной величины

- •11.6. Вычисление вероятности заданного отклонения

- •11.7. Правило трех сигм

- •11.8. Понятие о теореме Ляпунова. Формулировка центральной предельной теоремы

- •11.9. Оценка отклонения теоретического распределения от нормального. Асимметрия и эксцесс

- •11.10. Функция одного случайного аргумента и ее распределение

- •11.11. Математическое ожидание функции одного случайного аргумента

- •11.12. Функция двух случайных аргументов. Распределение суммы независимых слагаемых. Устойчивость нормального распределения

- •11.13. Распределение «хи квадрат»

- •11.14. Распределение Стьюдента

- •11.15. Распределение f Фишера – Снедекора

- •12. Показательное распределение

- •12.1. Определение показательного распределения

- •12.2. Вероятность попадания в заданный интервал показательно распределенной случайной величины

- •§ 3. Числовые характеристики показательного распределения

- •12.4. Функция надежности

- •12.5. Показательный закон надежности

- •12.6. Характеристическое свойство показательного закона надежности

3.3. Вероятность гипотез. Формулы Бейеса

Следствием формулы (3.6) является формула Байеса или теорема гипотез. Она позволяет переоценить вероятности гипотез Hi, принятых до опыта и называемых априорными («a priory», доопытные, лат.) по результатам уже проведенного опыта, то есть найти условные вероятности P(Hi|A), которые называются апостериорными («a posteriori», послеопытные, лат.).

Пусть событие А может наступить при условии появления одного из несовместных событий Н1, Н2,…, Нn, образующих полную группу. Поскольку заранее не известно, какое из этих событий наступит, их называют гипотезами. Вероятность появления события А определяется по формуле полной вероятности (3.6):

Р(А)

=

![]() .

.

Допустим, что произведено испытание, в результате которого появилось событие А. Поставим своей задачей определить, как изменились (в связи с тем, что событие А уже наступило) вероятности гипотез. Другими словами, будем искать условные вероятности

P(H1|A), P(H2|A),…, P(Hn|A).

Найдем сначала условную вероятность P(H1|A). По теореме умножения имеем

Р(AH1) = Р(А) P(H1|A) = P(H1) P(А/H1).

Отсюда

.

.

Заменив здесь Р(А) по формуле (3.6), получим

.

.

Аналогично выводятся формулы, определяющие условные вероятности остальных гипотез, т.е. условная вероятность любой гипотезы Hi (i = 1,2, ..., n) может быть вычислена по формуле

(3.8)

(3.8)

Полученные формулы называют формулами Бейеса (по имени английского математика, который их вывел; опубликованы в 1764 г.). Формулы Бейеса позволяют переоценить вероятности гипотез после того, как становится известным результат испытания, в итоге которого появилось событие А.

Теорема. Вероятность гипотезы после испытания равна произведению вероятности гипотезы до испытания на соответствующую ей условную вероятность события, которое произошло при испытании, деленному на полную вероятность этого события.

Замечание. Вероятности P(H1), …, P(Hn) часто называют априорными вероятностями группы событий H1, …, Hn, в то время как условные вероятности P(H1|A),…, P(Hn|A) – апостериорными, полученными после дополнительного эксперимента, в котором произошло событие А. В связи с этим формула Байеса называется также формулой обновления априорных вероятностей.

Приведем несколько задач, решаемых с помощью полученных формул условной вероятности.

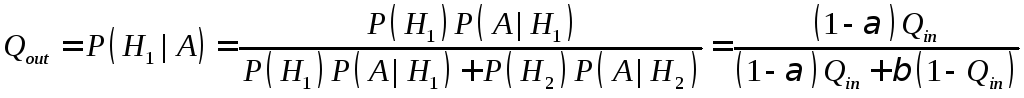

Статистический контроль качества. Формула Байеса играет большую роль в планировании процедур гарантийного контроля качества выпускаемой продукции. Производитель продукта должен выполнять определенные договорные обязательства перед потребителем, которые, так или иначе, сводятся к ограничениям на долю некондиционной продукции, поставляемой потребителю, или, что то же, доля кодндиционной продукции должна быть достаточно высокой. Обеспечение этих ограничений достигается с помощью контроля (как правило, выборочног) производимой продукции. Пусть Qin – доля кондиционной продукции среди изготавливаемой предариятием. Обычно эта доля называется входным уровнем качества, и необходимость контроля продукции обуславливается невысоким значеним Qin, которое не удовлетворяет потребителя. Если контроль продукции производится на основе обследования только ее части (так называемый выборочный или статистический контроль качества), то возникает вероятность принятия ошибочного решения о качестве контролируемого продукта: с некоторой вероятностью процедура контроля может пропустить некондиционный продукт или, наоборот, с вероятностью отклонить кондиционный. Вероятность называется риском потребителя, а вероятность – риском изготовителя. Существуют методы расчета этих рисков на основе вероятностной модели статистического контроля. Зная значения Qin, и , можно, используя формулу Байеса, вычислить выходной уровень качества Qout – долю кондиционной продукции, срели отсылаемой потребителю после контроля.

Пусть H1 – событие, состоящее в том, что поступивший на контроль продукт кондиционен, а H2 – продукт «плохой». В наших обозначениях Р(H1) = Qin. Пусть, далее, А – утверждение о кондиционности продукта после его контроля. Тогда Qout = P(H1 /А) – вероятность кондиционности продукта при условии, что он проше контроль. Наконец, P(А/H1) = 1 – и P(А/H2) = . По формуле Байеса

.

.

Проиллюстрируем расчеты, производимые по этой формуле, на основе конкретных числовых данных. Пусть предприятие работает из рку вон плохо: Qin = 0,1 (90% выпускаемой продукции не удовлетворяет нормам качества), но на предприятии существует довольно жесткий контроль, в котором риск потребителя = 0,01, а риск изготовителя = 0,1. Тогда выходной уровень качества

![]() ,

,

и это совсем неплохо по сравнению с тем, что было до контроля.

Пример. Детали, изготовляемые цехом завода, попадают для проверки их на стандартность к одному из двух контролеров. Вероятность того, что деталь попадает к первому контролеру, равна 0,6, а ко второму – 0,4. Вероятность того, что годная деталь будет признана стандартной первым контролером, равна 0,94, а вторым – 0,98. Годная деталь при проверке была признана стандартной. Найти вероятность того, что эту деталь проверил первый контролер.

Решение. Обозначим через А событие, состоящее в том, что годная деталь признана стандартной. Можно сделать два предположения:

1) деталь проверил первый контролер (гипотеза H1);

2) деталь проверил второй контролер (гипотеза H2).

Искомую вероятность того, что деталь проверил первый контролер, найдем по формуле Бейеса:

По условию задачи имеем:

Р(H1) = 0,6 (вероятность того, что деталь попадает к первому контролеру);

Р(H2) = 0,4 (вероятность того, что деталь попадет ко второму контролеру);

P(А/H1) = 0,94 (вероятность того, что годная деталь будет признана первым контролером стандартной);

P(А/H2) = 0,98 (вероятность того, что годная деталь будет признана вторым контролером стандартной).

Искомая вероятность

![]() .

.

Как видно, до испытания вероятность гипотезы H1 равнялась 0,6, а после того, как стал известен результат испытания, вероятность этой гипотезы (точнее, условная вероятность) изменилась и стала равной 0,59. Таким образом, использование формулы Бейеса позволило переоценить вероятность рассматриваемой гипотезы.