- •Теория вероятностей и математическая статистика Основные понятия теории вероятностей Рекомендуемая литература

- •1.1. Предмет теории вероятностей

- •1.2. Области применения теории вероятностей

- •1.3. Краткая историческая справка

- •1.4. Испытания и события. Виды событий

- •1.5. Алгебра событий

- •1.6. Классическое определение вероятности

- •1.7. Основные формулы комбинаторики

- •Лекция №2. Основные понятия и определения

- •2.1. Относительная частота. Устойчивость относительной частоты

- •2.2. Ограниченность классического определения вероятности. Статистическая вероятность

- •2.3. Геометрические вероятности

- •2.4. Теорема сложения вероятностей

- •2.5. Полная группа событий

- •2.6. Противоположные события

- •2.7. Принцип практической невозможности маловероятных событий

- •2.8. Произведение событий. Условная вероятность

- •2.9. Теорема умножения вероятностей

- •2.10. Независимые события. Теорема умножения для независимых событий

- •2.10. Вероятность появления хотя бы одного события

- •Лекция №3 следствия теорем сложения и умножения

- •3.1. Теорема сложения вероятностей совместных событий

- •3.2. Формула полной вероятности

- •3.3. Вероятность гипотез. Формулы Бейеса

- •4. Повторение испытаний

- •4.1. Формула Бернулли

- •4.2. Предельные теоремы в схеме Бернулли

- •4.3. Локальная и интегральная теоремы Муавра-Лапласа

- •4.3. Вероятность отклонения относительной частоты от постоянной вероятности в независимых испытаниях

- •5. Случайные величины

- •5.1. Понятие случайной величины. Закон распределения случайной величины

- •5.2. Закон распределения дискретной случайной величины. Многоугольник распределения

- •5.3. Биномиальное распределение

- •5.4. Распределение Пуассона

- •5.5. Геометрическое распределение

- •5.6. Гипергеометрическое распределение

- •6. Математическое ожидание дискретной случайной величины

- •6.1. Числовые характеристики дискретных случайных величин

- •6.2. Математическое ожидание дискретной случайной величины

- •6.3. Вероятностный смысл математического ожидания

- •6.4. Свойства математического ожидания

- •6.5. Математическое ожидание числа появлений события в независимых испытаниях

- •7. Дисперсия дискретной случайной величины

- •7.1. Целесообразность введения числовой характеристики рассеяния случайной величины

- •7.2. Отклонение случайной величины от ее математического ожидания

- •7.3. Дисперсия дискретной случайной величины

- •7.4. Формула для вычисления дисперсии

- •7.5. Свойства дисперсии

- •7.6. Дисперсия числа появлений события в независимых испытаниях

- •7.7. Среднее квадратическое отклонение

- •7.8. Среднее квадратическое отклонение суммы взаимно независимых случайных величин

- •7.9. Одинаково распределенные взаимно независимые случайные величины

- •7.10. Начальные и центральные теоретические моменты

- •8. Закон больших чисел

- •8.1. Предварительные замечания

- •8.2. Неравенство Чебышева

- •8.3. Теорема Чебышева

- •8.4. Сущность теоремы Чебышева

- •8.5. Значение теоремы Чебышева для практики

- •8.6. Теорема Бернулли

- •Функция распределения вероятностей случайной величины

- •9.1. Определение функции распределения

- •9.2. Свойства функции распределения

- •9.3. График функции распределения

- •10. Плотность распределения вероятностей непрерывной случайной величины

- •10.1. Определение плотности распределения

- •10.2. Вероятность попадания непрерывной случайной величины в заданный интервал

- •10.3. Закон равномерного распределения вероятностей

- •11. Нормальное распределение

- •11.1. Числовые характеристики непрерывных случайных величин

- •11.2. Нормальное распределение

- •11.3. Нормальная кривая

- •11.4. Влияние параметров нормального распределения на форму нормальной кривой

- •11.5. Вероятность попадания в заданный интервал нормальной случайной величины

- •11.6. Вычисление вероятности заданного отклонения

- •11.7. Правило трех сигм

- •11.8. Понятие о теореме Ляпунова. Формулировка центральной предельной теоремы

- •11.9. Оценка отклонения теоретического распределения от нормального. Асимметрия и эксцесс

- •11.10. Функция одного случайного аргумента и ее распределение

- •11.11. Математическое ожидание функции одного случайного аргумента

- •11.12. Функция двух случайных аргументов. Распределение суммы независимых слагаемых. Устойчивость нормального распределения

- •11.13. Распределение «хи квадрат»

- •11.14. Распределение Стьюдента

- •11.15. Распределение f Фишера – Снедекора

- •12. Показательное распределение

- •12.1. Определение показательного распределения

- •12.2. Вероятность попадания в заданный интервал показательно распределенной случайной величины

- •§ 3. Числовые характеристики показательного распределения

- •12.4. Функция надежности

- •12.5. Показательный закон надежности

- •12.6. Характеристическое свойство показательного закона надежности

Лекция №3 следствия теорем сложения и умножения

3.1. Теорема сложения вероятностей совместных событий

Была рассмотрена теорема сложения для несовместных событий. Рассмотрим теорему сложения для совместных событий.

Два события называют совместными, если появление одного из них не исключает появления другого в одном и том же испытании.

Пример. А – появление четырех очков при бросании игральной кости; В – появление четного числа очков. События А и В – совместные.

Пусть события А и В совместны, причем даны вероятности этих событий и вероятность их совместного появления. Как найти вероятность события А + В, состоящего в том, что появится хотя бы одно из событий А и В? Ответ на этот вопрос дает теорема сложения вероятностей совместных событий.

Теорема. Вероятность появления хотя бы одного из двух совместных событий равна сумме вероятностей этих событий без вероятности их совместного появления:

Р(А + В) = Р(А) + Р(В) – Р(АВ).

Доказательство.

Поскольку события А

и В,

по условию, совместны, то событие А

+ В

наступит, если наступит одно из следующих

трех несовместных событий:

![]() илиАВ.

По теореме сложения вероятностей

несовместных событий,

илиАВ.

По теореме сложения вероятностей

несовместных событий,

![]() . (3.1)

. (3.1)

Событие

А

произойдет, если наступит одно из двух

несовместных событий:

![]() илиАВ.

По теореме сложения вероятностей

несовместных событий имеем

илиАВ.

По теореме сложения вероятностей

несовместных событий имеем

![]() .

.

Отсюда

![]() . (3.2)

. (3.2)

Аналогично имеем

![]()

Отсюда

![]() . (3.3)

. (3.3)

Подставив (3.2) и (3.3.) в (3.1), окончательно получим

Р(А + В) = Р(А) + Р(В) – Р(АВ). (3.4)

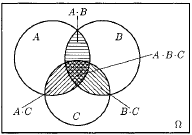

В справедливости формул можно наглядно убедиться на рис. 3.1.

Рис. 3.1

Замечание 1. При использовании полученной формулы следует иметь в виду, что события А и В могут быть как независимыми, так и зависимыми.

Для независимых событий

Р(А + В) = Р(А) + Р(В) – Р(А)Р(В);

для зависимых событий

Р(А + В) = Р(А) + Р(В) – Р(А)РА(В).

Замечание 2. Если события А и В несовместны, то их совмещение есть невозможное событие и, следовательно, Р(АВ) = 0. Формула (3.4) для несовместных событий принимает вид

Р(А + В) = Р(А) + Р(В).

Мы вновь получили теорему сложения для несовместных событий. Таким образом, формула (3.4) справедлива как для совместных, так и для несовместных событий.

Пример. Вероятности попадания в цель при стрельбе первого и второго орудий соответственно равны: р1 = 0,7; р2 = 0,8. Найти вероятность попадания при одном залпе (из обоих орудий) хотя бы одним из орудий.

Решение. Вероятность попадания в цель каждым из орудий не зависит от результата стрельбы из другого орудия, поэтому события А (попадание первого орудия) и В (попадание второго орудия) независимы.

Вероятность события АВ (оба орудия дали попадание)

Р(АВ) = Р(А)Р(В) = 0,70,8 = 0,56.

Искомая вероятность

Р(А + В) = Р(А) + Р(В) – Р(АВ) = 0,7 + 0,8 – 0,56 = 0,94.

Замечание 3. Так как в настоящем примере события А и В независимые, то можно было воспользоваться формулой Р = 1 – q1q2. В самом деле, вероятности событий, противоположных событиям А и В, т.е. вероятности промахов, таковы:

q1 = 1 – р1 = 1 – 0,7 = 0,3; q2 = 1 – p2= 1 – 0,8 = 0,2.

Искомая вероятность того, что при одном залпе хотя бы одно орудие даст попадание, равна

Р = 1 – q1q2 = 1 – 0,30.2 = 0,94.

Как и следовало ожидать, получен тот же результат.

Можно получить формулу вероятности суммы трех и большего числа совместных событий; для трех событий она имеет вид

Р(А + В + С) = Р(А) + Р(В) + Р(С) – Р(АВ) – Р(АС) – Р(ВС) + Р(АВС). (3.5)

Справедливость равенства поясняет рис. 3.2.

Рис. 3.2.

Проще,

однако, найти вероятность суммы нескольких

совместных событий P(S)

= P(A1

+A2

+ … +An),

используя равенство

![]() ,

где

,

где![]() - противоположно событиюS.

Тогда

- противоположно событиюS.

Тогда

![]() .

Этот прием можно использовать и при

решении задач.

.

Этот прием можно использовать и при

решении задач.

Пример. Бросаются две игральные кости. Какова вероятность появления хотя бы одной шестерки?

Решение. Введем события: А – появление шестерки на первой кости, В – на второй кости. Тогда А + В – появление хотя бы одной шестерки при бросании костей события А и В совместные.

![]() .

.

Следовательно,

![]() .

Или то же самое можно получить по формуле

(3.4):

.

Или то же самое можно получить по формуле

(3.4):![]() .

.