1 Случайным образом инициализируются веса синаптических связей (наи практике из интервала [-0,05; 0,5]/

На входы НС поочередно подаются «образы» (входные векторы) обучающей выборки.

Вычисляется реакция НС на соответствующий входной вектор.

Вычисляется вектор ошибки сети – разность между желаемым и фактическим значением.

Вычисляется суммарная квадратичная ошибка.

Проверяется условие Е≤ Едоп., где Едоп- заданное условие ошибки.

Производится изменение весов НС в сторону уменьшения ошибки.

Более подробно этот алгоритм выглядит следующим образом:

Суть процесса обучения НС заключается в выполнении следующей многошаговой процедуры.

Шаг 1. Задаётся обучающее множество (“задачник”)

![]() ,

элементами которого являются обучающие

пары

,

элементами которого являются обучающие

пары

![]() .

В данном случае

.

В данном случае

![]() –

1-й входной вектор (или 1-й входной образ),

предъявляемый нейронной сети;

–

1-й входной вектор (или 1-й входной образ),

предъявляемый нейронной сети;

![]() –

вектор эталонных (требуемых) реакций

НС в ответ на 1-й входной вектор

–

вектор эталонных (требуемых) реакций

НС в ответ на 1-й входной вектор

![]() ;

L

– число различных обучающих пар.

;

L

– число различных обучающих пар.

Шаг

2.

Устанавливается начальное состояние

НС путём присваивания всем её весам

![]() некоторых случайных (малых) значений.

некоторых случайных (малых) значений.

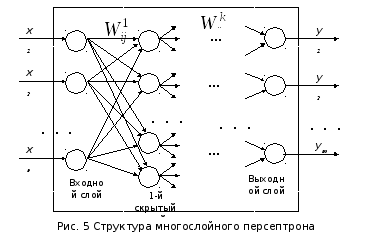

![]() –

вес связи, соединяющей выход i-го

нейрона k-го

слоя со входом j-го

нейрона (k

+ 1)-го слоя.

–

вес связи, соединяющей выход i-го

нейрона k-го

слоя со входом j-го

нейрона (k

+ 1)-го слоя.

Шаг

3.

На вход сети подаётся входной вектор

![]() ;

определяются реакции

;

определяются реакции

![]() нейронов выходного слоя.

нейронов выходного слоя.

Шаг

4.

Вычисляется разность

![]() между желаемой реакцией сети

между желаемой реакцией сети

![]() и её фактическим выходом

и её фактическим выходом

![]() ,

т. е.

,

т. е.

![]() ,

а также суммарная квадратичная ошибка

,

а также суммарная квадратичная ошибка

![]() .

.

Шаг

5.

Осуществляется коррекция весов

![]() нейронной сети таким образом, чтобы

уменьшить ошибку

нейронной сети таким образом, чтобы

уменьшить ошибку

![]() .

.

Шаг

6.

Повторяются шаги 3–5 для каждой пары

обучающего множества

![]() до тех пор, пока ошибка на всем множестве

не достигнет малой, заранее заданной

величины Е*.

до тех пор, пока ошибка на всем множестве

не достигнет малой, заранее заданной

величины Е*.

Результатом обучения является такая настройка весов синаптических связей, при которой каждому входному вектору сеть сопоставляет требуемый (или близкий к нему) выход.

Одним из первых алгоритмов, удачно зарекомендовавшим себя при обучении многослойной НС, явился предложенный в 1986 г. Руммельхартом Д. (США) и его коллегами алгоритм обратного распространения (Васk–Ргораgаtion Algorithm), претерпевший впоследствии многочисленные изменения и усовершенствования. Сущность этого алгоритма состоит в том, что подстройка весов осуществляется послойно, начиная с последнего(выходного) слоя и заканчивается первым скрытым слоем. Существуют также и другие алгоритмы обратного рспространения.

На сегодня известно более 200 разновидностей НС. Кроме упомянутых выше многослойных персептронов, это:

• динамические (рекуррентные) НС;

• сети на основе радиальных базисных функций;

• сети Хопфилда;

• сети Кохонена;

• неокогнитроны и т. д

Обучение

Способность к обучению является фундаментальным свойством мозга. В контексте ИНС процесс обучения может рассматриваться как настройка архитектуры сети и весов связей для эффективного выполнения специальной задачи. Обычно нейронная сеть должна настроить веса связей по имеющейся обучающей выборке. Функционирование сети улучшается по мере итеративной настройки весовых коэффициентов. Свойство сети обучаться на примерах делает их более привлекательными по сравнению с системами, которые следуют определенной системе правил функционирования, сформулированной экспертами.

Для конструирования процесса обучения, прежде всего, необходимо иметь модель внешней среды, в которой функционирует нейронная сеть - знать доступную для сети информацию. Эта модель определяет парадигму обучения. Во-вторых, необходимо понять, как модифицировать весовые параметры сети, - какие правила обучения управляют процессом настройки. Алгоритм обучения означает процедуру, в которой используются правила обучения для настройки весов.

Как правило, алгоритм обучения – это набор формул, который позволяет вычислить требуемые поправки для весов сети. Для полной тренировки требуется хотя бы несколько примеров.

Используемые алгоритмы:

- локальной оптимизации с вычислением частных производных первого порядка;

- локальной оптимизации с вычислением частных производных первого и второго порядков;

-стохастические алгоритмы оптимизации;

-алгоритмы глобальной оптимизации и другие.

Существуют три парадигмы обучения: «с учителем», «без учителя» (самообучение) и смешанная. В первом случае нейронная сеть располагает правильными ответами (выходами сети) на каждый входной пример. Веса настраиваются так, чтобы сеть производила ответы как можно более близкие к известным правильным ответам. Усиленный вариант обучения с учителем предполагает, что известна только критическая оценка правильности выхода нейронной сети, но не сами правильные значения выхода. Обучение без учителя не требует знания правильных ответов на каждый пример обучающей выборки. В этом случае раскрывается внутренняя структура данных или корреляции между образцами в системе данных, что позволяет распределить образцы по категориям. При смешанном обучении часть весов определяется посредством обучения с учителем, в то время как остальная получается с помощью самообучения.

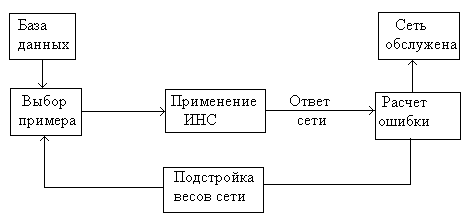

Рис.6. Алгоритм обучения ИНС.

Нейронные сети хороши для задач распознавания образов, но неудобны для выяснения вопроса, как они такое распознавание осуществляют. При этом знания эксперта для ускорения процесса ее обучения в нейронную сеть ввести невозможно.

Системы с нечеткой логикой, напротив, хороши для объяснения получаемых с их помощью выводов, но они не могут автоматически приобретать знания для их использования в механизмах вывода.

В гибридных сетях выводы делаются на основе аппарата нечеткой логики, но соответствующие функции принадлежности подстраиваются с использованием алгоритмов обучения нейронных сетей.

Основными недостатками аппарата нейронных сетей являются:

- отсутствие строгой теории по выбору структуры ИНС;

- практическая невозможность извлечения приобретенных знаний из обученных ИНС.

Опыт показал, что применение нейронных сетей оправданно там, где закономерности не изучены, а входные данные избыточны, иногда противоречивы и засорены случайной информацией.

За рубежом интерес к нейронным сетям стремительно растет. На нейронной технологии в сочетании с использованием проводящих полимеров основано устройство распознавания запахов, разработанное совместно фирмами Neotronics и Neoral Technologies. Системы на основе одного из типов нейронной сети осуществляют контроль за энергоустановками в некоторых городах США. Сеть РАРNЕТ после пробного рассмотрения нескольких тысяч образцов определяет пораженные раком клетки быстрее и точнее, чем это делает лаборант. "Гибридная" система анализа данных Clementine, разработанная ISL, применяется банком Чейз Манхэттен (Chase Manhattan Bank) для изучения вкусов и склонностей части своей клиентуры. Датский институт мясной промышленности приспособил нейронную сеть для анализа качества свинины. Фирма АЕА Technology разработала на основе нейронной сети средство определения идентичности подписи.

Области применения обученных ИНС: обработка видеоизображений; обработка статических изображений; обнаружение и классификация объектов по звуковым и гидроакустическим сигналам; медицинская диагностика; распознавание речи; обнаружение фальсификаций; управление ценами и производством; исследование факторов спроса; прогнозирование потребления энергии; анализ страховых рисков; оценка недвижимости.

Задачи нейронных сетей, генетических алгоритмов и методов нечеткой логики могут рассматриваться вне связи между собой, однако их взаимосвязь довольно высока. Генетические алгоритмы можно применять для подбора весов и топологии ИНС, а также для формирования базы правил и функций принадлежности нечеткой системы. В свою очередь, ИНС позволяют выбирать соответствующие параметры для генетических алгоритмов ( параметры скрещивания и мутации). Методы нечетких множеств позволяют подбирать параметры генетических алгоритмов и коэффициенты, определяющие скорость обучения ИНС.