Лаб_1

.docЛабораторна робота №1

Кількісна оцінка інформації – ентропія

Мета роботи: набути навики визначення кількості інформації рівноймовірних та нерівноймовірних повідомлень. Засвоїти способи обчислення ентропії.

Короткі теоретичні відомості

Число повідомлень N, які можна отримати, комбінуючи m символів алфавіту по n елементів в повідомленні визначається як

![]() .

.

Наприклад, при алфавіті з 2-х символів (m=2) та при 3-х елементах в повідомленні можна передати N=23=8 повідомлень.

Кількість інформації, що міститься в n повідомленнях:

![]() ,

,

де а основа логарифму, що не впливає на кількість інформації, а визначається лише зручність обчислень. Так, кількість інформації при а=10 буде виражена в десяткових бітах (дітах), а=2 – двійкові біти. Основа логарифму впливає на зручність обчислень

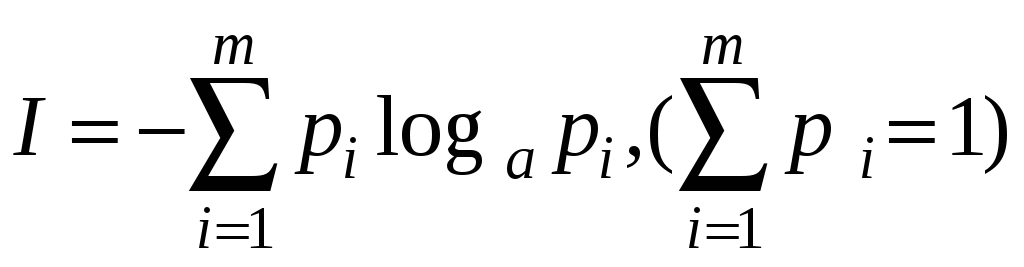

Кількість інформації пов’язана зі зняттям невизначеності, яка існувала до отримання повідомлення. Чим більша невизначеність була до передачі повідомлення, тим більша кількість інформації міститься в прийнятому повідомленні. В теорії інформації мірою невизначеності є ентропія. Ентропія – це питома кількість інформації, що припадає на один елемент повідомлення. Для повідомлення з n елементів ентропія рівна:

;

;

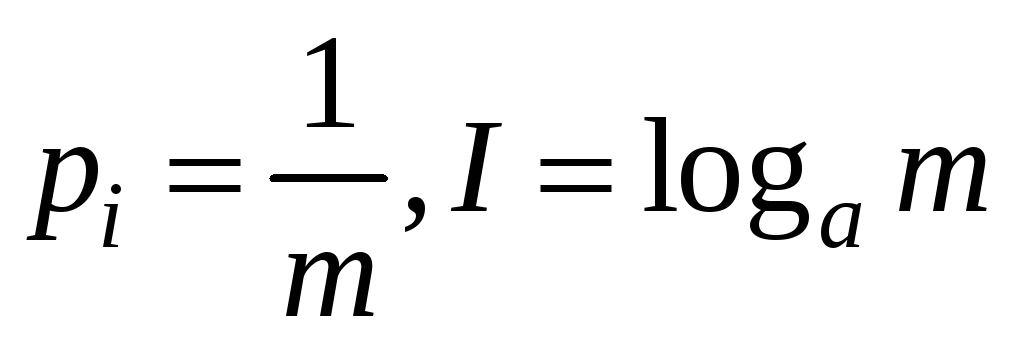

Коли поява будь-якого з m елементів повідомлення рівноймовірна, то:

.

.

При а=2 (бінарний код):

![]() (біт/символ)

(біт/символ)

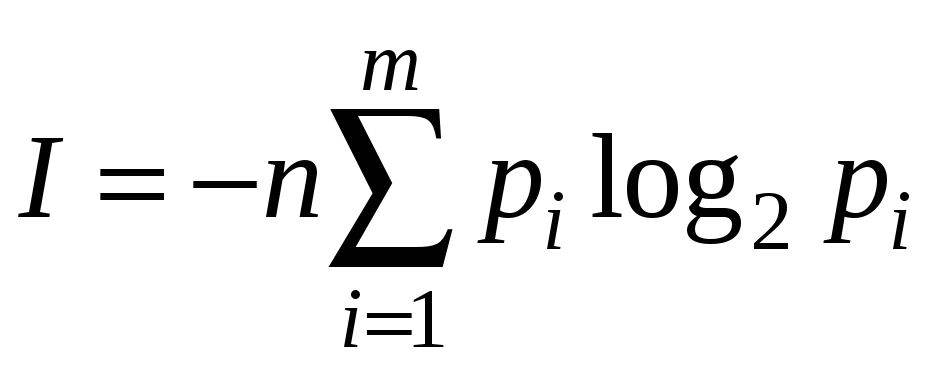

Кількість інформації в n повідомленнях алфавіту m для рівноймовірних і взаємонезалежних символів

![]() (біт).

(біт).

для нерівноймовірних алфавітів

(біт).

(біт).

Практичні завдання для підготовки до роботи

Завдання 1. Визначити

![]() .

.

Завдання 2. Як визначити кількість інформації в повідомленні, якщо відомий алфавіт повідомлень і кількість символів у повідомленні? Навести приклад.

Завдання 3. Скількома способами можна передати положення фігури на шахматній дошці? Визначити і порівняти кількість інформації в кожному випадку.

Виконання роботи

-

Виконати обчислення середньої ймовірності появи окремих літер українського, російського та англійського алфавітів шляхом аналізу різноманітних текстів (мова відповідно до варіанту завдання табл. 1).

-

На основі досліджень п.1 створити таблицю розподілу ймовірностей літер в повідомленнях відповідною мовою.

-

За створеною таблицею визначити :

-

максимальну ентропію Imax.

-

ентропію для нерівноймовірних взаємонезалежних літер I.

-

-

Визначити вказані в п.3 величини (Imax, I) з врахуванням пропуску між окремими словами.

-

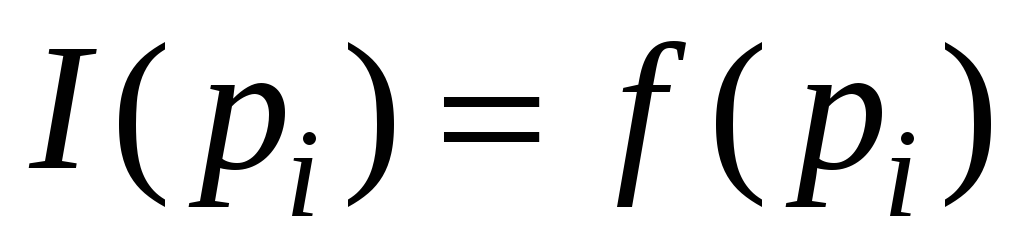

Дослідити функцію зміни ентропії

на екстремум, побудувати графік

на екстремум, побудувати графік

.

Пояснити характер зміни ентропії.

.

Пояснити характер зміни ентропії. -

Визначити кількості інформації на символ повідомлення і в усьому повідомленні для довільного тексту, складеного з алфавіту символів відповідно до варіанту завдання (табл. 2).

-

Визначити кількість інформації контрольного тексту.

Контрольні запитання

-

Дати визначення понять інформація, повідомлення, сигнал).

-

Що таке джерело повідомлень?

-

Що таке ансамбль повідомлень?

-

Охарактеризуйте неперервні та дискретні повідомлення.

-

Які є типи повідомлень?

-

Що розуміють під поняттям кодування повідомлень?

-

Яка залежність між кількістю інформації і кількістю комбінацій, складених з даного алфавіту?

-

Як визначити кількість інформації в одному повідомленні?

-

Дати пояснення поняття ентропія.

-

Що таке безумовна ентропія?

-

Що таке умовна ентропія?

-

Пояснити основні властивості безумовної ентропії.

-

В яких одиницях вимірюється ентропія, кількість інформації?

-

Яка різниця у визначенні кількості інформації для рівномірних та нерівномірних символів?

Таблиця 1

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

а |

у |

р |

а |

а |

у |

р |

р |

у |

а |

у |

а |

а |

у |

р |

Таблиця 2

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

а |

р |

а |

р |

у |

р |

у |

а |

а |

р |

а |

р |

р |

а |

а |