denbnovetsky

.pdf

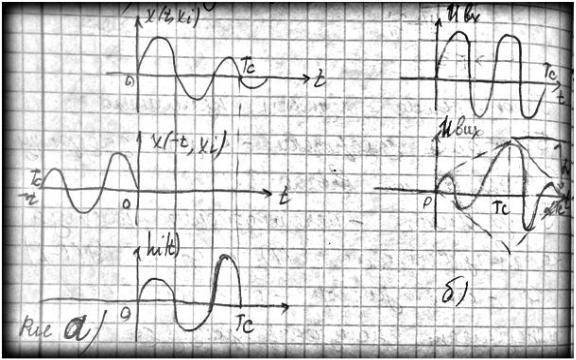

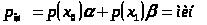

(29) можна назвать обращением сигнала , она показана на рисунке а). Покажем что на выходе в момент Тс сигнал является корреляцией:

t t

Uвых (t) Ubx ( )h(t )dt y( )ax(Tc , xi )d

0 0

В момент Тс:

Tc

Uвых (Tc ) a y( )x( , xi )d

0

Это выражение с точностью до константы равной а отвечает кореляционой функции y(t) ,

U (t, xi ).Пример прохождения сигнала в виде отрезка гармонческих колебаний через

согласов. фильтр показан на рисунке б). С рисунка видно что в момент t=Tc напряжение сигнала на выходе достигает мах.Для такого типа помех не получается.

Эффект соглас. фильтрации связан с корреляцией фазовых сдвигов между отдельными спектрами состояний выделяемого сигнала и на выходе мы получаем отношение с/ш=Е/N0 , где Е- енергия, N0-спектральная плотность сигнала. Таким образом согласованная

фильтрация отличается от обычной тем что отношение с/ш зависит от енергии сигнала, а не от его формы.

Физическая интерпретация частотного коэффшщента передачи согласованного фильтра.

Фильтр, выделяющий известный сигнал из смеси с шумом, должен с малым ослаблением пропускать гармонические колебания, частоты которых отвечают лишь тем участкам спектра, где спектральная плотность полезного сигнала отлична от нуля. Прн этом, естественно, модуль частотного коэффициента передачи должен быть пропорционален модулю спектральной плотности сигнала, т. е. тому вкладу в выходной сигнал, который вносится каждым малым участком на оси частот. Если спектр полезного сигнала имеет дискретную структуру (например, сигнал является периодическим), то данный принцип приводит к фильтрам с гребенчатой формой АЧХ, широко применяемым в радиотехнике. Согласованный фильтр действует подобно гребенчатому фильтру. Однако здесь удается добиться еще большей эффективности обнаружения сигнала путем использования свойств фазового спектра. Действительно, сигнал на выходе согласованного фильтра [см. формулу (16.22)] достигает максимума

(Еа — энергия выделяемого сигнала) в момент времени *0» когда все элементарные составляющие спектра входного колебания складываются на выходе когерентно, имея один и те же фазовые сдвиги.

Такйм образом, эффект согласованной фильтрации связан с коррекцией фазовых сдвигов между отдельными спектральными составляющими выделяемого сигнала.

24.нету

25.Квазіоптимальний фільтр. Яке буде відношення сигналу до шуму на виході RCфільтрупорівняно з узгодженим фільтром?

В рядеслучаевможнодостичьудовлетворительныхрезультатов, применивфильтрыболеепростойконструкции по сравнению с оптимальнымифильтрами. Подобныеустройствапринятоназыватьквазиоптимальнымифильтрами.

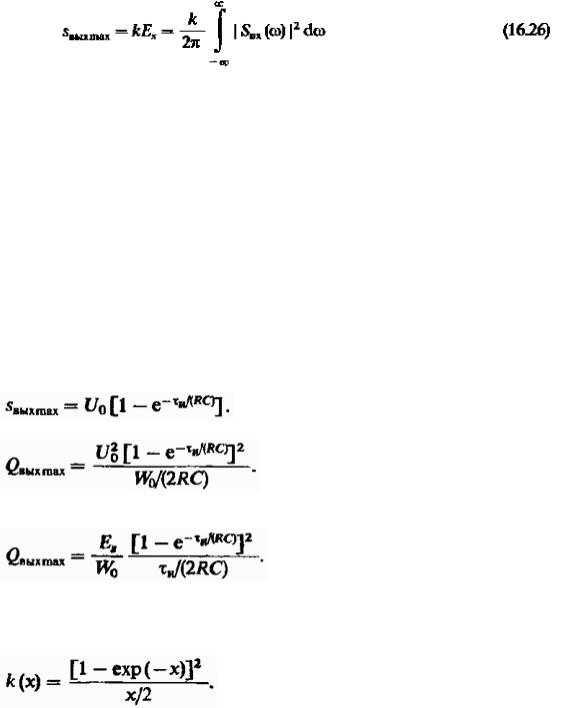

Полезный сигнал на выходе максимален в момент окончания импульса:

Отсюда максимальное значение отношения сигнал/шум на выходе RC-цели

Приняв во внимание, что энергия рассматриваемого видеоимпульса и запишем равенство в виде:

Первый сомножитель в правой части этого выражения задает отношение сигнал/шум, реализуемое согласованным фильтром. Второй сомножитель оценивает проигрыш в отношении сигнал/шум -фильтра по сравнению с согласованным фильтром.

Введя безразмерный параметр рассмотрим функцию, отображающую этот сомножитель:

Соответствующий графи приведен на рис. 16.8.

Из графика видно, что при значение величины достигает максимума, равного 0.814. Таким образом, выбирая подходящее значение постоянной времени RC-цепи, получаем простой квазиоптимальный фильтр с отношением сигнал/шум, лишь на 20% меньшим, чем в согласованном фильтре (проигрыш около 0.9 дБ).

Заметим, что квазиоптимальные фильтры с приемлемыми характеристиками удается реализовать только для простых сигналов, базы которых невелики.

Рис. 16.8. Ухудшение отношения сигнал/шум для RС-фильтра по сравнению с согласованным фильтром В частности, для квазиоптимального выделения прямоугольного радиоимпульса

длительностью можно применить полосовой фильтр с гауссовой частотной характеристикой, настроенный на несущую частоту. Полосу пропускания такого фильтра следует выбирать из соотношения

(16.44)

Можно показать, что проигрыш в отношении сигнал/шум по сравнению с оптимальным фильтром составит около 1 дБ.

26.нету

27Д. КритерійБайєса (ідеальногоспостерігача) при виявленнівідомого сигналу, поріг, з якимпорівнюєтьсявідношенняапостеріорнихвірогідностей, критерії Котельникова, Неймана - Пірсона, мінімального риску - критерійБайєса.

Критеріїоптимальностіприймача.

В процесівиявлення сигналу можуть бути помилкидвохвидів:

1)рішення про наявність сигналу, коли насправді є тільки шум (хибнатривога) Рхт;

2)рішення про відсутність сигналу, коли сигнал дійсно є (пропуск сигналу) Рпр; В залежностівідймовірностіпомилоквведенікритерії:

- Згідно з критеріємідеальногоспостерігачаприймач є оптимальним, якщовінзабезпечуємінімальнуймовірністьпомилки будь якого виду. Згіднокритерієм Неймана-Пірсонаприймач є оптимальним,

якщовінзабезпечуємаксимальнуймовірністьправильноговиявлення, мінімальнуймовірність пропуску сигналу при заданійймовірностіпомилковоїтривоги.

Критерій Неймана-Пірсонанайбільшезастосовується в радіолокації. Відомііншікритеріїоптимальностіприймача( критерійБайєса, мінімакснийкритерій, критерійвтратиінформації).

В загальномувипадкурізнимкритеріямоптимальностівідповідаютьрізніструктури і властивості оптимального приймача.

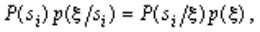

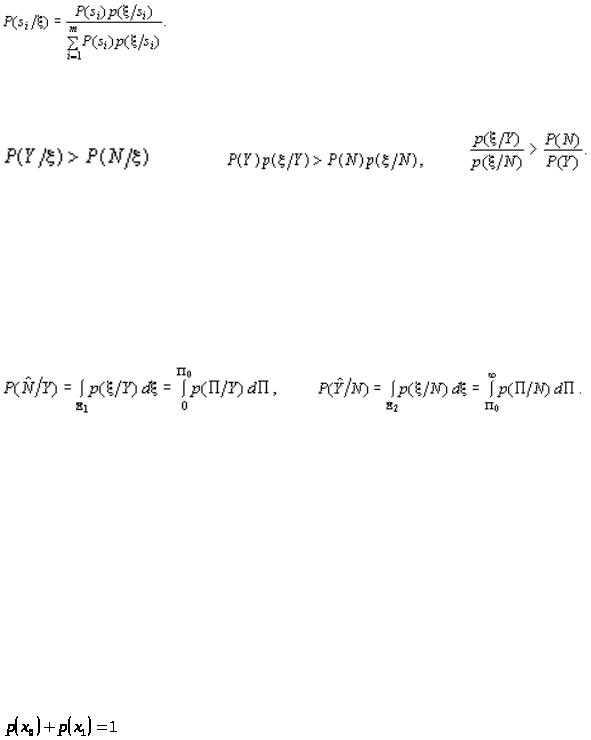

Теорема Байеса — одна из основных теорем элементарной теории вероятностей, которая определяет вероятность наступления события в условиях, когда на основе наблюдений известна лишь некоторая частичная информация о событиях; по формуле Байеса можно

пересчитывать вероятность, беря в учет как ранее известную информацию, так и данные новых наблюдений. Формула Байеса позволяет вычислить условную плотность вероятности х на входе, если заданy.

ФормулаБаєса: |

| |

| |

, где |

|

w(x)- априорная плотность вероятности x вектора сигнала(до ввода), w(y)- безусловная плотность вероятности вектора y;

w(y|x)- условная плотность вероятности y если x задан

Для определения апостериорной вероятности P(x|y) или плотности вероятности w(x|y) необходимо знать плотность вероятности w(y|x), которая при заданномy будет зависить только от x, то есть w(y|x)=L(x) – функция правдоподобия. В зависимости от того являються лих дискр. или непрер. величиной функция правдоподобн. может принять конечное или бесконечное множество значений. Значение функции правдоподобия w(y|x)=L(x) это условная плотность вероятности выборки у при наличии полезного сигнала х, а L(x0)=w(x|x0) условная плотность вероятности выборки у при отсутствии х, в случае когда есть только шум.

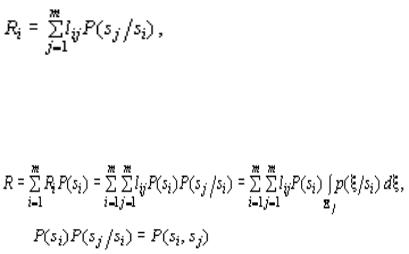

Потери, которые возникают при ошибочном решении, что был принят сигнал  , когда на самом деле передавался

, когда на самом деле передавался обозначим

обозначим  . Естественно принять

. Естественно принять  . Условный риск при передаче есть

. Условный риск при передаче есть

(31)

т.е. определяется суммой вероятностей ошибок с учѐтом потерь  .

.

Если  – априорная вероятность передачи сигналов

– априорная вероятность передачи сигналов  или средняя частота, с

или средняя частота, с

которой сигналы  передаются в канал, тогда средний риск при передаче одного сигнала из m возможных равен

передаются в канал, тогда средний риск при передаче одного сигнала из m возможных равен

|

(32) |

где |

– безусловная вероятность. |

|

Качество канала передачи сообщений тем выше, чем меньше средний риск R в (32). |

|

Критерий среднего риска является одним из наиболее общих. Это Байесовский |

критерий, поскольку он основан на априорно известных вероятности передачи отдельных сигналов и условной вероятности на приемной стороне, что позволяет воспользоваться формулой Байеса в (32).критерий Неймана-Пирсона можно интерпретировать как частный

случай Байесовского критерия. Для случая различения сигналов  используем соотношение

используем соотношение

(42)

(42)

где  – апостериорная вероятность того, что передавался сигнал

– апостериорная вероятность того, что передавался сигнал  при условии принятого сигнала x, p(x ) – безусловная плотность вероятности сигнала x . Согласно формуле Байеса,

при условии принятого сигнала x, p(x ) – безусловная плотность вероятности сигнала x . Согласно формуле Байеса,

(43)Условие максимума апостериорной вероятности есть

В случае обнаружения сигнала

В случае обнаружения сигнала  должно выполняться условие

должно выполняться условие

(44) или |

(45) |

(46) |

Левая часть неравенства (46) носит название отношения правдоподобия. Правая часть в случае неизвестных вероятностей отсутствия и наличия сигнала также неизвестна, поэтому принимают, что отношение правдоподобия должно быть выше заданного порогового значения P . Таким образом, пространство X реализаций x преобразуется в значения P на числовой оси, так что условные вероятности принять сигнал при условии его наличия или отсутствия выражаются в форме

(47)

(47)  (48)

(48)

Поэтому при установленной границе  принятия решений

принятия решений

(49) |

(50) |

Структура оптимального приемника Неймана-Пирсона строится так, чтобы выполнялось условие  .

.

28. Критерії приймання рішення про наявність корисного сигналу: максимуму правдоподібності, максимума апостеріорної вірогідності, ідеального спостерігача

Завдання ідентифікації, як відзначалося, полягає в тому, щоб у результаті обробки

прийнятого сигналу  встановити, чи міститься в ньому корисний

встановити, чи міститься в ньому корисний  чи сигнал ні. Нехай прийнятий сигнал є сумою корисного сигналу й завади

чи сигнал ні. Нехай прийнятий сигнал є сумою корисного сигналу й завади

.

.

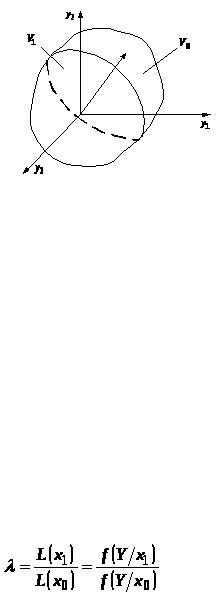

Інформаційний сигнал може приймати два значення:  і

і  з апріорними відповідно

з апріорними відповідно

ймовірностями  й

й  . Тому що сигнал

. Тому що сигнал  напевно має одне із цих двох значень, те справедливе співвідношення

напевно має одне із цих двох значень, те справедливе співвідношення

Таким чином, можливі дві взаємно виключають (альтернативні) гіпотези: у прийнятому сигналі міститься корисний сигнал (гіпотеза  ) і відсутній корисний сигнал (гіпотеза

) і відсутній корисний сигнал (гіпотеза

). Вирішальний пристрій приймача за даними вибірки повинне встановити, яка із цих гіпотез є правдоподібною.

). Вирішальний пристрій приймача за даними вибірки повинне встановити, яка із цих гіпотез є правдоподібною.

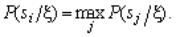

У геометричній інтерпретації поставлене завдання може бути сформульована в такий спосіб. Простір прийнятих сигналів V умовно розбивається на дві частини: область  відповідному прийняттю гіпотези

відповідному прийняттю гіпотези  про те, що

про те, що  й область

й область  відповідному прийняттю гіпотези

відповідному прийняттю гіпотези  про те, що

про те, що  .

.

Це значить, що якщо вектор прийнятого сигналу виявиться в межах області  те приймається гіпотеза

те приймається гіпотеза  . Якщо ж вектор сигналу

. Якщо ж вектор сигналу  виявиться в області

виявиться в області  , то приймається гіпотеза

, то приймається гіпотеза  .

.

У цих умовах можуть мати місце два значення апостеріорної ймовірності  :

:

— умовна ймовірність наявності корисного сигналу X при даному значенні

— умовна ймовірність наявності корисного сигналу X при даному значенні

вибірки  ,

,  — умовна ймовірність відсутності X при даному значенні вибірки

— умовна ймовірність відсутності X при даному значенні вибірки

.

.

Аналогічно можна розглядати два значення функції правдоподібності  :

:

умовна щільність імовірності вибірки

умовна щільність імовірності вибірки  при наявності корисного

при наявності корисного

сигналу  ;

;  умовна щільність імовірності вибірки

умовна щільність імовірності вибірки  при відсутності

при відсутності

.

.

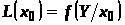

Відношення функцій правдоподібності

прийнято називати відношенням правдоподібності.

Для вибору гіпотези  або

або  повинне бути взяте за основи певне правило прийняття рішень.

повинне бути взяте за основи певне правило прийняття рішень.

Вибір правила прийняття рішення в математичному відношенні зводиться до оптимальної

розбивки простору прийнятих сигналів V на області  й

й  .

.

Для того щоб вибрати те або інше правило прийняття рішення, необхідно керуватися певними критеріями.

Критерій максимуму правдоподібності. Цей критерій формулюється в такий спосіб: найбільше правдоподібно те значення параметра X, для якого функція правдоподібності

максимальна.

максимальна.

Відповідно до цього критерію у випадку двухальтернативної ситуації (виявлення сигналу)

має два значення функції правдоподібності  й

й  і приймається та гіпотеза, який відповідає більше значення функції правдоподібності. Якщо, наприклад,

і приймається та гіпотеза, який відповідає більше значення функції правдоподібності. Якщо, наприклад,  то

то

приймається гіпотеза  . Якщо ж

. Якщо ж  , то приймається гіпотеза

, то приймається гіпотеза  .

.

Цей критерій можна записати в наступному вигляді через відношення правдоподібності:

якщо |

, то |

при |

, то |

Таким чином, відповідно до даного критерію методика прийняття рішення зводиться до

наступного: обчислюються функції правдоподібності  й

й  , визначається

, визначається

відношення правдоподібності  , і залежно від того, більше, дорівнює або менше

, і залежно від того, більше, дорівнює або менше  одиниці приймається відповідна гіпотеза.

одиниці приймається відповідна гіпотеза.

Критерій максимуму апостеріорної ймовірності. За цим критерієм при отриманому

значенні вибірки  приймається та гіпотеза, при якій апостеріорна ймовірність

приймається та гіпотеза, при якій апостеріорна ймовірність  максимальна.

максимальна.

Для випадку двухальтернативної ситуації маються два значення апостеріорної ймовірності

й

й  . Звичайно розглядається відношення цих величин і правило прийняття рішення записується у вигляді:

. Звичайно розглядається відношення цих величин і правило прийняття рішення записується у вигляді:

якщо |

, то |

якщо |

, то |

Використовуючи формулу Байеса, виразимо відношення апостеріорних ймовірностей через відношення функцій правдоподібності

Тоді критерій максимуму апостеріорної ймовірності може бути в такий спосіб виражений через відношення правдоподібності:

якщо |

, то |

якщо |

, то |

Співвідношення можна представити у вигляді:

якщо |

, то |

якщо |

, то |

де  - граничне значення відносини правдоподібності.

- граничне значення відносини правдоподібності.

Таким чином, процедура прийняття рішення відповідно до критерію максимуму апостеріорної ймовірності така ж, як і відповідно до критерію максимуму правдоподібності. Відмінність полягає лише в тому, що в першому випадку відношення правдоподібності порівняється з одиницею, а в другому з відношенням апріорних

ймовірностей  При наявності апріорних даних

При наявності апріорних даних  і

і  доцільно застосовувати критерій максимуму апостеріорної ймовірності, тому що при цьому є можливість користуватися додатковою інформацією, що дозволяє точніше вирішити завдання ідентифікації сигналу.

доцільно застосовувати критерій максимуму апостеріорної ймовірності, тому що при цьому є можливість користуватися додатковою інформацією, що дозволяє точніше вирішити завдання ідентифікації сигналу.

Критерій ідеального спостерігача (критерій Котельникова). Відповідно до даного критерію приймається та гіпотеза, при якій забезпечується мінімум загальної помилки прийняття рішення.

При рішенні завдання ідентифікації сигналу можуть мати місце помилки двох пологів:

1)при відсутності корисного інформаційного сигналу вектор прийнятого сигналу  виявляється в області

виявляється в області  й приймається відповідно до цього гіпотеза

й приймається відповідно до цього гіпотеза  ,

,

2)при наявності корисного сигналу вектор  виявляється в області

виявляється в області  й приймається

й приймається

гіпотеза  . Перша помилка називається помилкою першого роду, або «фіктивною тривогою». Друга помилка називається помилкою другого роду, або «пропуском сигналу». Кількісно помилки першого й другого роду оцінюються умовними

. Перша помилка називається помилкою першого роду, або «фіктивною тривогою». Друга помилка називається помилкою другого роду, або «пропуском сигналу». Кількісно помилки першого й другого роду оцінюються умовними

ймовірностями  й

й  помилковими рішеннями про наявність корисного сигналу, коли в дійсності він відсутній, і про відсутність сигналу, коли в дійсності він є

помилковими рішеннями про наявність корисного сигналу, коли в дійсності він відсутній, і про відсутність сигналу, коли в дійсності він є

Загальна безумовна ймовірність помилкового рішення визначається вираженням

Отже, умова оптимального рішення за критерієм ідеального спостерігача має вигляд

.

.

Цей критерій можна записати в наступному вигляді через відношення правдоподібності:

якщо |

, то |

якщо |

, то |

д30. Роздільна здатність ЕС. Інформаційна електронна система.

Роздільна здатність ЕС визначається залежно від призначення ЕС і задає:

1.Осцилографічні та ін вимірювальні системи - мінімальний інтервал часу між імпульсними сигналами, які відтворюються із заданими коефіцієнтами модуляції.

2.ЕС дефектоскопії - мінімальний розмір дефекту або вимірювального еталона, який виявляють на тлі шумів операторних або автоматизованим пристроєм.

3.ЕС електро-оптичного і опто-електричного перетворення (кінескопи, мікроскопи, РКпанелі, відікони і т.д.) - роздільна здатність відображає властивість електронної системи відображати найбільш дрібні деталі зображення.

Граничну роздільну здатність визначає головним чином величина сигналу в ЕС, інформаційно представляє якусь фізичну величину (розмір, частотний інтервал та ін), яка починає не відрізнятися з іншим інформаційним сигналом.

Інформацíйна систéма — сукупність організаційних і технічних засобів для збереження та обробки інформації з метою забезпечення інформаційних потреб користувачів. Інформаційні системи включають в себе: технічні засоби обробки даних, програмне забезпечення і відповідний персонал. Чотири складові частини утворюють внутрішню інформаційну основу:

засоби фіксації і збору інформації;

засоби передачі відповідних даних та повідомлень;

засоби збереження інформації;

засоби аналізу, обробки і представлення інформації. За ступенем автоматизації

В залежності від ступеня (рівня) автоматизації виділяють ручні, автоматизовані й автоматичні інформаційні системи.

Ручні ІС - характеризуються тим, що всі операції з переробки інформації виконуються людиною.

Автоматизовані ІС - частина функції (підсистем) керування або опрацювання даних здійснюється автоматично, а частина — людиною.

Автоматичні ІС - усі функції керування й опрацювання даних здійснюються технічними засобами без участі людини (наприклад, автоматичне керування технологічними процесами)

За сферою призначення Оскільки ІС утворюються для задоволення інформаційних потреб в межах конкретної

предметної галузі, то кожна предметна галузь (в сфері призначення) відповідає свій тип ІС. Перераховувати всі ці типи немає змісту, оскільки кількість предметних галузей велика, але можна вказати наприклад такі типи ІС:

Економічна ІС — інформаційна система призначена для виконання функцій управління на підприємстві; Медична ІС — інформаційна система призначена для використання в лікувальному або

лікувально-профілактичному закладі; Географічна ІС — інформаційна система, забезпечуюча збір, збереження, обробку, доступ, відображення і розповсюдження даних; Адміністративні; Виробничі; Навчальні; Екологічні; Криміналістичні; Військові та інші.

Д31. Ентропія джерела, її визначення та міра: біт, нат. Міра невизначеності станів дискретного джерела за Шенноном, за Хартлі. Властивості ентропії.

Энтропия - мера беспорядка системы, состоящей из многих элементов.

Энтропия – это средняя информативность источника на 1 символ, которая определяет непредсказуемость или неожиданность сообщений полностью детерминирующего источника, который создает одну заранее известную последовательность символов, имеет информативность 0.

|

N |

|

H (N ) pi lg pi |

-Шеннона(еѐ наз. энтропией дискретного источника) – |

i 1 |

-Хартли – H(N) = lgN; |

|

Свойства энтропии:

1. Энтропия – это действительная неотрицательная величина 1≤ i ≤ N

Вероятность изменяется от 0 до 1 lgpi < 0, а значит величина -pilgpi - должна быть положительной.

2.Энтропия – величина ограниченная, для составляющих -pilgpi при

pi → 0 определяется правилом Ляпиталя U = 0.

3. Энтропия = 0, когда вероятность одного из состояний становится 1, тоесть когда состояние источника полностью определено. Тогда вероятность всех других состояний =

0.

4.Энтропия макс для равновероятных состояний источника, когда

p1=p2=…=pN=1/N

|

|

|

1 |

log 1 |

|

|

|

|

|

N |

|

|

log 1 |

|

|||

|

|

N |

|

|

|

|

||

Hmax= |

|

N |

N |

|||||

i |

|

|

||||||

|

|

|

|

|

|

|

|

|

Д32. Энтропия объединения нескольких статически независимых один от другого источников информации равно сумме энтропии непрерывных источников.

Объединение двух источников информации U и V обобщенный источник информации р(U , V),

Которое характеризуется вероятностями р(Ui , Vj) всех возможных комбинаций состояний Ui Источника U и Vj источника V.

(1.9)

,где  - вероятность совместной реализации состояний

- вероятность совместной реализации состояний

Вслучае статической независим. Источника информации U и V

Вэтом выражении учтем :

Получим энтропию объединения двух статистически независимых источников, что равно сумме энтропии этих источников , тоесть:

Теорема объединения энтропий.