- •Лекция 4 Архитектура нейронных сетей Принципы обучения нейронных сетей

- •1. Особенности обучающихся нейронных сетей

- •2. Классификация принципов обучения нейронных сетей

- •3. Схемы обучения нейронных сетей

- •3.1. Схема обучения нейронной сети без учителя

- •3.2. Схема обучения нейронной сети с учителем

- •4. Алгоритмы обучения искусственных нс

- •4.1. Обучение без учителя

- •4.1.1. Правило Хебба

- •4.1.2. Правило Кохонена

- •4.2. Обучение с учителем

- •4.2.1. Дельта-правило

- •4.2.2. Правило обратного распространения ошибки

- •4.2.3. Стохастические алгоритмы

- •4.2.3.1. Машина Больцмана

- •4.2.3.2. Машина Коши

3.1. Схема обучения нейронной сети без учителя

Рассмотрим полный алгоритм обучения без учителя, не останавливаясь на конкретных формулах.

1. На стадии инициализации всем весовым коэффициентам присваиваются небольшие случайные значения.

2. На входы сети подается очередной входной образ из обучающей выборки, и сигналы возбуждения распространяются по всем нейронам всех слоев, изменяясь согласно законам функционирования сети.

3. Фиксируются сигналы, выданные теми нейронами, которые считаются выходными.

4. На основании полученных выходных значений нейронов по соответствующим формулам производится изменение весовых коэффициентов:

всех нейронов

либо группы нейронов,

либо единственного нейрона.

5. Осуществляется переход к следующему примеру обучающей выборки, и операции 2-5 повторяются пока выходные значения сети не установятся в стабильном состоянии с заданной точностью.

3.2. Схема обучения нейронной сети с учителем

Рассмотрим общую схему обучения нейронной сети в режиме по одиночным примерам, не останавливаясь на конкретных математических алгоритмах.

1. На стадии инициализации всем весовым коэффициентам присваиваются небольшие случайные значения.

2. Из обучающей выборки берется текущий пример (изначально, первый) и его входные параметры (вектор входных сигналов) подаются на входы обучаемой НС. Обычно каждый входной параметр примера подается на один соответствующий входной синапс.

3. Сигналы возбуждения распространяются по всем нейронам всех слоев, изменяясь согласно законам функционирования сети. При этом вектор входных сигналов распространяется по связям между нейронами (прямое функционирование).

4. Фиксируются сигналы, выданные теми нейронами, которые считаются выходными.

5. Вычисляется оценка (ошибка), характеризующая различие между выданным сетью ответом и требуемым ответом, имеющимся в примере (целевым вектором). Оценка вычисляется с помощью соответствующей функции оценки. Чем меньше оценка, тем лучше распознан пример.

6. Если ошибка примера равна нулю, ничего не предпринимается. В противном случае на основании ошибки вычисляются поправочные коэффициенты для каждого синаптического веса матрицы связей, после чего производится подстройка синаптических весов (обратное функционирование).

7. Осуществляется переход к следующему примеру обучающей выборки, и операции 2-7 повторяются.

8. Расчет средней ошибки по всем обучающим примерам.

9. Проверка условия окончания обучения.

В каждом цикле обучения каждый пример имеет свою оценку. Кроме того, вычисляется суммарная оценка множества всех примеров обучающей выборки. Если после выполнения нескольких циклов она равна нулю, обучение считается законченным, в противном случае циклы повторяются.

4. Алгоритмы обучения искусственных нс

4.1. Обучение без учителя

4.1.1. Правило Хебба

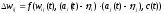

Правило Хебба. Вес пластического синапса должен определяться степенью корреляции между активностями пре- и постсинаптического нейронов (корреляционный алгоритм). Для дискретного времени оно выглядит так:

,

(4.8)

,

(4.8)

где wij(t) – текущее значение синаптического веса;ai(t) иaj(t) – активности пост- и пресинаптического нейронов;i,j(этта) – некоторые постоянны числа, обеспечивающие смещение средней величины синаптического веса;c(t) – управляющий сигнал, разрешающий или запрещающий обучение сети или контролирующий его скорость. Если сигналc(t) – бинарный, то он переводит сеть из режима записи в режим воспроизведения и наоборот.