- •Глава 8. Основы теории кодирования

- •8.2. Согласование источника с каналом по объемам алфавитов. Теоремы кодирования шеннона и потенциальные возможности системы передачи информации

- •8.2.1.Теорема Шеннона для дискретного канала связи без помех

- •8.2.2. Теорема Шеннона для дискретного канала связи с помехами

- •8.2.3. Теорема Шеннона для непрерывного канала связи

- •8.3. Основы экономного кодирования

- •8.3.1 Принципы экономного кодирования. Цель сжатия данных и типы систем сжатия

- •8.3.2. Префиксные коды

- •Избыточность кода Хаффмена

- •8.3.4. Код Шеннона-Фано

- •8.3.5. Неравномерное кодирование для последовательности сообщений

- •8.3.6. Арифметическое кодирование

- •Кодирование

- •Декодирование

- •8.3.7. Словарные методы сжатия

- •Кодирование

- •Декодирование

- •8.4. Основы помехоустойчивого кодирования

- •8.4.1 Принципы обнаружения и исправления ошибок

- •8.4.2. Классификация помехоустойчивых кодов

- •8.4.3. Основные характеристики помехоустойчивых кодов

- •8.4.4. Границы вероятности ошибочного декодирования

- •8.5. Блочные линейные коды

- •8.5.1. Математическое описание процессов кодирования и декодирования

- •8.5.2. Коды с проверкой на четность

- •8.5.3 Коды Хэмминга

- •8.5.4. Коды с постоянным весом

- •8.5.5. Циклические коды

- •1. Способы декодирования с обнаружением ошибок

- •2 Способы декодирования с исправлением ошибок

- •8.6. Непрерывные коды

- •8.6.1 Идея построения непрерывного кода Финка–Хегельбергера

- •8.6.2. Сверточные коды

- •8.6.3. Представление сверточных кодов с помощью многочленов

- •8.6.4. Графическое представление сверточных кодов

- •8.6.5. Методы декодирования сверточных кодов

- •8.6.6. Схемное построение декодера Витерби

- •8.7. Методы борьбы с ошибками

- •8.7.1. Системы с обратной связью

- •8.7.2. Формат кадра протоколов с обнаружением ошибок

- •8.7.3. Методы повторной передачи (arq)

- •8.7.4. Основные характеристики систем с решающей обратной связью

- •8.7.5. Показатели эффективности цифровой системы связи

8.3.2. Префиксные коды

Простейшими кодами, на основе которых может выполняться сжатие данных, являются коды без памяти. В коде без памяти каждый символ в кодируемом векторе данных заменяется кодовым словом из префиксного множества двоичных последовательностей или слов.

Префиксным множеством двоичных последовательностей S называется конечное множество двоичных последовательностей, таких, что ни одна последовательность в этом множестве не является префиксом, или началом, никакой другой последовательности в S.

К примеру, множество двоичных слов S1 = {00, 01, 100, 110, 1010, 1011 } является префиксным множеством двоичных последовательностей, поскольку, если проверить любую из возможных совместных комбинаций (wi wj) из S1, то видно, что wi никогда не явится префиксом (или началом) wj. С другой стороны, множество S2 = { 00, 001, 1110 } не является префиксным множеством двоичных последовательностей, так как последовательность 00 является префиксом (началом) другой последовательности из этого множества - 001.

Таким образом, если необходимо закодировать некоторый вектор данных X = ( x1, x2,… xn ) с алфавитом данных А размера N, то кодирование кодом без памяти осуществляется следующим образом:

- составляют полный список символов a1, a2, aj ... ,aN алфавита А, в котором aj - j-й по частоте появления в X символ, то есть первым в списке будет стоять наиболее часто встречающийся в алфавите символ, вторым – реже встречающийся и т.д.;

- каждому символу aj назначают кодовое слово wj из префиксного множества двоичных последовательностей S;

- выход кодера получают объединением в одну последовательность всех полученных двоичных слов.

Формирование префиксных множеств и работа с ними – это отдельная серьезная тема из теории множеств, выходящая за рамки нашего курса, но несколько необходимых замечаний все-таки придется сделать.

Если S

={w1,

w2,

... , wN}

- префиксное множество, то можно определить

некоторый вектор

![]() ,

состоящий из чисел, являющихся длинами

соответствующих префиксных

последовательностей (mi

- длина wi

).

,

состоящий из чисел, являющихся длинами

соответствующих префиксных

последовательностей (mi

- длина wi

).

Вектор

![]() ,

состоящий из неуменьшающихся положительных

целых чисел, называется вектором Крафта.

Для него выполняется неравенство

,

состоящий из неуменьшающихся положительных

целых чисел, называется вектором Крафта.

Для него выполняется неравенство

![]() .

(8.10)

.

(8.10)

Это неравенство называется неравенством Крафта. Для него справедливо следующее утверждение: если S - какое-либо префиксное множество, то v(S) - вектор Крафта.

Иными словами, длины двоичных последовательностей в префиксном множестве удовлетворяют неравенству Крафта.

Если неравенство (8.10) переходит в строгое равенство, то такой код называется компактным и обладает наименьшей среди кодов с данным алфавитом длиной, то есть является оптимальным.

Ниже приведены примеры простейших префиксных множеств и соответствующие им векторы Крафта:

S1 = {0, 10, 11} и v(S1) = ( 1, 2, 2 );

S2 = {0, 10, 110, 111} и v(S2) = ( 1, 2, 3, 3 );

S3 = {0, 10, 110, 1110, 1111} и v(S3) = ( 1, 2, 3, 4, 4 );

S4 = {0, 10, 1100, 1101, 1110, 1111} и v(S4) = ( 1, 2, 4, 4, 4, 4 );

S5 = {0, 10, 1100, 1101, 1110, 11110, 11111} и v(S5) = ( 1, 2, 4, 4, 4, 5, 5 );

S6 = {0, 10, 1100, 1101, 1110, 11110, 111110, 111111}

и v(S6) = (1,2,4,4,4,5,6,6).

Допустим мы хотим

разработать код без памяти для сжатия

вектора данных X

= ( x1,

x2,…

xN

) с алфавитом

А

размером в N

символов.

Введем в рассмотрение так называемый

вектор вероятностей

![]() ,

где

,

где![]() - вероятность появленияi-го

символа из А

в X или

вектор частот

F = ( f1,

f2,

... , fN

), где fi

- количество

появлений i-го

символа из А

в X.

Закодируем X

кодом без памяти.

- вероятность появленияi-го

символа из А

в X или

вектор частот

F = ( f1,

f2,

... , fN

), где fi

- количество

появлений i-го

символа из А

в X.

Закодируем X

кодом без памяти.

Длина двоичной кодовой последовательности на выходе кодера составит

![]() ,

(8.11)

,

(8.11)

а средняя длина двоичной кодовой последовательности на выходе кодера составит

![]() .

(8.12)

.

(8.12)

Лучшим кодом без

памяти был бы код, для которого средняя

длина

![]() - минимальна.

Для разработки такого кода нам нужно

найти вектор Крафта,

для которого

- минимальна.

Для разработки такого кода нам нужно

найти вектор Крафта,

для которого

![]() была бы минимальной.

была бы минимальной.

Простой перебор

возможных вариантов - вообще-то, не самый

лучший способ найти такой вектор Крафта,

особенно для большого

![]() .

.

Прямая теорема неравномерного кодирования

Теорема 8.1. Для

ансамбля

![]() с энтропией

с энтропией

![]() существует

побуквенный неравномерный префиксный

код со средней длиной кодовых слов

существует

побуквенный неравномерный префиксный

код со средней длиной кодовых слов

![]() .

(8.13)

.

(8.13)

Обсудим полученную

оценку длины кодовых слов. Мы знаем, что

достижимая скорость кодирования

примерно равна энтропии. Теорема

гарантирует, что средняя длина слов

хорошего кода отличается от энтропии

не более чем на 1. Если энтропия велика,

то проигрыш по сравнению с минимально

достижимой скоростью можно считать

небольшим. Но предположим, что

![]() .

Теорема гарантирует, что существует

код со средней длиной кодовых слов не

более 1,1 бита. Но нам хотелось бы

затрачивать на передачу одного сообщение

примерно в 10 раз меньше бит. Этот пример

показывает, что либо теорема дает

неточную оценку, либо побуквенное

кодирование в этом случае не эффективно.

.

Теорема гарантирует, что существует

код со средней длиной кодовых слов не

более 1,1 бита. Но нам хотелось бы

затрачивать на передачу одного сообщение

примерно в 10 раз меньше бит. Этот пример

показывает, что либо теорема дает

неточную оценку, либо побуквенное

кодирование в этом случае не эффективно.

На этом же примере

мы убедимся в том, что теорема достаточно

точна и ее результат не может быть

улучшен, если не использовать никакой

дополнительной информации об источнике.

Действительно, предположим, что дан

двоичный источник Х={0,1}

с вероятностями букв

![]() .

Минимально достижимая длина кодовых

слов наилучшего кода, очевидно, равна

1. Теорема говорит, что средняя длина

кодовых слов не больше

.

Минимально достижимая длина кодовых

слов наилучшего кода, очевидно, равна

1. Теорема говорит, что средняя длина

кодовых слов не больше![]() ,

т. е. стремится к 1 при

,

т. е. стремится к 1 при![]() .

Таким образом, для данного примера

двоичного источника теорема верна.

.

Таким образом, для данного примера

двоичного источника теорема верна.

Достижение скоростей

(затрат на передачу одной буквы источника),

меньших 1, невозможно при побуквенном

кодировании, поскольку длина кодового

слова не может быть меньше 1. Однако

переход к кодированию блоков сообщений

решает эту проблему и позволяет сколь

угодно близко подойти к теоретическому

пределу, равному энтропии

![]() .

Конструктивным

решением данной задачи является

арифметическое кодирование.

.

Конструктивным

решением данной задачи является

арифметическое кодирование.

Обратная теорема неравномерного кодирования

Обратная теорема неравномерного кодирования устанавливает нижнюю границу средней длины кодовых слов любого однозначно декодируемого кода.

Теорема 8.2. Для

любого однозначно декодируемого кода

дискретного источника

![]() с энтропией

с энтропией

![]() средняя

длина кодовых слов

средняя

длина кодовых слов

![]() соответствует

неравенству

соответствует

неравенству

![]() .

(8.14)

.

(8.14)

Иными словами, не

существует кода со средней длиной

кодовых слов меньше

![]() и обладающего

свойством однозначной декодируемости.

и обладающего

свойством однозначной декодируемости.

Рассмотрим вопрос о том, при каких условиях возможно равенство в обратной теореме. Перепишем неравенство (8.14):

![]() .

.

Для этого при

каждом

![]() должно

выполняться соотношение

должно

выполняться соотношение

![]() .

.

В то же время для такого распределения вероятностей существует полный префиксный код с длинами кодовых слов

![]() .

.

Для этого кода неравенство Крафта преобразуется в равенство

![]() .

.

Таким образом, мы установили справедливость следующего утверждения.

Следствие.

Для существования кода со средней длиной

кодовых слов

![]() необходимо,

чтобы все вероятности сообщений

необходимо,

чтобы все вероятности сообщений

![]() имели вид

имели вид

![]() ,

(8.15)

,

(8.15)

где

![]() — целые положительные числа.

— целые положительные числа.

8.3.3. Код Хаффмена

Алгоритм

Хаффмена, названный в честь его

изобретателя - Дэвида Хаффмена, - дает

эффективный способ поиска оптимального

вектора Крафта

![]() для которого

для которого

![]() –

минимальна. Код, полученный с использованием

оптимального

–

минимальна. Код, полученный с использованием

оптимального

![]() ,

называют кодом Хаффмена.

,

называют кодом Хаффмена.

Алгоритм Хаффмена

Алгоритм Хаффмена реализует общую идею статистического кодирования с использованием префиксных множеств и работает следующим образом:

1. Выписываем в ряд все символы алфавита в порядке не возрастания вероятности их появления в тексте.

2. Последовательно объединяем два символа с наименьшими вероятностями появления в новый составной символ. Каждому символу из составного символа приписываем: одному «0», а второму «1». Вероятность появления составного символа полагаем равной сумме вероятностей составляющих его символов. Составной символ переставляем в ряде в соответствии с новой суммарной вероятностью. В конце концов, построим дерево, каждый узел которого имеет суммарную вероятность всех узлов, находящихся ниже него.

3. Прослеживаем путь к каждому листу дерева, помечая направление к каждому узлу (например, направо - 1, налево - 0) . Полученная последовательность дает кодовое слово, соответствующее каждому символу.

Построим кодовое дерево для сообщения со следующим алфавитом табл. 8.8.

Таблица 8.8. Символы алфавита в порядке не возрастания вероятности их появления в тексте

Объединяем Е и F как символы с наименьшими вероятностями и приписываем символу Е – «0», а F – «1». Суммарная вероятность двух символов 0,2. Составной символ Е F переставляем в ряде в соответствии с новой суммарной вероятностью.

Продолжение табл.8.8

2. Объединяем С и D как символы с наименьшими вероятностями на данном шаге и приписываем символу С – «0», а D – «1». Суммарная вероятность двух символов 0,25. Составной символ С D переставляем в ряде в соответствии с новой суммарной вероятностью.

Продолжение табл.8.8

3. Объединяем В и Е F как символы с наименьшими вероятностями на данном шаге и приписываем символу В – «0», а Е F – «1». Суммарная вероятность символов 0,4. Составной символ В Е F переставляем в ряде в соответствии с новой суммарной вероятностью.

Продолжение табл.8.8

4. Объединяем А и С D как символы с наименьшими вероятностями на данном шаге и приписываем символу A – «0», а С D – «1». Суммарная вероятность символов 0,6. Составной символ А С D переставляем в ряде в соответствии с новой суммарной вероятностью.

Продолжение табл.8.8

5. На последнем шаге объединяем А С D и B E F и приписываем символу А С D – «0», а B E F – «1». Суммарная вероятность символов 1.

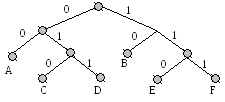

На рис.8.6 представлено дерево кода Хаффмена.

Рис. 8.6. Дерево кода Хаффмена