- •1. Описание сигнала и помехи

- •2.Проверка статистических гипотез

- •2.1.Определения

- •2.2. Критерий Байеса и правило принятия решений

- •2.3. Критерий максимума апостериорной вероятности

- •2.4. Критерий и правило максимума отношения

- •2.5. Критерий Неймана-Пирсона и правило

- •2.6. Минимаксный критерий

- •3. Расчет вероятностей ошибок

- •4. Функционал отношения правдоподобия

- •5. Вероятность ошибки и вероятность правильного

- •6. Методика эксперимента

2.6. Минимаксный критерий

При использовании этого критерия априорной информацией является матрица потерь и функция правдоподобия.

Правила 1, по которым выбираются подпространства G0 и G1 , зависят от потребителя (они субъективны), но число k этих правил j о конечно. Для каждого правила j, или для каждой пары G0j , G1j , вычисляется условное математическое ожидание потерь - условный риск (2.5), (2.6 )

![]() (2.24)

(2.24)

Из каждой пары (r 0j , r 1j) выбирается наибольший условный риск :

![]()

Получили последовательность правил и соответствующие им наибольшие условные потери. Из этой последовательности правил выбирается правило *, обеспечивающее минимум условного риска

![]() .

(2.25)

.

(2.25)

Рассмотрим на примере построение правила принятия решений по минимаксному критерию для параметра р биномиального распределения.

Пусть случайная величина распределена по биномиальному закону

но наблюдателю неизвестна эта вероятность p.

Задана матрица потерь

.

.

Относительно параметра биномиального распределения p наблюдатель проверяет две гипотезы

H0: p = p0 = 0.3, H1 : p = p1 = 0.6

Решение о том, какая из гипотез верна, выносится на основании выборки из трех независимых реализаций случайной величины. Произведем проверку гипотез согласно минимаксному критерию.

Выборочное пространство G состоит из элементов

000 , 001 , 010 , 011 , 100 , 101 , 110 , 111 .

Зададим произвольно 2 правила разбиения пространства G (хотя их можно задать и больше)

1: G01 =(000, 010, 011): G11 =(001, 100, 101, 110, 111),

2: G02 =(011, 100, 101, 110); G12 =(000, 001, 010, 111).

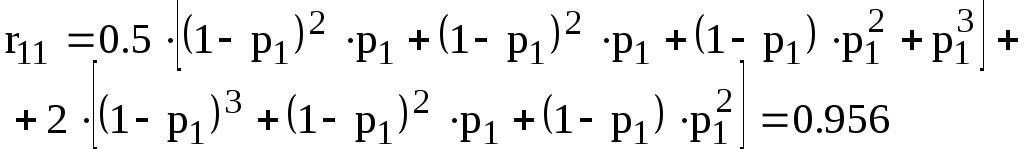

Согласно формулам (2.5), (2.6) вычислим условные риски

Таким образом, имеем таблицу

|

j |

r 0 j |

r 1 j |

max r i j |

|

1 |

0.7235 |

0.956 |

0.956 |

|

2 |

0.874 |

1.292 |

1.292 |

Согласно минимакcному критерию получим

![]()

Из двух возможных правил разбиения выборочного пространства G выбираем правило 1, обеспечивающее минимальный риск из возможных максимальных условных рисков. Для выбранного правила 1 определим вероятности ошибок и :

Как видно из приведенного примера, сначала выбирается способ разбиения выборочного пространства, рассчитываются условные риски, определяется правило, а затем рассчитываются вероятности ошибок.

3. Расчет вероятностей ошибок

Все рассмотренные критерии, кроме минимаксного критерия, приводят к единому правилу решения - отношение правдоподобия L(y) сравнивается с порогом, зависящим от критерия. Обозначим этот порог независимо от применяемого критерия через С. Тогда имеем правило

.

(3.1)

.

(3.1)

При необходимости будем заменять величину С соответствующим порогом согласно выбранному критерию. Используем функцию правдоподобия w(y1,y2,...,ym / s i) , i=0; 1 для вычисления отношения правдоподобия по формулам (1.5), (1.6). Отношение правдоподобия примет вид

.

(3.2)

.

(3.2)

Прологарифмируем (3.1) и с учетом (3.2) получим

.

(3.3)

.

(3.3)

Обозначим

![]() (3.4)

(3.4)

Правило решения примет вид

,

(3.5)

,

(3.5)

где Z - статистика,

C* - порог, разделяющий значения статистики Z на два подпространства, соответствующих гипотезам H0 и H1.

Статистика Z представляет собой сумму независимых случайных значений yi, умноженных на неслучайные величины si. Распределение yi -нормальное, параметры которого зависят от состояния источника. Известно, что сумма нормально распределенных величин распределена нормально. Следовательно,

(3.6)

(3.6)

Определим условные математические ожидания статистики Z, учитывая, что математическое ожидание шума M[n(ti)] = 0, дисперсия D[n(ti)] = n2 :

(3.7)

(3.7)

(3.8)

(3.8)

(3.9)

(3.9)

Выразим вероятность ошибки и вероятность правильного принятия решения D = 1- через распределение статистики Z :

= P( L(y) > C/ s0) = P(Z > C* / s0) , (3.10)

D = 1- = P( L(y) > C / s1) = P(Z > C* / s1) . (3.11)

Интегральное представление вероятностей ошибок имеет вид

![]()

Н а

рисунке 3.1 отображено поведение условных

плотностей распределения w(z/sj)

при различных состояниях источника, а

также вероятности ошибок первого и

второго рода. Как видно, вероятности

ошибок первого и второго рода равны

площади под кривой плотности распределения

w(z/sj),

j=0; 1. Для явного представления вероятности

ошибки первого рода подставим (3.7), (3.9)

в формулу (3.6) и запишем

а

рисунке 3.1 отображено поведение условных

плотностей распределения w(z/sj)

при различных состояниях источника, а

также вероятности ошибок первого и

второго рода. Как видно, вероятности

ошибок первого и второго рода равны

площади под кривой плотности распределения

w(z/sj),

j=0; 1. Для явного представления вероятности

ошибки первого рода подставим (3.7), (3.9)

в формулу (3.6) и запишем

(3.12)

(3.12)

где с =С*/ z .

Подставляя (3.8), (3.9) в формулу (3.6), запишем вероятность правильного принятия решения D = 1- :

, где c

=

(C* - a

z1 )

/

z . (3.13)

, где c

=

(C* - a

z1 )

/

z . (3.13)

Введем параметр

dm:

. (3.14)

. (3.14)

Выразим значения с и с через известные величины с*, a z 1 , z , dm:

![]() (3.15)

(3.15)

К ак

видно из выражений (3.12)

(3.15), вероятность ошибки

и вероятность правильного принятия

решения D = 1 -

являются функциями параметра dm

и порога С, который в свою очередь зависит

от выбранного критерия. Если зафиксировать

dm,

а порог С рассматривать как параметр,

принимающий значения -

< C <

, то можно получить зависимость D=D(),

которая называется

рабочей характеристикой.

Ее можно построить, используя (3.12),

(3.13). На рисунке 3.2 показан график D=D()

для dm2

> dm1

.

ак

видно из выражений (3.12)

(3.15), вероятность ошибки

и вероятность правильного принятия

решения D = 1 -

являются функциями параметра dm

и порога С, который в свою очередь зависит

от выбранного критерия. Если зафиксировать

dm,

а порог С рассматривать как параметр,

принимающий значения -

< C <

, то можно получить зависимость D=D(),

которая называется

рабочей характеристикой.

Ее можно построить, используя (3.12),

(3.13). На рисунке 3.2 показан график D=D()

для dm2

> dm1

.

В теории статистических решений доказывается, что

![]() (3.16)

(3.16)

т.е. тангенс угла наклона касательной к кривой рабочей характеристики в некоторой точке ( , D) равен порогу обнаружения С. Таким образом, для заданных двух величин из четырех параметров , D, С, и dm с помощью рабочей характеристики можно найти два других параметра.