- •1. Теория информации

- •1.1 Теорема Котельникова

- •1.2 Квантование сигнала по уровню

- •2. Мера информации

- •2.1 Мера информации по Шеннону

- •2.2 Энтропия дискретного ансамбля сообщений

- •2.3 Энтропия непрерывного ансамбля сообщений

- •2.4 Энтропия непрерывного ограниченного ансамбля

- •2.3 Количество взаимной информации

- •2.3.1 Дискретный канал передачи информации

- •2.3.2 Непрерывный канал передачи информации

- •2.3.3 Эпсилон-энтропия (ε-энтропия)

- •Кодирование источника информации

- •3.1 Метод кодирования равномерным кодом

- •3.2 Метод кодирования Шеннона-Фано

- •3.3 Метод кодирования Хафмана

- •3.4 Теорема оптимального кодирования источника независимых сообщений.

- •4 Канал связи

- •4.1 Скорость передачи информации и пропускная способность канала связи

- •4.2 Канал без шумов

- •4.3 Канал с шумами

- •4.4 Непрерывный канал связи

- •4.5 Теорема Шеннона о пропускной способности частотно ограниченного канала

- •5. Кодирование в канале

- •5.1 Систематические коды

- •5.1.1 Образование систематического кода

- •5.1.2 Систематический код Хемминга

- •5.2 Циклические коды

- •5.2.1 Обнаружение однократной ошибки

- •5.2.2 Исправление однократной ошибки

- •1. Теория информации 1

2.3.2 Непрерывный канал передачи информации

Непрерывный канал передачи информации описывается одномерными и двумерными плотностями распределений вероятностей. Чтобы записать количество взаимной информации между входом и выходом канала связи, используем дискретное представление информации, а затем прейдем к непрерывным величинам.

Совместная вероятность появления

символа

![]() на входе канала и символа

на входе канала и символа![]() на выходе канала равна

на выходе канала равна

![]() ,

,

где

![]() и

и![]() -значенияyиz,

удовлетворяющие условиям

-значенияyиz,

удовлетворяющие условиям![]() ,

,![]() ,

,![]() и

и![]() -

границыi-го иj-го

интервалов квантования соответственно

дляyиz

-

границыi-го иj-го

интервалов квантования соответственно

дляyиz

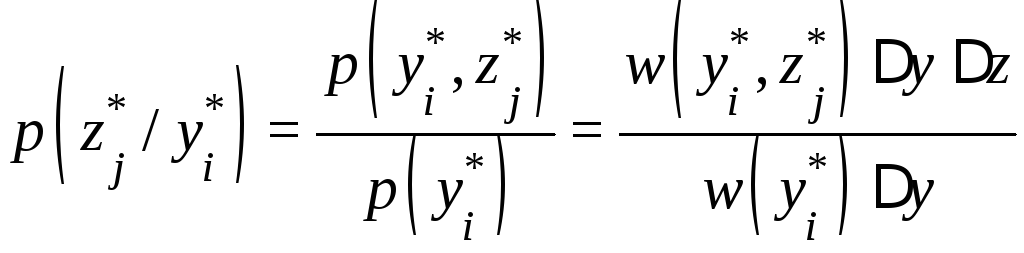

Вероятность появления символа

![]() на выходе канала при условии, что на

вход подан символ

на выходе канала при условии, что на

вход подан символ![]() ,

равна

,

равна

.

.

Количество информации, содержащееся в

символе

![]() ,

равно

,

равно

![]() .

.

Условное количество информации,

содержащееся в элементе

![]() ,

если на вход канала подаётся элемент

ансамбля

,

если на вход канала подаётся элемент

ансамбля![]() ,

равно

,

равно

.

.

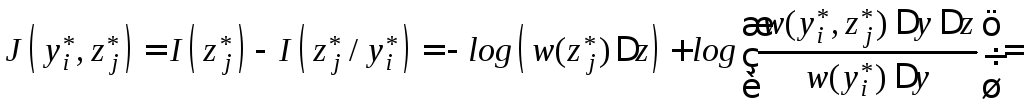

Тогда количество информации, содержащееся

в элементе

![]() относительно элемента

относительно элемента![]() ,

равно

,

равно

.

.

Как видно из последнего выражения,

интервалы квантования

![]() и

и![]() не влияют на количество информации,

содержащееся в элементе

не влияют на количество информации,

содержащееся в элементе![]() относительно элемента

относительно элемента![]() .

.

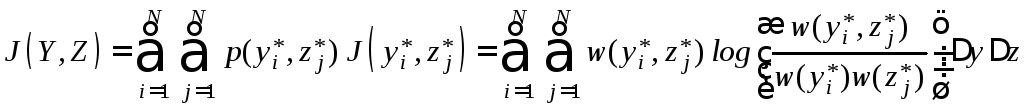

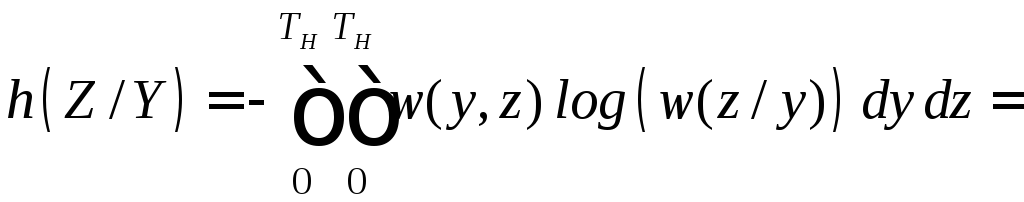

Количество взаимной информации,

содержащееся в ансамбле

![]() относительно ансамбля

относительно ансамбля![]() ,

равно

,

равно

.

.

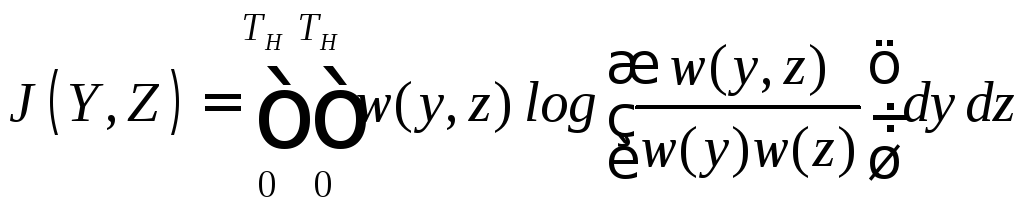

Осуществляя в предыдущем выражении

предельный переход

![]() ,

,![]() ,

получим интегральное представление

количества взаимной информации,

содержащееся в непрерывном ансамбле

,

получим интегральное представление

количества взаимной информации,

содержащееся в непрерывном ансамбле![]() относительно непрерывного ансамбля

относительно непрерывного ансамбля![]()

=

=

.

.

Количество взаимной информации,

содержащееся в ансамбле

![]() относительно ансамбля

относительно ансамбля![]() ,

равно количеству взаимной информации,

содержащееся в ансамбле

,

равно количеству взаимной информации,

содержащееся в ансамбле![]() относительно ансамбля

относительно ансамбля![]() .

.

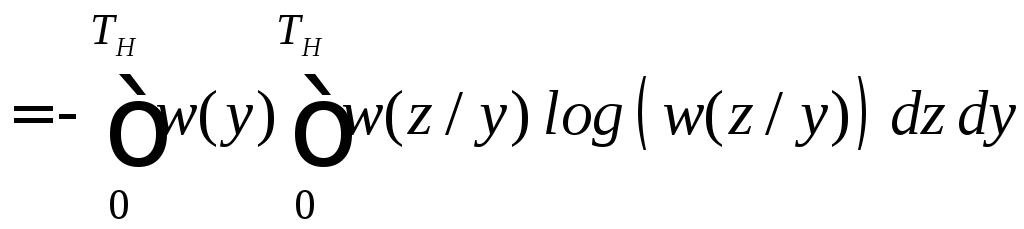

Выразим количество взаимной информации

![]() через энтропию ассамблейYиZ. Для этого используем

предыдущую формулу

через энтропию ассамблейYиZ. Для этого используем

предыдущую формулу

![]() ,

,

где

![]() - дифференциальная энтропия на один

отсчёт процесса

- дифференциальная энтропия на один

отсчёт процесса![]() ,

,

![]() - условная дифференциальная энтропия

на один отсчёт процесса

- условная дифференциальная энтропия

на один отсчёт процесса![]() при известном отсчёте

при известном отсчёте![]() .

.

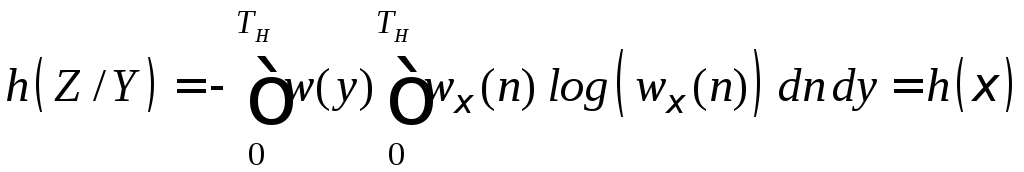

Точно так же можно показать, взаимная информация равна

![]()

,

,

где

![]() - дифференциальная энтропия на один

отсчёт процесса

- дифференциальная энтропия на один

отсчёт процесса![]() ,

,

![]() - условная дифференциальная энтропия

на один отсчёт процесса

- условная дифференциальная энтропия

на один отсчёт процесса![]() при известном отсчёте

при известном отсчёте![]() называетсяненадёжностьюканала

связи.

называетсяненадёжностьюканала

связи.

Рассмотрим

![]() -энтропию помехив непрерывном

канале связи. Сигналы на входе и выходе

канала связи и помеха описываются

линейной зависимостью

-энтропию помехив непрерывном

канале связи. Сигналы на входе и выходе

канала связи и помеха описываются

линейной зависимостью![]() ,

в которой каждая составляющая является

непрерывной случайной величиной со

своей плотностью распределения

вероятности. Условная энтропия

,

в которой каждая составляющая является

непрерывной случайной величиной со

своей плотностью распределения

вероятности. Условная энтропия![]() имеет вид:

имеет вид:

.

.

Положим, плотность распределения

вероятности шума известна и равна

![]() .

В условной плотности вероятности

.

В условной плотности вероятности![]() величинаyсчитается

известной. Тогда случайная величина

величинаyсчитается

известной. Тогда случайная величина![]() при известной величинеy

зависит только от шума и имеет место

при известной величинеy

зависит только от шума и имеет место![]() ,

откуда получим

,

откуда получим

.

.

Из этого выражения видно, что условная

плотность

![]() зависит только от шума. В результате

получим

зависит только от шума. В результате

получим

,

,

т.е. условная энтропия на один отсчёт

![]() равна энтропии шума

равна энтропии шума![]() на один отсчёт.

на один отсчёт.

2.3.3 Эпсилон-энтропия (ε-энтропия)

Наличие помехи в канале связи ухудшает

качество восстанавливаемого сигнала.

Возникает вопрос, до какой степени можно

допустить искажение сигнала помехой,

чтобы можно было сказать, сигнал,

поступивший в канал связи и вышедший

из канала связи идентичны Критерии

отождествления двух сигналов могут

быть самыми различными. Необходимо

ввести расстояние

![]() между элементами ансамблей

между элементами ансамблей![]() и

и![]() .

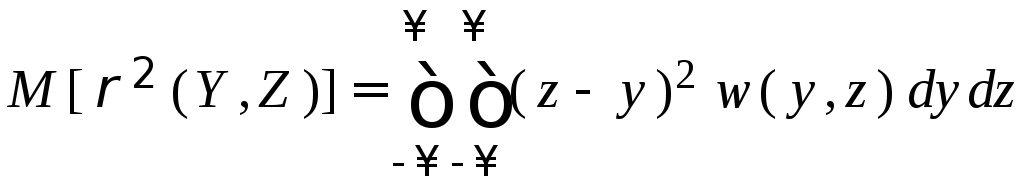

Мерой идентичности ансамблей

.

Мерой идентичности ансамблей![]() и

и![]() наиболее часто берут математическое

ожидание квадрата расстояния между

элементами ансамблей

наиболее часто берут математическое

ожидание квадрата расстояния между

элементами ансамблей![]() и

и![]() :

:

В качестве критерия «сходства» ансамблей

![]() и

и![]() примем

выполнение неравенства

примем

выполнение неравенства

![]() (2.21)

(2.21)

где

![]() - заранее заданная допустимая мера

отклонения «сходства» ансамблей

- заранее заданная допустимая мера

отклонения «сходства» ансамблей![]() и

и![]() .

.

Заданную меру «сходства»

![]() необходимо обеспечить при минимальном

количестве меры информации

необходимо обеспечить при минимальном

количестве меры информации![]() .

Ввиду того, что

.

Ввиду того, что

![]() ,

,

a![]() при отсутствии шума, то необходимо

минимизировать

при отсутствии шума, то необходимо

минимизировать![]() по всем возможным распределениям

плотности вероятности

по всем возможным распределениям

плотности вероятности

![]() .

.

Минимальное значение меры информации

![]() при выполнении условия

при выполнении условия![]() называетсяэпсилон-энтропией

(ε-энтропия) непрерывного

ансамбля

называетсяэпсилон-энтропией

(ε-энтропия) непрерывного

ансамбля

![]() .

(2.22)

.

(2.22)

Понятие

![]() -энтропия

введено Колмогоровым А.Н. [Колмогоров

А. Н. Теория информации и теория

алгоритмов.— М.: Наука, 1987.-304 с.(стр.46)

-энтропия

введено Колмогоровым А.Н. [Колмогоров

А. Н. Теория информации и теория

алгоритмов.— М.: Наука, 1987.-304 с.(стр.46)

Если на входе канала связи мощность

сигнала ограничена величиной

![]() ,

значения сигнала находятся в интервале

,

значения сигнала находятся в интервале![]() ,

то энтропия

,

то энтропия![]() не превышает энтропию нормального

закона распределения вероятности.

Энтропия нормального закона распределения

вероятности равна

не превышает энтропию нормального

закона распределения вероятности.

Энтропия нормального закона распределения

вероятности равна![]() .

Условная энтропия

.

Условная энтропия![]() зависит только от шума и принимает

максимальное значение

зависит только от шума и принимает

максимальное значение![]() при нормальном распределении шума

мощностью, не превышающей

при нормальном распределении шума

мощностью, не превышающей![]() .

Учитывая значения безусловной и условной

энтропий, получим

.

Учитывая значения безусловной и условной

энтропий, получим

.

.

Положим, источник генерирует сообщения

со скоростью

![]() [

[![]() ].

].

Тогда ε-призводительностью источника сообщений называется величина

![]()

.

(2.23)

.

(2.23)

Если учесть, что интервал дискретизации

![]() есть величина обратная полосе частот,

занимаемая сигналом, то, согласно теореме

Котельникова, получим

есть величина обратная полосе частот,

занимаемая сигналом, то, согласно теореме

Котельникова, получим

![]()

,

(2.24)

,

(2.24)

где

![]() - полоса частот, занимаемая сигналом

источника, приходящаяся на один отсчёт.

- полоса частот, занимаемая сигналом

источника, приходящаяся на один отсчёт.

Максимальная ε-призводительность

источника сообщений будет тогда,

когда значения сигнала![]() распределены по нормальному закону с

известной дисперсией

распределены по нормальному закону с

известной дисперсией![]() ,

,

,

,

.

.

Формулы (2.23) и (2.24) показывают, с какой

скоростью можно генерировать информацию,

чтобы восстановить сообщения с

погрешностью, не превышающей

![]() .

.