- •1. Теория информации

- •1.1 Теорема Котельникова

- •1.2 Квантование сигнала по уровню

- •2. Мера информации

- •2.1 Мера информации по Шеннону

- •2.2 Энтропия дискретного ансамбля сообщений

- •2.3 Энтропия непрерывного ансамбля сообщений

- •2.4 Энтропия непрерывного ограниченного ансамбля

- •2.3 Количество взаимной информации

- •2.3.1 Дискретный канал передачи информации

- •2.3.2 Непрерывный канал передачи информации

- •2.3.3 Эпсилон-энтропия (ε-энтропия)

- •Кодирование источника информации

- •3.1 Метод кодирования равномерным кодом

- •3.2 Метод кодирования Шеннона-Фано

- •3.3 Метод кодирования Хафмана

- •3.4 Теорема оптимального кодирования источника независимых сообщений.

- •4 Канал связи

- •4.1 Скорость передачи информации и пропускная способность канала связи

- •4.2 Канал без шумов

- •4.3 Канал с шумами

- •4.4 Непрерывный канал связи

- •4.5 Теорема Шеннона о пропускной способности частотно ограниченного канала

- •5. Кодирование в канале

- •5.1 Систематические коды

- •5.1.1 Образование систематического кода

- •5.1.2 Систематический код Хемминга

- •5.2 Циклические коды

- •5.2.1 Обнаружение однократной ошибки

- •5.2.2 Исправление однократной ошибки

- •1. Теория информации 1

4.1 Скорость передачи информации и пропускная способность канала связи

Ввиду того, что канал связи считается

стационарным, на вход канала поступает

последовательность символов

![]() ,

где каждый символ

,

где каждый символ![]() ,

образуетn-разрядный код.

Количество комбинаций, которое можно

образовать с использованием кода с

основаниемD, равно

,

образуетn-разрядный код.

Количество комбинаций, которое можно

образовать с использованием кода с

основаниемD, равно![]() .

Множество этих комбинаций образует

пространство значений кодовых комбинаций

.

Множество этих комбинаций образует

пространство значений кодовых комбинаций![]() .

Символы при ансамблеYобозначают моменты времени реализации

величины

.

Символы при ансамблеYобозначают моменты времени реализации

величины![]() .

Например, для двумерного ансамбляcоснованием кода, равнымD=3,

имеем

.

Например, для двумерного ансамбляcоснованием кода, равнымD=3,

имеем

.

.

На выходе канала имеем последовательность

символов

![]() ,

где каждый символ

,

где каждый символ![]() .

Точно так же можно образовать множество

кодовых комбинаций, составляющих

пространство

.

Точно так же можно образовать множество

кодовых комбинаций, составляющих

пространство![]() .

.

Последовательность символов

![]() поступает в канал в течение

поступает в канал в течение![]() .

.

Количество информации, которое передается

по каналу связи, за время наблюдения

![]() согласно (1.18) равно

согласно (1.18) равно

![]() .

(4.2)

.

(4.2)

Скоростью передачи информации по каналу связи называется величина

.

(4.3)

.

(4.3)

Скорость передачи информации Rотражает среднюю скорость передачи информации в единицу времени.

Максимальная

скорость передачи информации![]() называется пропускной способностью

канала связи

называется пропускной способностью

канала связи

.

(4.4)

.

(4.4)

Рассмотрим в выражении (1.18) разность

![]() .

Чем больше энтропия

.

Чем больше энтропия![]() ,

тем больше пропускная способность

канала связи.

Величина

,

тем больше пропускная способность

канала связи.

Величина ![]() определяет среднюю неопределённость,

содержащуюся в ансамблеY,

которая зависит от распределения

вероятности элементов ансамбляY.

Поэтому максимизация скорости передачи

информации происходит по распределению

вероятности элементов ансамбляY.

определяет среднюю неопределённость,

содержащуюся в ансамблеY,

которая зависит от распределения

вероятности элементов ансамбляY.

Поэтому максимизация скорости передачи

информации происходит по распределению

вероятности элементов ансамбляY.

Упростим выражение (4.2).

![]() .

В силу того, что канал - стационарный и

реализации элементов ансамблей

.

В силу того, что канал - стационарный и

реализации элементов ансамблей![]() и

и![]() в моменты времени

в моменты времени![]() и

и![]() независимы. Тогда

независимы. Тогда

![]() .

.

Но ансамбли

![]() за время передачи информации неизменны,

т.е.

за время передачи информации неизменны,

т.е.![]() .

Тогда имеем

.

Тогда имеем

![]() (4.5)

(4.5)

Условная энтропия в (4.2) представляется как

![]() =

=![]() =

=

= .

.

Воспользуемся условием независимости символов попарно на входе и выходе канала связи, а также стационарностью канала. Тогда соответствующие вероятности и условная энтропия будут равны

![]() =

=![]() ,

,

![]() =

=![]() ,

,

![]() =

= =

=

=![]() =

=![]() .

(4.6)

.

(4.6)

Если отсчёты во времени эквидистантны,

то

![]() ,

где

,

где![]() - интервал дискретизации по времени.

Подставив (4.5), (4.6) и

- интервал дискретизации по времени.

Подставив (4.5), (4.6) и![]() в (4.4), получим

в (4.4), получим

.

(4.7)

.

(4.7)

Введём скорость передачи символов

.

.

Тогда пропускную способность можно записать как

![]() (4.8)

(4.8)

В таблице 4.1 представлены характеристики источника сообщений, кодера источника и канала связи.

|

Таблица 4.1 |

| |

|

| ||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

4.2 Канал без шумов

Шум в канале связи искажает физические

параметры сигнала, что в свою очередь

приводит к искажению символов.

Вероятностная характеристика искажений

– это условная вероятность

![]() .

Будем считать, сигнал в канале не

искажается, если

.

Будем считать, сигнал в канале не

искажается, если![]() .

Тогда для канала без шумов справедливо

выражение

.

Тогда для канала без шумов справедливо

выражение

(4.9)

(4.9)

Из выражения (**.9) следует,

![]() ,

т.е. пропускная способность канала связи

равна

,

т.е. пропускная способность канала связи

равна

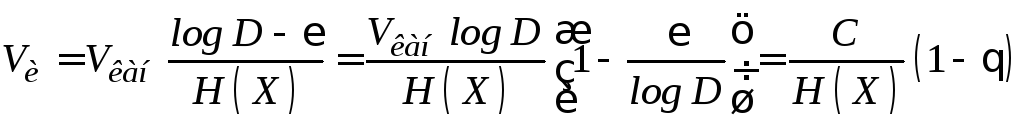

![]() =

=![]() (4.10)

(4.10)

Если используется код с основанием D,то энтропия ансамбля![]() достигает наибольшего значения при

достигает наибольшего значения при![]() .

Тогда пропускная способность канала

равна

.

Тогда пропускная способность канала

равна

![]() .

(4.11)

.

(4.11)

Теорема Шеннона о кодирование источника независимых сообщений для канала без шумов. (Шеннон, стр. 270)

Пусть источник имеет энтропию

![]() ,

а канал имеет пропускную способность

,

а канал имеет пропускную способность![]() .

Тогда можно закодировать сообщения

таким образом, что можно передавать их

со средней скоростью

.

Тогда можно закодировать сообщения

таким образом, что можно передавать их

со средней скоростью

,

где

,

где

![]() .

.

Передавать сообщения со скоростью

большей, чем

,

невозможно.

,

невозможно.

Доказательство. Будем считать источник

сообщений согласованным с каналом по

скорости передачи информации, если

![]() .

Тогда

.

Тогда

.

(4.12)

.

(4.12)

Энтропия

![]() не превышает

не превышает![]() .

Запишем

.

Запишем

![]() =

=![]() ,.

(4.13)

,.

(4.13)

где

![]() .

.

Подстановка (4.13) в (4.12) позволяет получить

,

(4.14)

,

(4.14)

где

![]() .

.

Если принять

![]() ,

то

,

то![]() ,

т.е. не имеет смысла передавать сообщения.

,

т.е. не имеет смысла передавать сообщения.