- •1. Теория информации

- •1.1 Теорема Котельникова

- •1.2 Квантование сигнала по уровню

- •2. Мера информации

- •2.1 Мера информации по Шеннону

- •2.2 Энтропия дискретного ансамбля сообщений

- •2.3 Энтропия непрерывного ансамбля сообщений

- •2.4 Энтропия непрерывного ограниченного ансамбля

- •2.3 Количество взаимной информации

- •2.3.1 Дискретный канал передачи информации

- •2.3.2 Непрерывный канал передачи информации

- •2.3.3 Эпсилон-энтропия (ε-энтропия)

- •Кодирование источника информации

- •3.1 Метод кодирования равномерным кодом

- •3.2 Метод кодирования Шеннона-Фано

- •3.3 Метод кодирования Хафмана

- •3.4 Теорема оптимального кодирования источника независимых сообщений.

- •4 Канал связи

- •4.1 Скорость передачи информации и пропускная способность канала связи

- •4.2 Канал без шумов

- •4.3 Канал с шумами

- •4.4 Непрерывный канал связи

- •4.5 Теорема Шеннона о пропускной способности частотно ограниченного канала

- •5. Кодирование в канале

- •5.1 Систематические коды

- •5.1.1 Образование систематического кода

- •5.1.2 Систематический код Хемминга

- •5.2 Циклические коды

- •5.2.1 Обнаружение однократной ошибки

- •5.2.2 Исправление однократной ошибки

- •1. Теория информации 1

3.4 Теорема оптимального кодирования источника независимых сообщений.

При заданном ансамбле

![]() изN независимых

сообщений с энтропией

изN независимых

сообщений с энтропией

![]() возможно так закодировать сообщения

ансамбля посредством последовательности

символов, что среднее число символов

на сообщение удовлетворяет неравенству

возможно так закодировать сообщения

ансамбля посредством последовательности

символов, что среднее число символов

на сообщение удовлетворяет неравенству

,

(3.1)

,

(3.1)

где

![]() - основание кода. Среднее число символов

на сообщение

- основание кода. Среднее число символов

на сообщение![]() не может быть сделано меньше, чем

не может быть сделано меньше, чем![]() .

.

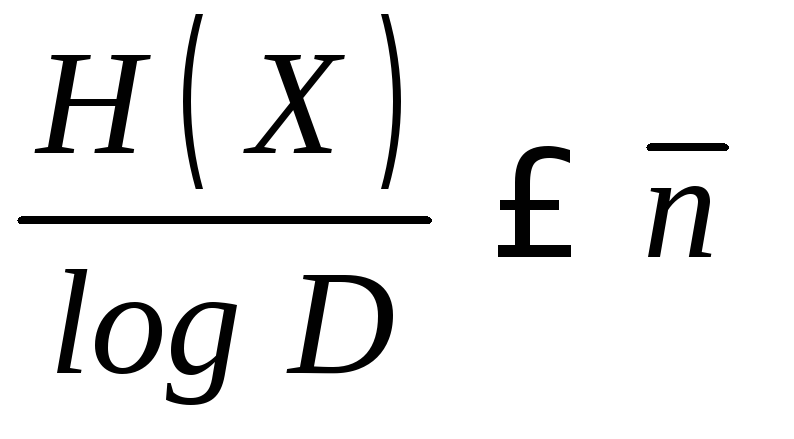

Величина

![]()

- количество информации, приходящееся

на один символ при кодировании кодом с

основаниемD.(При

кодировании двоичным кодом

- количество информации, приходящееся

на один символ при кодировании кодом с

основаниемD.(При

кодировании двоичным кодом![]() =1)

=1)

Доказательство. Рассмотрим левую часть

неравенства, составим разность

и используем неравенство

и используем неравенство![]() ,

где знак равенства реализуется приz= 1.

,

где знак равенства реализуется приz= 1.

.

(3.2)

.

(3.2)

Рассмотрим разность

![]() .

Пусть

.

Пусть![]() - количество символов, употребляемых

для кодирования

- количество символов, употребляемых

для кодирования![]() -го

сообщения,

-го

сообщения,![]() - наибольшее количество символов,

употребляемых для кодирования сообщения

в ансамблеX. Число

кодов, содержащих

- наибольшее количество символов,

употребляемых для кодирования сообщения

в ансамблеX. Число

кодов, содержащих![]() символов, которое можно было бы создать,

исходя из узла, состоящего из

символов, которое можно было бы создать,

исходя из узла, состоящего из![]() символов, равно

символов, равно![]() .

(Для иллюстрации этого предложения на

рисунке 3.4 выделено сообщение

.

(Для иллюстрации этого предложения на

рисунке 3.4 выделено сообщение![]() ,

имеющий код 100, т. е.

,

имеющий код 100, т. е.![]() .

Наибольшее число символов

.

Наибольшее число символов![]() на пятом уровне. На рисунке показаны

ветви, исходящие из кода 100 на третьем

уровне и останавливающиеся на пятом

уровне. Число неиспользуемых кодов

равно

на пятом уровне. На рисунке показаны

ветви, исходящие из кода 100 на третьем

уровне и останавливающиеся на пятом

уровне. Число неиспользуемых кодов

равно![]() .)

.)

Сумма всех неиспользуемых кодов не

превышает числа кодов, образованных

![]() разрядными кодами, т.е

разрядными кодами, т.е![]() или

или

![]() (3.3)

(3.3)

Неравенство (3.3) называется неравенством Крафта. Используя неравенство Крафта, из (3.1) получим

.

(3.4)

.

(3.4)

Знак равенства в (3.2) достигается тогда, когда

. (3.5)

. (3.5)

Из выражения (3.5) получим

,

, . (3.6)

. (3.6)

Как видно из (3.6), чем меньше вероятность

реализации события

![]() ,

тем больше требуется символов для

кодирования этого сообщения. Число

символов

,

тем больше требуется символов для

кодирования этого сообщения. Число

символов![]() - величина целая, но на практике при

произвольной вероятности

- величина целая, но на практике при

произвольной вероятности![]() получим дробную величину. Поэтому

величину

получим дробную величину. Поэтому

величину округляют до ближайшего целого числа

округляют до ближайшего целого числа

![]() ,

(3.7)

,

(3.7)

где

![]() .

.

Умножим левую и правую части равенства

(6) на![]() и просуммируем полученное выражение

и просуммируем полученное выражение

![]() .

(3.8)

.

(3.8)

Положим,

![]() .Тогда

после соответствующих подстановок

получим правую часть неравенства (3.1)

.Тогда

после соответствующих подстановок

получим правую часть неравенства (3.1)

. (3.9)

. (3.9)

Как видно из неравенства (1) среде число символов, применяемое при кодировании, зависит от метода кодирования и распределения вероятностей реализации сообщений. Теорема не отвечает на вопрос, как оптимально кодировать сообщения, она показывает границы среднего числа символов.

![]() - шум кодирования???

- шум кодирования???

Нет понятия скорости

кодирования источника сообщений,

нет понятия ошибки кодирования и декодирования,

нет понятия скорости создания информации

Все это есть у Колесника (≈ Стр 36)

4 Канал связи

Под каналом связи понимается среда, в которой перемещается сигнал. В зависимости от типа сигнала каналы разделяются на непрерывные и дискретные.

Предполагается, что сигнал, передаваемый по каналу связи, дискретный как по времени, так и по своим состояниям, и сообщения, генерируемые источником, сжаты одним из методов кодирования, (хотя это не обязательно). Модель передачи информации изображена на рисунке 1.1.

Д искретный

канал связи описывается ансамблем

входных символов

искретный

канал связи описывается ансамблем

входных символов

![]() с распределением вероятностей

с распределением вероятностей![]() ,

ансамблем выходных символов

,

ансамблем выходных символов

![]() и условными вероятностями

и условными вероятностями![]() =

=![]() перехода одного символа в другой.

Условные вероятности составляют матрицу

переходов

перехода одного символа в другой.

Условные вероятности составляют матрицу

переходов

(4.1)

(4.1)

Символы![]() ,

поступающие в канал связи в моменты

времени

,

поступающие в канал связи в моменты

времени![]() выбраны из ансамбляY,

т.е.

выбраны из ансамбляY,

т.е.![]() .

Обычно в канале связи действуют шумы,

искажающие физические свойства сигналов,

несущих информацию. В результате на

выходе канала получают последовательность

символов

.

Обычно в канале связи действуют шумы,

искажающие физические свойства сигналов,

несущих информацию. В результате на

выходе канала получают последовательность

символов![]() таких, что

таких, что![]() .

По своим свойствам канала связи

классифицируется как

.

По своим свойствам канала связи

классифицируется как

1) неоднородный канал с памятью - условная

вероятность

![]() получить символ

получить символ![]() в момент времени

в момент времени![]() зависит от некоторого множества символов

поступивших на вход канала до момента

времени

зависит от некоторого множества символов

поступивших на вход канала до момента

времени![]() .

Неоднородность проявляется в том, что

сохраняется зависимость условной

вероятности от времени.

.

Неоднородность проявляется в том, что

сохраняется зависимость условной

вероятности от времени.

2) Неоднородный канал без памяти - условная

вероятность

![]() не зависит от всех предыдущих символов

на входе канала, но зависимость от

времени остается

не зависит от всех предыдущих символов

на входе канала, но зависимость от

времени остается

3) Однородный канал без памяти (стационарный

канал) - условная вероятность

![]() не зависит от времени. В этом случае

можно записать

не зависит от времени. В этом случае

можно записать![]() =

=![]() .

.

В дальнейшем рассматривается стационарный канал.

Канал называется симметричным, если

На рисунке 4.2 представлена модель симметричного канала с основанием кода

D= 3. На рисунке 4.3 изображена модель канала со стиранием.

Н

а

практике при больших шумах часто нельзя

отдать предпочтение тому или иному

состоянию ансамбляZ. В

этом случае в ансамбльZвносится новое состояние

а

практике при больших шумах часто нельзя

отдать предпочтение тому или иному

состоянию ансамбляZ. В

этом случае в ансамбльZвносится новое состояние

![]() .

При переходе любого

.

При переходе любого![]() в состояние

в состояние![]() должны быть предусмотрены какие-то

действия, исключающие эту ошибку: стереть

полученный символ, продублировать

информацию и т. д. В этом случае имеем

канал со стиранием.

должны быть предусмотрены какие-то

действия, исключающие эту ошибку: стереть

полученный символ, продублировать

информацию и т. д. В этом случае имеем

канал со стиранием.