- •2.1. Основные понятия…………………………………………….11

- •3.2. Кодирование в дискретных каналах…………………...……111

- •1. Информация. Сообщение. Сигнал

- •1.1. Основные понятия

- •1.2. Дискретизация непрерывных сообщений

- •2.1. Основные понятия

- •Из (2.19) следует, что

- •Р ис.2.4. Двоичное кодовое дерево для кода примера 2.19

- •Поскольку

- •Из свойства аддитивности тогда следует, что

- •Из условия (3.29) следует, что

- •3.2. Кодирование в дискретных каналах

- •Источник

- •5.1.3. Кодирование сообщений с заданной мерой верности

3.2. Кодирование в дискретных каналах

В этой и следующей главах будет рассматриваться кодирование при передаче сообщений по каналам связи, подверженным воздействию шума. В любом реальном канале связи, который используется для передачи сообщений, всегда в той или иной степени действует шум. В результате воздействия шума на приемной стороне никогда не может быть вынесено абсолютно достоверное решение о том, какое сообщение передавалось по каналу. Наличие такой неопределенности приводит к существованию ненулевой вероятности ошибочной передачи сообщения. Если не принимать соответствующих мер для защиты передаваемых сообщений, то эта вероятность может оказаться весьма большой.

Защита сообщений от влияния шума канала реализуется с помощью специальных методов кодирования. Легко понять, что одним из возможных методов защиты является увеличение энергии, затрачиваемой на передачу каждого сообщения, например, с помощью многократного повторения передачи одного и того же сообщения. Однако при таком методе защиты время передачи одного сообщения становится весьма большим и, следовательно, скорость передачи — весьма низкой. Возможен и другой метод увеличения энергии, основанный на увеличении мощности передатчика. Однако зачастую на практике мощность передатчика не может быть увеличена в силу различных технических ограничений.

Повторение сообщений является тривиальным методом кодирования. Оказывается, что имеются нетривиальные методы кодирования, которые позволяют осуществлять передачу сообщений со сколь угодно высокой достоверностью и относительно высокой скоростью. Основной задачей, которую мы будем решать в этой и следующей главе, является определение по заданной статистической модели канала величины наибольшей скорости, при которой возможна передача сообщений с произвольно малой вероятностью ошибки.

Классификация каналов связи

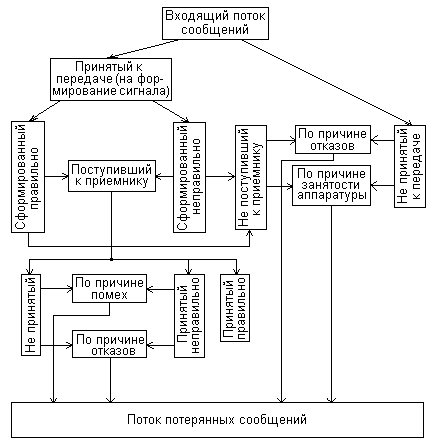

На рис. 3.1 приведена структурная схема системы связи. Всякая система связи использует некоторый канал связи. Физически канал представляет собой среду, в которой распространяются сигналы, соответствующие передаваемым сообщениям. Например, это меняющиеся во времени значения напряжения или тока, если канал образован парой проводов, или меняющаяся во времени напряженность электромагнитного поля в случае радиоканалов. Однако часто в канал включают не только физическую среду, но и некоторые устройства, сопряженные с входом и выходом физического канала. Например, это могут быть антенные устройства, выходные цепи передатчиков и входные цепи приемников. В зависимости от этого получаются различные модели реальных каналов связи.

Шум, действующий в канале, имеет такую же физическую природу, что и сигналы, и, как обычно предполагается в статистической теории связи, никогда не известен точно наблюдателю, находящемуся на приемной стороне системы связи. Поэтому наблюдатель всегда находится перед проблемой определения того, что же было передано по каналу.

Источник

Кодер

источ-

ника

Источ-ник

Кодер

канала

Моду-лятор

Канал

Получатель

Декодер

источ-

ника

Полу-чатель

Демо-дулятор

Декодер

канала

Рис. 3.1. Структурная схема система связи

Здесь мы будем предполагать, что кодер источника выбран достаточно хорошо, поэтому можно считать, что символы, появляющиеся на его выходе, независимы и равновероятны. Таким образом, пару «источник — кодер источника» можно рассматривать как новый источник дискретных сообщений. Аналогично пару «декодер источника - получатель» мы будем рассматривать как получателя сообщений в системе передачи. Роль остальных блоков системы связи сводится к тому, что обеспечить максимально надежную передачу последовательности независимых равновероятных символов. Основную роль в решении этой задачи играет пара «кодер —декодер» канала.

Роль пары «модулятор — демодулятор» можно пояснить следующим образом. Предположим, что задано множество символов на выходе кодера канала. Эти символы могут передаваться с помощью различных сигналов. Например, если символов всего два, то они могут быть переданы либо двумя значениями амплитуды несущих колебаний, либо двумя значениями частоты, либо двумя значениями длительности колебаний при фиксированной частоте и амплитуде и т. д.

Форма сигналов влияет на результирующее действие шумов. Например, при одинаковом источнике шума частота ошибок при использовании второго метода передачи может быть меньшей, чем при использовании первого.

Устройство, сопоставляющее каждому символу или группе символов на выходе кодера соответствующий входной сигнал канала, называется модулятором. Устройство, выполняющее обратное преобразование, называется демодулятором. Задачей конструктора системы связи является построение таких пар «кодер — декодер», «модулятор — демодулятор», которые наиболее эффективно уменьшают влияние шумов.

Для осуществления этой задачи необходимо совместное проектирование указанных пар. Однако довольно часто встречается ситуация, когда проектировщик системы не имеет возможности выбирать способ модуляции и демодуляции. Такая ситуация имеет место, например, когда пользователю предоставляется канал вместе с модулятором и демодулятором, а возможно выбирать только метод кодирования и декодирования. В этом случае каналом для проектировщика системы связи является та часть на рис. 3.2.1., которая находится между выходом кодера канала и входом декодера канала. Такой канал называют дискретным. Действие шума проявляется в том, что символ на выходе кодера может не совпадать с соответствующим ему символом на входе декодера.

Общее проектирование кодера и модулятора, а также декодера и демодулятора является весьма сложной задачей. В этом разделе мы всегда будем предполагать, что модулятор—демодулятор и, следовательно, система используемых сигналов выбрана, а задача состоит в выборе пары кодер —декодер.

Для теории информации физическая природа сигналов и шумов является несущественной. Так же, как и при кодировании источников, мы будем рассматривать сигналы на входе и выходе канала как элементы некоторых абстрактных множеств (алфавитов). В предыдущем изложении мы различали дискретные и непрерывные источники в зависимости от выбора множества сообщений. Аналогичная классификация имеет место и для каналов.

Канал называют дискретным по входу (выходу), если множество входных (выходных) сигналов конечно.

Иногда дискретным называют такой канал, в котором эти множества, или одно из них, счетно. В настоящем изложении каналы со счетными бесконечными алфавитами не встречаются.

Канал называют непрерывным по входу (выходу), если множество входных (выходных) сигналов несчетно.

Канал называют каналом, дискретным по входу и непрерывным по выходу (полунепрерывным), если множество входных сигналов конечно, а множество выходных сигналов несчетно.

Обычно множество входных сигналов канала будет обозначаться через X, а некоторый элемент этого множества — через х. Аналогичные обозначения Y и у используются для обозначения выходных сигналов канала.

Говоря о непрерывных или полунепрерывных каналах, мы в дальнейшем будем предполагать, что их вероятностное описание может быть дано в терминах функций плотностей вероятностей. Такое ограничение не является существенным, оно принято только в целях упрощения изложения.

Канал называют каналом с дискретным временем, если сигналы на его входе и выходе представляют собой конечные или бесконечные последовательности с элементами из алфавитов X и Y соответственно. Дискретный по входу и выходу канал с дискретным временем мы будем называть дискретным каналом.

Канал называют каналом с непрерывным временем, если сигналы на его входе и выходе представляют собой действительные функции времени. Непрерывный по входу и выходу канал с непрерывным временем мы будем называть непрерывным каналом.

В этом резделе рассматриваются только дискретные каналы. Непрерывные каналы (с дискретным и непрерывным временем) будут рассмотрены в следующем разделе.

Для полного задания канала необходимо задать статистическое описание процесса передачи. Как уже отмечалось, наличие шума может привести к тому, что один и тот же входной сигнал канала может перейти в различные выходные сигналы. С математической точки зрения такие переходы могут описываться с помощью распределений вероятностей. В случае дискретного канала переходы входных сигналов в выходные задаются условными вероятностями р (у|х), хX, у Y, получения на выходе сигнала у, если на входе был сигнал х.

В дальнейшем X и Y будут рассматриваться как множества сигналов на входе и выходе канала, которые появляются в некоторый фиксированный момент времени. Поэтому условные вероятности {р(у|х)} будут описывать только процесс однократной передачи (передачи одного сигнала) в этот фиксированный момент времени. Однако по каналу никогда не передается один-единственный сигнал, а передается, как правило, достаточно длинная последовательность сигналов. Поэтому задание только одномерных условных вероятностей или условных плотностей вероятностей в общем случае не описывает процесс передачи полностью.

Мы будем говорить, что дискретный канал задан, если для любых целых чисел n и j и любых последовательностей

(x(j), x(j+1),..., х(n+j1)) (y(j), y(j+1),..., y(n+j1))

с элементами из дискретных множеств X и Y соответственно заданы условные (или переходные) вероятности р (y(j), y(j+1),..., …,y(n+j1) | x(j), x(j+1),..., х(n+j1)) получения на выходе канала последовательности (y(j), y(j+1),..., y(n+j1)), если на входе канала была последовательность (x(j), x(j+1),..., х(n+j1)).

Дискретный канал называют каналом без памяти, если для любых n и j, а также для любых последовательностей (x(j), x(j+1),..., х(n+j1)) и (y(j), y(j+1),..., y(n+j1)) имеют место равенства

![]() (3.35)

(3.35)

где pi (y|x) —вероятность для момента времени i получения на выходе канала сигнала у, если на входе был сигнал х.

Название «без памяти» подчеркивает тот факт, что если выполняются соотношения (3.35), то при очередной передаче канал как бы не помнит результатов предыдущих передач.

Будем говорить, что дискретный канал без памяти удовлетворяет условию стационарности, если для любых i, j, х X, у Y

pj (y | x)= pi (y | x) (3.36)

Другими словами, статистические характеристики процесса передачи последовательностей сигналов по стационарному каналу без памяти не зависят от момента начала передачи и сохраняются постоянными на протяжении всего времени передачи.

Из определения следует, что для задания дискретного канала без памяти, удовлетворяющего условию стационарности, достаточно задать лишь одномерные переходные вероятности. В дальнейшем мы всегда будем предполагать, если это не оговорено особо, что дискретные каналы без памяти удовлетворяют условию стационарности. При этом дискретный канал без памяти мы иногда будем обозначать как {XY, р (у|х)}, где X, Y — входной и выходной алфавиты и р (у|х), х X, у Y, — переходные вероятности канала.

Ниже мы будем всюду предполагать, что зафиксирован момент времени j, в который начинается передача по каналу связи. Для простоты будем полагать j = 1. Из приведенных определений следует, что в общем случае для задания дискретного канала, по которому сообщения передаются, начиная с момента j = 1, необходимо задать переходные вероятности р (у | х) для всех n = 1, 2, … и всех последовательностей x (x(1),..., х(n))Xn и y (y(1),..., y(n))Yn. Мы будем предполагать, что переходные вероятности удовлетворяют следующим условиям согласованности:

![]()

n=1, 2,…, k=1,…,n - 1

Каналы, удовлетворяющие условиям согласованности, называются каналами без предвосхищения. В таких каналах вероятность появления выходного сигнала в некоторый момент времени не зависит от сигналов, которые появятся на входе канала в последующие моменты времени.

Отметим, что распределение вероятностей на входе канала не входит в описание канала, поскольку входное распределение определяется устройствами на входе канала (источником, кодером источника и кодером канала), но не самим каналом. Однако, если некоторое входное распределение, скажем р(х), задано, то оно вместе с условными вероятностями р(у|х) задает совместное распределение вероятностей на парах (х, у) ХnУn

p (x, y)=p (y | x) p (x) (3.37)

и распределение вероятностей на выходных последовательностях канала

![]() (3.38)

(3.38)

3.2.2. Постановка задачи кодирования в дискретном канале

Назначение кодера и декодера канала состоит в том, чтобы уменьшить влияние шумов в канале и обеспечить надежную связь между источником и получателем сообщений. В следующем примере рассматривается один из методов повышения надежности связи.

Пример 3.1. Пусть множества входных и выходных сигналов дискретного канала без памяти состоят из двух элементов {0, 1} и пусть р (0|1) = р (1|0) = р. Такой канал называется двоичным симметричным и полностью определяется заданием величины р. Действительно, если х, у— последовательности длины n из нулей и единиц на входе и выходе канала, то

![]()

Где t — количество позиций, на которых последовательности х и у различаются, другими словами, t — количество ошибок при передаче х и получении у.

Предположим, что р < 0,5 и требуется передать одно из двух сообщений z1 или z2. Можно было бы закодировать эти сообщения так: z10, z21. Однако при этом вероятность неправильного приема сообщения равнялась бы р.

Рассмотрим другой метод кодирования (передачу с помощью повторений): если надо передать z1, то по каналу передается последовательность из n нулей, если же надо передать z2, то по каналу передается последовательность из n единиц. Приемник работает по следующему правилу: если в принятой последовательности количество нулей больше количества единиц, считается, что передавалось z1, в противном случае считается, что передавалось z2.

Очевидно, что ошибка декодирования возникает всякий раз, когда при передаче последовательности длины n число ошибок t превосходит или равно n/2. Так как в рассматриваемом канале вероятность ошибочного приема сигнала равна р и не зависит от того, какой сигнал, 0 или 1, передавался, то вероятность неправильного приема сообщения можно определить следующим образом:

![]() (3.39)

(3.39)

Так как математическое ожидание числа ошибок в последовательности длины n равно nр < n/2, то в силу закона больших чисел стремится к нулю при возрастании n.

Таким образом, мы видим, что вероятность неправильной передачи сообщений по каналу может быть сделана сколь угодно малой, если это сообщение передается посредством достаточно большого числа повторений одного и того же входного сигнала. Время передачи при таком методе кодирования пропорционально числу повторений. Поэтому, чтобы вероятность неправильного приема была достаточно малой, необходимо иметь достаточно большое время передачи. При этом скорость передачи, т. е. количество информации, передаваемое в единицу времени, будет стремиться к нулю, так как за все время передачи будет передано одно из двух сообщений или не более 1 бита информации.

Произвольно малая вероятность ошибки может быть также достигнута и при скоростях передачи, отличных от нуля, за счет усложнения методов кодирования и соответственно декодирования.

Кодом с длиной n и объемом М для канала называется множество из М пар {u1, A1; u2, A2;...; uM, AM} где uiXn; i=1,...,М — последовательности длины n, образованные входными сигналами канала и называемые кодовыми словами (uiuj при i j), и Ai Yn, i = 1, 2, ... ..., М, — решающие области, образованные выходными последовательностями канала, причем при i j множества Аi и Аj.

Если задан код, то тем самым задано как множество кодовых слов, так и правило, по которому приемник принимает решение о переданном кодовом слове: если на выходе канала появляется последовательность у и у Ai то приемник принимает решение о том, что передавалось слово ui.

Скоростью кода (или скоростью передачи) называется величина

![]() (3.40)

(3.40)

где М — объем и n — длина кода.

Из этого определения следует, что скорость кода представляет собой максимальное количество информации, которое может быть передано с помощью одного сигнала (или символа), так как log M есть максимальное количество информации, которое может быть передано с помощью одного кодового слова. Это количество информации действительно передается, когда кодовые слова имеют одинаковые вероятности появления. Скорость измеряется в битах на символ. Если скорость кода равна R бит/символ, то с помощью такого кода можно передавать nR двоичных единиц информации за время передачи одного кодового слова (за n единиц времени).

Очевидно, что число кодовых слов не может превышать общего числа последовательностей длины n, образованных символами входного алфавита (входными сигналами), канала. Для дискретных каналов это число равно Ln, где L — число элементов множества входных сигналов. Следовательно, в случае дискретных каналов R log L.

Следует отметить разницу в определениях скорости кода канала и скорости кода источника. В случае кода источника скорость определяется как отношение логарифма числа кодовых слов к длине отрезков кодируемых сообщений. В случае кода канала скорость определяется как отношение того же числа к длине кодовых слов (к длине кодирующих последовательностей).

Очевидно, что код длины n, имеющий скорость R, имеет объем М = 2nR. Такой код в дальнейшем будем обозначать символом G(n, R).

Пример

3.2. Предположим, что двоичный источник

без памяти имеет энтропию Н(X)

< 1. Как было показано ранее, при

кодировании сообщений такого источника

можно достичь скорости, близкой к Н(X).

Это означает, что при появлении на входе

кодера источника n

двоичных символов, где n

достаточно велико, на выходе кодера

появляется примерно nН(X)

двоичных символов, что меньше, чем n.

Если теперь рассматривать последовательности

длины nН(X)

как входные сообщения для кодера

двоичного канала, осуществляющего

кодирование со скоростью R

< 1, то длина кодовых слов будет равна

![]() ,

что больше, чем nН(X).

Таким образом, кодирование источника

понижает длину последовательностей

сообщений, а кодирование в канале ее

увеличивает. В связи с этим кодирование

источника иногда называют устранением

избыточности, а кодирование в канале —

введением избыточности. Последовательное

применение этих двух операций в

большинстве случаев увеличивает

эффективность передачи по сравнению с

непосредственной передачей сообщений

источника без какого-либо кодирования.

,

что больше, чем nН(X).

Таким образом, кодирование источника

понижает длину последовательностей

сообщений, а кодирование в канале ее

увеличивает. В связи с этим кодирование

источника иногда называют устранением

избыточности, а кодирование в канале —

введением избыточности. Последовательное

применение этих двух операций в

большинстве случаев увеличивает

эффективность передачи по сравнению с

непосредственной передачей сообщений

источника без какого-либо кодирования.

Если заданы некоторый канал и код, то мы можем определить вероятность ошибки декодирования данного кода при передаче по данному каналу. Пусть передается слово ui некоторого фиксированного кода G(n,R), тогда ошибка декодирования возникает в случае, когда последовательность на выходе канала не принадлежит решающей области Ai. Обозначая через i вероятность ошибки декодирования при условии передачи слова ui ,получим

![]() (3.41)

(3.41)

где

![]() — дополнение к множеству Ai.

— дополнение к множеству Ai.

В качестве количественной меры надежности передачи с помощью кода G(n,R) мы будем использовать две величины. Первая — максимальная вероятность ошибки

max {1, ..., M } (3.42)

Вторая — средняя вероятность ошибки

![]() (3.43)

(3.43)

где р (ui) — вероятность передачи i-го кодового слова.

Так как распределение вероятностей р(ui) характеризует источник сообщений и никак не связано ни с каналом, ни с кодом, то средняя вероятность ошибки декодирования часто определяется следующим образом:

![]() (3.44)

(3.44)

Выражение (3.44) совпадает с (3.43) в случае оптимального кодирования источника, когда р (ui)= l/M, i = 1, ..., М.

Пропускной способностью канала с дискретным временем называется максимальное число С такое, что для любого сколь угодно малого , >0, и для любого R, R<С, существует код G(n,R) такой, что максимальная вероятность ошибки удовлетворяет неравенству

< (3.45)

С — это верхняя грань скоростей кодов, для которых выполняется (3.45), поэтому передача с произвольно малой вероятностью ошибки при скоростях R>С невозможна и, следовательно, для любого R>С существует положительное число ' такое, что ' для любого n и любого кода G (n, R).

Для того чтобы доказать, что некоторое число С является пропускной способностью канала, необходимо доказать два утверждения:

1) при любом R < С и любом положительном существует код длины n, скорость которого равна R и максимальная вероятность ошибки удовлетворяет неравенству < (прямая теорема кодирования);

2) для всякого R > С найдется положительное число <' такое, что <' для любого п и любого кода G (n, R) (обратная теорема кодирования).

Пропускная способность канала была определена относительно максимальной вероятности ошибки . Очевидно, что, если для некоторого кода максимальная вероятность ошибки не превосходит, то и средняя вероятность ошибки для этого кода также не превосходит . Следующая лемма устанавливает, что в определенном смысле верно и обратное утверждение. Поэтому пропускную способность можно определять как максимальную скорость, при которой средняя вероятность ошибки не превосходит .

Л е м м а Пусть существует код объема М с вероятностью ошибки К, определенной соотношением (3.44), тогда существует код объема М/2, максимальная вероятность ошибки которого удовлетворяет неравенству 2.

Предположим, что в коде объема М кодовые слова u1,..., uM упорядочены по невозрастанию вероятности ошибки, т. е. i j при i < j. Имеет место следующая цепочка неравенств:

![]() (3.46)

(3.46)

В силу упорядоченности вероятностей ошибок из (3.46) вытекает, что

j M/2 2 (3.47)

для всех j > М/2. Тогда код объема М/2, образованный словами uM/2+1,..., uM, имеет максимальную вероятность ошибки, не превышающую 2. Лемма доказана.

Из леммы следует, что, если при любом R'<С существует код G (n, R') такой, что

< / 2 (3.48)

где — произвольное положительное число, то при любом R < С существует код G (n, R), для которого < .

Действительно, скорость кода, построенного в доказательстве леммы, равна R=R'—1/n. Поэтому для любого R<С найдется такое, быть может большое, значение n, что R'<С и, следовательно, существует код, для средней вероятности ошибки которого выполняется неравенство (3.48). По лемме подкод объема М/2 этого кода имеет максимальную вероятность ошибки < и скорость R.

3.2.3. Неравенство Фано

В этом параграфе будет рассмотрено основное неравенство, с помощью которого доказываются обратные теоремы кодирования для различных каналов.

Пусть задан дискретный ансамбль {UW, р (u, w}, где V={u1, u2,…, uM}, W={w1, w2, ..., wL}. Обозначим через Е событие, состоящее в появлении пары (ui, wj), i j. Это событие будем называть «ошибкой». Положим

![]() (3.49)

(3.49)

![]() (3.50)

(3.50)

где

![]()

Величину j будем называть условной вероятностью ошибки при фиксированном wj W, а величину — средней вероятностью ошибки.

Рассмотрим

множество Е = {Е,

![]() },

состоящее из двух событий Е и

,

где

— событие, дополнительное к Е, оно

наступает при появлении любой пары (ui,

wj),

для которой i=j.

На множестве Е для каждого wjW

определено условное распределение

вероятностей {j,

1—j}.

Это распределение совместно с безусловным

распределением р (wj),

j

= 1, ...,L,

задает ансамбль ЕW,

для которого

},

состоящее из двух событий Е и

,

где

— событие, дополнительное к Е, оно

наступает при появлении любой пары (ui,

wj),

для которой i=j.

На множестве Е для каждого wjW

определено условное распределение

вероятностей {j,

1—j}.

Это распределение совместно с безусловным

распределением р (wj),

j

= 1, ...,L,

задает ансамбль ЕW,

для которого

H (E | wj ) j log j (1-j ) log (1- j ) = h (j) (3.51)

где h (р) = —р log р — (1 — р) log (1 — р), и

![]() (3.52)

(3.52)

Безусловное распределение вероятностей на Е есть {, 1—}. При этом

H (E) = h () (3.53)

В следующей теореме устанавливается связь между условной энтропией H (U|W) и вероятностью ошибки .

Т е о р е м а (неравенство Фано). Для любого дискретного ансамбля {UW, p (u, w)}, |U| = M, справедливо неравенство

H (U | W) h () + log M (3.54)

Рассмотрим условную энтропию H(U|wj). При j М имеем

H

(U|wj)![]() log

p(ui,

wj)=

- p(uj|wj)log

p(uj|wj)

–

log

p(ui,

wj)=

- p(uj|wj)log

p(uj|wj)

–

-

[1- p(uj|wj)]log[1

- p(uj|wj)]![]() log

p(ui|wj)+

log

p(ui|wj)+

+ [1- p(uj|wj)]log[1 - p(uj|wj)]=H(E|wj)=

=![]() (3.55)

(3.55)

где последнее равенство следует из (3.49) и (3.51). Из соотношения (3.49) следует также, что

![]() (3.56)

(3.56)

Поэтому второе слагаемое в последнем выражении в (3.55) представляет умноженную, на j энтропию ансамбля, состоящего из (М—1) сообщений, вероятности которых указаны как слагаемые в сумме (3.3.8). Если эту энтропию оценить сверху величиной log M, то

H (U | wj) H (E | wj) + j log M= h( j)+ j log M (3.57)

При j > М (такое j найдется, если L > М) имеем

H (U|wj) log p(ui| wj ) log M (3.58)

Так как при j > М всегда происходит ошибка, то при таких значениях jj = 1 и H(E |wj) =h (j) = 0. Следовательно, из (3.58) вытекает, что неравенство (3.57) имеет место при всех j= 1, ..., L.

Усредним обе части неравенства (3.57) по ансамблю W. Для этого умножим правую и левую части неравенства на р(wj) и просуммируем по всем j. В результате получим, что

H (U | W) H (E | W) + log M (3.59)

Поскольку условная энтропия H(E|W) не превосходит безусловную Н(Е)=h(), то из (3.59) следует неравенство (3.54). Теорема доказана.

Рассмотрим, как неравенство Фано может применяться для оценки вероятности ошибки декодирования в дискретном канале связи. Пусть задан дискретный канал, т. е. заданы множества входных X и выходных Y сигналов, а также при всех n = 1, 2, ... заданы условные вероятности р(у|х), уУn, хXn. Предположим, что для передачи по каналу используется код G (n, R) = — {u1, A1; u2, A2;...; uM, AM } длины n и объема М = 2nR.

Обозначим через W множество решений {w1, …, wM, wM+1}, которые принимает приемник о передаваемых кодовых словах. Решение есть wj, j M+1, если выходная последовательность канала принадлежит области Aj, решение есть wM+1, если выходная последовательность канала не принадлежит ни одной решающей области Aj, j= 1, ..., М. Пусть U = {u1,…, uM+1}— множество кодовых слов и р(ui) — вероятность появления слова ui на входе канала. Тем самым определен ансамбль {UW, p(u,w)}, элементами которого являются пары (u, w) — (переданное слово, решение), а распределение вероятностей

р (ui, wj) = p (ui) p ( wj | ui), i=1,...,M, j=1,..., M+1.

где

![]()

![]()

При этом величина j представляет собой условную вероятность ошибки декодирования для кода G (n, R) при условии, что в результате декодирования вынесено решение wj W, а величина (см. (3.50)) представляет собой среднюю вероятность ошибки декодирования. Эта средняя вероятность ошибки может быть вычислена также по формуле :

![]()

Энтропия H (U | W) в рассматриваемом случае представляет собой среднюю условную информацию ансамбля кодовых слов при фиксированном множестве решений. Величину Н(U|W) иногда называют ненадежностью передачи с помощью кода G(n,R). Она характеризует количество информации, потерянное при передаче из-за шума в канале. Неравенство Фано (3.54) устанавливает связь между ненадежностью передачи и средней вероятностью ошибки декодирования для кода G (n, R).

Неравенство Фано можно интерпретировать следующим образом. Для того чтобы наблюдатель, находящийся в декодере, мог точно установить переданное сообщение, он, во-первых, должен знать, допускает или не допускает ошибку декодер. Среднее количество информации, необходимое для этого, равно h(). Если наблюдатель знает, что при декодировании произошла ошибка, то ему необходимо дополнительно установить, какое из оставшихся М—1 кодовых слов было действительно передано. Среднее количество информации, необходимое для этого, не превосходит log M. Так как такая необходимость возникает с вероятностью , то среднее количество дополнительной информации не превосходит log M. Неравенство (3.3.6) обосновывает тот интуитивно ясный факт, что потеря информации в канале из-за действия шумов, т. е. величина H(U|W), не превосходит величины h()+ log M, которая является верхней оценкой количества информации, необходимого для точного установления переданного сообщения.

Правая часть неравенства Фано является функцией только от ; обозначим ее через ():

![]() (3.60)

(3.60)

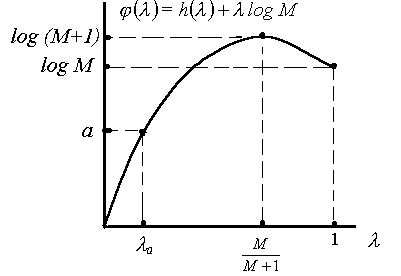

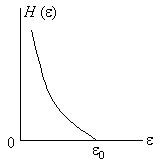

Заметим, что () 0, причем равенство имеет место только при = 0. Функция () является непрерывной на интервале [0, 1]. Беря производную по , можно убедиться в том, что она монотонно возрастает, если 0 < М/М + 1, убывает, если М/М+1<1, и имеет максимум в точке М/М + 1. График функции () изображен на рис. 3.2

Рис.3.2. График функции ()

Пусть а — некоторое положительное число, меньшее или равное log M, и a — наименьшее решение уравнения () = а. Нетрудно видеть, что следующие два неравенства

![]() (3.61)

(3.61)

равносильны, т. е, первое влечет второе и наоборот.

3.3. Общая обратная теорема кодирования для дискретных каналов

Теперь мы используем неравенство Фано для доказательства обратной теоремы кодирования для широкого класса дискретных каналов.

Рассмотрим некоторый дискретный канал. Пусть задано распределение вероятностей р(х) на входных последовательностях канала хХn. Это распределение совместно с условными вероятностями, посредством которых задается канал определяет ансамбль {XnYn, р(у|х) р(х)}. Пусть I(Хn; Yn) — средняя взаимная информация между последовательностями длины n на входе и выходе канала

![]() (3.62)

(3.62)

где

![]() (3.63)

(3.63)

Обозначим через С* максимальное значение средней взаимной информации в единицу времени между входом и выходом канала

![]() (3.64)

(3.64)

где верхняя грань берется по всем n и всевозможным распределениям р(х), хХn, на входных последовательностях длины n. Мы будем называть этот максимум информационной емкостью дискретного канала.

Точная

верхняя грань sup

f(х),

х

X,

где f

(х) — некоторая функция на X,

есть наименьшее число f0,

такое, что f0

f(х)

для каждого х

X.

Если в множестве X

существует такой элемент х0,

для которого f0

= f

(x0),

то говорят, что верхняя грань достигается

на X,

и пишут f

(x0)

= max

f

(х), хX.

Если X

— конечное множество, то верхняя грань

всегда достигается. В этом случае всегда

sup

f

(х) = max

f

(х). Если X

— бесконечное множество, то верхняя

грань может не достигаться ни на одном

элементе из X.

Например, если X

— множество натуральных чисел и f

(х) = 1-![]() ,

то sup

f

(х) = 1, но f

(х)

1 ни для одного элемента из X.

Заметим также, что верхняя грань

достигается, если X

— замкнутое множество и функция f

(x)

непрерывна.

,

то sup

f

(х) = 1, но f

(х)

1 ни для одного элемента из X.

Заметим также, что верхняя грань

достигается, если X

— замкнутое множество и функция f

(x)

непрерывна.

Т е о р е м а (обратная теорема кодирования для дискретных каналов). Пусть С* — информационная емкость дискретного канала и R = С* + где — произвольное положительное число. Тогда существует положительное число , зависящее от R, такое, что для всякого кода G (n, R)

(3.65)

Зафиксируем некоторое n и рассмотрим код G (n, R) с М = 2nR кодовыми словами { u1,…, uM}. Зададим распределение вероятностей на Хn следующим образом. Положим

![]() (3.66)

(3.66)

Пусть I(Xn; Yn) — средняя взаимная информация между входом и выходом канала, вычисленная для распределения вероятностей (3.4.5). Тогда I(Хn; Yn) = I(U; Yn), где U — ансамбль слов рассматриваемого кода, и из определения информационной емкости следует, что

nС* I (Xn; Yn) = I (U; Yn) (3.67)

Пусть W — ансамбль решений. Этот ансамбль можно рассматривать как результат отображения ансамбля Yn всех последовательностей на выходе канала в множество решений. Это отображение задается посредством набора решающих областей A1,..., AM. Каждая последовательность y Yn однозначно определяет решение w W по следующему правилу:

![]() (3.68)

(3.68)

Поскольку информация не возрастает в результате преобразований, то

I (U; Yn) I (U; W) (3.69)

Так как H (U | W) = Н (U) — I (U; W) и согласно (3.66) H(U)=logМ, то используя неравенство (3.67), получим, что

H (U | W)=log M – I (U;W) log M – nС* (3.70)

или

H (U | W) n(R – С*) = n (3.71)

Теперь можно воспользоваться неравенством Фано, которое, как было показано выше, выполняется для любого кода и для любого распределения вероятностей р (х) на кодовых словах и, в частности, для кода G (n, R) и распределения вероятностей (3.66). Обозначим через 0n наименьший корень уравнения

h ()+ log M= n (3.72)

Тогда из неравенства Фано и неравенства (3.4.71) следует, что средняя вероятность ошибки , для кода G(n,R) удовлетворяет неравенству 0n. Легко увидеть, что 0n стремится к /R при n. Из свойств функции () (см. предыдущий параграф) следует, что при М 1 число 0n остается положительным при всех п и 0n 01 > 0. Полагая 01 = , получим, что для любого кода G (п, R). Теорема доказана.

Цель дальнейшего изложения состоит в том, чтобы показать, что для широкого класса каналов информационная емкость и, пропускная способность совпадают. Для этого нужно доказать прямую теорему кодирования, в которой утверждается существование кода со скоростью R < С*, обеспечивающего сколь угодно малую заданную наперед вероятность ошибки. Путь, которому мы следуем, состоит в том, что вначале вычисляются величины информационных емкостей ряда достаточно простых каналов, а затем для каждого из рассмотренных каналов доказываются индивидуальные прямые теоремы кодирования. Доказательства для простых каналов обладают необходимой прозрачностью и позволяют наиболее выпукло показать фундаментальные идеи теории информации.

3.4. Информационные пределы избыточности. Принципы помехоустойчивого кодирования

Кодирование, с помощью которого можно устранять ошибки обусловленные наличием шума в канале называется помехоустойчивым. Коды способные исправлять и обнаруживать ошибки называется помехоустойчивым кодом. К сожалению основная теорема кодирования Шеннона не конструктивна, она не указывает способ построения конкретного оптимального помехоустойчивого кода, обеспечивающего предельное согласование сигнала с каналом, существование которого доказывает. Вместе с тем обосновав принципиальную возможность построения помехоустойчивых кодов, обеспечивающих идеальную передачу.

Если сообщения обладают внутренними корреляционными связями, т. е. если одно сообщение некоторым образом зависит от другого, как это обычно бывает при передаче текстов на естественных языках, то помехоустойчивость любого кода может быть повышена за счет статистических связей между сообщениями. Если эти связи слабые, или неизвестны, или их нельзя использовать для повышения помехоустойчивости, то в этом случае форма представления сообщения должна быть избыточной; в частности, число символов в коде сообщения увеличивают, а между кодовыми символами вводят искусственные корреляционные связи. Поэтому в некоторых случаях помехоустойчивые коды называют избыточными.

Введение избыточности в код позволяет помимо обнаружения и исправления ошибок повысить энергетическую эффективность линии связи, обузить частотный спектр передаваемого сигнала, сократить время вхождения в связь путем повышения помехозащищенности тракта синхронизации, улучшить корреляционные свойства ансамбля сигналов, простыми средствами реализовать разнесенный прием.

В каналах действуют искажения сигналов, шумы, помехи, которые в дискретном канале проявляются в виде перехода одного значения символа в другое - ложное (событие, состоящее в появлении ошибки) или неиспользуемое (событие, которое называют стиранием). В зависимости от характера ошибок различают дискретные каналы: симметричный (все ложные значения символов равновероятны), асимметричный (некоторые ложные значения символов обладают большей вероятностью), без памяти (искажение символа не зависит статистически от искажения другого выходного символа), с памятью (искажение символа выходной последовательности зависит статистически от искажения другого символа той же последовательности), со стираниями (наряду с ошибками имеют место стирания символов).

Любой канал связи с ограниченными полосой частот, временем передачи и динамическим диапазоном (значений амплитуд) обладает конечной пропускной способностью. Теоретически пропускная способность - это максимальное число переданных двоичных единиц (бит) в единицу времени при сколь угодно малой вероятности ошибок. Реально получаемое число передаваемых бит в единицу времени называют скоростью передачи. При неограниченно малой вероятности ошибок скорость передачи всегда меньше пропускной способности. В канале с ошибками максимальное значение скорости получают путем использования помехоустойчивого кодирования. Последнее требует введения избыточности в передаваемый сигнал: по времени, частоте или амплитуде. Если код согласован с каналом, т. е. код позволяет исправлять наиболее вероятные ошибки, введенная избыточность становится оправданной. Если код не согласован с каналом, ошибки могут быть не только не исправлены, но и размножены кодом. В этом случае применение помехоустойчивого кодирования принесет не пользу, а вред. Для согласования кода с каналом связи необходимо иметь максимальный объем сведений о возможных мешающих влияниях в каналах.

Рассмотрим основополагающие принципы, заложенные в основу построения помехоустойчивых кодов. Как следует из доказательства основной теоремы Шеннона, неприменимым свойством помехоустойчивых кодов является наличие избыточности. При этом необходима не просто любая избыточность, а специфическая, определяемая свойствами канала и правилом построения кода. И позволяющая с минимальными затратами повысить вероятность передачи. В ситуации, когда источник сообщений обладает собственной существенной избыточностью, которая в принципе тоже в определенной степени повышает достоверность передачи информации, но не так эффектно как это возможно. Поступают следующим образом: сначала с помощью эффективного кодирования до минимума уменьшают избыточность источника сообщений, а затем в процессе помехоустойчивого кодирования вносят в передаваемый сигнал избыточность, позволяющую простыми средствами поднять верность. Таким образом, эффективное кодирование может сочетаться с помехоустойчивым.

Помехоустойчивые коды можно подразделить на два больших класса блочные и непрерывные. В случае блочных кодов, при кодировании, каждому дискретному сообщению ставится в соответствие отдельный блок кодовых символов называемого кодовой комбинацией. Непрерывные коды образуют последовательность символов неразделяемых на кодовые комбинации.

Рассмотрим принцип построения помехоустойчивых блочных кодов. Избыточность, обуславливающая корректирующие свойства равномерного блочного кода, обычно вводится за счет выполнения неравенства

mn>M (3.73),

где m-основание кода, т.е. объем алфавита используемых кодовых символов, n-длина или количество разрядов кодовой комбинации, М-количество сообщений подлежащих кодированию. Выполнение этого неравенства означает, что для передачи знаков сообщения используют лишь часть М возможных кодовых комбинаций. Используемые кодовые комбинации называют разрешенными. Неиспользуемые mn - M комбинации являются запрещенными. На вход канала подаются только разрешенные комбинации. Если вследствие помех один или несколько символов приняты ошибочно, то на выходе канала появляется запрещенная комбинация, что и говорит о наличии ошибки. Для того, чтобы обеспечить выполнение (3.73) необходимо выбирать n > K , где К-минимальное целое, удовлетворяющее неравенству

mk M (3.74).

Число К обычно называют количеством информационных разрядов кодовой комбинации, поскольку именно столько разрядов должна содержать комбинация кода с основанием m, чтобы число разных кодовых комбинаций было не меньше числа сообщений М подлежащих передаче. R=n-K разрядов кодовой комбинации необходимых для передачи полезной информации называются проверочными. Количество их и определяет избыточность помехоустойчивого кода. При использовании помехоустойчивого кода возможно декодирование с обнаружением и исправлением ошибок. В первом случае на основе анализа принятой комбинации выясняется, является ли она разрешенной или запрещенной. После этого запрещенная комбинация либо отбрасывается, либо уточняется путем посылки запроса на повторение переданной информации. Во втором случае при приеме запрещенной комбинации определенным способом выявляются и исправляются содержащиеся в ней ошибки. Максимальные числа ошибок в кодовой комбинации q и S, которые могут быть обнаружены (q) или исправлены (S) с помощью данного кода называются соответственно обнаруживающей или исправляющей способностью кода. В значении q и S определяются величиной dmin минимальным кодовым расстоянием между ближайшими разрешенными комбинациями. Под кодовым расстоянием понимают количество неодинаковых разрядов в кодовых комбинациях. Величина dmin в помехоустойчивом коде зависит от соотношения n и К, т.е. от числа r проверочных разрядов кода.

Рассмотрим информационный подход позволяющий оценить необходимую минимальную избыточность, выраженную в количестве проверочных разрядов rmin блочного помехоустойчивого кода, длиной n с заданной исправляющей способностью S. Пусть имеется код с основанием m и с исправляющей способностью S. И используется декодирование с исправлением ошибок. На приеме при использовании такого кода возможно две ситуации: правильный прием сообщения и неправильный. Осуществление с вероятностью PH. Неправильный прием может произойти в том случае, когда из-за превышения числом ошибок пришедшей из канала кодовой комбинации значение S она может превратиться в одну из других разрешенных кодовых комбинаций. В свою очередь правильный прием осуществляется либо в том случае, когда в принимаемой комбинации отсутствуют ошибки (обозначим вероятность такого сообщения Р0), либо Nправ в случаях когда в принятой комбинации присутствуют ошибки которые могут быть исправлены рассмотренным кодом. Вероятности таких случаев обозначим через Pj (j=1 Nправ). Для решения поставленной задачи определим минимальное количество информации, которой может быть описана совокупность событий, включающая появление одной из конкретных ошибок и отсутствие ошибок или появление некорректных ошибок. Зная эту величину и максимальное количество информации, которое может содержать один проверочный символ кода можно определить минимальное число проверочных символов.

Количество информации необходимо для описания указанных событий

![]() (3.75)

(3.75)

(в случае отсутствия ошибки учтем включением нуля в предел суммирования). Максимальное количество информации, которое может содержать символ кода с основанием m равно log2 m. Следовательно, число проверочных разрядов в комбинации кода не может быть меньше, чем

![]() (3.76).

(3.76).

Определенную

таким образом величину rmin

называют информационным пределом

избыточности. Найдем значение rmin

для двоичного канала с независимыми

ошибками. В таком канале появление

предыдущей ошибки не влечет за собой

появление последующей. В этой ситуации

число R(i) ошибок кратности i в кодовой

комбинации длиной n равно числу сочетаний

![]() .

.

![]() (3.77)

(3.77)

Поскольку ошибки независимы вероятность P(i) возникновения в кодовой комбинации ошибки кратности i равна

Р(i) = Pi - (1-P)n-i (3.78),

где Р-вероятность ошибки в канале. Учитывая, что в данном случае Nпр=S выражение (3.75) можно записать в виде

![]() .

.

Вторым слагаемым можно пренебречь поскольку, описываемая им функция не используется в процессе исправления ошибок. Поэтому с учетом (3.77 и 3.78) имеем

![]() (3.79).

(3.79).

Рассмотрим

частный случай, когда возникновение

конкретной ошибки любой кратности и

отсутствие ошибок имеют равную

вероятность, т.е.

![]() ,

при любом i. Величину Р1

определим из условия нормировки

,

при любом i. Величину Р1

определим из условия нормировки

![]() (3.80),

(3.80),

отражающего тот факт, что вероятность появления ошибки какой-либо кратности, включения и нулевую равна единице. Из (3.80) имеем

следовательно,

![]() (3.81).

(3.81).

Поскольку код двоичной, то есть m=2, c учетом (3.76 и 3.81), имеем

![]() .

.

Найденное таким образом значение rmin совпадает с оценками полученными другим методами в частности с нижним пределом Хэмминга. Аналогичным образом могут быть найдены информационные пределы избыточности для других конфигураций ошибок в канале, например для пакетных ошибок, когда одиночные ошибки группируются в пакеты различной кратности. Полученные при этом результаты так же хорошо согласовывается с выводами полученными другими методами. Найденное таким образом значение rmin совпадает с оценками, полученными другими методами, в частности, с нижним пределом Хэмминга. Аналогичным образом могут быть найдены информационные пределы избыточности для других конфигураций ошибок в канале, например для пакетных ошибок, когда одиночные ошибки группируются в пакеты различной кратности. Получаемые при этом результаты также хорошо согласуются с выводами, полученными другими методами.

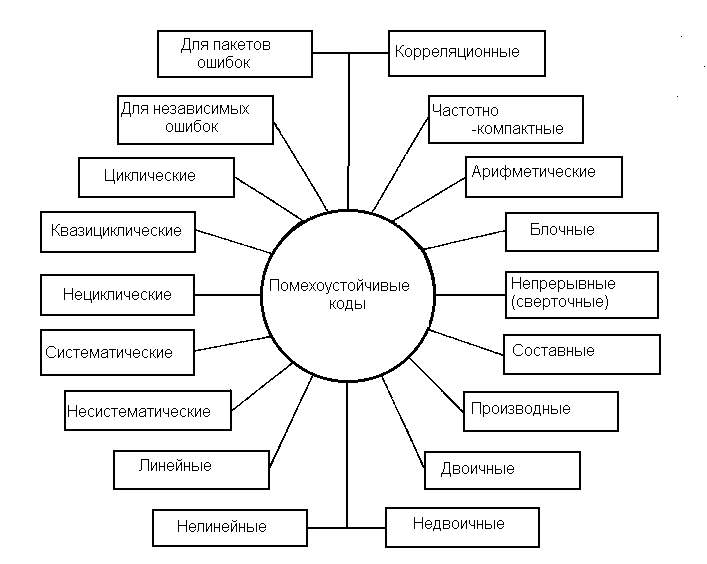

К настоящему времени разработано много различных помехоустойчивых кодов, отличающихся друг от друга основанием q, расстоянием d, избыточностью, структурой, функциональным назначением, энергетической эффективностью, корреляционными свойствами, алгоритмами кодирования и декодирования, формой частотного спектра. На рисунке, представленном выше, приведены типы кодов, различающиеся по особенностям структуры, функциональному назначению, физическим свойствам кода как сигнала.

Наиболее важный подкласс непрерывных кодов образуют сверточные коды, отличающиеся от других непрерывных кодов методом построения и более широкой областью применения.

В общем случае, чем длиннее код при фиксированной избыточности, тем больше расстояние и тем выше помехоустойчивость кода. Однако длинные коды сложно реализуются. Составные коды дают компромиссное решение задачи; из них основное значение имеют каскадные коды и коды произведения. Как правило, каскадный код состоит из двух ступеней (каскадов): внутренней и внешней. По линии связи сигналы передают внутренним кодом nвт, символьные слова которого являются символами внешнего кода длины nвш. Основание внешнего кода равно qkвт.

Коды произведения строят в виде матрицы, в которой строки суть слова одного кода, а столбцы - того же или другого кода.

При формировании каскадного кода входную информационную последовательность символов разбивают на блоки по kвт символов в каждом, каждый блок сопоставляют с информационным символом внешнего кода из алфавита, содержащего qkвт значений символов. Затем kвш информационных символов внешнего кода преобразуют в блоки из nвш символов внешнего кода и, наконец, блоки из kвт информационных символов внутреннего кода преобразуют в блоки из nвт символов внутреннего кода. Возможны различные варианты: внешний и внутренний коды - блочные, внешний блочный - внутренний сверточный, внешний сверточный - внутренний блочный, внешний и внутренний сверточные.

Один из наиболее распространенных методов формирования кода произведения заключается в последовательной записи по k1 символов входной информационной последовательности в k2 строк матрицы (например, в ячейки памяти ОЗУ), добавлении избыточных символов по n1-k1 в каждую строку и по n2-k2 в каждый столбец, после чего в последовательность символов кода считывают по строкам или столбцам из матрицы. Физическим аналогом кода произведения является, в частности, частотно-временной код, у которого строки располагаются вдоль оси времени, а столбцы - по оси частот.

Параметры составных кодов: каскадных - n=nвшnвт, k=kвшkвт, d=dвшdвт; произведения - n=n1n2, k=k1k2, d=d1d2.

Производные коды строят на основе некоторого исходного кода, к которому либо добавляют символы, увеличивая расстояние (расширенный код), либо сокращают часть информационных символов без изменения расстояния (укороченный код), либо выбрасывают (выкалывают) некоторые символы (выколотый, или перфорированный код). Код Хэмминга дает пример процедуры расширения, увеличивающей расстояние кода с 3 до 4. Необходимость в выкалывании возникает в результате построения на основе исходного кода другого, менее мощного, более короткого кода с тем же расстоянием.

При более широкой трактовке термина "производный код" к этому классу можно отнести все коды, полученные из исходного добавлением или исключением как символов, так и слов.

Формально деление кодов на двоичные и недвоичные носит искусственный характер; по аналогии следует выделять троичные, четверичные и другие коды большего основания. Оправдывается такое деление усложнением алгоритмов построения, кодирования и декодирования недвоичных кодов.

Рис.3.3.

Классификация помехоустойчивых кодов

Рис.3.3.

Классификация помехоустойчивых кодов

При прочих равных условиях желательно, чтобы информационные и избыточные символы располагались отдельно. В систематических кодах это условие выполняется.

В циклических кодах каждое слово содержит все свои циклические перестановки. Все n циклических перестановок (слова длины n) образуют цикл. В квазициклических кодах цикл образуется на числе символов n-1 или, реже, n-2. Циклические коды важны как с точки зрения математического описания, так и для построения и реализации кода.

Ошибки в каналах связи имеют самое различное распределение, однако, для выбора помехоустойчивого кода целесообразно разделить все возможные конфигурации ошибок на независимые (некоррелированные) и пакеты (коррелированные ошибки). На практике приходится учитывать качество интервалов между пакетами: они могут быть свободными от ошибок или же содержать случайные независимые ошибки.

Под корреляционными подразумевают коды, обладающие хорошими корреляционными свойствами, важными при передаче сигналов вхождения в связь, для повышения защищенности от некоторых видов помех, извлечения сигналов из интенсивных шумов, обеспечения многостанционного доступа, построения асинхронно-адресных систем связи. Корреляционные коды включают в себя пары противоположных сигналов с хорошей функцией автокорреляции (метод внутриимпульсной модуляции), импульсно-интервальные коды, имеющие на фиксированном интервале времени постоянное для всех слов кода число импульсов с неперекрывающимися (при любом взаимном сдвиге слов во времени) значениями интервалов между импульсами, ансамбли сигналов с хорошими взаимокорреляционными свойствами.

Особый класс образуют частотно-компактные коды, предназначенные для сосредоточения энергии сигнала в возможно более узкой полосе частот. Столь общая постановка задачи понимается в различных системах связи по-разному: в проводных линиях и линейных трактах, содержащих полосно-ограничивающие фильтры с крутыми фронтами, необходимо основную энергию сигналa "отодвинуть" от крайних частот к центру полосы пропускания целью уменьшения межсимвольных искажений; в сетях радиосвязи с жесткими ограничениями по электромагнитной совместимости радиосредств от кода требуется значительно (на десятки децибел) уменьшить уровень внеполосных излучений. Построение кодирование и декодирование частотно-компактных кодов существенно зависят от метода модуляции.

Арифметические коды служат для борьбы с ошибками при вы полнении арифметических операций в процессоре ЭВМ.

Коды можно разделить на линейные и нелинейные. Линейные коды образуют векторное пространство и обладают следующим важным свойством: два кодовых слова можно сложить, используя подходящее определение суммы, и получить третье кодовое слово. В случае обычных двоичных кодов эта операция является посимвольным сложением двух кодовых слов по модулю 2 (т. е. 1+1=0, 1+0=1, 0+0=0). Это свойство приводит к двум важным следствиям. Первое из них состоит в том, что линейность существенно упрощает процедуры кодирования и декодирования, позволяя выразить каждое кодовое слово в виде "линейной" комбинации небольшого числа выделенных кодовых слов, так называемых базисных векторов. Второе свойство состоит в том, что линейность существенно упрощает задачу вычисления параметров кода, поскольку расстояние между двумя кодовыми словами при этом эквивалентно расстоянию между кодовым словом, состоящим целиком из нулей, и некоторым другим кодовым словом. Таким образом, при вычислении параметров линейного кода достаточно рассмотреть, что происходит при передаче кодового слова, состоящего целиком из нулей. Вычисление параметров упрощается еще и потому, что расстояние Хемминга между данным кодовым словом и нулевым кодовым словом равно числу ненулевых элементов данного кодового слова. Это число часто называют весом Хемминга данного слова, и список, содержащий число кодовых слов каждого веса, можно использовать для вычисления характеристик кода с помощью аддитивной границы. Такой список называют спектром кода.

Линейные коды отличаются от нелинейных замкнутостью кодового множества относительно некоторого линейного оператора, например сложения или умножения слов кода, рассматриваемых как векторы пространства, состоящего из кодовых слов - векторов. Линейность кода упрощает его построение и реализацию. При большой длине практически могут быть использованы только линейные коды. Вместе с тем часто нелинейные коды обладают лучшими параметрами по сравнению с линейными. Для относительно коротких кодов сложность построения и реализации линейных и нелинейных кодов примерно одинакова.

Как линейные, так и нелинейные коды образуют обширные классы, содержащие много различных конкретных видов помехоустойчивых кодов. Среди линейных блочных наибольшее значение имеют коды с одной проверкой на четность, M-коды (симплексные), ортогональные, биортогональные, Хэмминга, Боуза-Чоудхури-Хоквингема, Голея, квадратично-вычетные (KB), Рида-Соломона. К нелинейным относят коды с контрольной суммой, инверсные, Нордстрома-Робинсона (HP), с постоянным весом, перестановочные с повторением и без повторения символов (полные коды ортогональных таблиц, проективных групп, групп Матье и других групп перестановок).

Почти все схемы кодирования, применяемые на практике, основаны на линейных кодах. Двойные линейные блоковые коды часто называют групповыми кодами, поскольку кодовые слова образуют математическую структуру, называемую группой. Линейные древовидные коды обычно называют сверточными кодами, поскольку операцию кодирования можно рассматривать как дискретную свертку входной последовательности с импульсным откликом кодера.

Наконец, коды можно разбить на коды, исправляющие случайные ошибки, и коды, исправляющие пакеты ошибок. В основном мы будем иметь дело с кодами, предназначенными для исправления случайных, или независимых, ошибок. Для исправления пакетов ошибок было создано много кодов, имеющих хорошие параметры. Однако при наличии пачек ошибок часто оказывается более выгодным использовать коды, исправляющие случайные ошибки, вместе с устройством перемежения восстановления. Такой подход включает в себя процедуру перемешивания порядка символов в закодированной последовательности перед передачей и восстановлением исходного порядка символов после приема с тем, чтобы рандомизировать ошибки, объединенные в пакеты.

3.5. Основные принципы помехоустойчивого кодирования

Кодирование с исправлением ошибок, по существу, представляет собой метод обработки сигналов, предназначенный для увеличения надежности передачи по цифровым каналам. Хотя различные схемы кодирования очень непохожи друг на друга и основаны на различных математических теориях, всем им присущи два общих свойства. Одно из них - использование избыточности. Закодированные цифровые сообщения всегда содержат дополнительные, или избыточные, символы. Эти символы используют для того, чтобы подчеркнуть индивидуальность каждого сообщения. Их всегда выбирают так, чтобы сделать маловероятной потерю сообщением его индивидуальности из-за искажения при воздействии помех достаточно большого числа символов. Второе свойство состоит в усреднении шума. Эффект усреднения достигается за счет того, что избыточные символы зависят от нескольких информационных символов. Для понимания процесса кодирования полезно рассмотреть каждое из этих свойств отдельно.

Рассмотрим вначале двоичный канал связи с помехами, приводящими к тому, что ошибки появляются независимо в каждом символе и средняя вероятность ошибки равна Р=0,01. Если требуется рассмотреть произвольный блок из 10 символов на выходе канала, то весьма трудно выявить символы, которые являются ошибочными. Вместе с тем если считать, что такой блок содержит не более трех ошибок, то мы будем неправы лишь два раза на миллион блоков. Кроме того, вероятность, что мы окажемся правы, возрастает с увеличением длины блока. При увеличении длины блока доля ошибочных символов в блоке стремится к средней частоте ошибок в канале, а также, что очень важно, доля блоков, число ошибок, в которых существенно отличается от этого среднего значения, становится очень малой. Простые вычисления помогают понять, насколько верным является это утверждение.

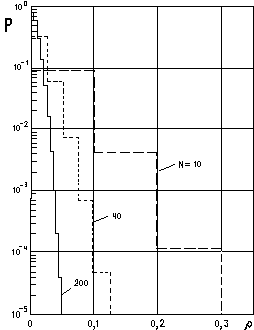

Рис.

3.4. Вероятность того, что доля ошибочных

символов e/N в блоке длиной N превышает

при вероятности Р

e=0,01

Рис.

3.4. Вероятность того, что доля ошибочных

символов e/N в блоке длиной N превышает

при вероятности Р

e=0,01

Рассмотрев, например, тот же канал, вычислим вероятность того, что доля ошибочных символов превышает значение , и построим график этой функции для нескольких значений длины блока.

Кривые на рис. 3.4 показывают, что при обработке символов блоками, а не одного за другим можно уменьшить общую частоту ошибок. При этом потребуется, чтобы существовала схема кодирования, нечувствительная к ошибкам в некоторой доле символов блока и не приводящая при этом к потере сообщением своей индивидуальности, т. е. не приводящая к ошибочному блоку. Из графиков на рис. 3.4 для различных длин блоков видно, какую именно долю ошибок нужно исправлять, чтобы получить заданную вероятность ошибки блока. Он показывает также, что при фиксированной вероятности ошибки блока доля ошибок, которые нужно исправлять, уменьшается при возрастании длины блока. Сказанное свидетельствует о резервах улучшения характеристик при усреднении шума и о том, что эти резервы возрастают при увеличении длины блока. Таким образом, длинные блоковые коды эффективнее коротких. После того как установлена целесообразность исправления ошибок в символах, возникает следующий логичный вопрос: как это сделать? Ключ лежит в избыточности. При исправлении ошибок в сообщении, представляемом последовательностью из n двоичных символов, очень важно учесть, чтобы не все 2n возможных последовательностей представляли сообщения. В самом деле, когда каждая из возможных принятых последовательностей n символов представляет некоторое сообщение, нет никаких оснований считать, что одна последовательность является более правильной, чем любая другая. Продолжая рассуждать таким же способом, можно ясно увидеть, что для исправления всех наборов из t или менее ошибок необходимо и достаточно, чтобы каждая последовательность, представляющая сообщение, отличалась от последовательности, представляющей любое другое сообщение, не менее чем в 2t+1 местах. Например, для исправления всех одиночных или всех двойных ошибок в символах нужно, чтобы каждые две последовательности, представляющие разные сообщения, отличались не менее чем в пяти символах. Каждая принятая последовательность, содержащая два ошибочных символа и, следовательно, отличающаяся от посланной последовательности ровно в двух местах, будет всегда отличаться от всех других последовательностей, представляющих сообщения, не менее чем в трех местах. Число позиций, в которых две последовательности отличаются друг от друга, будем называть расстоянием Хемминга d между этими двумя последовательностями. Наименьшее значение d для всех пар кодовых последовательностей называется кодовым расстоянием и обозначается dmin. Поскольку dmin всегда должно быть на единицу больше удвоенного числа исправляемых ошибок, можно написать

t = [(dmin- l) / 2], (3.82)

где [ ] обозначает целую часть. Параметр t указывает, что все комбинации из t или менее ошибок в любой принятой последовательности могут быть исправлены. Имеются модели каналов, в которых значение t может быть больше указанного в (3.82).

Рассмотрим код, состоящий из четырех кодовых слов 00000, 00111,11100 и 11011. Каждое кодовое слово используется для представления одного из четырех возможных сообщении. Поскольку код включает лишь небольшую долю всех 32 возможных последовательностей из пяти символов, мы можем выбрать кодовые слова таким образом, чтобы каждые два из них отличались друг от друга не менее чем в трех позициях. Таким образом, кодовое расстояние равно трем и код может исправлять одиночную ошибку в любой позиции. Чтобы провести процедуру декодирования при этом коде, каждой из 28 недопустимых последовательностей нужно поставить в соответствие ближайшую к ней допустимую последовательность. Этот процесс ведет к созданию таблицы декодирования, которая строится следующим образом. Вначале под каждым кодовым словом выписываем все возможные последовательности, отличающиеся от него в одной позиции. В результате получаем часть табл. 1.2, заключенную между штриховыми линиями. Заметим, что после построения этой части осталось 8 последовательностей. Каждая из этих последовательностей отличается от каждого кодового слова не менее чем в двух позициях. Однако в отличие от других последовательностей эти восемь последовательностей нельзя однозначно разместить в таблице. Например, последовательностью можно поместить либо в первый, либо в четвертый столбец. При использовании этой таблицы в процессе декодирования нужно найти столбец, в котором содержится принятая последовательность, и а качестве выходной последовательности декодера взять кодовое слово, находящееся в верхней строке этого столбца.

Таблица 2.

Таблица декодирования для кода с четырьмя словами

00000 10000 01000 00100 00010 00001 |

11100 01100 10100 11000 11110 11101 |

00111 10111 01111 00011 00101 00110 |

11011 01011 10011 11111 11001 11010 |

10001 10010 |

01101 01110 |

10110 10101 |

01010 01001 |

Причина, по которой таблица декодирования должна строиться именно таким образом, очень проста. Вероятность появления фиксированной комбинации из i ошибок равна Рte(1 -Рe)5-i . Заметим, что при Рe<1/2

(1 -Рe)5Pe(1 -Рe)4Рe2(1 -Рe)3...

Таким образом, появление фиксированной одиночной ошибки более вероятно, чем фиксированной комбинации двух ошибок, и т. д. Это значит, что декодер, который декодирует каждую принятую последовательность в ближайшее к ней по расстоянию Хемминга кодовое слово, выбирает в действительности то кодовое слово, вероятность передачи которого максимальна (в предположении, что все кодовые слова равновероятны). Декодер, реализующий это правило декодирования, является декодером максимального правдоподобия, и в указанных предположениях он минимизирует вероятность появления ошибки декодирования принятой последовательности. В этом смысле такой декодер является оптимальным. Это понятие очень важно, поскольку декодеры максимального правдоподобия часто используются для коротких кодов. Кроме того, параметры декодера максимального правдоподобия могут служить эталоном, с которым сравниваются параметры других, неоптимальных декодеров. Если декодирование ведется с помощью таблицы декодирования, то элементы таблицы можно расположить так, чтобы получить декодирование по максимуму правдоподобия. К сожалению, объем таблицы растет экспоненциально с ростом длины блока, так что использование таблицы декодирования для длинных кодов нецелесообразно. Однако таблица декодирования часто оказывается полезной для выяснения важных свойств блоковых кодов.

Множество кодовых слов в таблице декодирования является подмножеством (первой строкой таблицы декодирования) множества всех 2n последовательностей длиной n. В процессе построения таблицы декодирования множество всех последовательностей длиной n разбивается на непересекающиеся подмножества (столбцы таблицы декодирования). В случае когда код исправляет t ошибок, число Ne последовательностей длиной n в каждом подмножестве удовлетворяет неравенству

Ne 1+ n + Cn2 +...+ Cnt, (3.83)

где Cni - i-й биномиальный коэффициент.

Неравенство (3.83) следует непосредственно из того, что имеется ровно n различных последовательностей, отличающихся от данной последовательности в одной позиции, Cn2 последовательностей, отличающихся в двух позициях, и т. д. Как и в приведенном выше простом примере, после размещения всех последовательностей, отличающихся от кодовых в t или менее позициях, почти всегда остаются неразмещенные последовательности [отсюда неравенство в (3.83)]. Теперь можно связать избыточность кода c числом ошибок, которые им исправляются. Заметим сначала, что число всех возможных последовательностей равно 2n. Каждый столбец таблицы декодирования содержит Ne таких последовательностей, поэтому общее число кодовых слов должно удовлетворять неравенству

Ne 2n / (1+ n + Cn2 +...+ Cnt), (3.84)

Это неравенство называется границей Хемминга или границей сферической упаковки. Равенство в (3.84) достигается только для так называемых совершенных кодов. Эти коды исправляют все наборы из t или менее ошибок и не исправляют никаких других наборов. Число известных совершенных кодов очень невелико, так что равенство в (3.84) достигается в очень редких случаях.

Процесс кодирования состоит в том, что наборы k информационных символов отображаются в кодовые последовательности, состоящие из n символов. Любое такое отображение будем называть (n,k)-кодом, хотя обычно такое название применяется только к линейным кодам. Поскольку число последовательностей длиной k равно 2k, неравенство (3.84) можно переписать следующим образом:

2k 2n / (1+ n + Cn2 +...+ Cnt), (3.85)

Мера эффективности кода определяется отношением

R=k/n (3.86)

и называется скоростью кода. Доля избыточно передаваемых символов равна 1-R.

Отображение, возникающее при кодировании, можно задавать таблицей кодирования. Например, код с четырьмя кодовыми словами задается табл. 3.

Таблица 3.

Таблица поиска при декодировании

Входная последовательность |

Кодовая последовательность |

00 01 10 11 |

00100 01111 11011 10000 |

Часть кодовой последовательности, заключенная между штриховыми линиями, совпадает с входной последовательностью. Поэтому каждой кодовой последовательности, легко однозначно сопоставить входную последовательность. Не все блоковые коды обладают этим свойством. Те, которые им обладают, называются систематическими кодами. Понятие избыточных символов для систематических кодов становится абсолютно ясным, и избыточными символами в табл. 2 являются символы на позициях 1, 4 и 5. Коды, не обладающие указанным свойством, называются несистематическими.

Существует много хороших конструктивных методов кодирования, позволяющих исправлять кратные ошибки и приводящих к заметному уменьшению частоты появления ошибочных символов. Эти коды легко строятся и с помощью современных полупроводниковых устройств относительно просто декодируются. Например, существует блоковый код длиной 40, содержащий 50% избыточных символов и позволяющий исправлять четыре случайные ошибки. На рис. 3.4 показано, что при Рe=0,01 этот код имеет вероятность ошибки блока, меньшую 10-4. Если этого недостаточно, разработчик увеличивает избыточность, чтобы исправлять большее число ошибок, или переходит к кодам с большей длиной блока и получает выигрыш за счет большего усреднения. В каждом случае нужно принимать во внимание возникающие дополнительные затраты. Однако обе указанные возможности допустимы и могут представлять практически приемлемые альтернативы.

Форма кривых, изображенных на рис. 3.4, позволяет предположить, что если имеется схема, исправляющая фиксированную долю t/n ошибочных символов в блоке (в нашем случае t/n незначительно превышает 0,01), то, выбирая длину блока достаточно большой, можно сделать долю ошибок сколь угодно малой. К сожалению, это оказывается очень трудной задачей. Большинство конструктивных процедур может обеспечить постоянное отношение t/n лишь при возрастающей доле избыточных символов (другими словами, R0 при n). Таким образом, потеря эффективности возникает из-за того, что доля полезных сообщений становится очень малой при большой длине блока.

4. Непрерывные ансамбли и источники

4.1. Непрерывные ансамбли и источники. Обобщение понятия количества информации

Все предыдущее рассмотрение относилось только к случаю дискретных ансамблей и соответственно к случаю, когда дискретные ансамбли являлись моделями источников сообщений. Класс дискретных источников не исчерпывает всего многообразия источников, встречающихся на практике. Например, источник, порождающий речевые сообщения, не является дискретным, ибо в каждый момент времени выходным сигналом источника является некоторое действительное число — величина звукового давления.

В этом параграфе мы введем непрерывные ансамбли сообщений, которые могут служить моделями источников непрерывных сообщений. Начнем с наиболее простого случая, а именно, ансамбля, соответствующего непрерывной случайной величине (с. в.).

Пусть на числовой оси задано некоторое распределение вероятностей, определяющее с. в. X, и F (х) — функция распределения этой с. в., т. е. такая функция, что ее значение в точке x; равно вероятности появления с. в. X в интервале (—, х]:

F(x) Pr (— < X х)

Если существует функция f (х) такая, что для всех х на числовой оси

![]() (4.1)

(4.1)

то она называется функцией плотности вероятностей (ф. п. в.) (или просто плотностью вероятностей) с. в. X. Для любого интервала (а, b] числовой оси вероятность появления с. в. в этом интервале определяется по формуле

Pr

(a,

b)

= F

(b)

- F

(a)

=

![]() (4.2)

(4.2)

Очевидно, функция F (х) неотрицательна и монотонно не убывает, причем F(—)=0, F()=1. Функция плотности вероятностей неотрицательна и ее интеграл в пределах от — до + равен единице. Последнее условие обычно называют условием нормировки. В зависимости от свойств распределений вероятностей может быть нескольких типов функции F(х). Если эта функция ступенчатая и имеет конечное число ступенек, то распределение называется дискретным и соответствует дискретной случайной величине. В этом случае функции плотности в обычном смысле не существует. Если для F(х) в каждой точке может быть определена производная, то распределение соответствует непрерывной случайной величине. Производная функции распределения в этом случае есть ф. п. в. Указанные два случая — наиболее часто встречающиеся в приложениях. Смешанный тип распределения — это такой, когда F(х) непрерывна (справа) в каждой точке, за исключением конечного числа точек, где функция распределения имеет ступеньки. Наконец, последний тип распределения имеет место, когда F(х) непрерывна в каждой точке (справа), но ф. п. в. всюду или на каком-либо интервале не существует.

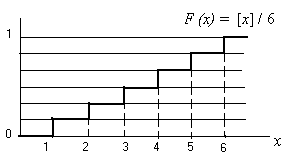

Пример 4.1. Рассмотрим дискретную случайную величину — число очков при бросании кости. Возможные значения для этой с. в. суть 1, 2, ..., 6. Очевидно, F (х) = [x] / 6, где [x] — целая часть х, F (х) = О при х < 1 и F(х) = 1 при х 6 (см. рис. 3.2).

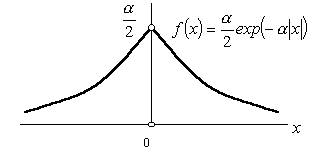

Пример 4.2. Рассмотрим непрерывную с. в., которая задается функцией распределения

Рис. 4.1. Функция распре-деления числа очков при бросании игральной кости

Рис. 4.2. Функция плотности вероятности непрерывной с.в. примера 4.2.

![]() (4.3)

(4.3)

Нетрудно найти ф. п. в. этого распределения (см. рис. 4.2)

![]() (4.4)

(4.4)

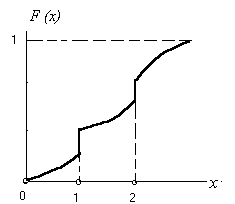

Пример 4.3. На рис. 4.3 показана функция распределения смешанного типа. Все значения, кроме х = 1 и х = 2, имеют нулевые вероятности (но не плотности v вероятностей), как для любой непрерывной с. в. Значения х = 1, х = 2 появляются с ненулевыми вероятностями, как в дискретном случае.

Рис. 4.3. Функция распределения смешанного типа

Непрерывным ансамблем, задаваемым ф.п.в. f (х), будем называть пару {X, f (х)}, где X — числовая ось и распределение вероятностей на X задается ф. п. в. f(х).

Согласно этому определению мы отождествляем понятия непрерывного ансамбля и непрерывной действительной случайной величины, имеющей ф. п. в. f(х). Система совместно заданных непрерывных ансамблей вводится таким же образом, как и в случае дискретных ансамблей. Пусть X и Y — числовые оси и XY (произведение множеств X и Y) — действительная плоскость, т. е. множество всех упорядоченных пар (x, у), где х X и у Y. Пусть F(х, у) — совместная функция распределения на множестве XY, Функции распределения на множествах X и Y при этом определяются из соотношений

F1 (х) = F (х, ), F2 (у) = F(, у) (4.5)

соответственно.

Пусть распределения вероятностей на X, Y и XY задаются ф. п. в. f1 (х), f2 (у) и f (х, у), причем f (х, у) определяется соотношением

![]() (4.6)

(4.6)

а

![]() (4.7)

(4.7)

В этом случае будем говорить, что {XY, f (х, у)} есть система двух совместно заданных непрерывных ансамблей {X , f l (х)} и {Y, f 2 (y)}

Всякий раз, как совместно заданы два непрерывных ансамбля, определено семейство различных условных непрерывных ансамблей. Так, если фиксировано сообщение у Y, для которого f2(у) 0, то на множестве X определена условная ф. п. в.

![]() (4.8)

(4.8)

и условный непрерывный ансамбль {X, f (х | у)}. Аналогичным образом определяется условный непрерывный ансамбль {Y, f (y | x)}.

Система более двух непрерывных ансамблей вводится в точности так же, как система двух ансамблей. Пусть Хl ... Хп — произведение п множеств, каждое из которых является числовой прямой. Элементы множества Х1 ... Хп представляют собой действительные последовательности (х(1), ..., х(п)) длины п, х(1) X1, ..., х(п) Хп. Будем считать, что распределение вероятностей на этом множестве задается n-мерной ф. п. в. f(х(1), ..., х(п)). Другими словами, для любого набора интервалов 1, ..., n вероятность попадания последовательности (x(1), ..., х(п)) в n-мерную область, задаваемую указанными интервалами, определяется n-кратным интегралом

![]()

Пусть

(4.9)

(4.9)

Соотношения (4.9) задают безусловные ф. п. в. на множествах Х1, ..., Хп соответственно. В этом случае будем говорить, что {X1 ... Хп, f(х(1) ..., х(n))} есть система п совместно заданных непрерывных ансамблей {Х1, f1 (x)} ,..., {Хп , fn (х)}. Если

f ( х(1) ,..., х (n)) = f1 ( x (1)) . . . fn ( x (n)) (4.10)

для любых x(1) Х1 ,..., х(п) Хп, то непрерывные ансамбли Х1, ..., Хп называются статистически независимыми.

Заметим, что при задании системы п непрерывных ансамблей фактически оказываются заданными всевозможные системы по тп непрерывных ансамблей.

Пусть {Х, f1(х)} — непрерывный ансамбль и (х) — произвольная действительная функция на X, отображающая числовую прямую X в себя. Всякая такая функция порождает некоторый ансамбль и называется случайной величиной на ансамбле {X, /! (х)\. Если ф (х) — ступенчатая функция с конечным числом значений, то она порождает дискретный ансамбль {Y, р (у)}, где Y = {y1, ..., yn} — множество значений функции (х) и

![]()

Если (х) — непрерывная

функция, то она порождает непрерывный

ансамбль {Y,

![]() },

где Y — числовая ось, а ф.

п. в.

определяется из уравнения

},

где Y — числовая ось, а ф.

п. в.

определяется из уравнения

Для каждой с. в. определены ее числовые характеристики, например, математическое ожидание и дисперсия. Все числовые характеристики непрерывных случайных величин определяются так же, как и в случае дискретных случайных величин с заменой вероятностей на ф. п. в. и сумм на интегралы. Очевидно, что для непрерывных с. в. справедливо неравенство Чебышева и закон больших чисел.

Рассмотрим теперь совместное задание непрерывного ансамбля X и дискретного ансамбля Yд. Для этого удобно рассматривать дискретный ансамбль как результат дискретизации некоторого непрерывного ансамбля Y. Пусть {XY, f (х, у)} — пара совместно заданных непрерывных ансамблей {X, fl (х)} и {Y, f2 (y)}. Пусть B1, ..., BN — разбиение множества Y на непересекающиеся подмножества. Введем в рассмотрение дискретное множество Yд={yl, …, yN} и будем говорить, что происходит событие yj, если точка непрерывного ансамбля {Y, f2 (у)} попадает в множество Вj. Для каждого у вероятность р2 (yj) этого события определяется формулой

![]() (4.11)

(4.11)

Переход от непрерывного ансамбля {Y, f2 (у)} к дискретному называется дискретизацией. Очевидно, что любой дискретный ансамбль можно себе представлять как результат дискретизации некоторого непрерывного.

Так же, как и в дискретном случае, разбиение Y на подмножества задает семейство условных плотностей вероятностей на множестве X

![]() (4.12)

(4.12)

Отсюда и из (4.7) следует, что

![]() (4.13)

(4.13)

С другой стороны, на дискретном множестве Yд определены условные вероятности

(4.14)

(4.14)