- •Основы теории интеллектуальных систем

- •Нечеткие знания

- •Применение нечетких систем

- •Материальная база ии. Обзор суперкомпьютеров

- •1. Психофизиологический аспект:

- •Денотаты и гештальты

- •Треугольник Фреге

- •Наследование

- •Сети из знаков

- •Фреймы и семантические сети

- •Протофреймы и экзофреймы

- •Знаки-фреймы

- •Базовые процедуры знака-фрейма

- •Сети из знаков-фреймов

- •Операции на сетях из знаков-фреймов

- •Логические системы

- •1) Непротиворечивости, 2) независимости и 3) полноты.

- •Искусственные нейронные сети (инс)

- •Устойчивость к шумам входных данных

- •Адаптация к изменениям

- •Отказоустойчивость

- •Сверхвысокое быстродействие

- •Ответ инс всегда приблизительный

- •Невозможно многошаговое принятие решений

- •Неспособность решать вычислительные задачи

- •1. Единичная ступенчатая функция

- •2. Сигмоидальная функция

- •3. Гиперболический тангенс

- •Прогнозы развития ии Искусственный разум появится в мире через 20 лет

Основы теории интеллектуальных систем

Краткая история искусственного интеллекта

Предыстория

Идея создания искусственного подобия человека для решения сложных задач и моделирования человеческого разума витала в воздухе еще в древнейшие времена. Так, в древнем Египте была создана «оживающая» механическая статуя бога Амона. У Гомера в Илиаде бог Гефест ковал человекоподобные существа-автоматы. B литературе эта идея обыгрывалась многократно: от Галатеи Пигмалиона до Буратино папы Карло. Однако родоначальником искусственного интеллекта считается средневековый испанский философ, математик и поэт Раймонд Луллий, который еще в XIII веке попытaлся создать механическую машину для решения рaзличных задач, на основе разработанной им всеобщей классификации понятий.

B XVIII векe Лейбниц и Дeкарт независимо друг от друга продолжили эту идею, предложив универсальные языки классификации всех наук. Эти работы можно считать первыми теоретическими работами в области искусственного интеллекта.

Окончательное рождение искусственного интеллекта как научного направления произошло только после создания ЭВМ в 40-x годах ХХ века. B это же время Норберт Винер создал свои основополагающие работы по новой науке — кибернетике.

Норберт Винер (англ. Norbert Wiener; 26 ноября 1894, Колумбия, штат Миссури, США — 18 марта 1964, Стокгольм, Швеция) — американский учёный, выдающийся математик и философ, основоположник кибернетики и теории искусственного интеллекта.

Термин «искусственный интеллект»

Термин «искусственный интеллект» (ИИ) (англ. AI — artificial intelligence) был предложен в 1956 г. на семинаре c аналогичным названием в Дартмутском колледже (США). Семинар был посвящен разработке методов решения логических, а не вычислительных задач. B английском языке данное словосочетание не имеет той слегка фантастической антропоморфной окраски, которую оно приобрело в довольно неудачном русском переводе. Слово intelligence означает «умение рассуждать разумно», a вовсе не «интеллект», для которого есть термин intellесt.

Вскоре после признания искусственного интеллекта отдельной областью науки и произошло разделение его на два направления: нейрокибернетика и «кибернетика черного ящика». Эти направления развиваются практически независимо, существенно различаясь как в методологии, так и в технологии. И только в настоящее время стали заметны тенденции к объединению этих частей вновь в единое целое.

Зарождение нейрокибернетики

Основную идею этого направления можно сформулировать следующим образом:

Единственный объект, способный мыcлить, — это человеческий мозг. Поэтому любое «мыслящее» устройство должно каким-то образом воспроизводить структуру мозга.

Таким образом, нейрокибернетика ориентирована на программно-аппаратное моделирование структур, подобных структуре мозга. Физиологами давно установлено, что основой человеческого мозга является большое количество (до 1021) связанных между собой и взаимодействующих нервных клеток — нейронов. Поэтому усилия нейрокибepнетики были сосредоточены на создании элементов, аналогичных нейpонам, и их объединении в функционирующие системы. Эти системы принято называть нейронными сетями, или нейросетями.

Первые нейросети были созданы Ф.Розенблаттом и У.Mак-Каллоком в 1956-1965 гг.) Это были попытки создать системы, моделирующие человеческий глаз и его взаимодействие с мозгом. Устройство, созданное ими тогда, получило название персептрона (perceptron – от перцепция, т.е. восприятие). Оно умело различать буквы алфавита, но было чувствительно к их написанию. Например, буквы A, A и А для этого устройства были тремя разными знаками. Постепенно в 70-80 годах ХХ века количество работ по этому направлению искусственного интеллекта стало снижаться. Слишком неутешительны были первые результаты. Авторы объясняли неудачи малой памятью и низким быстродействием существующих в то время компьютеров.

Фрэнк Розенблатт (англ. Frank Rosenblatt, 1928—1971) — известный американский учёный в области психологии, нейрофизиологии и искусственного интеллекта.

Уоррен Мак-Каллок (англ. Warren Sturgis McCulloch; 16 ноября 1898, Оранж, Нью-Джерси, США — 24 сентября 1969, Кембридж, Массачусетс, США) — американский нейропсихолог, нейрофизиолог, теоретик искусственных нейронных сетей и один из отцов кибернетики.

Кибернетика «черного ящика»

Основной принцип этого подхода, противоположного нейрокибернетике, формулируется так:

Не имеет значения, как устроено «мыслящее» устройство. Главное, чтобы на заданные входные воздействия оно реагировало так же, как человеческий мозг.

Сторонники этого направления считали, что человек не должен слепо следовать природе в своих научных и технологических поисках. Так, например, очевиден успех колеса, которого не существует в природе, или самолета, не машущего крыльями, подражая птице. К тому же пограничные науки о человеке не смогли внести существенного теоретического вклада в хотя бы приблизительное объяснение того, как протекают интеллектуальные процессы у человека, как устроена память, как человек познает окружающий мир.

Это направление искусственного интеллекта было ориентировано на поиски алгоритмов решения интеллектуальных задач на существующих моделях компьютеров. Существенный вклад внесли в становление новой науки внесли ее «пионеры»: Джон Маккарти (автор первого языка программирования для задач ИИ – ЛИСПа), Марвин Минский (автор идеи фрейма и фреймовой модели представления знаний), Ньюэлл, Саймон, Шоу, Хант и др.

В 1956-1963 гг. велись интенсивные поиски моделей и алгоритмов человеческого мышления и разработка первых программ на их основе. Представители существующих гуманитарных наук – философы, психологи, лингвисты – ни тогда, ни сейчас не в состоянии были предложить таких алгоритмов. Тогда кибернетики начали создавать собственные модели. Так последовательно были созданы и опробованы различные походы.

Джон Маккарти (John McCarthy) родился в 1927 году в Бостоне, Массачусетс (Boston, Massachusetts, U.S.).

Юный Джон рано проявил свои успехи в математике – так, еще будучи школьником, он самостоятельно осваивал математику по университетским учебникам. Позже, став студентом Калифорнийского технологического института (California Institute of Technology, Caltech), Маккарти сумел перепрыгнуть сразу два первых года обучения. Степень бакалавра в математике он получил в Калифорнии, а степень доктора Маккарти заработал уже в Принстоне (Princeton University) в 1951 году. Позже Маккарти поработал в качестве профессора в таких уважаемых учебных заведениях, как Дартмутский колледж (Dartmouth) и знаменитый Массачусетский Технологический Институт (MIT), работал он и в Принстоне. Однако дольше всего Джон Маккарти трудился в Стэнфорде (Stanford University), начав преподавать там в 1962 году. В Стэнфорде ученый оставался до 2000-го, до самого ухода на пенсию. Кстати, именно в свой стэнфордский период жизни Маккарти решил первые проблемы в разделе математики, называемом семантикой вычислений.

Одним из главных достижений Маккарти является изобретение языка программирования Lisp в 1958 году. Описание его появилось через пару лет в журнале «Communications of the ACM» Этот высокоуровневый язык применяется и сегодня (Lisp - 'LISt Processing' - обработка списков; программы и данные в этом языке представляются системами линейных списков символов).

Подходы к решению интеллектуальных задач

Модель лабиринтного поиска. Задача представляется как пространство состояний в форме графа, и в этом графе проводится поиск оптимального пути от входных данных к результирующим. Эта идея успешно применялась в программах для различных игр: «15», шашек, шахмат и др. К сожалению, для решения практических задач она не нашла широкого применения.

Эвристическое программирование. Эвристикой называется теоретически не обоснованное правило, которое позволяет сократить количество переборов в пространстве поиска. Эвристическое программирование – это разработка стратегии действий на основе известных, заранее заданных эвристик.

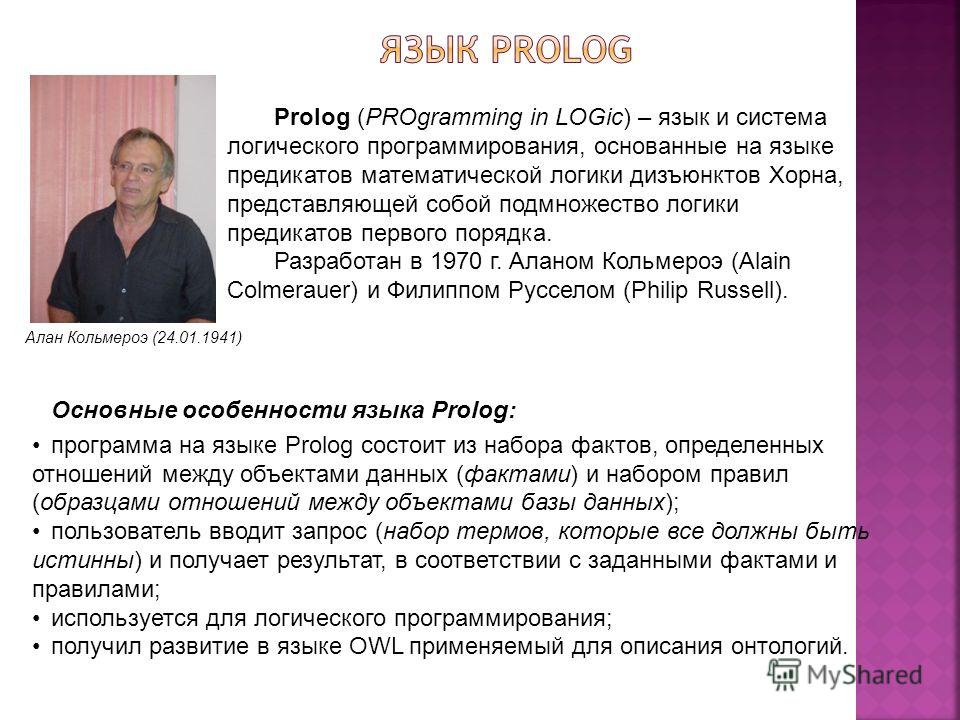

Методы математической логики. Англичанин Джон Алан Робинсон в 1965 году разработал метод резолюций, позволяющий автоматически доказывать теоремы при наличии набора исходных аксиом. На основе метода резолюций француз Алан Кольмероэ в Марсельском университете в 1970 году создал язык логического программирования ПРОЛОГ. Большинство реальных задач не сводится к набору аксиом, поэтому логические модели при всех преимуществах имеют существенные ограничения по классам решаемых задач.

Джон Алан Робинсон (англ. John Alan Robinson; 1930, Йоркшир, Великобритания – 5 августа 2016, Портленд, Камберленд, Мэн, США) — британский философ и логик, внёс важный вклад в становление логического программирования.

Экспертные системы. В 1970-х годах в США появились первые коммерческие системы, основанные на знаниях, или экспертные системы (ЭС) – MYCIN для медицины и DENDRAL для химии. Стал применяться новый подход к решению задач ИИ – представление знаний.

С середины 1980-х годов повсеместно происходит коммерциализация ИИ. Растут ежегодные капиталовложения, создаются промышленные ЭС. Растет интерес к самообучающимся системам. ИИ становится одной из наиболее перспективных и престижных областей информатики (computer science).

Рис. 1. Основные направления развития ИИ

Представление знаний и вывод на знаниях

Данные – это отдельные факты, характеризующие объекты, процессы и явления предметной области, а также их свойства.

При обработке на ЭВМ данные трансформируются, условно проходя следующие этапы:

D1 — данные как результат измерений и наблюдений;

D2 — данные на материальных носителях информации (таблицы , протоколы, справочники);

D3 — модели (структуры) данных в виде диаграмм, графиков, функций;

D4 — данные в компьютере на языке описания данных;

D5 — базы данных на машинных носителях информации.

Знания основаны на данных, полученных эмпирическим путем. Они представляют собой результат мыслительной деятельности человека, направленной на обобщение его опыта, полученного в результате практической деятельности.

Знания – это закономерности предметной области (принципы, связи, законы), полученные в результате практической деятельности и профессионального опыта, позволяющие специалистам ставить и решать задачи в этой области.

Различие между понятиями «данные» и «знания»

Термин «данные» распространен весьма широко. Он используется при решении задач на компьютерах, в системах передачи информации, в статистике и во многих других случаях. Его всеобщность такова, что никто не пытался давать точного определения понятия «данные». Этого и не требовалось до тех пор, пока не появился новый термин «знания», в какой-то мере противопоставляемый термину «данные». Такая ситуация требует уточнения того, что понимается под данными и знаниями.

Развитие ИИ, приведшее к появлению термина «знания», сделало необходимым введение отличия нового понятия от понятия «данные». Поскольку сам термин «знания» теснейшим образом связан с идеями семиотики, то для нас весьма интересно сформулировать эти различия.

Данные могут быть результатом произведенных измерений и представляют собой массивы чисел, из которых невозможно получить новые данные, отличные от исходных данных.

Знания же позволяют получать (генерировать) новые знания, первоначально не заложенные в базу.

Данные сами по себе не поддаются интерпретации (объяснению), хотя можно выявить тенденцию их изменения.

Знания допускают интерпретацию (трактовку) смысла, заложенного в них (семантики и прагматики).

При обработке на ЭВМ знания трансформируются аналогично данным.

1. Z1– знания в памяти человека как результат мышления;

2. Z2 – материальные носители знаний (учебники, методические пособия);

3. Z3 – поле знаний – условное описание основных объектов предметной области, их атрибутов и закономерностей, их связывающих;

4. Z4 – модели знаний, т.е. знания, описанные на языках представления знаний (продукционные языки, семантические сети, фреймы);

5. Z5 – база знаний на машинных носителях информации.

Часто используется такое определение знаний.

Знания – это хорошо структурированные данные, или данные о данных, или метаданные.

Существует множество способов определять понятия. Один из широко применяемых способов основан на идее интенсионала.

Интенсионал понятия — это определение его через соотнесение с понятием более высокого уровня абстракции с указанием специфических свойств. Интенсионалы формулируют знания об объектах.

Другой способ определяет понятие через соотнесение с понятиями более низкого уровня абстракции или перечисление фактов, относящихся к определяемому объекту. Это есть определение через данные, или экстенсионал понятия.

Пример 1. Понятие «персональный компьютер». Его интенсионал: «Персональный компьютер – это дружественная ЭВМ, которую можно поставить на стол и купить менее чем за $1000 – 2000».

Экстенсионал этого понятия: «Персональный компьютер — это Мac, IBМ РС, Sinkler...»

Поверхностные и глубинные знания

Для хранения данных используются базы данных (для них характерны 6ольшой объем и относительно небольшая удельная стоимость информации), для хранения знаний – базы знаний (небольшого объема, но исключительно дорогие информационные массивы). База знаний – основа любой интеллектуальной системы.

Знания могут быть классифицированы по следующим категориям:

Поверхностные – знания о видимых взаимосвязях между отдельными со6ытиями и фактами в предметной области.

Глубинные – абстракции, аналогии, схемы, отображающие структуру и природу процессов, протекающих в предметной области. Эти знания объясняют явления и могут использоваться для прогнозирования поведения объектов.

Пример 2.

Поверхностные знания: «Если нажать на кнопку звонка, раздастся звук. Если болит голова, то следует принять аспирин».

Глубинные знания: Принципиальная электрическая схема звонка и проводки. Знания физиологов и врачей высокой квалификации o причинах, видах головных болей и методах их лечения.

Процедурные и декларативные знания

Современные экспертные системы работают в основном c поверхностными знаниями. Это связано с тем, что на данный момент нет универсальных методик, позволяющих выявлять глубинные структуры знаний и работать с ними.

Кроме того, в учебниках по ИИ знания традиционно делят на процедурные и декларативные. Исторически первичными были процедурные знания, то есть знания, «растворенные» в алгоритмах. Они управляли данными. Для их изменения требовалось изменять программы. Однако c развитием искусственного интеллекта приоритет данных постепенно изменялся, и все большая часть знаний сосредоточивалась в структурах данных (таблицы, списки, абстрактные типы данных), то есть увеличивалась роль декларативных знаний.

Сегодня знания приобрели чисто декларативную форму, то есть знаниями считаются предложения, записанные на языках представления знаний, приближенных к естественному и понятных неспециалистам.

Модели представления знаний

Существуют десятки моделей (или языков) представления знаний для различных предметных областей. Большинство из них может быть сведено к следующим классам:

продукционные модели;

семантические сети;

фреймы;

формальные логические модели.

Продукционная модель

Продукционная модель или модель, основанная на правилах, позволяет представить знания в виде предложений типа «Если (условие), то (действие)».

Под «условием» (антецедентом) понимается некоторое предложение-образец, по которому осуществляется поиск в базе знаний, а под «действием» (консеквентом) — действия, выполняемые при успешном исходе поиска (они могут быть промежуточными, выступающими далее как условия и терминальными или целевыми, завершающими работу системы).

Чаще всего вывод на такой базе знаний бывает прямой (от данных к поиску цели) или обратный (от цели для ее подтверждения — к данным). Данные — это исходные факты, хранящиеся в базе фактов, на основании которых запускается машина вывода или интерпретатор правил, перебирающий правила из продукционной базы знаний.

Продукционная модель чаще всего применяется в промышленных экспертных системах. Она привлекает разработчиков своей наглядностью, высокой модульностью, легкостью внесения дополнений и изменений и простотой механизма логического вывода.

Имеется большое число программных средств, реализующих продукционный подход, (язык OPS 5; «оболочки» или «пустые» ЭС — EXSYS Professional, Карра, ЭКСПЕРТ; ЭКО, инструментальные системы ПИЭС [Хорошевский, 1993] и СПЭИC [Ковригин, Перфильев, 1988] и др.), a также промышленных ЭС на его основе (например, ЭС, созданных средствами G2 [Попов, 1996]) и др.

Семантические сети

Термин семантическая означает «смысловая», а сама семантика – это наука, устанавливающая отношения между символами и объектами, которые они обозначают, то есть наука, определяющая смысл знаков.

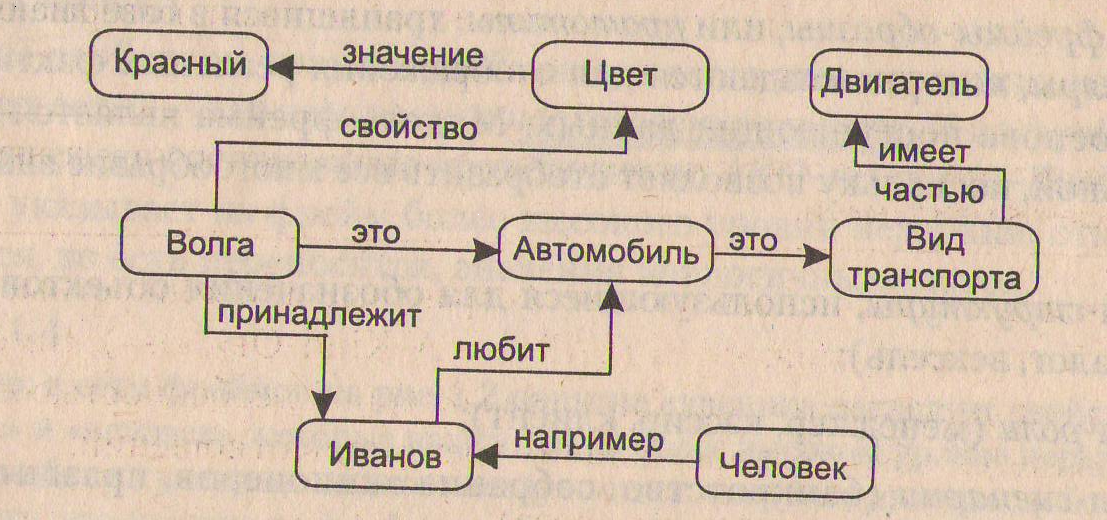

Семантическая сеть – это ориентированный граф, вершины которого – понятия, a дуги – отношения между ними.

В качестве понятий обычно выступают абстрактные или конкретные объекты, а отношения – это связи типа: «это» («АКО — А-Kind-Of», "is"), «имеет частью» "has part"), «принадлежит», «любит». Характерной особенностью семантических сетей. сетей является обязательное наличие трех типов отношений:

класс – элемент класса (цветок – роза);

свойство – значение (цвет – желтый);

пример элемента класса (роза – чайная).

Можно предложить несколько классификаций семантических сетей, связанных с типами отношений между понятиями.

По количеству типов отношений:

однородные (c единственным типом отношений);

неоднородные (с различными типами отношений).

По типам отношений:

бинарные (в которых отношения связывают два объекта);

N-арные (в которых есть специальные отношения, связывающие более двух понятий).

Пример семантической сети

Пример 3.

На рис. 2 изображена семантическая сеть. B качестве вершин тут выступают понятия «человек», «Иванов», «Волга», «автомобиль», «вид транспорта» и «двигатель».

Рис. 2. Пример семантической сети

Для реализации семантических сетей существуют специальные сетевые языки, например, NET, язык реализации систем SIMER+MIR и др. Широко известны экспертные системы, использующие семантические сети в качестве языка представления знаний – PROSPECTOR, CASNET, TORUS.

Фреймы

Термин фрейм (от английского frame, что означает «каркас» или «рамка», «кадр») предложен Мaрвином Минским, одним из пионеров ИИ, в 70-е годы ХХ в. для обозначения структуры знаний для восприятия пространственных сцен. Эта модель, как и семантическая сеть, имеет глубокое психологическое обоснование.

Фрейм – это абстрактный образ для представления некоего стереотипа восприятия. В психологии и философии известно понятие абстрактного образа. Например, произнесение вслух слова «комната» порождает y слушающих образ комнаты: «жилое помещение с четырьмя стенами, полом, потолком, окнами и дверью, площадью 6–20 м2». Из этого описания ничего нельзя убрать (например, убрав окна, мы получим уже чулан, а не комнату), но в нем есть «дырки» или «слоты» – это незаполненные значения некоторых атрибутов – например, количество окон, цвет стен, высота потолка, покрытие пола и др.

В теории фреймов такой образ комнаты называется фреймом комнаты. Фреймом также называется и формализованная модель для отображения образа.

Различают фреймы-образцы, или прототипы, хранящиеся в базе знаний, и фреймы-экземпляры, которые создаются для отображения реальных фактических ситуаций на основе поступающих данных. Модель фрейма является достаточно универсальной, поскольку позволяет отобразить все многообразие знаний о мире через:

фреймы-структуры, использующиеся для обозначения объектов и понятий (заем, залог, вексель);

фреймы-роли (менеджер, кассир, клиент);

фреймы-сценарии (банкротство, собрание акционеров, празднование именин);

фреймы-ситуации (тревога, авария, рабочий режим устройства) и др.

Основным преимуществом фреймов как модели представления знаний является то, что она отражает концептуальную основу организации памяти человека, а также ее гибкость и наглядность.

Специальные языки представления знаний в сетях фреймов FRL (Frame Representation Language), KRL (Knowledge Representation Language), фреймовая «оболочка» Kappa и другие программные средства позволяют эффективно строить промышленные ЭС. Известны такие фрейм-ориентированные ЭС как ANALYST, TRISTAN, ALTERID, МОДИС и др.

Традиционно структура фрейма может быть представлена как список свойств:

( ИМЯ ФРЕЙМА:

( имя 1-го слота: значение 1-го слота),

(имя 2-гo слота: значение 2-го слота),

………………………………………………

(имя N-го слота: значение N-го слота)).

Ту же запись можно представить в виде таблицы, дополнив ее двумя столбцами:

Таблица 1

Имя фрейма |

|||

Имя слота |

Значение слота |

Способ получения значения |

Присоединенная процедура |

|

|

|

|

B таблице дополнительные столбцы предназначены для описания способа получения слотом его значения и возможного присоединения к тому или иному слоту специальных процедур, что допускается в теории фреймов. B качестве значений слота может выступать имя другого фрейма, так образуются сети фреймов. Существует несколько способов получения слотом значений во фрейме-экземпляре:

по умолчанию от фрейма-образца (Default-значение);

через наследование свойств от фрейма, указанного в слоте АКО;

по формуле, указанной в слоте;

через присоединенную процедуру;

явно из диалога с пользователем;

из базы данных.

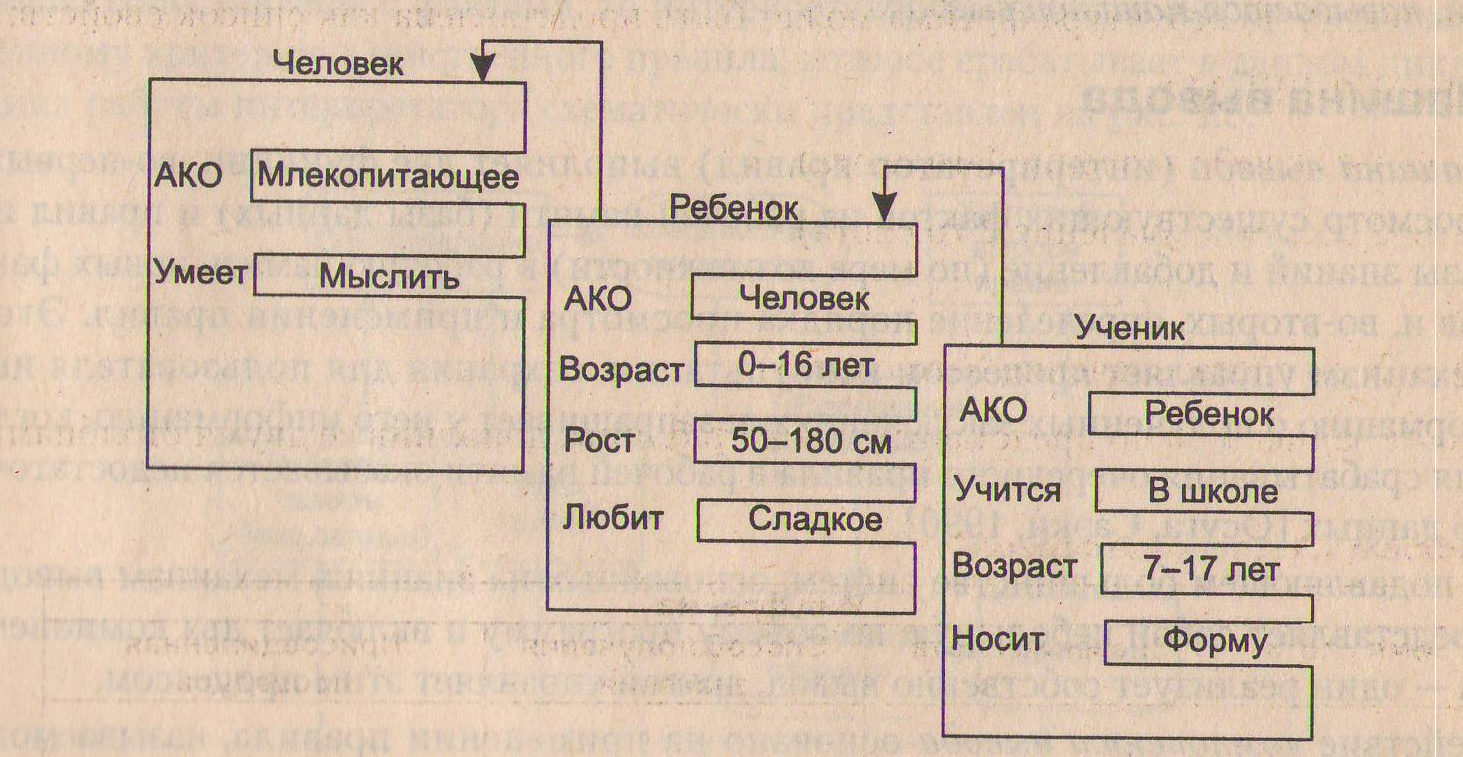

Важнейшим свойством теории фреймов является заимствование из теории семантических сетей – так называемое наследование свойств. И во фреймах, и в семантических сетях наследование происходит по АКО-связям (А-Kind-Оf = это). Слот АКО указывает на фрейм более высокого уровня иерархии, откуда неявно наследуются, то есть переносятся, значения аналогичных слотов.

Пример сети фреймов

Пример 4.

Например, в сети фреймов на рис. 3 понятие «ученик» наследует свойства фреймов «ребенок» и «человек», которые находятся на более высоком уровне иерархии. Так на вопрос «любят ли ученики сладкое» следует ответ «да», так как этим свойством обладают все дети, что указано во фрейме «ребенок». Наследование свойств может быть частичным, так как возраст для учеников не наследуется из фрейма «ребенок», поскольку указан явно в своем собственном фрейме.

Рис. 3. Пример сети фреймов

Формальные логические модели

Традиционно в представлении знаний выделяют формальные логические модели, основанные на классическом исчислении предикатов 1-го порядка, когда предметная область или задача описывается в виде набора аксиом.

Исчисление предикатов 1-го порядка в промышленных экспертных системах практически не используется. Эта логическая модель применима в основном в исследовательских «игрушечных» системах, так как предъявляет очень высокие требования и ограничения к предметной области.

В промышленных же экспертных системах используются различные ее модификации и расширения.

Формальные аксиоматизированные системы будут рассмотрены более подробно ниже (стр. 52).

Вывод на знаниях

Несмотря на все недостатки, наибольшее распространение получила продукционная модель представления знаний. При использовании продукционной модели база знаний состоит из набора правил. Программа, управляющая перебором правил, называется машиной вывода.

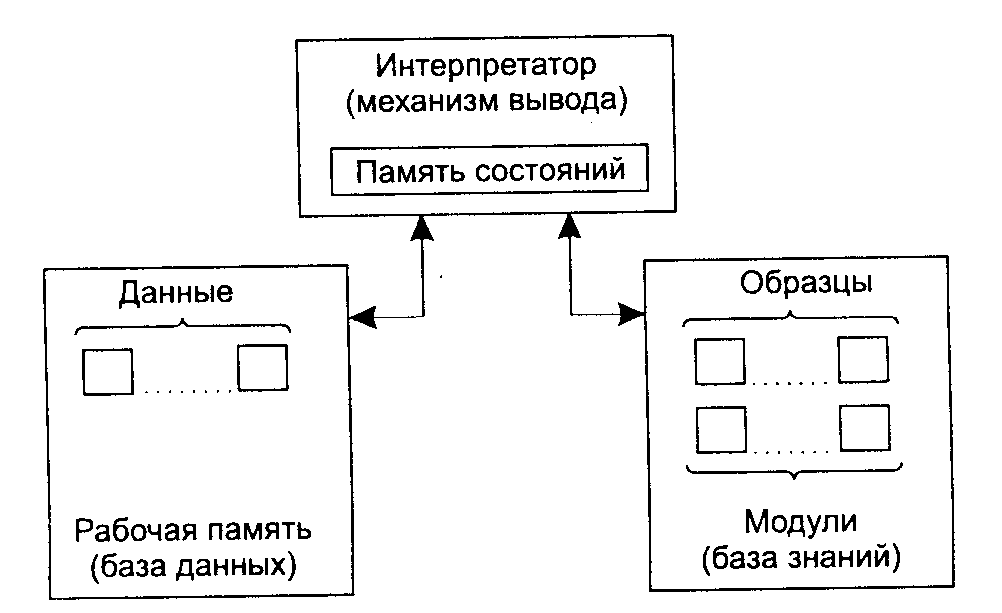

Машина вывода

Машина вывода (интерпретатор правил) выполняет две функции: во-первых, просмотр существующих фактов из рабочей памяти (базы данных) и правил из базы знаний и добавление (по мере возможности) в рабочую память новых фактов и, во-вторых, определение порядка просмотра и применения правил. Этот механизм управляет процессом консультации, сохраняя для пользователя информацию о полученных заключениях, и запрашивает у него информацию, когда для срабатывания очередного правила в рабочей памяти оказывается недостаточно данных.

В подавляющем большинстве систем, основанных на знаниях, механизм вывода представляет собой небольшую по объему программу и включает две компоненты: 1) одна компонента реализует собственно вывод, 2) другая компонента управляет этим процессом.

Действие компоненты вывода основано на применении правила modus ponens:

Если известно, что истинно утверждение А и существует правило вида «ЕСЛИ А, ТО В», тогда утверждение В также истинно.

Правила срабатывают, когда находятся факты, удовлетворяющие их левой части: если истинна посылка, то должно быть истинно и заключение.

Компонента вывода должен функционировать даже при недостатке информации. Полученное решение может и не быть точным, однако система не должна останавливаться из-за того, что отсутствует какая-либо часть входной информации.

Управляющая компонента механизма вывода

Управляющая компонента определяет порядок применения правил и выполняет четыре функции.

Сопоставление – образец правила сопоставляется с имеющимися фактами.

Выбор – если в конкретной ситуации может быть применено сразу несколько правил, то из них выбирается одно, наиболее подходящее по заданному критерию (разрешение конфликта).

Срабатывание – если образец правила при сопоставлении совпал с какими-либо фактами из рабочей памяти, то правило срабатывает.

Действие – рабочая память подвергается изменению путем добавления в нее заключения сработавшего правила. Если в правой части правила содержится указание на какое-либо действие, то оно выполняется (как, например, в системах обеспечения безопасности информации).

Интерпретатор продукций

Интерпретатор продукций работает циклически. В каждом цикле он просматривает все правила, чтобы выявить те, посылки которых совпадают с известными на данный момент фактами из рабочей памяти. После выбора правило срабатывает, его заключение заносится в рабочую память, и затем цикл повторяется сначала.

В одном цикле может сработать только одно правило. Если несколько правил успешно сопоставлены с фактами, то интерпретатор производит выбор по определенному критерию единственного правила, которое срабатывает в данном цикле. Цикл работы интерпретатора схематически представлен на рис. 4.

Рис. 4. Цикл работы интерпретатора

Информация из рабочей памяти последовательно сопоставляется с посылками правил для выявления успешного сопоставления. Совокупность отобранных правил составляет так называемое конфликтное множество.

Для разрешения конфликта интерпретатор имеет критерий, с помощью которого он выбирает единственное правило, после чего оно срабатывает.

Это выражается в занесении фактов, образующих заключение правила, в рабочую память или в изменении критерия выбора конфликтующих правил. Если же в заключение правила входит название какого-нибудь действия, то оно выполняется.

Схема работы интерпретатора

Работа машины вывода зависит только от состояния рабочей памяти и от состава базы знаний. На практике обычно учитывается история работы, то есть поведение, механизма вывода в предшествующих циклах. Информация о поведении механизма вывода запоминается в памяти состояний (рис. 5). Обычно память состояний содержит протокол системы.

Рис. 5. Схема работы интерпретатора

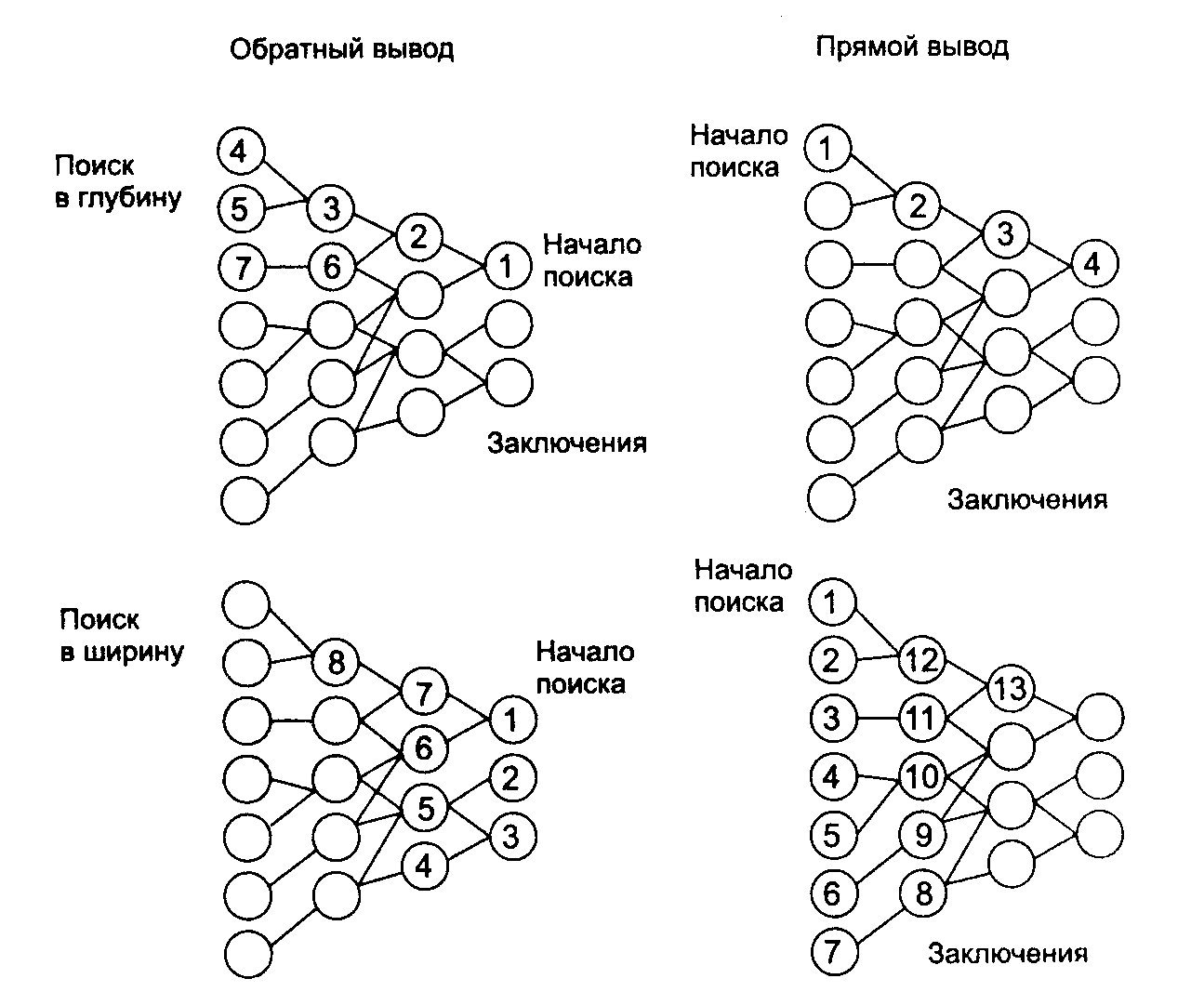

Стратегии управления выводом

От выбранного метода поиска, то есть стратегии вывода, будет зависеть порядок применения и срабатывания правил. Процедура выбора сводится к определению направления поиска и способа его осуществления. Процедуры, реализующие поиск, обычно «зашиты» в механизм вывода, поэтому в большинстве систем инженеры знаний не имеют к ним доступа и, следовательно, не могут в них ничего изменять по своему желанию.

При разработке стратегии управления выводом важно определить два вопроса:

1. Какую точку в пространстве состояний принять в качестве исходной? От выбора этой точки зависит и метод осуществления поиска – в прямом или обратном направлении.

2. Какими методами можно повысить эффективность поиска решения? Эти методы определяются выбранной стратегией перебора – в глубину, в ширину, по подзадачам или иначе.

Прямой и обратный вывод

Обратный поиск применяется в тех случаях, когда цели известны и их сравнительно немного. При обратном порядке вывода вначале выдвигается некоторая гипотеза, а затем механизм вывода как бы возвращается назад, переходя к фактам, пытаясь найти те, которые подтверждают гипотезу (рис. 6, левая часть). Если она оказалась правильной, то выбирается следующая гипотеза, детализирующая первую и являющаяся по отношению к ней подцелью. Далее отыскиваются факты, подтверждающие истинность подчиненной гипотезы.

Вывод такого типа называется управляемым целями, или управляемым консеквентами.

Рис. 6. Стратегии вывода

Прямой вывод часто называют выводом, управляемым данными, или выводом, управляемым антецедентами.

B системах с прямым выводом по известным фактам отыскивается заключение, которое из этих фактов следует (рис. 5, правая часть). Если такое заключение удается найти, то оно заносится в рабочую память.

Существуют системы, в которых вывод основывается на сочетании упомянутых выше методов – обратного и ограниченного прямого. Такой комбинированный метод называется циклическим.

Примеры вывода

Имеется фрагмент базы знаний из двух правил:

П1. Если «отдых – летом» и «человек – активный», то «ехать в горы».

П2. Если «любит солнце», то «отдых летом».

Предположим, в систему поступили факты – «человек – активный» и «любит солнце».

ПРЯМОЙ ВЫВОД – исходя из фактических данных, получить рекомендацию.

1-й проход.

Шаг 1. Пробуем П1, не работает (не хватает данных «отдых – летом»).

Шаг 2. Пробуем П2, работает, в базу поступает факт «отдых – летом».

2-й проход.

Шаг 3. Пробуем П1, работает, активизируется цель «ехать в горы», которая и выступает как совет, который дает ЭС.

ОБРАТНЫЙ ВЫВОД – подтвердить выбранную цель при помощи имеющихся правил и данных.

1-й проход.

Шаг 1. Цель – «ехать в горы»: пробуем П1 – данных «отдых – летом» нет, они становятся новой целью и ищется правило, где цель в левой части.

Шаг 2. Цель «отдых – летом»: правило П2 подтверждает цель и активирует ее.

2-й проход.

Шаг 3. Пробуем П1, подтверждается искомая цель.

Методы поиска в глубину и ширину

B системах, база знаний которых насчитывает сотни правил, желательным является использование стратегии управления выводом, позволяющей минимизировать время поиска решения и тем самым повысить эффективность вывода. К числу таких стратегий относятся: поиск в глубину, поиск в ширину, разбиение на подзадачи и альфа-бета алгоритм.

При поиске в глубину в качестве очередной подцели выбирается та, которая соответствует следующему, более детальному уровню описания задачи. Например, диагностирующая система, сделав на основе известных симптомов предположение о наличии определенного заболевания, будет продолжать запрашивать уточняющие признаки и симптомы этой болезни до тех пор, пока полностью не опровергнет выдвинутую гипотезу.

При поиске в ширину, напротив, система вначале проанализирует все симптомы, находящиеся на одном уровне пространства состояний, даже если они относятся к разным заболеваниям, и лишь затем перейдет к симптомам следующего уровня детальности.

Разбиение на подзадачи – подразумевает выделение подзадач, решение которых рассматривается как достижение промежуточных целей на пути к конечной цели. Примером, подтверждающим эффективность разбиения на подзадачи, является поиск неисправностей в компьютере – сначала выявляется отказавшая подсистема (питание, память и т. д.), что значительно сужает пространство поиска. Если удается правильно понять сущность задачи и оптимально разбить ее на систему иерархически связанных целей-подцелей, то можно добиться того, что путь к ее решению в пространстве поиска будет минимален.

Альфа-бета алгоритм позволяет уменьшить пространство состояний путем удаления ветвей, неперспективных для успешного поиска. Поэтому просматриваются только те вершины, в которые можно попасть в результате следующего шага, после чего неперспективные направления исключаются. Альфа-бета алгоритм нашел широкое применение в основном в системах, ориентированных на различные игры, например в шахматных программах.