Классификация основных алгоритмов обучения нейронных сетей:

1) Обучение с учителем (supervised learning) - наиболее распространённый случай. Если при обучении классификатора используется эталонное (ожидаемое) значение выходного сигнала нейрона, то такой механизм обучения называется обучением с учителем — результат обучения предопределен заранее благодаря заданным обучающим эталонным значениям. Каждый прецедент представляет собой пару "объект, ответ". Требуется найти функциональную зависимость ответов от описаний объектов и построить алгоритм, принимающий на входе описание объекта и выдающий на выходе ответ. Функционал качества обычно определяется как средняя ошибка ответов, выданных алгоритмом, по всем объектам выборки:

а) Метод коррекции ошибки;

б) Правило Розенблатта (дельта-правило):

Метод обучения перцептрона по принципу градиентного спуска по поверхности ошибки. Дельта-правило развилось из первого и второго правил Хебба. Его дальнейшее развитие привело к созданию метода обратного распространения ошибки. :

Формула:

![]() , где

, где

![]() -

эталонное значение выходного сигнала

нейрона;

-

эталонное значение выходного сигнала

нейрона;

![]() -

коэффициент

скорости обучения ,

-

коэффициент

скорости обучения ,

![]() ;

;

![]() и

и

![]() -

номера соответственно текущей и следующей

итераций;

-

номера соответственно текущей и следующей

итераций;

![]() -

номер

входа.

-

номер

входа.

(Подробный алгоритм обучения по правилу Розенблатта описан в решении Задания 2.2);

в) Метод обратного распространения ошибки:

Это

итеративный градиентный алгоритм,

который используется с целью минимизации

ошибки работы многослойного перцептрона

и получения желаемого выхода. Основная

идея этого метода состоит в распространении

сигналов ошибки от выходов сети к её

входам, в направлении, обратном прямому

распространению сигналов в обычном

режиме работы. Алгоритм обратного

распространения ошибки определяет

стратегию подбора весов многослойной

сети с применением градиентных методов

оптимизации. Его необходимым условием

выступает дифференцируемость используемых

функций активации нейронов сети. Этот

алгоритм использует градиентный метод

наискорейшего спуска для минимизации

среднеквадратической ошибки сети

(квадратичной суммы разностей между

фактическими и ожидаемыми значениями

выходных сигналов), вычисляемой по

формуле:

![]() ;

;

г) "Машина" опорных векторов (SVM - Support Vector Machine):

Использует линейное разделение объектов в пространстве признаков с помощью гиперплоскости. Метод применяется для решения задачи бинарной классификации. Основная идея метода опорных векторов — перевод исходных векторов в пространство более высокой размерности и поиск разделяющей гиперплоскости с максимальным зазором в этом пространстве. Две параллельных гиперплоскости строятся по обеим сторонам гиперплоскости, разделяющей наши классы. Разделяющей гиперплоскостью будет гиперплоскость, максимизирующая расстояние до двух параллельных гиперплоскостей. Алгоритм работает в предположении, что чем больше разница или расстояние между этими параллельными гиперплоскостями, тем меньше будет средняя ошибка классификатора. Основной проблемой метода является выбор оптимальной гиперплоскости, которая позволяет разделить классы с максимальной точностью. Для этого разделяющая гиперплоскость должна быть выбрана таким образом, чтобы расстояние между ближайшими точками, расположенными по разные стороны от нее, было бы максимальным. Данное расстояние называется зазором, а сами точки – оперными векторами. Тогда разделяющая гиперплоскость должна быть выбрана таким образом, чтобы максимизировать зазор, что обеспечит более уверенное разделение классов;

2) Обучение без учителя (unsupervised learning) - для каждого прецедента задается только "ситуация", требуется сгруппировать объекты в кластеры, используя данные о попарном сходстве объектов, и/или понизить размерность данных; в этом случае ответы не задаются, и требуется искать зависимости между объектами. Задачу можно сформулировать следующим образом: системе одновременно или последовательно предъявляются объекты без каких-либо указаний об их принадлежности к образам. Входное устройство системы отображает множество объектов и, используя некоторое заложенное в нее заранее свойство разделимости образов, производит самостоятельную классификацию этих объектов. После такого процесса самообучения система должна приобрести способность к распознаванию не только уже знакомых объектов (объектов из обучающей последовательности), но и тех, которые ранее не предъявлялись.:

а) Альфа-система подкрепления;

б) Гамма-система подкрепления;

в) Метод ближайших соседей (Пример работы метода приведен в Задании 2.1 и Задании 2.2);

3) Обучение с подкреплением (reinforcement learning) - для каждого прецедента имеется пара "ситуация, принятое решение". Роль объектов играют пары «ситуация, принятое решение», ответами являются значения функционала качества, характеризующего правильность принятых решений (реакцию среды). Как и в задачах прогнозирования, здесь существенную роль играет фактор времени. Примеры прикладных задач: формирование инвестиционных стратегий, автоматическое управление технологическими процессами, самообучение роботов, и т.д.:

а) Генетический алгоритм;

4) Активное обучение (active learning) - отличается тем, что обучаемый алгоритм имеет возможность самостоятельно назначать следующую исследуемую ситуацию, на которой станет известен верный ответ;

5) Обучение с частичным привлечением учителя (semi-supervised learning) занимает промежуточное положение между обучением с учителем и без учителя. Каждый прецедент представляет собой пару "объект, ответ", но ответы известны только на части прецедентов. Пример прикладной задачи - автоматическая рубрикация большого количества текстов при условии, что некоторые из них уже отнесены к каким-то рубрикам. Т.е. для части прецедентов задается пара "ситуация, требуемое решение", а для части - только "ситуация";

6) Трансдуктивное обучение (transduction) - обучение с частичным привлечением учителя, когда прогноз предполагается делать только для прецедентов из тестовой выборки;

7) Многозадачное обучение (multi-task learning) - одновременное обучение группе взаимосвязанных задач, для каждой из которых задаются свои пары "ситуация, требуемое решение". Набор взаимосвязанных или схожих задач обучения решается одновременно, с помощью различных алгоритмов обучения, имеющих схожее внутренне представление. Информация о сходстве задач между собой позволяет более эффективно совершенствовать алгоритм обучения и повышать качество решения основной задачи;

8) Многовариантное обучение (multi-instant learning) - обучение, когда прецеденты могут быть объединены в группы, в каждой из которых для всех прецедентов имеется "ситуация", но только для одного из них (причем, неизвестно какого) имеется пара "ситуация, требуемое решение".

Задание 2

2.1.

Задано

три образа (вектора информативных

признаков):

![]() ,

,

![]() и

и

![]() .

Каждый образ представлен вектором из

двух информативных признаков

.

Каждый образ представлен вектором из

двух информативных признаков

![]() ,

,![]() .

.

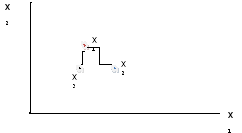

Р ис.

1

ис.

1

На Рис.1 показан пример распределения образов в пространстве признаков.

Образы

![]() ,

,

![]() и

и

![]() (координаты

векторов) необходимо задать произвольно

(в диапазоне значений 0 - 10) и занести в

таблицу.

(координаты

векторов) необходимо задать произвольно

(в диапазоне значений 0 - 10) и занести в

таблицу.

Определить

к какому образу (![]() или

или

![]() )

"ближе" образ

)

"ближе" образ

![]() ,

используя метрики:

,

используя метрики:

а) Евклидово расстояние;

б) Направляющие косинусы;

в) Расстояние Танимото.