- •На магистерскую выпускную квалификационную работу

- •Р еферат

- •С одержание

- •Введение

- •1 Характеристика технологического процесса

- •1.1 Анализ готовой продукции лкм

- •1.1.1 Характеристика пф-115

- •1.1.2 Область применения

- •1.1.3 Классификация лакокрасочных материалов

- •1.1.4 Нормативная документация

- •1.1.5 Сертификация

- •1.2 Описание технологического процесса

- •1.2.1 Стадии технологического процесса

- •1.2.2 Подготовка сырья

- •1.2.3 Изготовление пигментной суспензии в дисольвере

- •1.2.4 Диспергирование пигментной суспензии в бисерном измельчителе

- •1.2.5 Диспергирование колеровочных пигментных паст

- •1.2.6 Составление эмали, постановка «на тип»

- •1.2.7 Слив эмали

- •2 Описание технологической схемы производства

- •2.1 Описание технологической схемы производства эмали

- •2.2 Описание технологической схемы ужс

- •2.3 Потребность в основных видах сырья

- •3 Производственный контроль качества

- •3.1 Порядок проверки качества лака

- •3.2 Контроль качества при составлении эмали

- •3.3 Контроль качества эмалей акриловых

- •4. Разработка новой продукции

- •4.1 Порядок выполнения и управления процессом

- •4.2 Разработка новых видов продукции

- •4.3 Принятие решения об изготовлении промышленной партии

- •4.4 Изготовление промышленной партии. Утверждение рецептур

- •4.5 Порядок введения в производство рецептур и их изменения

- •5 Автоматизация технологического процесса

- •5.1 Производственный корпус №1

- •5.2 Производственный корпус №2

- •5.3 Участок приема и отпуска жидкого сырья

- •6 Моделирование процесса получения эмали с помощью инс

- •6.1 Искусственные нейронные сети

- •6.1.2 Нейрон и его модели

- •6.1.3 Искусственный нейрон

- •6.2 Архитектура сетей

- •6.2.1 Однослойные сети прямого распространения

- •6.2.2 Многослойные сети прямого распространения

- •6.2.3 Рекуррентные сети

- •6.3 Представление знаний

- •6.4 Процессы обучения

- •6.4.1 Парадигмы обучения

- •6.4.2 Практики обучения

- •Заключение Список использованных источников

- •Приложение

6.4.2 Практики обучения

Обучение Хебба:

Алгоритм обучения Хебба назван так в честь нейрофизиолога, который в нейробиологическом контексте предложил следующее правило модификации синаптических весов:

Если аксон клетки А находится на достаточно близком расстоянии от клетки В и постоянно или периодически участвует в ее возбуждении, наблюдается процесс метаболических изменений в одном или обоих нейронах, выражающийся в том, что эффективность нейрона А как одного из возбудителей нейрона В возрастает.

В контексте искусственных нейронных сетей данное правило может быть переформулировано в виде двух утверждений:

если два нейрона, связанные синаптической связью возбуждаются одновременно (синхронно), то прочность этой связи (соответствующий синаптический вес) возрастает;

если два нейрона по обе стороны синапса возбуждаются асинхронно, такой синапс ослабевает (синаптический вес уменьшается).

Можно сформулировать следующие свойства синапса Хебба:

Зависимость от времени. Изменение синаптического веса зависит от точного времени возникновения предсинаптического и постсинаптического сигналов.

Локальность. На изменение синаптического веса оказывают воздействие сигналы, находящиеся в пространственно-временной близости.

Интерактивность. Изменение синаптического веса определяется сигналами на обоих его концах.

Корреляция. Механизм изменения синаптического веса определяется наличием корреляции между предсинаптическим и постсинаптическим сигналом.

Математические модели обучения Хебба

Рассмотрим синапс с синаптическим весом , который соединяет выходной сигнал некоторого нейрона kjwjyj с соответствующим входом нейрона . Выходной сигнал является kjy jkjw xj-ой компонентой вектора входного сигнала для нейрона . kk)k))>)

Таким образом, модификация веса нейрона , будет определяться парой предсинаптического и постсинаптического сигналов kjw(jyx,. Изменение синаптического веса в момент времени n будет определяться соотношением:

(),(()(nxnyFnwjkkj=Δ .

Это соотношение может быть записано в различных видах, каждый из которых все равно остается математической моделью алгоритма обучения Хебба.

Гипотеза Хебба. Является простейшей формой обучения Хебба. В соответствии с гипотезой Хебба выражение для модификации веса в момент времени записывается в виде: kjwn

)()()(nxnynwjkkjη=Δ,

где η – константа скорости обучения.

Недостатком данной модели является то, что при частом приложении входного сигнала наблюдается неограниченный рост синаптического веса , что приводит к потере избирательности связей и неспособности сети сохранить какую-либо информацию. jxkjw

Гипотеза ковариации. Недостаток гипотезы Хебба может быть устранен, если переписать выражение для модификации синаптического веса в виде: kjw

))()()(()(xnxynynwjkkj−−=Δη,

где x и y – это усредненные по времени значения предсинаптического и постсинаптического сигналов.

Синапс, вес которого изменяется в соответствии с гипотезой ковариации, обладает следующими свойствами:

синаптический вес увеличивается при высоком уровне предсинаптического и постсинаптического сигналов, то есть при и (; xnxj>)( ynyk

синаптический вес уменьшается при высоком уровне предсинаптического сигнала, который не вызывает существенной постсинаптической активности, то есть >)( и ; xnynyk<)(

синаптический вес уменьшается, если наблюдается существенная постсинаптическая активность при отсутствии значительного предсинаптического сигнала, то есть и . xnxj<)( ynyk>)(

Конкурентное обучение:

При конкурентном обучении, в отличие от, например, обучения Хебба, в фиксированный момент времени в возбужденном состоянии может находиться только один нейрон выходного слоя. В связи с этим конкурентные сети часто применяются для решения задач классификации входных образов.

Конкурентное обучение строится на основании следующих принципов:

Все нейроны выходного слоя одинаковы и имеют в начальный момент времени случайные значения весов.

Существует предельное значение выходного сигнала каждого нейрона.

Существует механизм, определяющий нейрон, победивший в борьбе за право генерировать выходной сигнал. Принцип конкуренции можно сформулировать как «победитель получает все».

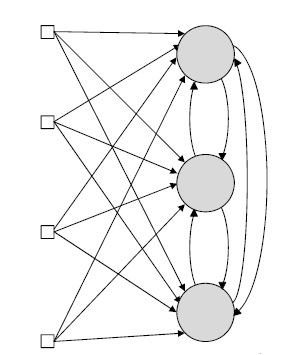

Механизм конкуренции может формироваться за счет введения отрицательных обратных связей, обеспечивающих латеральное торможение, когда каждый нейрон стремится затормозить связанные с ним нейроны (рис.6).

Рисунок 6 - Сеть конкурентного обучения

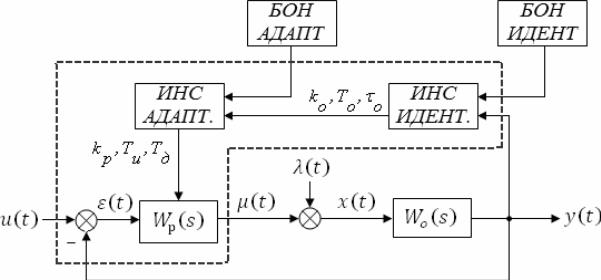

Предлагаемая адаптивная АСР состоит из следующих блоков:

БОН ИДЕНТ. – блок обучения нейросети идентификации;

ИНС ИДЕНТ. – искусственная нейросеть идентификации, реализующая функциональную зависимость ординат переходного процесса и его импульсной переходной характеристики с параметрами объекта регулирования выбранной модели идентификации;

БОН АДАПТ. – блок обучения нейросети адаптации (в данном блоке

происходит формирование обучающих выборок для обучения нейросети,

расчет оптимальных настроечных параметров реализуемых регуляторов);

ИНС АДАПТ. – искусственная нейросеть, реализующая функциональную зависимость, связывающую настроечные параметры реализуемого регулятора с параметрами идентифицированной модели объекта.

Рисунок 1 – Структурная схема адаптивной АСР

На рисунке 1 пунктирной линией показана граница реализации

функциональных блоков в циклических программах программируемого

логического контроллера.

Передаточная функция предлагаемой аппроксимирующей модели для объекта с самовыравниванием записывается в следующем виде: