- •В.П. Иосифов

- •А.М. Макаров

- •Введение

- •1. Основные понятия информационных процессов и систем

- •1.1. Общие понятия информационных процессов

- •1.2. Основные понятия теории систем

- •1.4. Классификация систем

- •2. Основы теории информации

- •2.1. Сигналы и системы передачи информации

- •2.2. Параметры сигнала

- •2.3. Энтропия дискретного сигнала. Количество информации

- •2.4. Свойства энтропии дискретных сообщений

- •2.5. Энтропия непрерывных сообщений

- •2.6. Информационный канал, пропускная способность канала

- •3. Элементы теории кодирования информации

- •3.1. Алфавитное кодирование информации

- •3.2. Критерий взаимной однозначности алфавитного кодирования

- •3.3. Эффективное кодирование, избыточность сообщений

- •3.4. Метод Хаффмана

- •3.5. Основы помехоустойчивого кодирования

- •3.6. Линейные блочные коды. Код с проверкой на четность, итеративный код

- •3.7. Код Хемминга

- •3.8. Алгоритмы сжатия информации

- •4. Модели систем с использованием случайных процессов

- •4.1. Марковские случайные процессы, классификация

- •4.2. Марковские цепи

- •4.3. Непрерывные цепи Маркова, уравнение Колмогорова

- •4.4. Система гибели и размножения

- •5. Системы массового обслуживания

- •5.1. Компоненты и классификация моделей массового обслуживания

- •5.2. Одноканальная смо с отказами

- •5.3. Одноканальная смо с ожиданием и ограниченной очередью

- •5.4. Одноканальная смо с ожиданием и неограниченной очередью

- •5.5. Многоканальная смо с отказами

- •5.6. Многоканальная смо с ожиданием

- •6. Основы теории принятия решений

- •6.1. Современные методы принятия решений

- •6.2. Принятие решений в условиях неопределенности

- •6.3. Критерии принятия решений в условиях неопределенности

- •Литература

3.2. Критерий взаимной однозначности алфавитного кодирования

Для вывода общего критерия взаимной однозначности понадобится следующее понятие. Представление элементарного кода βi схемы алфавитного кодирования в виде

βi=β`βi1 … βinβ``

где слово β` не может оканчиваться на элементарный код, а слово β`` начинаться с элементарного кода, будем называть нетривиальным разложением элементарного кода. При этом одно из слов β` или β`` может быть пустым (^). Для определения однозначности или неоднозначности схемы алфавитного кодирования существует эффективный алгоритм, использующий понятие нетривиального разложения элементарных кодов.

Для каждого элементарного кода выписываем все нетривиальные разложения.

Выписываем множество М1 состоящее из слов β`, которые входят в качестве начал в нетривиальные разложения элементарных кодов.

Выписываем множество М2, состоящее из всех слов β``, которые являются окончанием нетривиальных разложений элементарных кодов.

Составляем множество М = М1 ∩ М2 U {^}, т.е. множество слов, встречающихся как в качестве начала, так и в качестве окончания в нетривиальных разложениях элементарных кодов.

Выписываем все разложения элементарных кодов, связанных с множеством М, т.е. все разложения элементарных кодов вида:

βi=β`βi1 … βinβ``,

где

β`, β``

![]() М,

a

k

может

быть равно 0.

М,

a

k

может

быть равно 0.

По разложениям, полученным в пункте 5, строится ориентированный граф следующим образом. Вершины графа отождествляют с элементами множества М. Пара вершин β`, и β`` соединяются ориентированными ребрами в том и только в том случае, если существует разложение β`βi1 … βinβ``. При этом ребру (β`,β``) приписывается слово βi1 … βin, соответствующее этому разложению.

По полученному графу легко проверить, обладает или нет исходная схема кодирования свойством взаимной однозначности.

Теорема А.А. Маркова: Алфавитное кодирование не обладает свойством взаимной однозначности тогда и только тогда, когда граф содержит ориентированный цикл, проходящий через вершину ^.

3.3. Эффективное кодирование, избыточность сообщений

Эффективное кодирование – это процедуры направленные на устранение избыточности. Основная задача эффективного кодирования – обеспечить, в среднем, минимальное число двоичных элементов на передачу сообщения источника. В этом случае, при заданной скорости модуляции обеспечивается передача максимального числа сообщений, а значит максимальная скорости передачи информации. Пусть имеется источник дискретных сообщений, алфавит которого K. При кодировании сообщений данного источника двоичным, равномерным кодом, потребуется Lpk = log2 K двоичных элементов на кодирование каждого сообщения.

Если вероятности P(ai) появления всех сообщений источника равны, то энтропия источника (или среднее количество информации в одном сообщении) максимальна и равна Hmax(x)=log2 K. В данном случае каждое сообщение источника имеет информационную емкость log2 K=Lpk бит, и очевидно, что для его кодирования (перевозки) требуется двоичная комбинация не менее Lpk элементов. Каждый двоичный элемент, в этом случае, будет переносить 1 бит информации. Если при том же объеме алфавита сообщения не равновероятны, то, как известно, энтропия источника будет меньше

![]() .

.

Если и в этом случае использовать для перевозки сообщения Lpk -разрядные кодовые комбинации, то на каждый двоичный элемент кодовой комбинации будет приходиться меньше чем 1 бит. Появляется избыточность, которая может быть определена по следующей формуле:

![]() .

.

Среднее количество информации, приходящееся на один двоичный элемент комбинации при кодировании равномерным кодом:

![]() .

.

Пример: Для кодирования 32 букв русского алфавита, при условии равновероятности, нужна 5 разрядная кодовая комбинация. При учете всех статистических связей реальная энтропия составляет около 1,5 бит на букву. Нетрудно показать, что избыточность в данном случае составит:

![]() ,

,

Если средняя загрузка единичного элемента так мала, встает вопрос, нельзя ли уменьшить среднее количество элементов необходимых для переноса одного сообщения и как наиболее эффективно это сделать? Для решения этой задачи используются неравномерные коды. При этом, для передачи сообщения, содержащего большее количество информации, выбирают более длинную кодовую комбинацию, а для передачи сообщения с малым объемом информации используют короткие кодовые комбинации. Учитывая, что объем информации, содержащейся в сообщении, определяется вероятностью появления:

![]() ,

,

можно перефразировать данное высказывание.

Для сообщения, имеющего высокую вероятность появления, выбирается более короткая комбинация и наоборот, редко встречающееся сообщение кодируется длинной комбинацией. Т.о. на одно сообщение будет затрачено в среднем меньшее единичных элементов, чем при равномерном. Если скорость телеграфирования постоянна, то на передачу одного сообщения будет затрачено в среднем меньше времени:

![]()

А значит, при той же скорости телеграфирования будет передаваться большее число сообщений в единицу времени, чем при равномерном кодировании, т.е. обеспечивается большая скорость передачи информации. Каково же в среднем минимальное количество единичных элементов требуется для передачи сообщений данного источника? Ответ на этот вопрос дал К. Шеннон. Он показал, что:

1. Нельзя закодировать сообщение двоичным кодом так, что бы средняя длина кодового слова l была численно меньше величины энтропии источника сообщений.

2. Существует способ кодирования, при котором средняя длина кодового слова немногим отличается от энтропии источника. Остается выбрать подходящий способ кодирования.

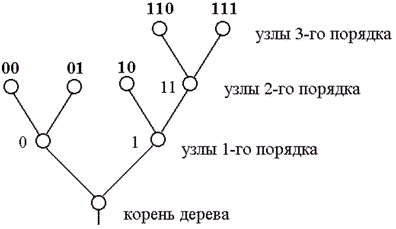

Введем понятие кодового дерева для множества кодовых слов. Наглядное графическое изображение множества кодовых слов можно получить, установив соответствие между сообщениями и концевыми узлами двоичного дерева. Пример двоичного кодового дерева изображен на рисунке 3. Две ветви, идущие от корня дерева к узлам первого порядка, соответствуют выбору между 0 и 1 в качестве первого символа кодового слова: левая ветвь соответствует 0, а правая – 1. Две ветви, идущие из узлов первого порядка, соответствуют второму символу кодовых слов, левая означает 0, а правая –1 и т.д. Ясно, что последовательность символов каждого кодового слова определяет необходимые правила продвижения от корня дерева до концевого узла, соответствующего рассматриваемому сообщению.

Рисунок 3.1. Пример двоичного кодового дерева

Формально кодовые слова могут быть приписаны также промежуточным узлам. Например, промежуточному узлу второго порядка на рис. 3 можно приписать кодовое слово 11, которое соответствует первым двум символам кодовых слов, соответствующих концевым узлам, порождаемых этим узлом. Однако кодовые слова, соответствующие промежуточным узлам, не могут быть использованы для представления сообщений, так как в этом случае нарушается требование префиксности кода. Требование, чтобы только концевые узлы сопоставлялись сообщениям, эквивалентно условию, чтобы ни одно из кодовых слов не совпало с началом (префиксом) более длинного кодового слова. Любой код, кодовые слова которого соответствуют различным концевым вершинам некоторого двоичного кодового дерева, является префиксным, т.е. однозначно декодируемым.