- •Некрасова м.Г. - Методы оптимизации Оглавление

- •Глава 1. Введение в методы оптимизации

- •Вопросы к главе 1

- •Глава 2. Основы теории оптимизации

- •2.1. Параметры плана

- •2.2. Целевая функция (план)

- •Вопросы к главе 2

- •Глава 3. Функция одной переменной

- •3.1. Определение функции одной переменной и её свойства

- •3.2. Исследование функций в экономике. Нахождение максимума прибыли

- •3.3. Определение глобального экстремума

- •3.4. Выпуклость, вогнутость функции

- •3.4. Критерий оптимальности

- •Замечание.

- •3.6. Идентификация оптимумов

- •Вопросы к главе 3

- •Глава 4. Одномерная оптимизация

- •4.1. Методы исключения интервалов

- •4.1.1. Метод сканирования

- •4.1.2. Метод деления отрезка пополам

- •4.1.2. Метод золотого сечения

- •4.1.2. Сравнительная характеристика методов исключения интервалов

- •4.2. Полиномиальная аппроксимация и методы точечного оценивания

- •4.2.1. Метод параболической аппроксимации

- •4.2.2. Метод Пауэлла

- •4.3. Сравнение методов одномерного поиска

- •Метод Пауэлла

- •Глава 5. Функции многих переменных

- •5.1. Функции многих переменных, их обозначение и область определения

- •5.2. Некоторые многомерные функции, используемые в экономике

- •5.3. Частные производные функции многих переменных

- •5.3. Экономический смысл частных производных

- •5.3. Частные производные высших порядков

- •5.6. Свойства функций нескольких переменных

- •5.7. Производная по направлению. Градиент. Линии уровня функции

- •5.8. Экстремум функции многих переменных

- •Вопросы к главе 5

- •Глава 6. Многомерная безусловная градиентная оптимизация

- •6.1. Концепция методов

- •6.2. Метод градиентного спуска

- •6.3. Метод наискорейшего спуска

- •Вопросы к главе 6

- •Глава 7. Критерии оптимальности в задачах с ограничениями

- •7.1. Задачи с ограничениями в виде равенств

- •7.2. Множители Лагранжа

- •7.3. Экономическая интерпретация множителей Лагранжа

- •7.4. Условия Куна - Таккера

- •7.4.1. Условия Куна – Таккера и задача Куна - Таккера

- •7.5. Теоремы Куна - Таккера

- •7.6. Условия существования седловой точки

- •Теорема 4. Необходимые условия оптимальности

- •Вопросы к главе 7

- •Глава 8. Модели динамического программирования

- •8.1. Предмет динамического программирования

- •8.2. Постановка задачи динамического программирования

- •8.3. Принцип оптимальности и математическое описание динамического процесса управления

- •8.4. Общая схема применения метода динамического программирования

- •8.5. Двумерная модель распределения ресурсов

- •8.6. Дискретная динамическая модель оптимального распределения ресурсов

- •2 Этап. Безусловная оптимизация.

- •8.7. Выбор оптимальной стратегии обновления оборудования

- •8.8. Выбор оптимального маршрута перевозки грузов

- •2 Этап. Безусловная оптимизация.

- •8.9. Построение оптимальной последовательности операций в коммерческой деятельности

- •1 Этап. Условная оптимизация.

- •Вопросы к главе 8

- •Пример выполнения задачи 1

- •Пример выполнения задачи 4

- •Пример выполнения задачи 5

- •Расчетно-графическое задание 2

- •Пример выполнения задачи 1

- •Пример выполнения задачи 2

- •Пример выполнения задачи 3

- •Пример выполнения задачи 4

- •1 Этап. Условная оптимизация.

- •2 Этап. Безусловная оптимизация.

- •2 Этап. Безусловная оптимизация.

4.2.2. Метод Пауэлла

Этот метод, разработанный Пауэллом, основан на последовательном применении процедуры оценивания с использованием квадратичной аппроксимации. Схему алгоритма можно описать следующим образом. Пусть х1 – начальная точка, х – выбранная величина шага по оси х.

Алгоритм метода Пауэлла:

Шаг 1. Вычислить

![]()

Шаг 2. Вычислить f(x1) и f(x2).

Шаг 3. Если f(x1)

> f(x2),

положить

![]() Если

Если

![]() положить

положить

![]() .

.

Шаг 4. Вычислить f(x3) и найти

![]()

Шаг 5. По трем точкам х1, х2, х3 вычислить , используя формулу оценивания квадратичной аппроксимации:

![]()

Шаг 6. Проверка на окончание поиска.

а) является ли разность

![]() достаточно

малой?

достаточно

малой?

б) является ли разность

![]() достаточно

малой?

достаточно

малой?

Если оба условия выполняются, закончить поиск. В противном случае перейти к шагу 7.

Шаг 7. Выбрать «наилучшую» точку

(![]() )

и две точки по обе стороны от нее.

Обозначить эти точки в естественном

порядке и перейти к шагу 4.

)

и две точки по обе стороны от нее.

Обозначить эти точки в естественном

порядке и перейти к шагу 4.

Заметим, что при первой реализации шага 5 границы интервала, содержащего точку минимума, не обязательно оказываются установленными. При этом полученная точка может находиться за точкой х3 . Поэтому следует провести после шага 5 дополнительную проверку и в случае, когда точка находится слишком далеко от х3, заменить точкой, координата которой вычисляется с учетом заранее установленной длины шага.

Пример 22. Минимизировать функцию f(x) = 2x2 + (16/x).

Решение. Пусть начальная точка x1 = 1 и длина шага x = 1. Для проверки на окончание поиска используются следующие параметры сходимости:

![]()

Итерация 1.

Шаг 1.

![]()

Шаг 2.

![]()

Шаг 3.

![]()

Шаг 4.

![]()

Шаг 5. Используя метод параболической аппроксимации, находим

![]()

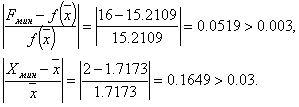

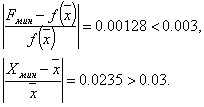

Шаг 6. Проверка на окончание поиска:

Следовательно, продолжаем поиск.

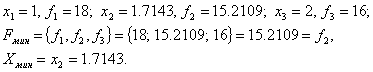

Шаг 7. Выбираем

«наилучшую» точку, и точки, их окружающие.

Обозначаем эти точки в естественном

порядке

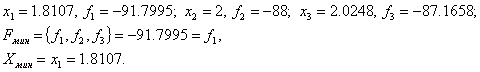

![]() Переходим

к итерации 2, которая начинается с шага

4.

Переходим

к итерации 2, которая начинается с шага

4.

Итерация 2.

Шаг 4.

Шаг 5.

![]()

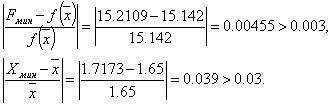

Шаг 6. Проверка на окончание поиска:

Следовательно, продолжаем поиск.

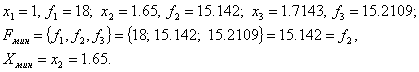

Шаг 7. Выбираем

«наилучшую» точку, и точки, их окружающие.

Обозначаем эти точки в естественном

порядке

![]() Переходим

к итерации 3, которая начинается с шага

4.

Переходим

к итерации 3, которая начинается с шага

4.

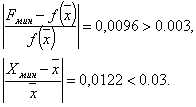

Итерация 3.

Шаг 4.

Шаг 5.

![]()

Шаг 6. Проверка на окончание поиска:

Точность достигнута. Следовательно, поиск закончен.

Получили

![]()

Пример 23. Найти минимальное значение f* и точку минимума х* функции . Точку х* найти с точностью =0,05.

Решение. Пусть начальная точка x1 =3 и длина шага x = 1. Для проверки на окончание поиска используются следующие параметры сходимости:

Итерация 1.

Шаг 1.

![]()

Шаг 2.

![]()

Шаг 3.

![]()

Шаг 4.

![]()

Шаг 5. Используя метод параболической аппроксимации, находим

![]()

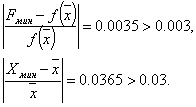

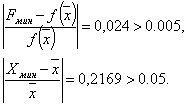

Шаг 6. Проверка на окончание поиска:

Так как пункт а) не выполняется, то продолжаем поиск.

Шаг 7. Выбираем

«наилучшую» точку, и точки, их окружающие.

Обозначаем эти точки в естественном

порядке

![]() Переходим

к итерации 2, которая начинается с шага

4.

Переходим

к итерации 2, которая начинается с шага

4.

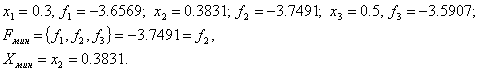

Итерация 2.

Шаг 4.

Шаг 5.

![]()

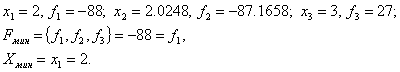

Шаг 6. Проверка на окончание поиска:

Следовательно, продолжаем поиск.

Шаг 7. Выбираем

«наилучшую» точку, и точки, их окружающие.

Обозначаем эти точки в естественном

порядке

![]() Переходим

к итерации 3, которая начинается с шага

4.

Переходим

к итерации 3, которая начинается с шага

4.

Итерация 3.

Шаг 4.

Шаг 5.

![]()

Шаг 6. Проверка на окончание поиска:

Продолжаем поиск.

Шаг 7. Выбираем

«наилучшую» точку, и точки, их окружающие.

Обозначаем эти точки в естественном

порядке

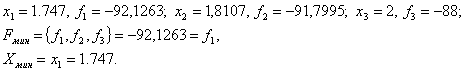

![]() Переходим

к итерации 4, которая начинается с шага

4.

Переходим

к итерации 4, которая начинается с шага

4.

Итерация 4.

Шаг 4.

Шаг 5.

![]()

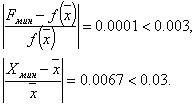

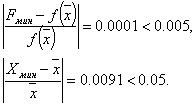

Шаг 6. Проверка на окончание поиска:

Условия окончания поиска выполняются, следовательно, вычисления заканчиваем.

Получили

![]()

Пример 24. Найти точку минимума х* функции с точностью =0,05.

Решение. Пусть начальная точка x1 = 0,5 и длина шага x = 0,2. Для проверки на окончание поиска используются следующие параметры сходимости:

![]()

Итерация 1.

Шаг 1.

![]()

Шаг 2.

![]()

Шаг 3.

![]()

Шаг 4.

![]()

Шаг 5. Используя метод параболической аппроксимации, находим

![]()

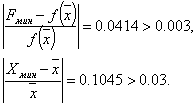

Шаг 6. Проверка на окончание поиска:

Так как пункт а) не выполняется, то продолжаем поиск.

Шаг 7. Выбираем

«наилучшую» точку, и точки, их окружающие.

Обозначаем эти точки в естественном

порядке

![]() Переходим

к итерации 2, которая начинается с шага

4.

Переходим

к итерации 2, которая начинается с шага

4.

Итерация 2.

Шаг 4.

Шаг 5.

![]()

Шаг 6. Проверка на окончание поиска:

Условия окончания поиска выполняются, следовательно, вычисления заканчиваем.

Получили

![]()