Реферат

В данной работе разрабатывается программа , реализующая аппроксимацию данных линейной функцией метом наименьших квадратов. Разработка проводится в среде разработки Visual C# (операционная среда Windows 7).

В работе представлены теоретическое введение «Введение. Метод наименьших квадратов», в котором описана общая суть метода наименьших квадратов, его вариации, историческое развитие, математическое наполнение, приведены простейшие примеры его применения. Раздел содержит семь страниц.

Далее приведен раздел «Теоретическое обоснование аппроксимации данных линейной функцией методом наименьших квадратов», который содержит данный о математической реализации аппроксимации данных линейной функцией методом наименьших квадратов. Раздел насчитывает три страницы.

Раздел «Примеры простейших реализаций» содержит математическое описание простейших реализаций метода наименьших квадратов, эти данные необходимы для понимания сущности аппроксимации данных линейной функцией методом наименьших квадратов. Раздел так же содержит три страницы.

Следующий раздел «Программная реализация аппроксимации данных линейной функцией методом наименьших квадратов» содержит сведенья о разработке программы, о том как программно реализована аппроксимация данных линейной функцией методом наименьших квадратов, приведены скриншоты рабочего поля, начального экрана программы. Так же данный раздел содержит коды исходных классов, описание используемы классов и методов. Фактически в данном разделе в текстовой форме описана работа программы, ее алгоритм. Раздел содержит семь страниц.

Предпоследний раздел «Заключение» содержит скриншоты самой программы, а так же скриншоты, демонстрирующие работоспособность программы, ее возможность генерировать, как случайный массив данных, так и читать данные из текстового файла, хранящегося на компьютере пользователя или же на внешнем носителе. Раздел содержит две страницы.

В разделе «Литература» литература приведена, использованная при создании данного курсового проекта.

В работе представлены:

Графики-2 шт.

Таблица-1 шт.

Скриншоты программы и рабочей среды- 9 шт.

В работе использованы материалы сайта Wikipedia.org6

Содержание

Введение. Метод наименьших квадратов……………………………..…………………...4

Теоретическое обоснование аппроксимации данных линейной функцией методом наименьших квадратов…………………………………………………………………..…11

Примеры простейших реализаций……………………………………………...................14

Программная реализация аппроксимации данных линейной функцией методом наименьших квадратов……………………………………………………………………..17

Заключение………………………………………………………………………………….24

Литература…………………………………………………………………………………..26

Теоретическое введение Метод наименьших квадратов

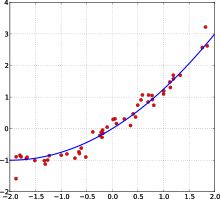

Пример кривой, проведённой через точки, имеющие нормально распределённое отклонение от истинного значения.

Метод наименьших квадратов (МНК, OLS, Ordinary Least Squares) — один из базовых методов регрессионного анализа для оценки неизвестных параметров регрессионных моделей по выборочным данным. Метод основан на минимизации суммы квадратов остатков регрессии.

Необходимо отметить, что собственно методом наименьших квадратов можно назвать метод решения задачи в любой области, если решение заключается или удовлетворяет некоторому критерию минимизации суммы квадратов некоторых функций от искомых переменных. Поэтому метод наименьших квадратов может применяться также для приближённого представления (аппроксимации) заданной функции другими (более простыми) функциями, при нахождении совокупности величин, удовлетворяющих уравнениям или ограничениям, количество которых превышает количество этих величин и т. д.

Сущность мнк

Пусть задана некоторая (параметрическая) модель вероятностной (регрессионной) зависимости между (объясняемой) переменной y и множеством факторов (объясняющих переменных) x

![]()

где ![]() —

вектор неизвестных параметров модели

—

вектор неизвестных параметров модели

![]() —

случайная ошибка

модели.

—

случайная ошибка

модели.

Пусть

также имеются выборочные наблюдения

значений указанных переменных. Пусть ![]() —

номер наблюдения (

—

номер наблюдения (![]() ).

Тогда

).

Тогда ![]() —

значения переменных в

-м

наблюдении. Тогда при заданных значениях

параметров b можно рассчитать теоретические

(модельные) значения объясняемой

переменной y:

—

значения переменных в

-м

наблюдении. Тогда при заданных значениях

параметров b можно рассчитать теоретические

(модельные) значения объясняемой

переменной y:

![]()

Тогда можно рассчитать остатки регрессионной модели — разницу между наблюдаемыми значениями объясняемой переменной и теоретическими (модельными, оцененными):

![]()

Величина остатков зависит от значений параметров b.

Сущность

МНК (обычного, классического) заключается

в том, чтобы найти такие параметры b, при

которых сумма квадратов

остатков ![]() (англ. Residual

Sum

of

Squares])

будет минимальной:

(англ. Residual

Sum

of

Squares])

будет минимальной:

![]()

где:

![]()

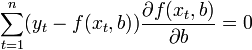

В общем случае решение этой задачи может осуществляться численными методами оптимизации (минимизации). В этом случае говорят о нелинейном МНК (NLS или NLLS — англ. Non-Linear Least Squares). Во многих случаях можно получить аналитическое решение. Для решения задачи минимизации необходимо найти стационарные точки функции , продифференцировав её по неизвестным параметрам b, приравняв производные к нулю и решив полученную систему уравнений:

Если случайные ошибки модели имеют нормальное распределение, имеют одинаковую дисперсию и некоррелированы между собой, МНК-оценки параметров совпадают с оценками метода максимального правдоподобия (ММП).

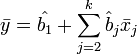

Мнк в случае линейной модели

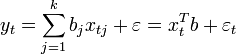

Пусть регрессионная зависимость является линейной:

Пусть y —

вектор-столбец наблюдений объясняемой

переменной, а ![]() —

это

—

это ![]() -матрица

наблюдений факторов (строки матрицы —

векторы значений факторов в данном

наблюдении, по столбцам — вектор

значений данного фактора во всех

наблюдениях). Матричное

представление линейной

модели имеет вид:

-матрица

наблюдений факторов (строки матрицы —

векторы значений факторов в данном

наблюдении, по столбцам — вектор

значений данного фактора во всех

наблюдениях). Матричное

представление линейной

модели имеет вид:

![]()

Тогда вектор оценок объясняемой переменной и вектор остатков регрессии будут равны

![]()

соответственно сумма квадратов остатков регрессии будет равна

![]()

Дифференцируя эту функцию по вектору параметров и приравняв производные к нулю, получим систему уравнений (в матричной форме):

![]() .

.

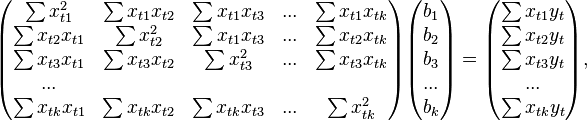

В расшифрованной матричной форме эта система уравнений выглядит следующим образом:

где все суммы берутся по всем допустимым значениям .

Если

в модель включена константа (как обычно),

то ![]() при

всех

,

поэтому в левом верхнем углу матрицы

системы уравнений находится количество

наблюдений

при

всех

,

поэтому в левом верхнем углу матрицы

системы уравнений находится количество

наблюдений ![]() ,

а в остальных элементах первой строки

и первого столбца — просто суммы

значений переменных:

,

а в остальных элементах первой строки

и первого столбца — просто суммы

значений переменных: ![]() и

первый элемент правой части системы —

и

первый элемент правой части системы — ![]() .

.

Решение этой системы уравнений и дает общую формулу МНК-оценок для линейной модели:

![]()

Для аналитических целей оказывается полезным последнее представление этой формулы (в системе уравнений при делении на n, вместо сумм фигурируют средние арифметические). Если в регрессионной модели данныецентрированы, то в этом представлении первая матрица имеет смысл выборочной ковариационной матрицы факторов, а вторая — вектор ковариаций факторов с зависимой переменной. Если кроме того данные ещё инормированы на СКО (то есть в конечном итоге стандартизированы), то первая матрица имеет смысл выборочной корреляционной матрицы факторов, второй вектор — вектора выборочных корреляций факторов с зависимой переменной.

Немаловажное свойство МНК-оценок для моделей с константой — линия построенной регрессии проходит через центр тяжести выборочных данных, то есть выполняется равенство:

В частности, в крайнем случае, когда единственным регрессором является константа, получаем, что МНК-оценка единственного параметра (собственно константы) равна среднему значению объясняемой переменной. То есть среднее арифметическое, известное своими хорошими свойствами из законов больших чисел, также является МНК-оценкой — удовлетворяет критерию минимума суммы квадратов отклонений от неё.